抱抱臉團隊(HF)發(fā)布多模態(tài)大模型Idefics2,8B參數(shù) 原創(chuàng)

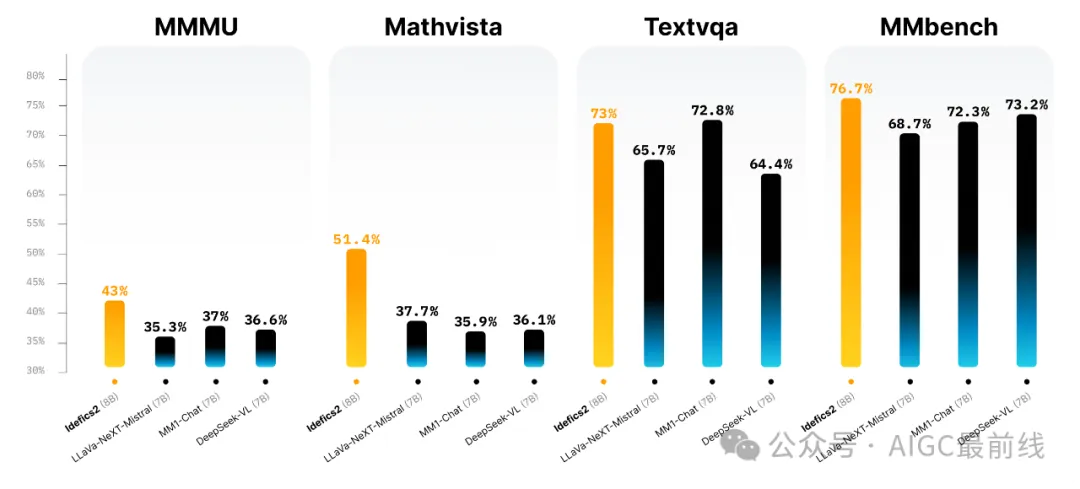

近日,抱抱臉團隊(HF)發(fā)布Idefics2,一個通用的多模態(tài)大模型,可以接受任意文本和圖像序列作為輸入,并生成文本響應(yīng)。它可以回答關(guān)于圖像的問題,描述視覺內(nèi)容,創(chuàng)建基于多個圖像的故事,從文檔中提取信息,并執(zhí)行基本算術(shù)運算。Idefics2改進了Idefics1:具有8B參數(shù)、開放許可(Apache 2.0)和增強的OCR(光學(xué)字符識別)功能,Idefics2是多模態(tài)工作社區(qū)的堅實基礎(chǔ)。它在視覺問答基準上的表現(xiàn)居于同類模型的前列,并與LLava-Next-34B和MM1-30B-chat等更大的模型競爭。

訓(xùn)練數(shù)據(jù)

Idefics2在預(yù)訓(xùn)練過程中使用了一系列公開可用數(shù)據(jù)集進行訓(xùn)練:交錯的網(wǎng)頁文檔(維基百科、OBELICS)、圖像-標題對(公共多模態(tài)數(shù)據(jù)集、LAION-COCO)、OCR數(shù)據(jù)(PDFA(英文)、IDL和渲染文本)以及圖像到代碼數(shù)據(jù)(WebSight)。交互式可視化允許探索OBELICS數(shù)據(jù)集。根據(jù)基礎(chǔ)模型社區(qū)的通行做法,HF進一步對基礎(chǔ)模型進行了面向任務(wù)的訓(xùn)練。然而,這些數(shù)據(jù)通常是以不同的格式存在,并分散在各個地方。對于社區(qū)來說,收集這些數(shù)據(jù)是一個障礙。為了解決這個問題,HF發(fā)布了一直在準備的多模態(tài)指令微調(diào)數(shù)據(jù)集:Cauldron,這是一個開放的、由50個手動策劃的數(shù)據(jù)集的合集,格式化為多輪對話。HF使用The Cauldron和各種文本微調(diào)數(shù)據(jù)集的串聯(lián)來對Idefics2進行了指令微調(diào)。

改進

- HF按照NaViT策略處理圖像的原生分辨率(高達980 x 980)和原生寬高比。這樣就避免了將圖像調(diào)整為固定大小的正方形的需要,因為這在計算機視覺界一直是歷史性的做法。此外,HF遵循了SPHINX的策略,并(可選地)允許子圖像分割和傳遞非常大分辨率的圖像。

- 通過整合需要模型轉(zhuǎn)錄圖像或文檔中的文本的數(shù)據(jù),顯著增強了OCR功能。我們還通過適當?shù)挠?xùn)練數(shù)據(jù),改進了在圖表、圖形和文檔上回答問題的能力。

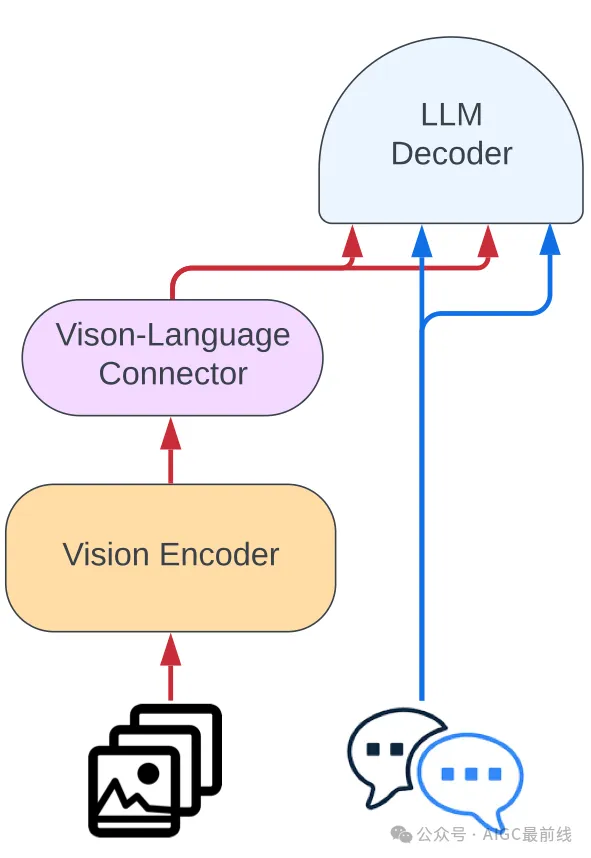

- 摒棄了Idefics1的架構(gòu)(門控交叉關(guān)注)并簡化了將視覺特征整合到語言骨干中的過程。圖像被輸入到視覺編碼器中,然后是一個學(xué)習(xí)的Perceiver池化和一個MLP模態(tài)投影。然后將這個池化序列與文本嵌入拼接起來,得到一個(交錯的)圖像和文本序列。

所有這些改進加上更好的預(yù)訓(xùn)練骨干,使性能大幅提高,而模型的大小只增加了10倍。

Idefics2體系結(jié)構(gòu)

開始使用Idefics2

Idefics2可在Hugging Face Hub上獲得,并在最新的transformers版本中受支持。

譯自(有刪改):https://huggingface.co/blog/idefics2

本文轉(zhuǎn)載自公眾號AIGC最前線