破解 RL 訓(xùn)練崩潰難題,快手聯(lián)合中科院、清華、南大提出多模態(tài)獎勵模型 R1-Reward!

多模態(tài)獎勵模型(MRMs)在提升多模態(tài)大語言模型(MLLMs)的表現(xiàn)中起著至關(guān)重要的作用,在訓(xùn)練階段可以提供穩(wěn)定的 reward,評估階段可以選擇更好的 sample 結(jié)果,甚至單獨作為 evaluator。盡管近期強(qiáng)化學(xué)習(xí)(RL)在傳統(tǒng)視覺任務(wù)和多模態(tài)推理任務(wù)中取得了顯著進(jìn)展,但其在獎勵建模中的應(yīng)用仍然受到挑戰(zhàn),尤其是如何通過強(qiáng)化學(xué)習(xí)對獎勵模型引入長期推理能力。

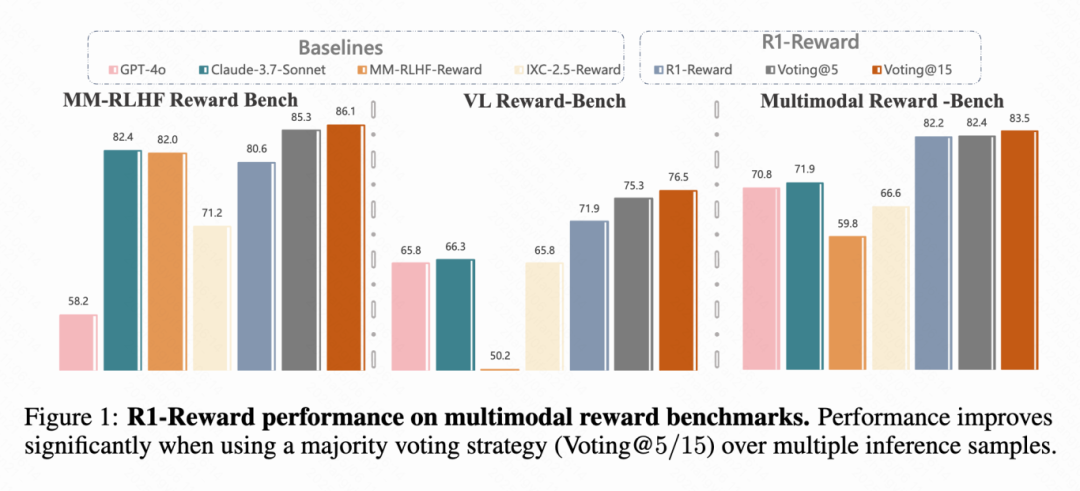

快手、中科院、清華、南大的研究團(tuán)隊發(fā)現(xiàn),直接把現(xiàn)有的 RL 算法(比如 Reinforce++)用到訓(xùn)練 MRM 上,會遇到很多問題,比如訓(xùn)練過程很不穩(wěn)定,甚至直接崩掉。本文的出發(fā)點就是要解決這些問題,探索如何利用強(qiáng)化學(xué)習(xí)來穩(wěn)定、有效地提升多模態(tài)獎勵模型的長時推理能力。基于團(tuán)隊在多模態(tài)強(qiáng)化學(xué)習(xí)的工作 MM-RLHF (ICML 2025),本文進(jìn)一步提出了 R1-Reward,在現(xiàn)有的多模態(tài)獎勵模型 benchmark 上相比于 SOTA 模型有 5%-15%的提升,且隨著 inference sampleing 的數(shù)目增多還能進(jìn)一步增長。

R1-Reward 不僅在學(xué)術(shù)上展現(xiàn)了巨大價值,還在快手的實際業(yè)務(wù)場景中得到了成功應(yīng)用。例如,在短視頻、電商和直播等場景中,該方法已用于標(biāo)簽識別、多圖/多視頻相關(guān)性判斷以及短視頻推薦,并取得了顯著的性能提升,展示了較強(qiáng)的工業(yè)化潛力。

[?? arXiv Paper]:??https://arxiv.org/abs/2505.02835??

[?? Training Code]:??https://github.com/yfzhang114/r1_reward??

[?? R1-Reward Model]:??https://huggingface.co/yifanzhang114/R1-Reward??

「一分鐘速看全文內(nèi)容」

1. 重新定義問題:將訓(xùn)練獎勵模型這個問題,看成是一個基于規(guī)則的強(qiáng)化學(xué)習(xí)任務(wù)。簡單說,就是給獎勵模型一個問題和兩個答案,讓它通過學(xué)習(xí)來判斷哪個答案更好,并且能給出合理的分析。

2. 提出新算法 StableReinforce:針對現(xiàn)有 RL 算法的不足,提出一個改進(jìn)版的算法叫 StableReinforce。這個算法主要在幾個方面做了優(yōu)化:

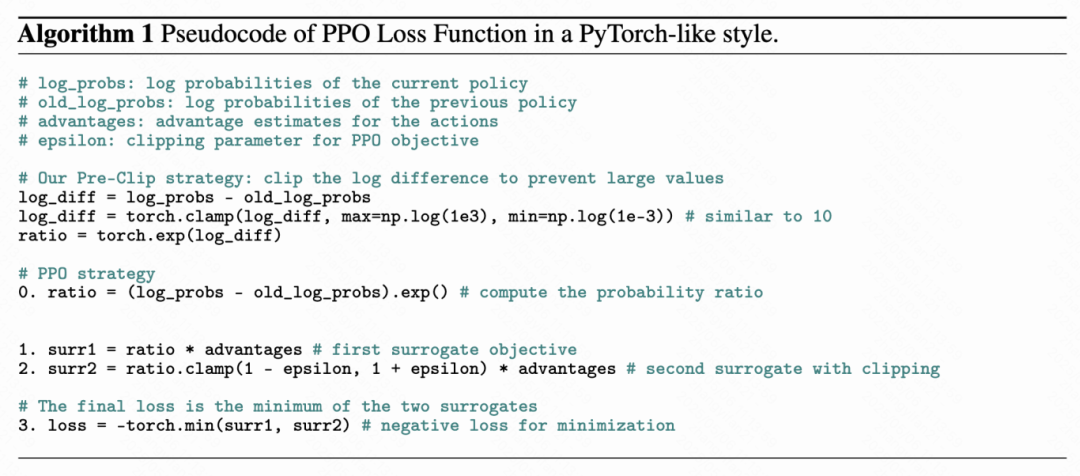

- 改進(jìn)了損失函數(shù)里的裁剪操作,提出 Pre-Clip,防止數(shù)值計算不穩(wěn)定。

- 提出了一種更穩(wěn)健的優(yōu)勢值(advantage)處理方法(叫做優(yōu)勢過濾器 Advantage Filter),不容易被極端值帶偏。

- 設(shè)計了一個新穎的“一致性獎勵” (Consistency Reward)。它引入了另一個大模型作為“裁判”,專門檢查獎勵模型自己的分析過程和它最終給出的答案是不是一致的。如果一致,就給獎勵,這樣能促使模型做出更符合邏輯的判斷。

3. 漸進(jìn)式的訓(xùn)練策略:

- 團(tuán)隊從各種公開數(shù)據(jù)集中收集了 20 萬條偏好數(shù)據(jù),構(gòu)建了一個名為 R1-Reward-200k 的數(shù)據(jù)集用于訓(xùn)練。

- 采用了一種 “漸進(jìn)式難度” 的訓(xùn)練策略。因為直接用 RL 訓(xùn)練模型效果不好(冷啟動問題),團(tuán)隊先用 GPT-4o 對這些數(shù)據(jù)生成了詳細(xì)的思考過程,作為監(jiān)督微調(diào)(SFT)的數(shù)據(jù),讓模型先“入門”。同時記錄了 GPT-4o 判斷每個樣本的難度(需要嘗試幾次才能判斷對)。

- 在后續(xù)的強(qiáng)化學(xué)習(xí)階段,專門挑選那些 GPT-4o 都覺得比較難(需要嘗試多次或者干脆判斷錯誤)的樣本進(jìn)行訓(xùn)練,讓模型在難題上得到鍛煉。

4. 效果顯著:

- 實驗結(jié)果表明,這個 R1-Reward 模型在幾個主流的多模態(tài)獎勵模型測評基準(zhǔn)(如 VL Reward-Bench, Multimodal Reward Bench)上表現(xiàn)非常出色,顯著超過了之前的最佳模型 (SOTA)。比如在一個榜單上提升了 8.4%,在另一個榜單上提升了 14.3%。

- 更有趣的是,團(tuán)隊發(fā)現(xiàn)通過在推理時多做幾次計算(比如采樣 5 次或 15 次,然后投票選最多的答案),R1-Reward 的性能還能進(jìn)一步大幅提升,這說明 RL 方法在優(yōu)化獎勵模型方面潛力巨大。

- 團(tuán)隊還觀察到,經(jīng)過 StableReinforce 的 RL 訓(xùn)練后,模型輸出的平均長度減少了大約 15%,這意味著模型可能變得更有效率了。

一、現(xiàn)有強(qiáng)化學(xué)習(xí)方法的局限性

什么是獎勵模型

首先得知道,獎勵模型(Reward Model)是干嘛的。簡單說,它就是用來判斷兩個模型的回答,哪一個更符合人類喜好。

具體的優(yōu)化公式大概是這樣:

這里的 r(y|x) 就是模型打的分?jǐn)?shù),σ 是個 sigmoid 函數(shù),E 表示求期望(平均)。意思就是,模型要盡量讓好答案的分比壞答案的分高,差距越大越好,然后通過 log 和 sigmoid 函數(shù)來計算損失。

PPO 和 Reinforce++算法簡介

PPO (Proximal Policy Optimization)

PPO 是一種很常用的強(qiáng)化學(xué)習(xí)算法,屬于策略梯度方法,目標(biāo)是直接優(yōu)化模型(策略)來獲得最大的累積獎勵。它的厲害之處在于,它不像傳統(tǒng)的策略梯度方法那樣容易因為步子邁太大而導(dǎo)致訓(xùn)練不穩(wěn)定。PPO 通過一種特殊的方式來限制每次策略更新的幅度。

它的目標(biāo)函數(shù)為:

這個公式的核心思想在于 min 和 clip 操作。它確保了就算 ratio * A_t (標(biāo)準(zhǔn)的策略梯度目標(biāo))很大,也會被 clip 后的項限制住,防止策略更新過猛導(dǎo)致訓(xùn)練不穩(wěn)定。PPO 因為實現(xiàn)簡單、效果好,所以在很多地方(比如機(jī)器人控制、玩游戲)都用得很廣。

Reinforc++

Reinforce++ 是在 PPO 基礎(chǔ)上做了一些優(yōu)化的版本,目的是讓訓(xùn)練更穩(wěn)定、更高效。主要改進(jìn)有:

1、在 reward 中增加了 KL 散度懲罰:在獎勵函數(shù)里加入了一項用來懲罰強(qiáng)化學(xué)習(xí)模型(RL model)和監(jiān)督微調(diào)模型(SFT model)在每個詞(token)上的輸出概率分布差異過大。獎勵函數(shù)變成了:

這里表示只有在生成結(jié)束符時才加上原始的任務(wù)獎勵r( x, y),β K L( t)是那個 KL 懲罰項。

2、獎勵和優(yōu)勢的歸一化:它會對整個批次(batch)的獎勵進(jìn)行歸一化、裁剪和縮放,還對優(yōu)勢值 A 進(jìn)行歸一化:

(減去均值μ A?,再除以標(biāo)準(zhǔn)差σ A?)。

在很多研究中 Reinforce++ 比 GRPO 更穩(wěn)定,比 PPO 收斂更快。

?

PPO 和 Reinforce++的問題在哪?

雖然 PPO 和 Reinforce++ 不錯,但在實際訓(xùn)練中,尤其是在訓(xùn)練獎勵模型的時候,研究者們發(fā)現(xiàn)它們有兩個核心問題,很容易讓模型訓(xùn)練不穩(wěn)定甚至失敗:

1. 訓(xùn)練損失導(dǎo)致的不穩(wěn)定:

- 計算 PPO 損失時,需要算概率比值 ratio。如果新舊策略差別很大,這個 ratio 可能會變得非常大或非常小。

- 在代碼實現(xiàn)里(比如用 PyTorch),通常是算 ratio = torch.exp(log_probs - old_log_probs)。如果 log_probs - old_log_probs 這個差值很大,exp() 運算可能會導(dǎo)致數(shù)值溢出,直接讓程序崩潰。

- 就算沒崩潰,如果算出來的 ratio 很大,并且優(yōu)勢是負(fù)的(表示這個動作不好),那么根據(jù) PPO 的損失公式 ,這個損失值可能會變得異常大。這么大的損失會讓模型的參數(shù)更新變得極其不穩(wěn)定。

2. 優(yōu)勢歸一化導(dǎo)致的不穩(wěn)定:

- 獎勵模型的訓(xùn)練數(shù)據(jù)標(biāo)簽通常很簡單,比如就兩個標(biāo)簽:1 和 2(1 好還是 2 更好)。模型比較容易學(xué)會區(qū)分。

- 這就導(dǎo)致在訓(xùn)練后期,一個批次(batch)里的數(shù)據(jù),模型可能大部分都能預(yù)測對。比如一個 batch 里有 255 個樣本的真實獎勵是 1,只有 1 個是 0。

- 在這種情況下,獎勵的方差會非常小。如果這時候還用標(biāo)準(zhǔn)的優(yōu)勢歸一化方法(減均值除以標(biāo)準(zhǔn)差 ),那個獎勵為 0 的樣本對應(yīng)的優(yōu)勢值,在歸一化之后可能會變成一個絕對值非常大的數(shù)(例子中是 -15.96)。

- 這么大的優(yōu)勢值同樣會干擾模型的更新,導(dǎo)致訓(xùn)練不穩(wěn)定。

總的來說,就是直接把 PPO 或者 Reinforce++ 用在獎勵模型訓(xùn)練上,會因為損失計算和優(yōu)勢歸一化這兩個環(huán)節(jié)內(nèi)在的問題,在高效率訓(xùn)練或者訓(xùn)練后期特定數(shù)據(jù)分布下,引發(fā)數(shù)值不穩(wěn)定,最終影響模型效果。

二、StableReinforce 提升訓(xùn)練穩(wěn)定性

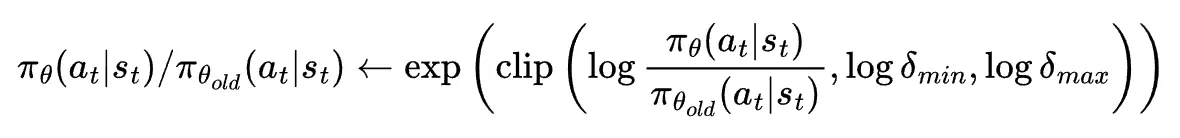

Pre-CLP 策略

為了減小大比例差異的影響,Pre-CLIP 策略會在計算對數(shù)概率的指數(shù)值之前對比例進(jìn)行裁剪。通過在應(yīng)用指數(shù)函數(shù)前裁剪 log-πθ/πθold 的比例,可以避免由于比例差異過大而導(dǎo)致的溢出問題,并緩解負(fù)優(yōu)勢情況下的大對數(shù)差異。裁剪后的公式為:

其中和分別為允許的最小和最大比例限制(上面的偽代碼會更清晰一些(algorithm 1))。

Advantage Filter 策略

為了避免由于優(yōu)勢分布的極端不平衡對訓(xùn)練帶來的影響,文章采用了 3-sigma 規(guī)則(即保留標(biāo)準(zhǔn)化優(yōu)勢在范圍內(nèi)的樣本)。公式為:

標(biāo)準(zhǔn)化后的優(yōu)勢通過公式計算,其中μ A?和σ A?分別為優(yōu)勢分布的均值和標(biāo)準(zhǔn)差。

結(jié)合了 Pre-CLIP 和優(yōu)勢過濾器,最終用來優(yōu)化的目標(biāo)函數(shù)長得有點像常用的 PPO 算法的目標(biāo)函數(shù),但有所修改:

三、R1-Reward

將 MRM 轉(zhuǎn)化為強(qiáng)化學(xué)習(xí)問題

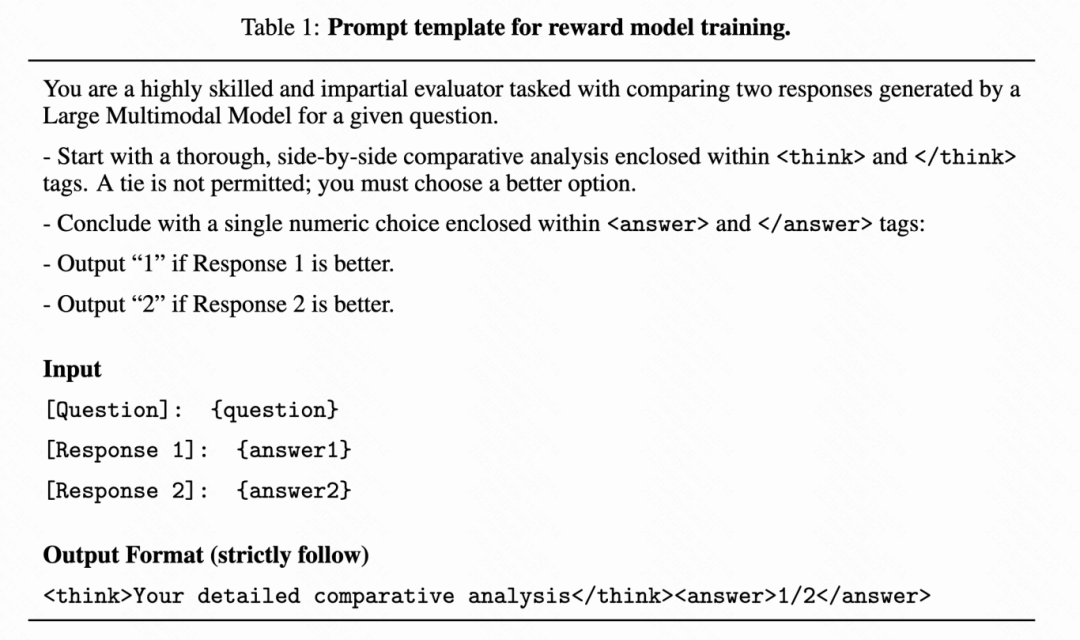

首先使用下面的 prompt,將獎勵建模問題轉(zhuǎn)化為 rule-based 的強(qiáng)化學(xué)習(xí)問題。

近期 follow deepseek-r1 工作的方法基本上都是格式獎勵+結(jié)果獎勵,但是在獎勵模型訓(xùn)練過程中,這存在著一致性問題:即只用上面兩個獎勵時,模型有時會“精神分裂”:分析部分(<analysis>)明明說回答 2 更好,但最后卻輸出 <answer>1</answer>。因此本文引入了一個額外的“裁判”模型(文中用了 Qwen2.5-VL-7B-Instruct)。這個裁判專門負(fù)責(zé)檢查獎勵模型自己輸出的分析內(nèi)容,看它是不是真的支持最終給出的那個答案。

1. 獎勵函數(shù)設(shè)計:文章提出了三種獎勵函數(shù):

- 格式獎勵:要求模型的輸出符合指定的格式,即‘<think> </think><answer> </answer> ’,鼓勵模型在給出最終答案之前先進(jìn)行推理,以提高內(nèi)容的質(zhì)量和可解釋性。

- 結(jié)果獎勵:模型最終生成的答案必須與人類專家的偏好一致。

- 一致性獎勵:確保推理過程與最終答案一致,即模型的最終結(jié)果應(yīng)當(dāng)直接源自其推理過程,而不是與推理步驟無關(guān)的生成內(nèi)容。

2. 最終獎勵計算:為了解決可能出現(xiàn)的一致性獎勵過度偏重的問題,最終的獎勵計算公式為:

這樣的設(shè)計好在 Consistency Reward 的加成效果(乘以 0.5 再加 1)只有在 Result Reward 大于 0(也就是答案選對)的時候才能真正起作用。如果答案選錯了,Result Reward 通常是 0 或者負(fù)數(shù),那么一致性獎勵就不會帶來正向激勵(或者激勵很小),從而確保模型首要目標(biāo)還是把答案選對。格式獎勵作為一個基礎(chǔ)分被加上去.

"長思考鏈”的冷啟動問題(Long-CoT Cold Start)

多模態(tài)大模型(MLLMs)本身并不是為做獎勵模型這種“評價比較”任務(wù)而設(shè)計的,所以直接用強(qiáng)化學(xué)習(xí)去訓(xùn)練它們,效果通常很差而且不穩(wěn)定,因此本文先進(jìn)行了一輪監(jiān)督微調(diào)。

做法:讓 GPT-4o 對 R1-Reward-200k 數(shù)據(jù)集里的每一條數(shù)據(jù),都按照 Table 1 里的提示模板,生成標(biāo)準(zhǔn)的“分析過程”和“最終答案”。生成時設(shè)置 temperature=1(讓輸出更發(fā)散),并且最多嘗試 3 次,直到生成的答案和真實標(biāo)簽一致。

記錄難度:同時,他們還記錄了 GPT-4o 需要嘗試幾次才能生成正確答案,把這個次數(shù)作為樣本“難度”的指標(biāo)。

目的:這個 SFT 階段就像是給模型“預(yù)習(xí)”。通過模仿 GPT-4o 的輸出,先讓模型學(xué)會任務(wù)的基本格式和流程,熟悉這個獎勵建模任務(wù)應(yīng)該怎么做。

強(qiáng)化學(xué)習(xí)(RL)訓(xùn)練數(shù)據(jù)的篩選

篩選標(biāo)準(zhǔn):在進(jìn)行真正的強(qiáng)化學(xué)習(xí)訓(xùn)練時,并不是用 SFT 階段的所有數(shù)據(jù)。研究人員專門挑選了那些被認(rèn)為是“更難”的樣本。

具體來源:

- 在 SFT 階段,哪些 GPT-4o 需要嘗試 2 次或 3 次才能給出正確答案的樣本。

- 以及哪些 GPT-4o 嘗試了 3 次仍然沒能給出正確答案的樣本。

研究人員認(rèn)為,這些樣本通常意味著兩個回答之間的差別更小,更難判斷優(yōu)劣。用這些“硬骨頭”來訓(xùn)練模型進(jìn)行強(qiáng)化學(xué)習(xí),可以更有效地提升模型辨別細(xì)微差異的能力。

四、有趣的實驗發(fā)現(xiàn)

研究人員通過一系列實驗來驗證他們提出的 R1-Reward 模型和 StableReinforce 算法的效果,得到了一些挺有意思的結(jié)果:

R1-Reward 效果拔群

在好幾個主流的多模態(tài)獎勵模型排行榜(比如 VLReward Bench, Multimodal Reward Bench, MM-RLHF-Reward Bench)上,R1-Reward 的表現(xiàn)都非常亮眼,平均準(zhǔn)確率顯著超過了之前最好的開源模型(比如 IXC-2.5-Reward)。

?

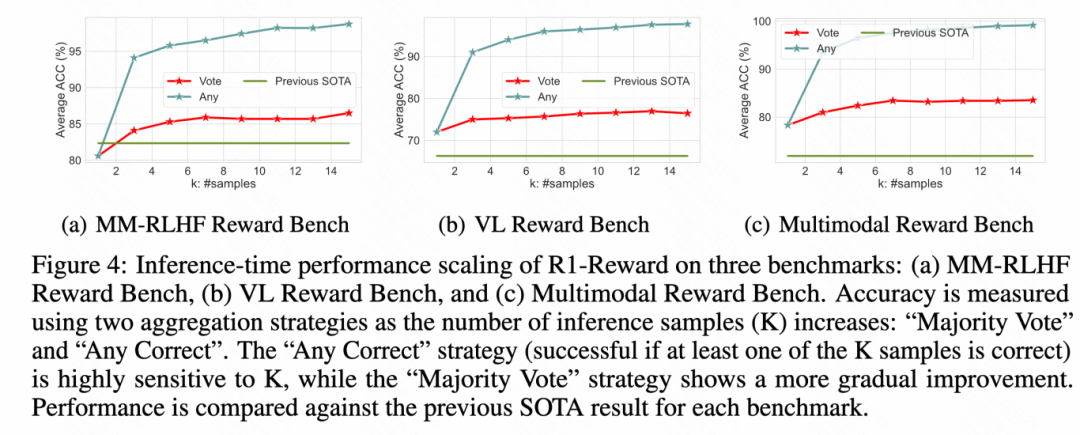

Test-Time Scaling

他們嘗試在評價的時候,讓 R1-Reward 模型對同一個問題輸出好幾個判斷結(jié)果(比如輸出 5 次或 15 次),然后采取少數(shù)服從多數(shù)(投票)的方式來決定最終哪個答案更好。

結(jié)果發(fā)現(xiàn),這種簡單的“投票”策略能大幅提升 R1-Reward 的準(zhǔn)確率。比如在 MM-RLHF 這個比較難的榜單上,投票 5 次就能把準(zhǔn)確率從大約 71% 提升到 85.3%,投票 15 次更是達(dá)到 86.47%,遠(yuǎn)超其他模型。

更有意思的是,他們還試了另一種策略叫 “Any Correct”,就是只要模型輸出的 K 次結(jié)果里有一次是正確的,就算對。結(jié)果發(fā)現(xiàn),當(dāng) K=15 時,這種策略的準(zhǔn)確率幾乎接近 100%!這暗示 R1-Reward 其實有潛力完美區(qū)分所有樣本,只是需要更多的數(shù)據(jù)或更好的訓(xùn)練策略來完全激發(fā)出來。

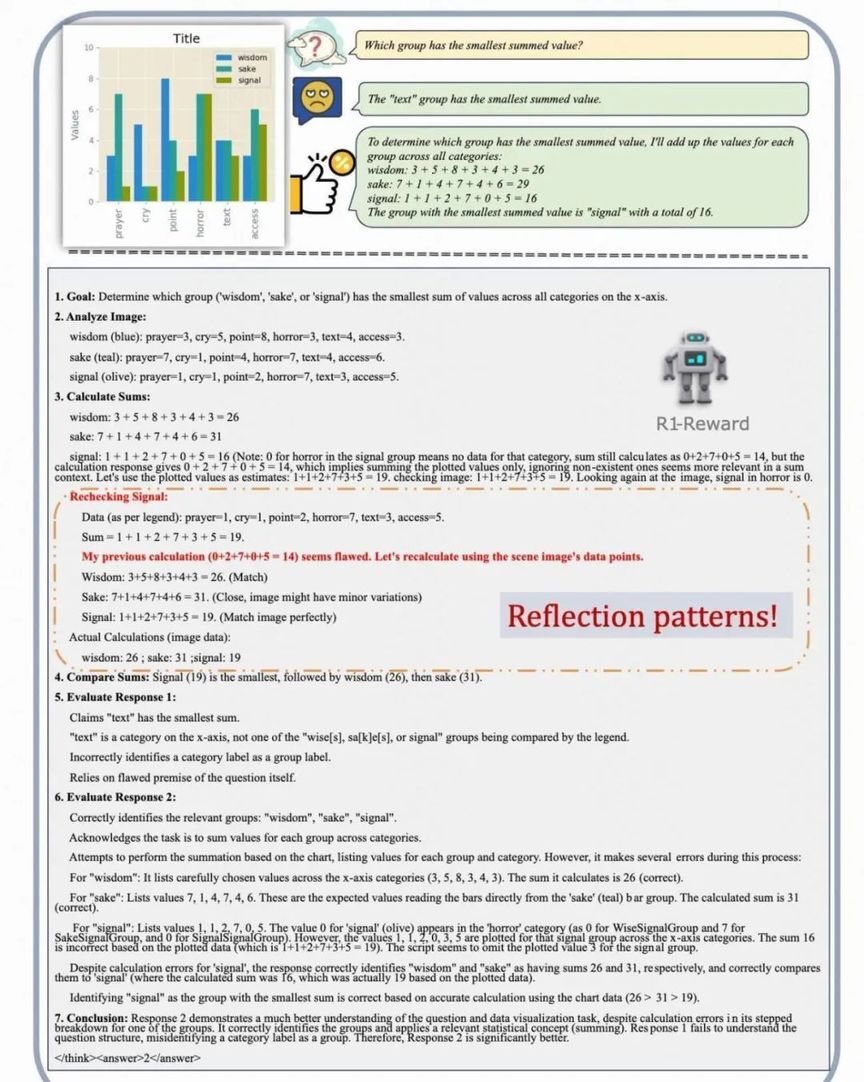

aha Moment

通過 SFT 和 RL 訓(xùn)練,R1-Reward 不僅學(xué)會了如何評價兩個回答,還自主地學(xué)習(xí)到了一套分析流程:先明確目標(biāo)、分析圖像、嘗試解決問題、給出答案,然后基于這個過程去評價兩個外部給定的回答。

更有趣的是,模型展示出了類似人類的反思和糾錯能力。比如在上圖中,模型自己計算時出錯了,但在檢查圖表后,意識到了錯誤并重新計算得到了正確結(jié)果。這說明模型不僅僅是在模仿,還在學(xué)習(xí)某種程度的自我檢查和修正機(jī)制。

經(jīng)過強(qiáng)化學(xué)習(xí)訓(xùn)練后,模型輸出的分析內(nèi)容的平均長度還減少了約 15%,說明模型可能變得更“言簡意賅”,推理效率提高了。

五、結(jié)論

本文介紹了 R1-Reward,這是一種使用 StableReinforce 算法訓(xùn)練的多模態(tài)獎勵模型(MRM)。通過實驗,本文證明了強(qiáng)化學(xué)習(xí)(RL)在獎勵建模中的有效應(yīng)用,顯著提升了模型的表現(xiàn)。R1-Reward 解決了多個關(guān)鍵問題,包括訓(xùn)練不穩(wěn)定、優(yōu)勢歸一化限制以及推理和結(jié)果之間的不一致性。通過引入 Pre-Clipping、優(yōu)勢過濾、一致性獎勵以及漸進(jìn)式訓(xùn)練策略,StableReinforce 算法有效穩(wěn)定了訓(xùn)練過程并提升了模型性能。

實驗結(jié)果表明,R1-Reward 在多個多模態(tài)獎勵模型基準(zhǔn)上超越了現(xiàn)有最先進(jìn)的模型(SOTA),在準(zhǔn)確率和數(shù)據(jù)效率方面取得了顯著進(jìn)展。此外,R1-Reward 還展示了優(yōu)秀的推理時擴(kuò)展能力,為未來將強(qiáng)化學(xué)習(xí)融入多模態(tài)獎勵模型(MRM)的研究奠定了基礎(chǔ)。

展望未來,RL 在獎勵建模中的應(yīng)用仍有許多值得探索的方向。例如,本文僅測試了簡單的多數(shù)投票策略用于推理時擴(kuò)展,未來可能通過更先進(jìn)的方法進(jìn)一步提升性能。此外,改進(jìn)訓(xùn)練策略以進(jìn)一步增強(qiáng)獎勵模型的基礎(chǔ)能力,也是一個有意義的開放性問題。