只要你一句話,馬斯克就得留掃把頭,項目已開源

本文經(jīng)AI新媒體量子位(公眾號ID:QbitAI)授權(quán)轉(zhuǎn)載,轉(zhuǎn)載請聯(lián)系出處。

現(xiàn)在,Adobe不想讓你用手P圖了——動動口就行。

只需要你說一句話,計算機就能P出你想要的效果。

例如,說出想要的發(fā)型,馬斯克就會立刻被剃頭:“Hi-top Fade(掃把頭),變!”

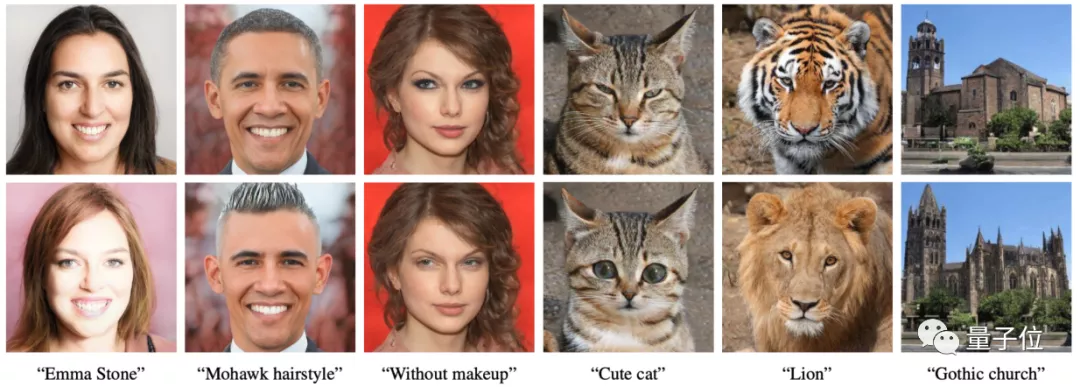

膚色、妝容也都能輕松改變,一句“face with/without makeup”就能上妝/卸妝:

△給霉霉上妝/卸妝

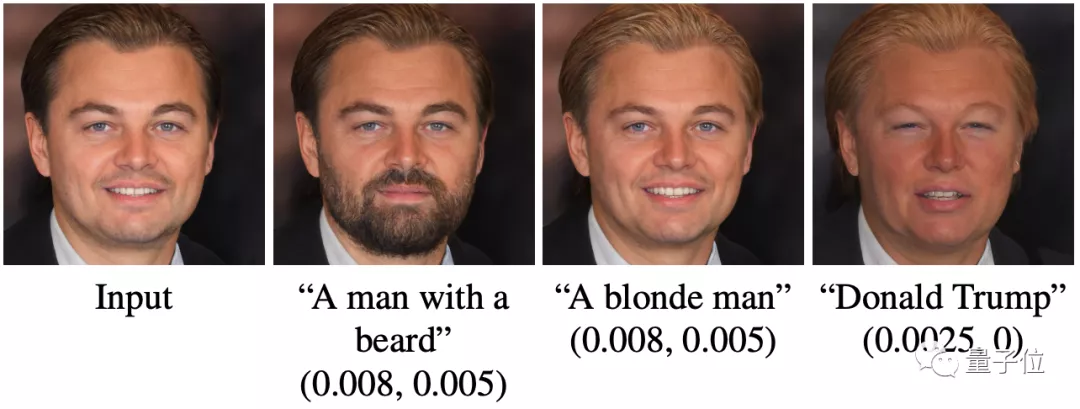

甚至還能直接改變?nèi)藰樱o小李子變出胡子、金發(fā)后,變成特朗普!

除了人,動物、景物也能P。

輸入“cute cat”,就能讓圖中的貓變成“大眼萌貓”:

說一句“classic car”,它就能把你的車P成經(jīng)典古老的車型,還能手動調(diào)復(fù)古程度:

簡直是手殘P圖玩家的福音。

沒錯,這是來自Adobe、希伯來大學(xué)、特拉維夫大學(xué)的新操作,只需要一句話,就能讓計算機“修”出你想要的圖片。

現(xiàn)在,項目已經(jīng)開源。

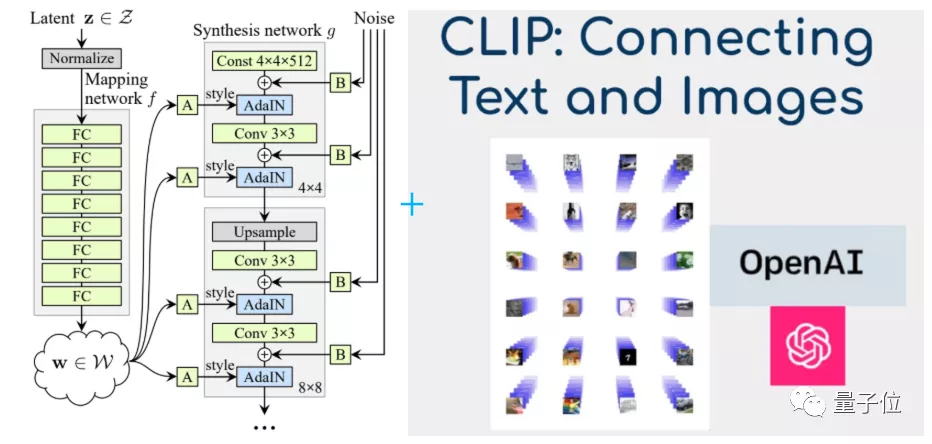

當(dāng)GAN遇上CLIP

這一神奇的操作,來自一種新算法:StyleCLIP。

沒錯,就是將目前最先進的GAN——StyleGAN,和OpenAI搞出來的CLIP模型結(jié)合到一起。

為何選擇這兩個模型?

其中,CLIP不能自己生成圖像,但具有很好的圖像分類效果。

它不僅可以理解輸入的詞語,還能將語義和圖像特征聯(lián)系起來。

也就是說,CLIP有著和人腦極為相似的工作方式,不僅能將CV和NLP從技術(shù)上打通,還給他們分配了專門的處理區(qū)域。

例如,一旦聽到“蜘蛛俠”三個字、或是看到蜘蛛俠的照片,CLIP的某個特殊區(qū)域就開始響應(yīng),甚至原本用來響應(yīng)紅色和藍(lán)色的區(qū)域也會“躁動”。

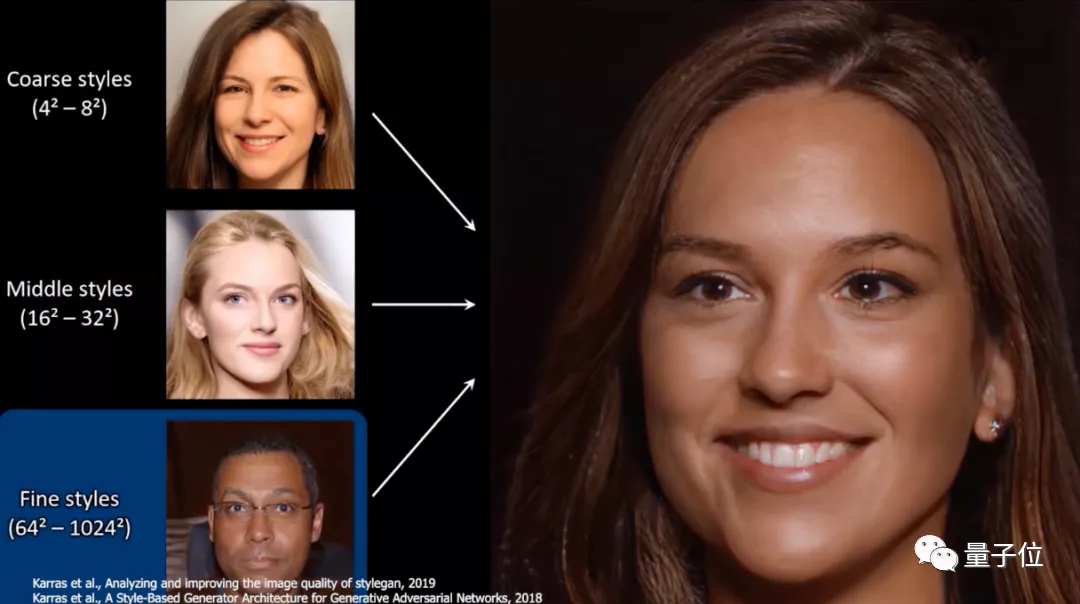

而StyleGAN,雖然能實現(xiàn)照片級模擬,生成非常逼真的圖像:

但StyleGAN、StyleGAN2等一系列GAN模型,卻沒辦法獨立更改如面部外觀、形狀或表情等參數(shù),只能像下面這樣,從整體、中等、微調(diào)等大方向去改變形象:

如果將CLIP和StyleGAN合成新模型,只需要一句文本信息,它就能幫你P出既逼真、又能控制細(xì)節(jié)的圖像來。

點點鼠標(biāo),就能調(diào)整效果

事實上,模型的效果也確實不錯,功能非常全面。

還自帶一個圖形界面窗口:用一句話說出需求后,用鼠標(biāo)就能進行調(diào)節(jié)。

例如,一鍵將英國首相鮑里斯·約翰遜(Alexander Boris de Pfeffel Johnson)變成女人:

還能讓他愁眉不展、或是開口大笑:

不僅能記住一整個人的面部特征,并根據(jù)需要換臉、換頭發(fā)、換妝;還能應(yīng)用在動物身上,甚至將老虎變成獅子:

當(dāng)然,將普通的房子變成哥特式(gothic)建筑也行。

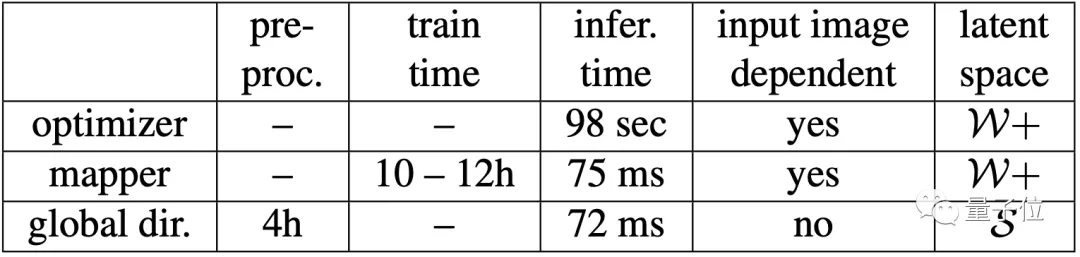

在單個NVIDIA GTX 1080Ti GPU上,進行全局預(yù)處理的時間是4個小時。預(yù)處理后,就能將不同的文本-圖像對應(yīng)用在上面了。

至于訓(xùn)練的時間,則需要跑10~12個小時,加上優(yōu)化器后的推理時間是98秒。

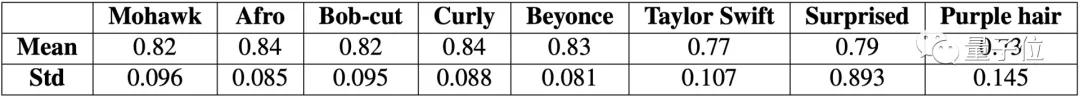

那么,模型的穩(wěn)定性如何?

即使背景人物不同,在用一句話P圖后,它們之間的相似度也能達(dá)到73%以上,最高能達(dá)到84%。

也就是說,模型改變特征的效果還是很穩(wěn)定的。

當(dāng)然,即使測試效果很好,網(wǎng)友們還是發(fā)現(xiàn)了一些圖片生成的bug。

例如,網(wǎng)友發(fā)現(xiàn),長著胡子的男性,看起來要比沒有胡子的男性更生氣?

有網(wǎng)友在測試后表示,個別效果如“加深男性膚色”(tanned man)確實不夠好,需要進行數(shù)據(jù)清洗。

除此之外,也有網(wǎng)友建議作者嘗試進一步研究,如模型中的偏見性。

例如,試試“成功的男人/女人”、“罪犯”等形容詞,看看這個模型會生成什么。

作者介紹

一作Or Patashnik,來自特拉維夫大學(xué)(Tel-Aviv University),主要研究方向是計算機視覺。

共同一作吳宗澤(Zongze Wu),來自希伯來大學(xué)(Hebrew University of Jerusalem),主要研究方向是計算機視覺,包括GAN、圖像處理、圖像翻譯等。

三作Eli Shechtman,來自Adobe,研究方向是計算機視覺,包括視頻分析與合成、目標(biāo)和動作識別、圖形視覺、圖像和視頻檢索等。

此外,來自特拉維夫大學(xué)的Daniel Cohen-Or、和希伯來大學(xué)的Dani Lischinski對這篇論文也有貢獻(xiàn)。

說不定,Adobe真會將“動口P圖”這一功能放進PS中呢。

項目地址:

https://github.com/orpatashnik/StyleCLIP

論文地址:

https://arxiv.org/abs/2103.17249