橫掃六大權(quán)威榜單,達摩院自家深度語言模型體系A(chǔ)liceMind開源了

自然語言處理(NLP)被譽為 AI 皇冠上的明珠,傳統(tǒng) NLP 模型制作復(fù)雜,耗時耗力,且用途單一,難以復(fù)用,猶如手工作坊。而近幾年興起的預(yù)訓(xùn)練語言模型,正在改變局面,有望讓語言 AI 走向可規(guī)模化復(fù)制的工業(yè)時代。因此,「預(yù)訓(xùn)練 + 精調(diào)」已成為 NLP 任務(wù)的新范式。

阿里巴巴達摩院作為最早投入預(yù)訓(xùn)練語言模型研究的團隊之一,歷經(jīng)三年研發(fā)出深度語言模型體系 AliceMind, 在通用語言模型 StructBERT 的基礎(chǔ)上,拓展到多語言、生成式、多模態(tài)、結(jié)構(gòu)化、知識驅(qū)動等方向,能力全面。其中的模型先后登頂 GLUE、CLUE、XTREME、VQA Challenge、DocVQA、MS MARCO 在內(nèi)的自然語言處理領(lǐng)域六大權(quán)威榜單,領(lǐng)先業(yè)界,相關(guān)工作論文被 AI/NLP 頂會接收,并在 6 月入選 2021 世界人工智能大會最高獎 SAIL 獎 TOP30 榜單。

上周 AliceMind 再次登頂多模態(tài)權(quán)威榜單 VQA Challenge 2021 視覺問答挑戰(zhàn)賽,戰(zhàn)勝了微軟、Facebook 等幾十家國際頂尖團隊,超越第二名 1 個點,將紀錄從去年第一名的 76.36% 顯著提升到 79.78%,接近人類水平(80.78%)。

就在近日,阿里巴巴達摩院宣布正式開源 AliceMind。達摩院相關(guān)負責人表示,希望通過開源來降低業(yè)界研究和創(chuàng)新應(yīng)用的門檻,助推語言 AI 進入大工業(yè)時代。

據(jù)介紹,達摩院深度語言模型體系 AliceMind,包括通用語言模型 StructBERT、多語言 VECO、生成式 PALM、多模態(tài) StructVBERT、結(jié)構(gòu)化 StructuralLM、知識驅(qū)動 LatticeBERT、機器閱讀理解 UED、超大模型 PLUG 等,此次大部分已開源。此外,AliceMind 之后將圍繞「預(yù)訓(xùn)練 + 精調(diào)」語言模型持續(xù)進行生態(tài)性的技術(shù)開源。

AliceMind 開源地址:

https://github.com/alibaba/AliceMind

AliceMind 體驗入口:

https://nlp.aliyun.com/portal#/alice

AliceMind 的創(chuàng)新之處

1、通用語言模型 StructBERT

Google 于 2018 年底推出的 BERT 模型是業(yè)界廣泛使用的自然語言預(yù)訓(xùn)練模型,達摩院團隊在 BERT 的基礎(chǔ)上提出優(yōu)化模型 StructBERT,讓機器更好地掌握人類語法,理解自然語言,2020 年多次在自然語言處理領(lǐng)域頂級賽事 GLUE Benchmark 上奪冠。

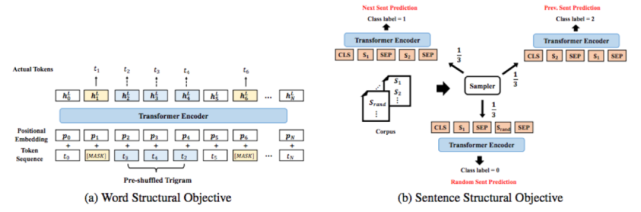

StructBERT 通過在句子級別和詞級別引入兩個新的目標函數(shù),好比給機器內(nèi)置一個「語法識別器」,使機器在面對語序錯亂或不符合語法習慣的詞句時,仍能準確理解并給出正確的表達和回應(yīng),大大提高機器對詞語、句子以及語言整體的理解力。相關(guān)論文被 ICLR2020 接收。

2、多語言語言模型 VECO

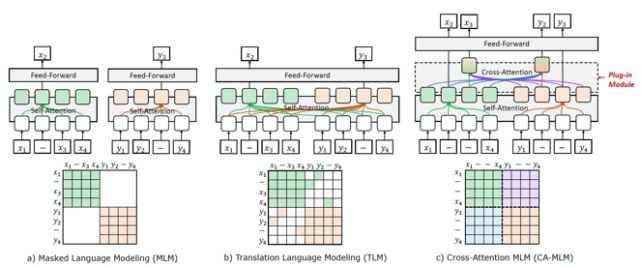

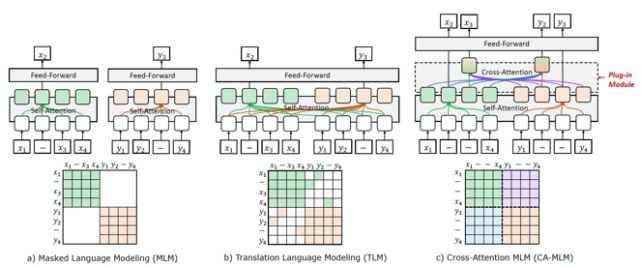

跨語言預(yù)訓(xùn)練初衷是為多種語言建立起一個統(tǒng)一聯(lián)合的語義表示,AliceMind 體系內(nèi)的跨語言預(yù)訓(xùn)練模型 VECO 一經(jīng)提出,便在國際權(quán)威多語言榜單 XTREME 排名第一,遠超 Facebook、Microsoft 等業(yè)界代表性模型。VECO 目前支持 100 種語言的理解和生成任務(wù)。

VECO 效果亮眼,主要是因為兩項創(chuàng)新:一是其可以更加「顯式」地進行跨語言信息的建模(圖 1);二是 VECO 在預(yù)訓(xùn)練的過程充分學習用于語言理解(NLU)和生成(NLG)任務(wù),并讓二者互相學習提高彼此(圖 2)。因此,VECO 模型成為了多語言領(lǐng)域內(nèi)的第一個同時在多語言理解(NLU)和語言生成(NLG)任務(wù)上均取得業(yè)內(nèi)最佳效果的模型,相關(guān)論文被頂會 ACL 2021 接收。

圖 1

圖 2

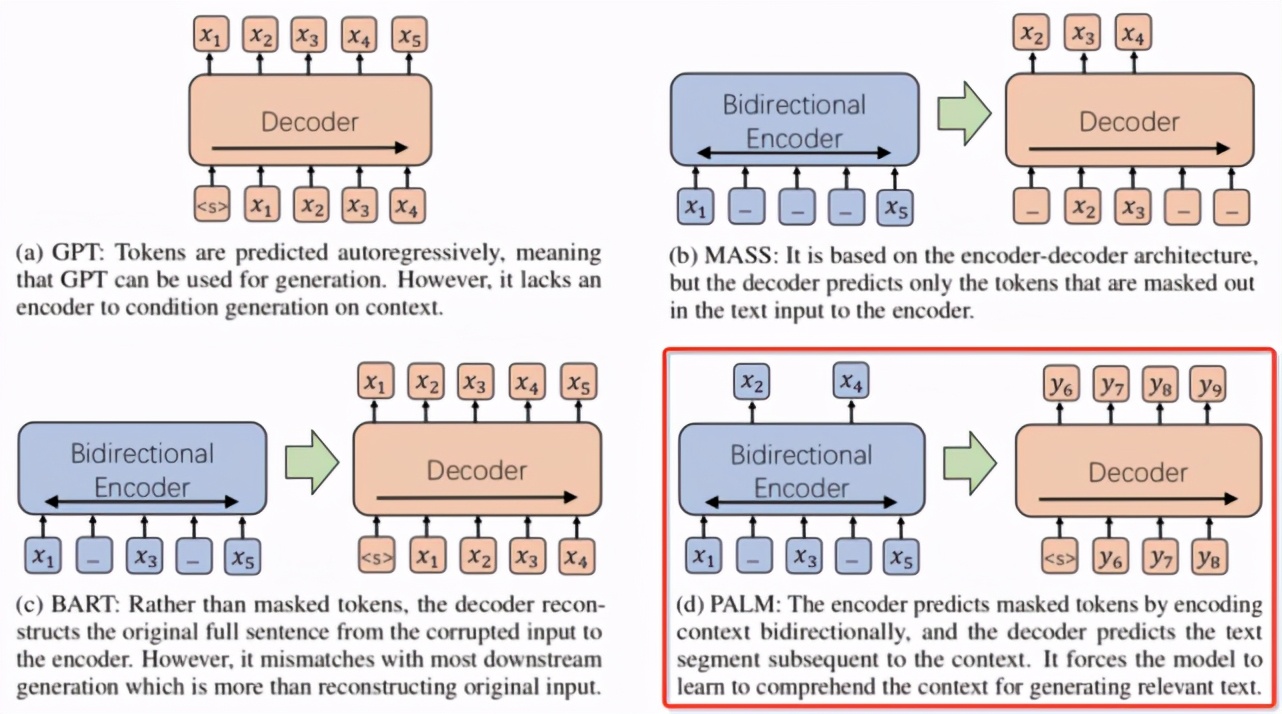

3、生成式語言模型 PALM

PALM 采用了與之前的生成模型不同的預(yù)訓(xùn)練方式,將預(yù)測后續(xù)文本作為其預(yù)訓(xùn)練目標,而非重構(gòu)輸入文本。PALM 在一個模型中使用自編碼方式來編碼輸入文本,同時使用自回歸方式來生成后續(xù)文本。這種預(yù)測后續(xù)文本的預(yù)訓(xùn)練促使該模型提高對輸入文本的理解能力,從而在下游的各個語言生成(NLG)任務(wù)上取得更好的效果。

PALM 在 MARCO NLG 自然語言生成公開評測上取得了排行榜第一,同時在摘要生成標準數(shù)據(jù)集 CNN/DailyMail 和 Gigaword 上也超過了現(xiàn)有的各個預(yù)訓(xùn)練生成語言模型。PALM 可被用于問答生成、文本復(fù)述、回復(fù)生成、文本摘要、Data-to-Text 等生成應(yīng)用上。相關(guān)文章已被頂會 ACL2020 錄用。

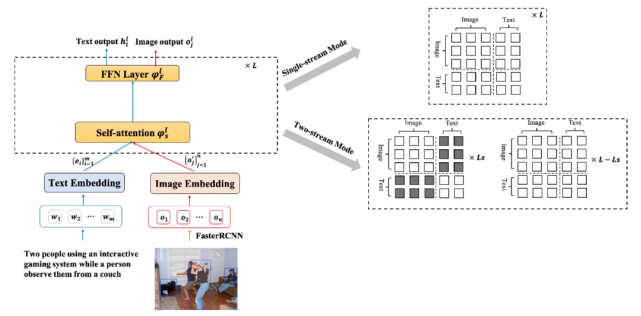

4、多模態(tài)語言模型 StructVBERT

StructVBERT 是在通用的 StructBERT 模型基礎(chǔ)上,同時引入文本和圖像模態(tài),在統(tǒng)一的多模態(tài)語義空間進行聯(lián)合建模,在單流架構(gòu)的基礎(chǔ)上同時引入圖像 - 文本描述數(shù)據(jù)和圖像問答數(shù)據(jù)進行多任務(wù)預(yù)訓(xùn)練,并在多尺度的圖像特征上進行分階段預(yù)訓(xùn)練。此外,模型利用 attention mask 矩陣控制實現(xiàn)雙流架構(gòu),從而提升跨模態(tài)雙流建模能力,結(jié)合單流、雙流結(jié)構(gòu)的優(yōu)點進一步提升模型對文本和圖像兩個模態(tài)的理解能力。相關(guān)文章已被頂會 ACL2021 錄用。

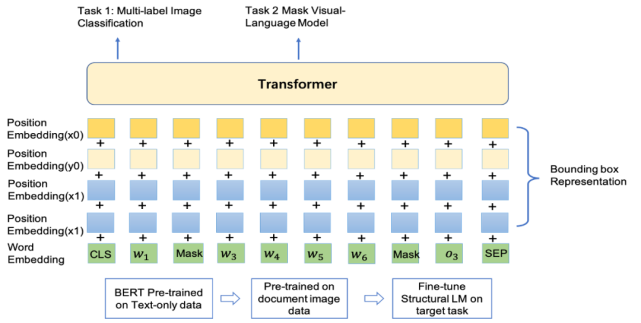

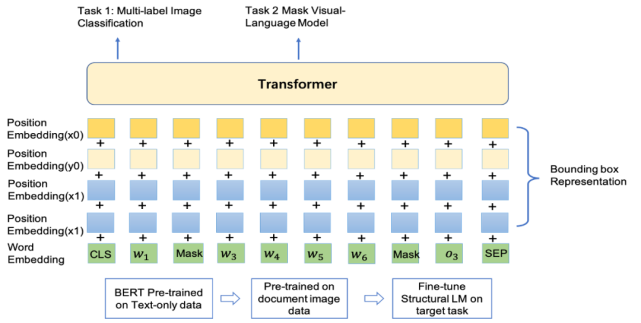

5、結(jié)構(gòu)化語言模型 StructuralLM

StructuralLM 在語言模型 StructBERT 的基礎(chǔ)上擴展到結(jié)構(gòu)化語言模型,充分利用圖片文檔數(shù)據(jù)的 2D 位置信息,并引入 box 位置預(yù)測的預(yù)訓(xùn)練任務(wù),幫助模型感知圖片不同位置之間詞語的關(guān)系,這對于理解真實場景中的圖片文檔十分重要。Structural LM 模型在 DocVQA 榜單上排名第一,同時在表單理解 FUNSD 數(shù)據(jù)集和文檔圖片分類 RVL-CDIP 數(shù)據(jù)集上也超過現(xiàn)有的所有預(yù)訓(xùn)練模型。相關(guān)文章已被頂會 ACL2021 錄用。

6、機器閱讀理解模型 UED

自最開始聲名大噪的 SQuAD 榜單起,阿里圍繞著機器閱讀理解發(fā)展路線:單段落抽取 -> 多文檔抽取 / 檢索 -> 多文檔生成 -> 開放式閱讀理解,拿下了一系列的榜單冠軍:

- 2018 年在單段落機器閱讀理解領(lǐng)域頂級賽事 SQuAD 上首次超出人類回答精準率;

- 2018 年在多文檔機器閱讀理解權(quán)威比賽 TriviaQA 和 DuReader 上雙雙刷新紀錄,取得第一名;

- 2019 年在信息檢索國際頂級評測 TREC 2019 Deep Learning Track 上的段落檢索和文檔檢索任務(wù)上均取得第一名;

- 2019 年在機器閱讀理解頂級賽事 MS MARCO 的段落排序、多文檔答案抽取以及多文檔答案生成 3 個任務(wù)均取得第一名,并在多文檔答案抽取任務(wù)上首次超越人類水平。

相關(guān)論文已被 AAAI2021 接收。

7、超大規(guī)模中文理解和生成統(tǒng)一模型 PLUG

PLUG 是目前中文社區(qū)已開放 API 的最大規(guī)模的純文本預(yù)訓(xùn)練語言模型,集語言理解與生成能力于一身。PLUG 可為目標任務(wù)做針對性優(yōu)化,通過利用下游訓(xùn)練數(shù)據(jù)精調(diào)模型使其在該特定任務(wù)上生成質(zhì)量達到最優(yōu),彌補之前其它大規(guī)模生成模型 few-shot 推理的生成效果不足,適于應(yīng)用在實際生成任務(wù)。同時,PLUG 采用 encoder-decoder 的雙向建模方式,因此,在傳統(tǒng)的 zero-shot 生成的表現(xiàn)上,無論是生成的多樣性,領(lǐng)域的廣泛程度,還是生成長文本的表現(xiàn),較此前的模型均有明顯的優(yōu)勢。

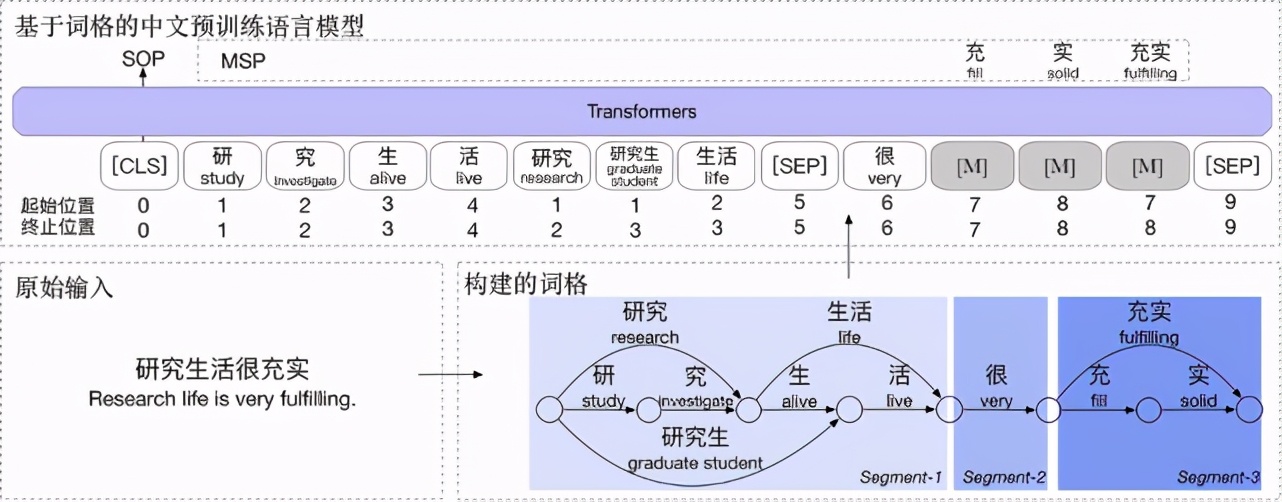

8. 知識驅(qū)動的語言模型 LatticeBERT

LatticeBERT 在預(yù)訓(xùn)練模型中訓(xùn)練中有效地融合了詞典等知識,從而能夠同時建模字和詞的結(jié)構(gòu),來線性化地表示這種混合粒度的輸入。第一步是將涵蓋多粒度字詞信息的中文文本用詞格(Lattice)表示起來,再把這個詞格線性化作為 BERT 的輸入。LatticeBERT 在 2020 年 9 月達到中文語義理解評估基準 CLUE 榜單的 base 模型中的第一名。

霸榜背后,是 AliceMind 持續(xù)創(chuàng)新和進化。達摩院團隊在 BERT 基礎(chǔ)上提出優(yōu)化模型 StructBERT,2020 年多次在 NLP 頂級賽事 GLUE Benchmark 上奪冠。該模型通過在句子和詞級別引入兩個新的目標函數(shù),好比給 AI 裝上「語法識別器」,在面對語法錯亂時,AI 依然能準確理解并給出正確回應(yīng),大大提高機器對語言的整體理解力,相關(guān)文章被 NAACL2021 錄用。

而此次在 VQA Challenge 2021 登頂?shù)亩嗄B(tài)模型 StrucVBERT,融合了通用模型 StructBERT 和結(jié)構(gòu)化模型 StructuralLM,同時引入文本和圖像模態(tài),利用更高效的視覺特征和創(chuàng)新的注意力機制在統(tǒng)一的多模態(tài)語義空間進行聯(lián)合建模。

AliceMind 的應(yīng)用情況

AliceMind 具有閱讀、寫作、翻譯、問答、搜索、摘要生成、對話等多種能力,目前已成為阿里的語言技術(shù)底座,日均調(diào)用量超過 50 億次,活躍場景超過 200 個,已在跨境電商、客服、廣告等數(shù)十個核心業(yè)務(wù)應(yīng)用落地。AliceMind 已上線到內(nèi)部平臺,開箱即用,目前支持訓(xùn)練、精調(diào)、蒸餾、測試、部署五大功能,只需簡單操作即可完成語言模型從訓(xùn)練到部署的完整鏈路。

在阿里之外,AliceMind 廣泛運用于醫(yī)療、能源、金融等多個行業(yè)。其中,浙江電網(wǎng)公司以 AliceMind 為底座為員工構(gòu)建智能化運維平臺,應(yīng)用于變壓器檢修、供電搶修等業(yè)務(wù),已經(jīng)開始在國家電網(wǎng)公司統(tǒng)一推廣。

阿里達摩院深度語言模型團隊負責人黃松芳表示:「預(yù)訓(xùn)練語言模型已成為 NLP 領(lǐng)域的基石和原材料,AliceMind 開源將降低 NLP 領(lǐng)域研究和應(yīng)用創(chuàng)新的門檻,助推行業(yè)從手工業(yè)時代走向大工業(yè)時代。」