世界超大的多語言語音數(shù)據(jù)集現(xiàn)已開源!超40萬小時(shí),共23種語言

本文經(jīng)AI新媒體量子位(公眾號(hào)ID:QbitAI)授權(quán)轉(zhuǎn)載,轉(zhuǎn)載請(qǐng)聯(lián)系出處。

最近,F(xiàn)acebook開源了目前世界上最大的多語言語音數(shù)據(jù)集,VoxPopuli:

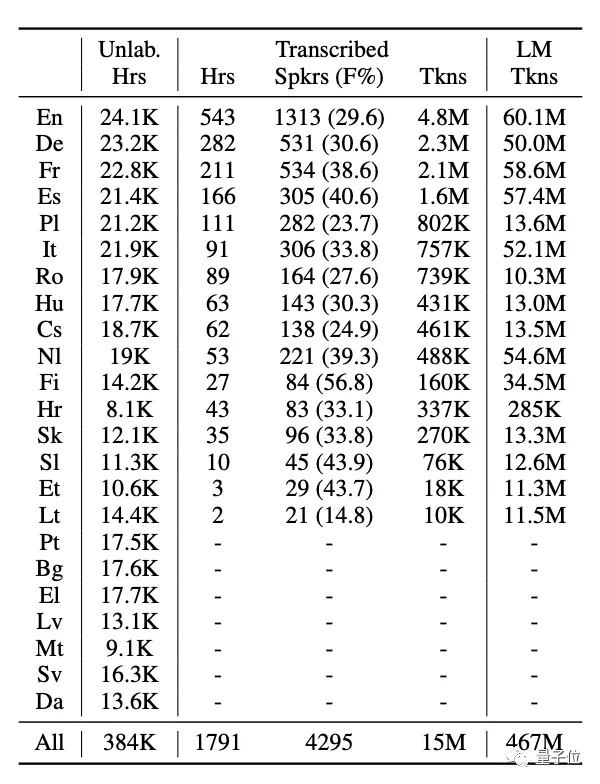

這一數(shù)據(jù)集共涵蓋了23種語言,時(shí)長(zhǎng)超過40萬小時(shí)。

其中,每種語言都有9000到18000小時(shí)的無標(biāo)簽語音數(shù)據(jù)。

此外,還包括了共1800小時(shí),16種語言的轉(zhuǎn)錄語音數(shù)據(jù),以及17300小時(shí),15種目標(biāo)語言的口譯語音數(shù)據(jù)。

國外網(wǎng)友很快為這一行為點(diǎn)贊:

顯然,如果數(shù)據(jù)集已經(jīng)存在,那么它應(yīng)該被利用,并以一種道德的方式來改善人類社會(huì)。

這一數(shù)據(jù)集龐大的無標(biāo)簽數(shù)據(jù)量和廣泛的語言覆蓋率,對(duì)改進(jìn)自監(jiān)督模型有著很大的幫助。

而Facebook也希望能夠幫助提高語音數(shù)據(jù)集的質(zhì)量和魯棒性,使訓(xùn)練語音轉(zhuǎn)換神經(jīng)網(wǎng)絡(luò)更加可靠。

最終加速新的NLP系統(tǒng)的開發(fā),使AI翻譯的效果越來越好。

而數(shù)據(jù)集的名字,VoxPopuli的直譯“人民的心聲”也表示了其原始數(shù)據(jù)的來源——

即源語音全都收集自2009-2020年歐洲議會(huì)的活動(dòng)錄音。

來自10年歐會(huì)的語料庫

在歐洲議會(huì)的各自活動(dòng),如全體會(huì)議、委員會(huì)會(huì)議和其他活動(dòng)上,發(fā)言者都會(huì)以不同的歐盟語言輪流發(fā)表演講。

Facebook就是從歐會(huì)官網(wǎng)上抓取了每個(gè)演講的文字記錄、演講者信息、開始/結(jié)束時(shí)間戳。

然后,將所有的原始演講數(shù)據(jù)進(jìn)行處理,大致分為以下3類:

共40萬小時(shí),23種語言的無標(biāo)簽語音數(shù)據(jù)

每種語言都有8千到2萬多的原始語音數(shù)據(jù)。

因此,F(xiàn)acebook基于能量的語音激活檢測(cè)(VAD)算法,將完整音頻分割成15-30秒的短片段。

最終得到?jīng)]有太多的數(shù)據(jù)不平衡,也不需要調(diào)整數(shù)據(jù)采樣策略的數(shù)據(jù)集。

因此非常適合多語言模型的訓(xùn)練。

而上表中除了無標(biāo)簽數(shù)據(jù),也有轉(zhuǎn)錄的語音數(shù)據(jù),這也就是第二種:

共1800小時(shí),16種語言的轉(zhuǎn)錄語音數(shù)據(jù)

歐會(huì)官方的時(shí)間戳雖然可以用來在會(huì)議中定義演講者,但常常會(huì)被截?cái)啵蚧旌锨昂笱葜v的片段,因此并不完全準(zhǔn)確。

所以Facebook對(duì)全會(huì)話音頻采用了聲紋分割聚類(SD)。

這時(shí)的語音段落平均時(shí)長(zhǎng)為197秒,再利用語音識(shí)別(ASR)系統(tǒng),將其細(xì)分為20秒左右的短片段。

觀察上表,可以看到最終得到的數(shù)據(jù)中,有包括各語言的持續(xù)時(shí)間、發(fā)言人數(shù)量、女性發(fā)言人百分比、標(biāo)記數(shù)量等多種屬性。

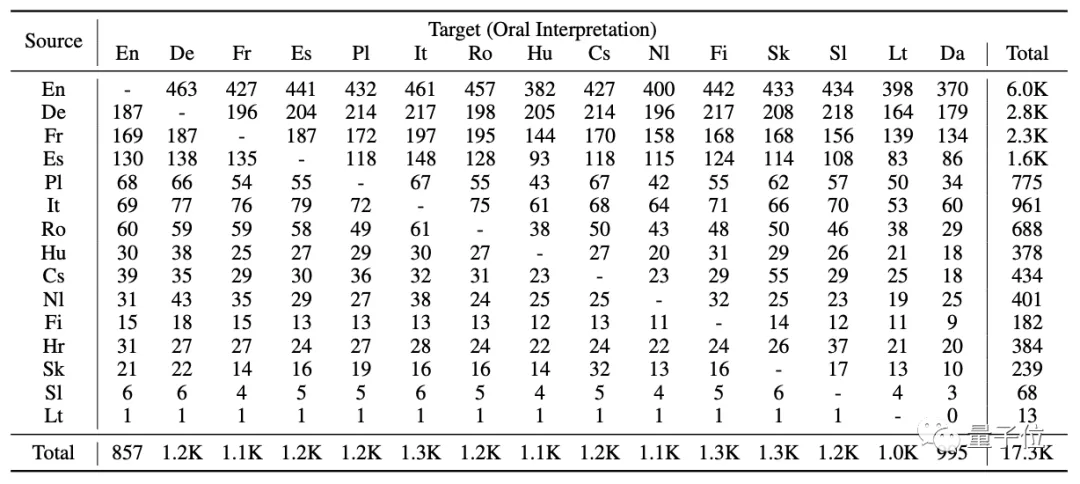

17300小時(shí)的15種目標(biāo)語言的口譯語音數(shù)據(jù):

每個(gè)原始語音都有相對(duì)應(yīng)的同聲傳譯,并互相關(guān)聯(lián)。

但要使這個(gè)數(shù)據(jù)集可用,必須經(jīng)過大量的預(yù)處理和過濾。

因此,F(xiàn)acebook使用了語音識(shí)別(ASR)系統(tǒng)在句子層面上對(duì)齊源語音和目標(biāo)語音。

在域外環(huán)境的半監(jiān)督學(xué)習(xí)下具有通用性

那么這一數(shù)據(jù)集用起來到底怎么樣?

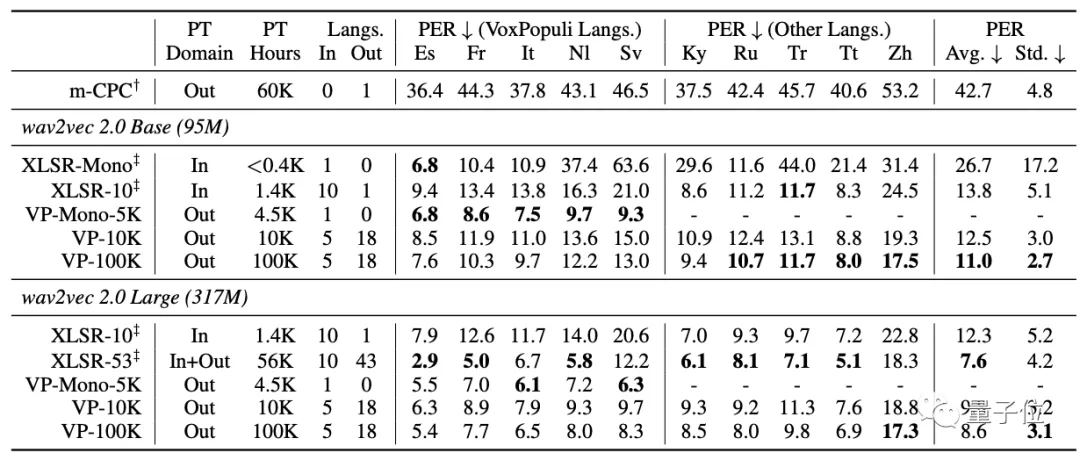

首先,是使用包含了域外語言(out-of-domain out-of-language)的無監(jiān)督預(yù)訓(xùn)練,進(jìn)行少樣本的語音識(shí)別:

可以從表中看到,VP-Mono5K在5種VoxPopuli語言上,都優(yōu)于XLSR-Mono和XLSR-10。

而VP-100K則在10種語言中的8種上的都比XLSR-10的表現(xiàn)更好。

并且,雖然XLSR-53涵蓋了Zh語言,但與VP-100K(Large)在Zh上的表現(xiàn)相距甚遠(yuǎn)。

這表明VP-100K所學(xué)的語音表征具有高度的通用性。

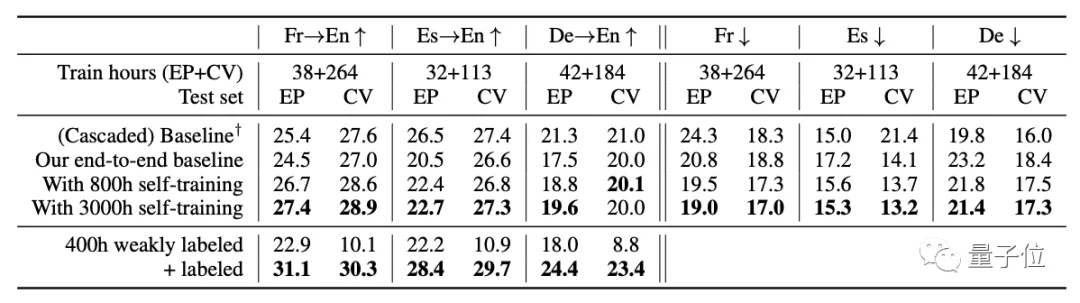

然后是使用VoxPopuli數(shù)據(jù)集進(jìn)行自我訓(xùn)練或弱監(jiān)督的語言翻譯(ST)和語音識(shí)別(ASR):

從表中可以看到,不管是對(duì)于域內(nèi)語言還是域外語言,對(duì)VoxPopuli的自我訓(xùn)練在大多數(shù)時(shí)候都能夠提高性能。

而在翻譯上,也不用再增加昂貴的標(biāo)簽數(shù)據(jù)。

通過自我訓(xùn)練,就能夠縮小端到端模型和級(jí)聯(lián)模型之間的差距。

論文地址:

https://arxiv.org/abs/2101.00390

下載:

https://github.com/facebookresearch/voxpopuli