Meta用《圣經》訓練超多語言模型:識別1107種、辨認4017種語言

在《圣經》中有一個巴別塔的故事,說是人類聯合起來計劃興建一座高塔,希望能通往天堂,但神擾亂了人類的語言,計劃也就因此失敗。到了今天,AI 技術有望拆除人類語言之間的藩籬,幫助人類造出文明的巴別塔。

近日,Meta 的一項研究向這個方面邁出了重要一步,他們將新提出的方法稱為 Massively Multilingual Speech(超多語言語音 / MMS),其以《圣經》作為訓練數據的一部分,得到了以下成果:

- 在 1107 種語言上用 wave2vec 2.0 訓練得到了一個有 10 億參數的多語言語音識別模型,相比于 OpenAI 的 Whisper 模型,其錯誤率降低了 50% 以上。

- 單個音頻合成模型就支持這 1107 種語言的文本轉語音(TTS)。

- 開發了一個能夠辨別 4017 種語言的語言辨識分類器。

對于很多罕見語言的數據稀少問題,Meta 是如何解決的呢?他們采用的方法很有意思,即采用宗教的語料庫,因為像是《圣經》這樣的語料具有最「對齊的」語音數據。盡管這個數據集偏向宗教內容并且主要是男性聲音,但其論文表明這個模型在其它領域以及使用女聲時也表現優良。這是基礎模型的涌現行為,著實讓人驚嘆。而更讓人驚嘆的是,Meta 將新開發的模型(語音識別、TTS 和語言辨識)都免費發布出來了!

- 模型下載:https://github.com/facebookresearch/fairseq/tree/main/examples/mms

- 論文地址:https://research.facebook.com/publications/scaling-speech-technology-to-1000-languages/

新提出的方法

為了打造出一個能識別千言萬語的語音模型,首要的挑戰是收集各種語言的音頻數據,因為現目前已有的最大語音數據集也只有至多 100 種語言。為了克服這個問題,Meta 的研究者使用了宗教文本,比如《圣經》,這些文本已被翻譯成了許多不同語言,并且那些譯本都已被廣泛研究過。這些譯本都有人們用不同語言閱讀的錄音,并且這些音頻也是公開可用的。使用這些音頻,研究者創建了一個數據集,其中包含人們用 1100 種語言閱讀《新約》的音頻,其中每種語言的平均音頻長度為 32 小時。

然后他們又納入了基督教的其它許多讀物的無標注錄音,從而將可用語言數量增加到了 4000 以上。盡管這個數據集領域單一,并且大都是男聲,但分析結果表明 Meta 新開發的模型在女聲上表現也同樣優良,并且該模型也不會格外偏向于產生更宗教式的語言。研究者在博客中表示,這主要是得益于他們使用的 Connectionist Temporal Classification(連接主義時間分類)方法,相比于大型語言模型(LLM)或序列到序列語音識別模型,這種方法要遠遠更為受限。

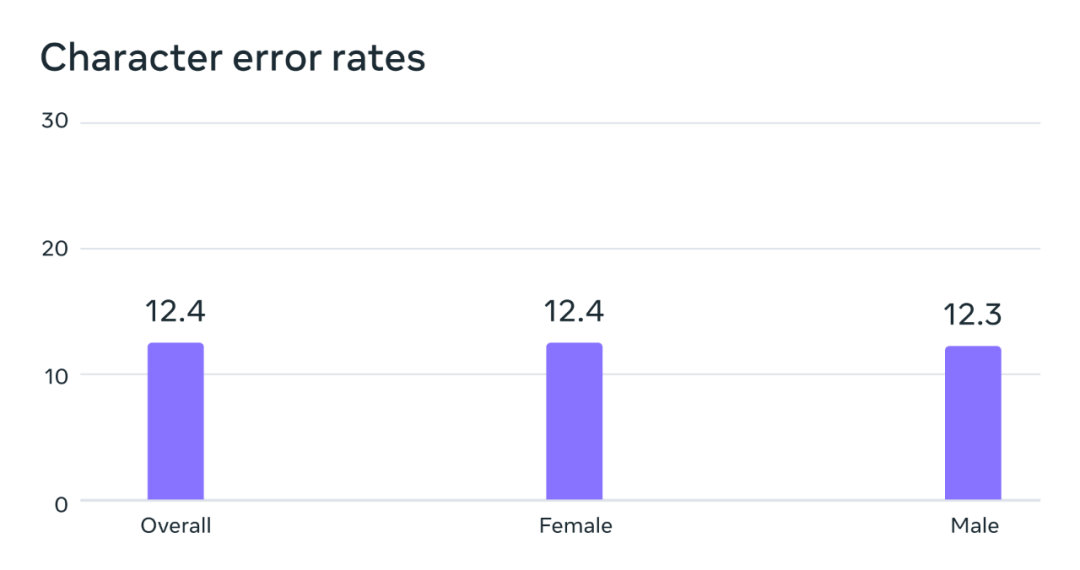

潛在的性別偏見情況分析。在 FLEURS 基準上,這個在超多語言語音(MMS)數據集上訓練的自動語音識別模型在男聲和女聲上的錯誤率是差不多的。

為了提升數據質量,使之能被機器學習算法使用,他們還采用了一些預處理方法。首先,他們在現有的 100 多種語言的數據上訓練了一個對齊模型,然后再搭配使用了一個高效的強制對齊算法,該算法可處理 20 分鐘以上的超長錄音。之后,經過多輪對齊過程,最終再執行一步交叉驗證過濾,基于模型準確度移除可能未對齊的數據。為了方便其他研究者創建新的語音數據集,Meta 將該對齊算法添加到了 PyTorch 并放出了該對齊模型。

要訓練出普遍可用的監督式語音識別模型,每種語言僅有 32 小時的數據可不夠。因此,他們的模型是基于 wav2vec 2.0 開發的,這是他們之前在自監督語音表征學習上的研究成果,能極大減少訓練所需的有標注數據量。具體來說,研究者使用 1400 多種語言的大約 50 萬小時語音數據訓練了一個自監督模型 —— 這個語言數量已經超過之前任何研究的五倍以上了。然后,基于具體的語音任務(比如多語言語音識別或語言辨識),研究者再對所得模型進行微調。

結果

研究者在一些已有基準上評估了新開發的模型。

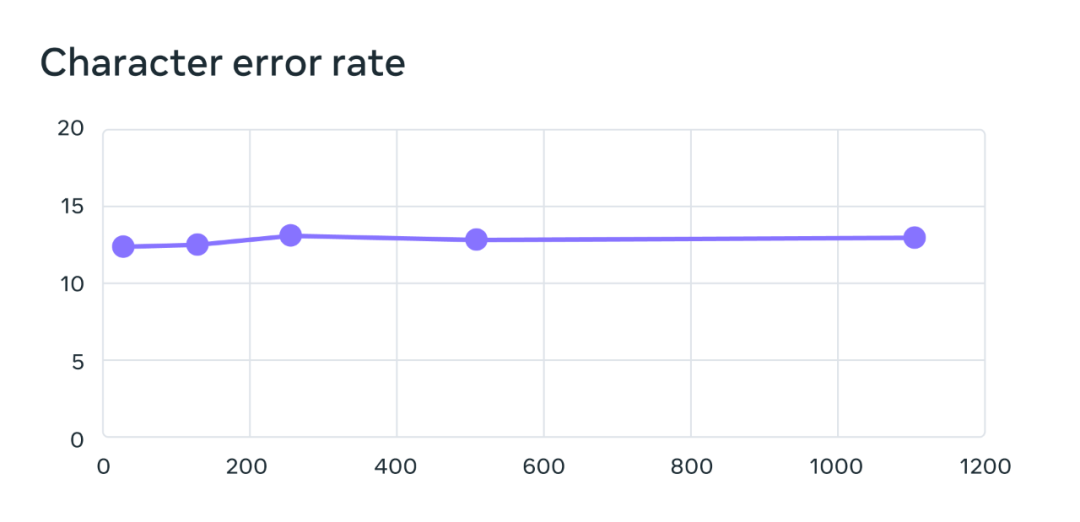

其多語言語音識別模型的訓練使用了含 10 億參數的 wav2vec 2.0 模型,訓練數據集包含 1100 多種語言。隨著語言數量增加,模型性能確實會下降,但下降幅度非常小:當語言數量從 61 種增加到 1107 種時,字符錯誤率僅上升了 0.4%,但語言覆蓋范圍卻增加了 18 倍以上。

在 61 種 FLEURS 語言的基準測試上,隨語言數量增長的字符錯誤率變化情況,錯誤率越高,模型越差。

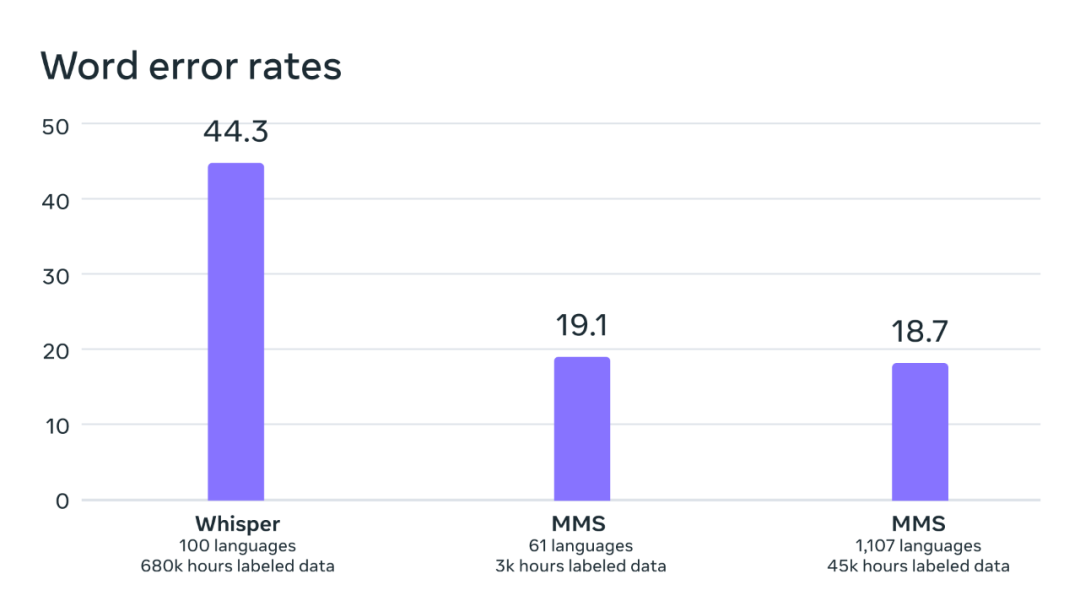

通過對比 OpenAI 的 Whisper 模型,研究者發現他們的模型的詞錯誤率僅有 Whisper 的一半,而同時新模型支持的語言數量還多 11 倍。這個結果足以表明新方法的卓越能力。

在可直接比較的 54 種 FLEURS 語言的基準測試上,OpenAI Whisper 與 MMS 的詞錯誤率對比。

接下來,使用之前已有的數據集(如 FLEURS 和 CommonVoice)和新數據集,Meta 的研究者還訓練了一個語言辨識(LID)模型,并在 FLEURS LID 任務上進行了評估。結果表明,新模型不僅表現很棒,而且支持的語言數量也增加了 40 倍。

之前的研究在 VoxLingua-107 基準上也僅支持 100 多種語言,而 MMS 支持超過 4000 種語言。

另外 Meta 還構建了一個支持 1100 種語言的文本轉語音系統。當前文本轉語音模型的訓練數據通常是來自單個說話人的語音語料。MMS 數據的一個局限性是許多語言都只有少量說話人,甚至往往只有一個說話人。但是,在構建文本轉語音系統時,這卻成了一個優勢,于是 Meta 就順便造了一個支持 1100 多種語言的 TTS 系統。研究者表示,這些系統生成的語音質量其實相當好,下面給出了幾個例子。

約魯巴語、伊洛科語和邁蒂利語的 MMS 文本轉語音模型演示。

盡管如此,研究者表示 AI 技術都仍不完美,MMS 也是如此。舉個例子,MMS 在語音轉文本時可能錯誤轉錄選定的詞或短語。這可能導致輸出結果中出現冒犯性和 / 或不準確的語言。研究者強調了與 AI 社區合作共同進行負責任開發的重要性。

用單個模型支持千言萬語的價值

世界上有許多語言瀕臨滅絕,而當前的語音識別和語音生成技術的局限性只會進一步加速這一趨勢。研究者在博客中設想:也許技術能鼓勵人們留存自己的語言,因為有了好的技術后,他們完全可以使用自己喜歡的語言來獲取信息和使用技術。

他們相信 MMS 項目是朝這個方向邁出的重要一步。他們還表示這個項目還將繼續開發,未來還將支持更多語言,甚至還會解決方言和口音的難題。