只需要十分之一數(shù)據(jù),就能通關(guān)四大視覺任務(wù),居然還開源了!

?Github鏈接:https://github.com/opengvlab

家人們,你們有沒有這種苦惱?

搬一次家就換一次家具,那些又貴又重的家具既不好搬運(yùn),又不好全部帶走。

下一次又重新購(gòu)置一遍家具,浪費(fèi)錢不說,關(guān)鍵是來來回回都做一樣的事情!家具還沒用過幾次,利用率不高呀!

這種搬家的苦惱,就好比AI領(lǐng)域,做幾個(gè)任務(wù)就需要開發(fā)幾個(gè)高度定制的模型,不僅所需的數(shù)據(jù)采集量非常大,每次還都得從頭標(biāo)注。既提不起數(shù)據(jù)的學(xué)習(xí)效率,又耗費(fèi)巨大的數(shù)據(jù)獲取成本。

光是AI前端研究就耗費(fèi)如此巨大的精力,更別提應(yīng)用場(chǎng)景中數(shù)以萬計(jì)的長(zhǎng)尾任務(wù)。

那怎么辦?

做一款通用的深度學(xué)習(xí)模型,才是關(guān)鍵。?

1 通用,才是技術(shù)根本

無論國(guó)內(nèi)外,底層技術(shù)關(guān)注者都以設(shè)計(jì)出“通用模型”為己任。而打造通用模型的兩個(gè)主戰(zhàn)場(chǎng),就是深度學(xué)習(xí)應(yīng)用最廣泛的兩個(gè)方向:語言與視覺。

目前,通用語言模型(GLM)已經(jīng)取得了令人矚目的進(jìn)展,比如BERT、T5和GPT-3,它們?cè)趹?yīng)對(duì)廣泛的語言下游任務(wù)時(shí)已經(jīng)游刃有余。

相形之下,通用視覺模型(GVM)的研究遲遲未交出一份令人滿意的答卷。

以往的大多數(shù) GVM 研究主要利用一種監(jiān)督信號(hào)來源,如 ViT-G/14 采用有標(biāo)簽監(jiān)督,SEER 采用樣本的不同增強(qiáng)之間的對(duì)比學(xué)習(xí),CLIP采用圖片文本對(duì)進(jìn)行監(jiān)督。如果是在單個(gè)監(jiān)督信號(hào)下進(jìn)行的預(yù)訓(xùn)練,這幾種范式確實(shí)能夠生成在固定場(chǎng)景下表現(xiàn)良好的模型。但如果用在場(chǎng)景多元、任務(wù)多樣的下游場(chǎng)景,這些模型就難以勝任了。

比如現(xiàn)在最火的自動(dòng)駕駛,汽車處于移動(dòng)狀態(tài),既要看到路況,又要看到紅綠燈,還要注意行人,甚至在智能座艙興起后,還要和語言技術(shù)、LBS場(chǎng)景服務(wù)協(xié)同,這么多的感知數(shù)據(jù)與協(xié)同任務(wù),這么多隨機(jī)的新任務(wù),無論在體量還是維度方面,都對(duì)視覺模型的要求極大提高。

這時(shí),打造一款通用視覺模型,降低研發(fā)門檻,尤其是學(xué)術(shù)界的時(shí)間成本、資金成本,才能暢享下游的極致場(chǎng)景體驗(yàn)。

去年11月,上海人工智能實(shí)驗(yàn)室聯(lián)合商湯科技、香港中文大學(xué)、上海交通大學(xué)發(fā)布通用視覺技術(shù)體系“書生”(INTERN),一套持續(xù)學(xué)習(xí)框架,用于系統(tǒng)化解決當(dāng)下人工智能視覺領(lǐng)域中存在的任務(wù)通用、場(chǎng)景泛化和數(shù)據(jù)效率等一系列瓶頸問題。

前不久,上海人工智能實(shí)驗(yàn)室聯(lián)合商湯科技發(fā)布通用視覺開源平臺(tái)OpenGVLab,面向?qū)W術(shù)界和產(chǎn)業(yè)界開放其超高效預(yù)訓(xùn)練模型、超大規(guī)模公開數(shù)據(jù)集,以及業(yè)內(nèi)首個(gè)針對(duì)通用視覺模型的評(píng)測(cè)基準(zhǔn)。

這些開源技術(shù),究竟有何魔力?

2 大力出奇跡,打造通用視覺模型

“書生” (INTERN),就是練就通用視覺能力的底層技術(shù)。

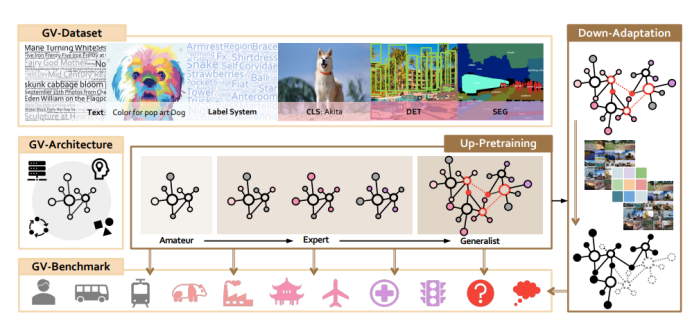

從技術(shù)實(shí)現(xiàn)上講,“書生”技術(shù)體系由由七大模塊組成,包括三個(gè)基礎(chǔ)設(shè)施模塊和四個(gè)訓(xùn)練階段構(gòu)成。

- 三個(gè)基礎(chǔ)設(shè)施模塊分別為通用視覺數(shù)據(jù)系統(tǒng)(GV-D)、通用視覺網(wǎng)絡(luò)結(jié)構(gòu)(GV-A)、以及通用視覺評(píng)測(cè)基準(zhǔn)(GV-B);

- 四個(gè)訓(xùn)練階段分別為:上游基礎(chǔ)模型訓(xùn)練(Amateur)、上游專家模型訓(xùn)練(Expert)、上游通才模型(Generalist)訓(xùn)練;以及下游的應(yīng)用訓(xùn)練(Downstream-Adaptation)。

書生(INTERN)結(jié)構(gòu)圖

首先,通用視覺數(shù)據(jù)系統(tǒng)。

這是一個(gè)超大規(guī)模的精標(biāo)數(shù)據(jù)集,擁有100億個(gè)樣本和各種監(jiān)督信號(hào),并依照四大視覺任務(wù)分別設(shè)置了四個(gè)數(shù)據(jù)子集:多模態(tài)數(shù)據(jù)GV-D- 10B分類標(biāo)注的GV-Dc-36M、檢測(cè)標(biāo)注的GV-Dd-3M、分割標(biāo)注的GV-Ds-143K。

另外,這一數(shù)據(jù)集還包含11.9萬的標(biāo)簽系統(tǒng),不僅涵蓋了自然界的眾多領(lǐng)域和目前計(jì)算機(jī)視覺研究中的幾乎所有標(biāo)簽,還擴(kuò)充了大量細(xì)粒度標(biāo)簽,涵蓋各類圖像中的屬性、狀態(tài)等。

而這,就是書生“大力出奇跡”的一大注腳。

其次,通用視覺模型結(jié)構(gòu)。

它是由一個(gè)具有CNN和Transformer的統(tǒng)一搜索空間構(gòu)建而成。

為何要建立這樣的混合結(jié)構(gòu)?要知道,多年來,卷積神經(jīng)網(wǎng)絡(luò)(CNN)一直主導(dǎo)著視覺表征學(xué)習(xí),并在圖像分類、目標(biāo)檢測(cè)和語義分割等下游任務(wù)中表現(xiàn)出穩(wěn)定的可遷移性。但最近幾年,Vision Transformer (ViT)僅使用普通的Transformer結(jié)構(gòu)就能作為圖像編碼模型在ImageNet-1k上取得媲美 CNN 的性能,在大規(guī)模數(shù)據(jù)集上 ViT 更是展示出比 CNN 更大的潛力。

盡管ViT在性能上有優(yōu)點(diǎn),但純Transformer網(wǎng)絡(luò)相比卷積神經(jīng)網(wǎng)絡(luò)缺乏某些歸納偏置(inductive biases),因此需要更多的數(shù)據(jù)和計(jì)算資源。此外,自注意的計(jì)算成本相對(duì)于輸入的數(shù)量是平方的,限制了對(duì)高輸入分辨率的應(yīng)用。因此,將CNN和Transformer和MLP結(jié)合起來,平衡效率和有效性兩個(gè)方面,才是模型通用的關(guān)鍵。

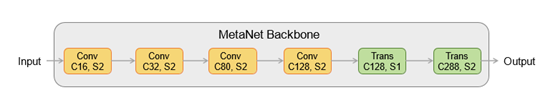

這種兼具更好的泛化能力和更高的模型容量的模型結(jié)構(gòu)名為MetaNet。在MetaNet網(wǎng)絡(luò)結(jié)構(gòu)族里面進(jìn)行網(wǎng)絡(luò)結(jié)構(gòu)搜索,從而得到最優(yōu)的一個(gè)模型訓(xùn)練結(jié)構(gòu)。

統(tǒng)一搜索的MetaNet架構(gòu):Conv和Trans分別表示卷積和Transformer。C和S為每一階輸出通道數(shù)和步幅。

具體來看,MetaNet不僅基于強(qiáng)化學(xué)習(xí) 的PPO算法提出了統(tǒng)一搜索架構(gòu),并且,為了避免傳統(tǒng)的下采樣模塊會(huì)成為模型性能的瓶頸,“書生“結(jié)合了包含 local-global-DSM (LG_DSM) 和 global-DSM (G-DSM)的context-aware down-sampling modules (DSM),用來代替原本的下采樣模塊。

因此,在淺層,模型依然使用卷積來提取特征,但在深層,模型卻能將Transformer模塊和LG-DSM結(jié)合使用,以便于更好地提取全局信息。

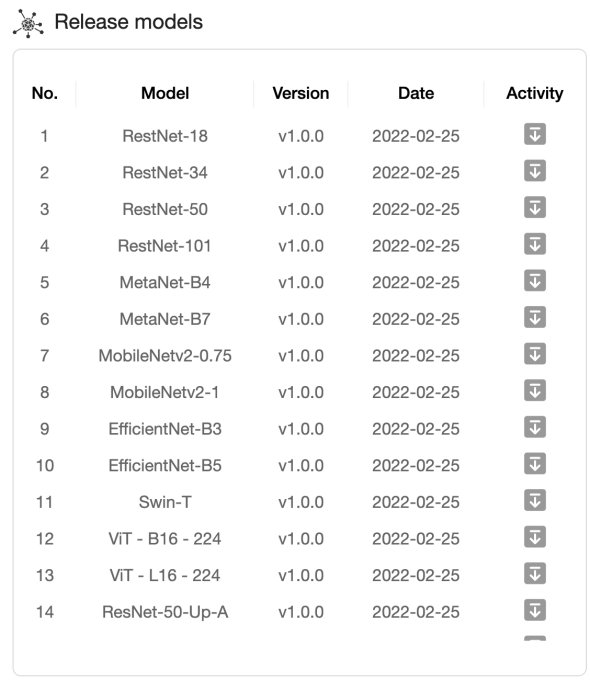

同時(shí),書生還基于最大的MetaNet-B15蒸餾出了多達(dá)13種不同的模型結(jié)構(gòu),共24種不同的模型權(quán)重,現(xiàn)已全部開源。

這些模型結(jié)構(gòu)基本涵蓋了現(xiàn)有市面上大部分的主流backbone,不僅能夠很輕易地遷移到所需要的算法框架作為新網(wǎng)絡(luò)預(yù)訓(xùn)練的初始化,而且只需要更短的訓(xùn)練時(shí)間就可以達(dá)到比原來更好的訓(xùn)練效果。

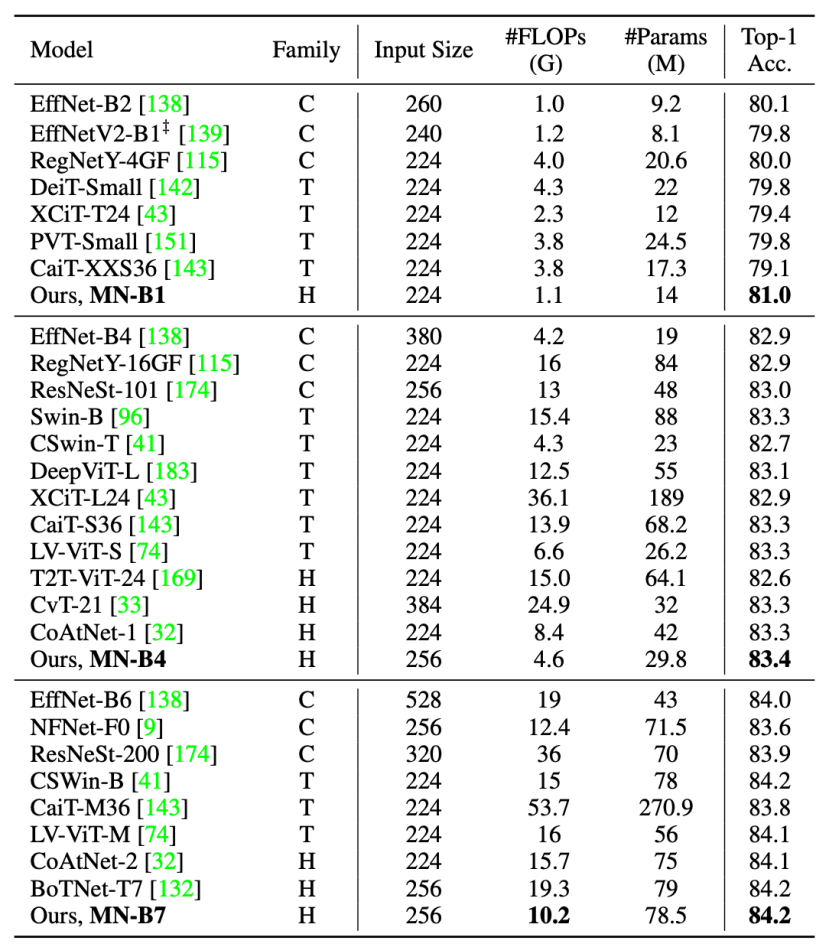

MetaNet 模型與其他模型結(jié)構(gòu)比較,結(jié)果如下:

基于卷積、Transformer和兩者混合的結(jié)構(gòu),分別用C,T和H表示

可以看出,在圖像分類性能上,MetaNet系列的MN-B1,MN-B4和MN-B7,和其他的SOTA模型相比,不僅有更高的精度,還有更低的FLOPS和參數(shù)量。

除了分類任務(wù),把MetaNet做為檢測(cè)和分割的backbone,在COCO數(shù)據(jù)集上使用Mask R-CNN結(jié)構(gòu)訓(xùn)練,結(jié)果發(fā)現(xiàn):

在模型參數(shù)量更小的前提下,MN-B4比Swin-T精度高出2到4個(gè)點(diǎn)。另外還在ADE20K數(shù)據(jù)集上進(jìn)行了語義分割任務(wù),MN-B4的mIoU指標(biāo)比Swin-T高出5個(gè)點(diǎn)之多。

上述兩個(gè)實(shí)驗(yàn)結(jié)果表明,MetaNet系列模型結(jié)構(gòu),在模型精度與計(jì)算量之間,都達(dá)到了新的SOTA!

最后,通用視覺評(píng)測(cè)基準(zhǔn)。

視覺評(píng)測(cè)基準(zhǔn)GV-B ,就像是一個(gè)「擂臺(tái)」。

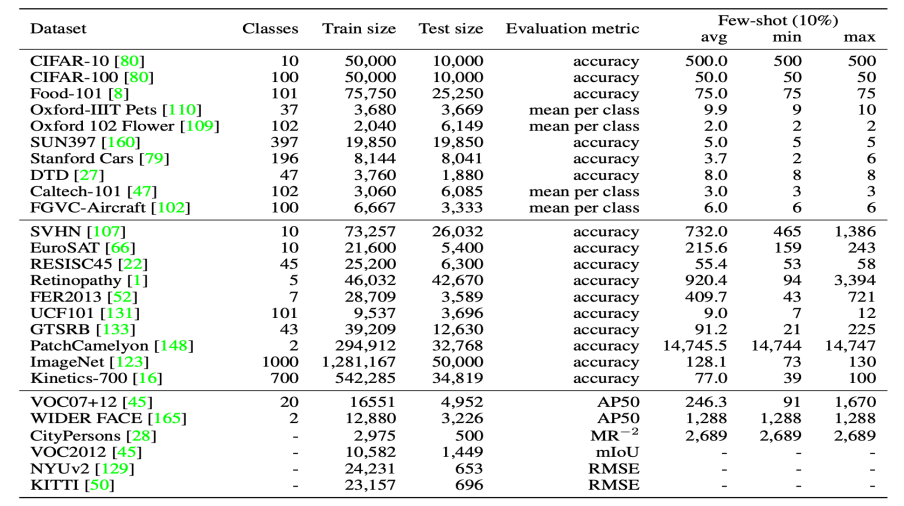

如下表所示,測(cè)評(píng)基準(zhǔn)收集了 26 個(gè)下游任務(wù)數(shù)據(jù)集,囊括了 4 種視覺任務(wù)類型:分類,檢測(cè),分割和深度估計(jì)。

在設(shè)置上,該基準(zhǔn)引入了百分比樣本(percentage-shot),只需要選取整個(gè)數(shù)據(jù)集的一部分,例如 10%、20% ,對(duì)比縮小下游任務(wù)的訓(xùn)練數(shù)據(jù)量后的模型性能。

與傳統(tǒng)的少樣本設(shè)置相比,這種百分比樣本設(shè)置可以很好地保留原始數(shù)據(jù)集的長(zhǎng)尾分布等屬性,并減輕對(duì)樣本選擇的敏感性。因?yàn)橛幸恍?shù)據(jù)集樣本類別分布不平衡,比如下表中的VOC07+12,百分比數(shù)據(jù)的劃分方式卻會(huì)繼承這種分布情況。

右側(cè)三列avg,min和max,分別表示在10%的數(shù)據(jù)中,不同類別樣本數(shù)量的平均值,最小值和最大值

結(jié)合上述數(shù)據(jù)集和任務(wù)類型,論文選取了一些具有代表性的模型來做評(píng)測(cè)對(duì)比。為了比較公平性,該對(duì)比使用了這些模型的官方預(yù)訓(xùn)練權(quán)重。這些模型包括:

- RseNet

- CLIP

- ResNeXt

- BiT

- ViT

- SwAV, DeepClusterV2和MoCo v2

- Detco

有了超大精標(biāo)數(shù)據(jù)集、模型結(jié)構(gòu),以及評(píng)測(cè)基準(zhǔn)后,已經(jīng)是萬事俱備,只欠訓(xùn)練。

書生作為中國(guó)古代讀書人的經(jīng)典形象,代表著一個(gè)通過不斷學(xué)習(xí)、不斷成長(zhǎng)進(jìn)而擁有各方面才能的人格化角色:從基礎(chǔ)的知識(shí)技能學(xué)習(xí)開始,到對(duì)多種專業(yè)知識(shí)觸類旁通,進(jìn)而成長(zhǎng)為擁有通用知識(shí)的通才。借此意象,“書生”(INTERN)系統(tǒng)可通過持續(xù)學(xué)習(xí),舉一反三,逐步實(shí)現(xiàn)通用視覺領(lǐng)域的融會(huì)貫通,最終實(shí)現(xiàn)靈活高效的模型部署。

下面就來看看,這套系統(tǒng)是如何通過訓(xùn)練,一步步從生手變成專家再到多面手,最終在各種任務(wù)中大顯身手。

第一階段,訓(xùn)練的是基礎(chǔ)能力,被稱為“基礎(chǔ)模型”(Amateur)。

近年來,CLIP因zero-shot recognition 能力和在下游任務(wù)的遷移能力而備受關(guān)注。

然而CLIP需要400M的圖像-文本對(duì)進(jìn)行前訓(xùn)練,囿于極大的數(shù)據(jù)量,CLIP很難進(jìn)一步發(fā)展。但“書生”提出了一種新的訓(xùn)練范式,DeCLIP(Data efficient CLIP ),能夠同時(shí)使用來自圖像-文本、圖像-圖像和文本-文本對(duì)的監(jiān)督信號(hào)進(jìn)行模型預(yù)訓(xùn)練,從而更有效地實(shí)現(xiàn)通用性。

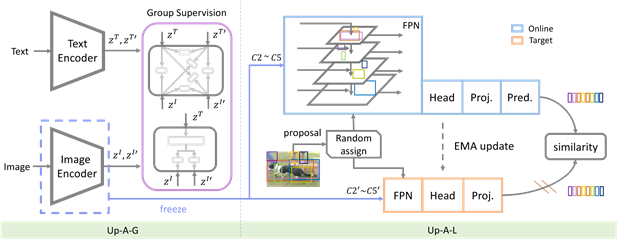

此外,為了充分利用大規(guī)模多模態(tài)數(shù)據(jù)獲取基礎(chǔ)模型的優(yōu)勢(shì),這一階段提出了Upstream-Amateur (Up-A)視覺語言預(yù)訓(xùn)練框架,同時(shí)挖掘模態(tài)內(nèi)和跨模態(tài)知識(shí)。

這一訓(xùn)練框架分為兩個(gè)預(yù)訓(xùn)練階段:Upstream-Amateur for Global Representation (Up-A-G)和Upstream-Amateur for Local Representation (Up-A-L)。

其中,Up-A-G(左)使用群體監(jiān)督功能,從更豐富的監(jiān)督中學(xué)習(xí)。Up-A-L(右)采用局部自我監(jiān)督學(xué)習(xí)方法,對(duì)訓(xùn)練好的視覺-語言模型進(jìn)行調(diào)整,從而提高自身在密集預(yù)測(cè)CV任務(wù)中的表現(xiàn)。

Upstream-Amateur的框架

得益于這些內(nèi)在的監(jiān)督,DeCLIP-ResNet50可以在ImageNet上實(shí)現(xiàn)60.4%的zero-shot 精度第一。這比CLIP-ResNet50高出0.8%,數(shù)據(jù)使用量少了81%。當(dāng)遷移到下游任務(wù)時(shí),DeCLIP-ResNet50在11個(gè)視覺數(shù)據(jù)集中有8個(gè)優(yōu)于CLIP。

更關(guān)鍵的是,訓(xùn)練完成的Upstream-Amateur為后續(xù)的訓(xùn)練階段提供了一個(gè)很高的起點(diǎn)。

第二階段,訓(xùn)練的是專業(yè)能力,被稱為“專家模型”(Expert)。

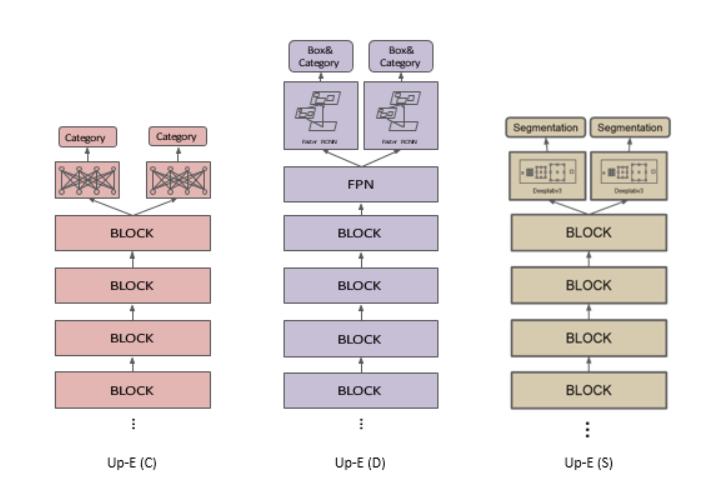

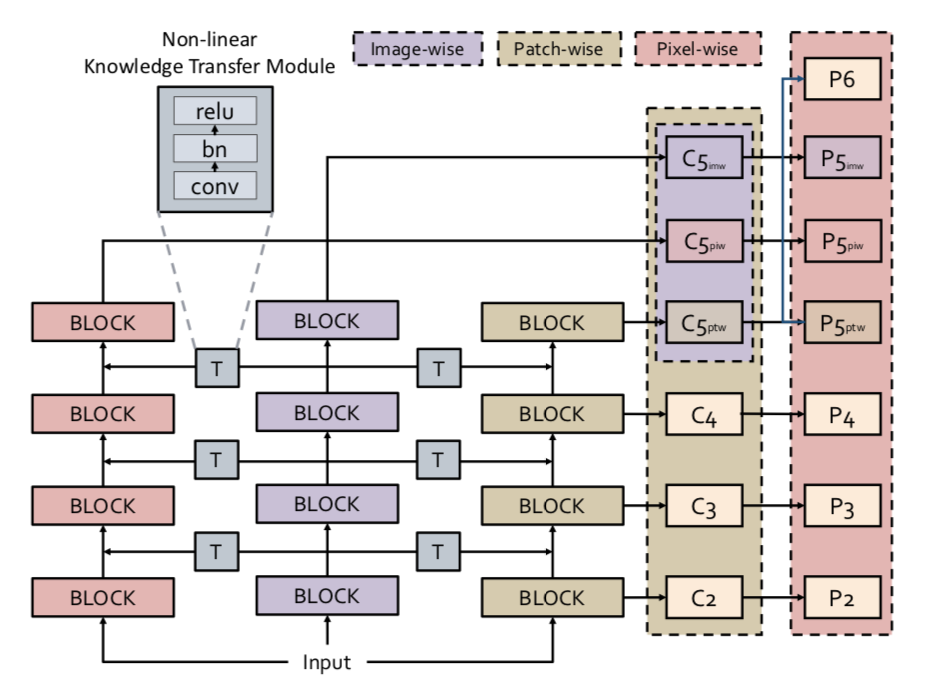

Up-A階段得到的基礎(chǔ)模型,在一般的視覺識(shí)別問題上顯示出優(yōu)異的性能。但要完全掌握檢測(cè)、分割等更具體的任務(wù),還需要在每個(gè)任務(wù)中進(jìn)行更專業(yè)的預(yù)訓(xùn)練,這就促成了第二個(gè)階段的到來,專家模型。

對(duì)于每個(gè)專家,“書生”采用了一種簡(jiǎn)單的多頭設(shè)計(jì),每個(gè)頭是一個(gè)特定數(shù)據(jù)集的子網(wǎng)絡(luò),從一個(gè)公共的、共享的“主干”分支出來。比如Up-E (C)、Up-E (D)和Up-E (S),分別用于圖像分類、對(duì)象檢測(cè)和語義分割。

第三階段,訓(xùn)練的是組合能力,被稱為“通才模型”(Generalist)。

上述的多任務(wù)是指不同數(shù)據(jù)集(如ImageNet和CIFAR)的一個(gè)視覺問題(如分類),或一個(gè)數(shù)據(jù)集的多個(gè)視覺問題(如分類和檢測(cè))。但關(guān)鍵是,如何將專家整合到一個(gè)統(tǒng)一的模型中,獲得一個(gè)更加通用的視覺模型。因此,在預(yù)訓(xùn)練“專家”階段之后,又將“通才”作為第三個(gè)預(yù)訓(xùn)練階段,以進(jìn)一步統(tǒng)一特征表示。

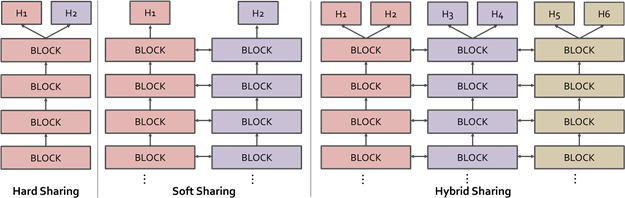

“書生”提出了一個(gè)新的范式,名為“混合參數(shù)共享”,從而開發(fā)一個(gè)名為“多面手”的通才模型。

具體來說,由于專家捕獲的知識(shí)是相互關(guān)聯(lián)的,當(dāng)專家的特征融合為一個(gè)共享的表示形式時(shí),再利用基于軟共享的跨任務(wù)知識(shí)轉(zhuǎn)移和基于硬共享的通用表示學(xué)習(xí)的方法,在不引入任務(wù)沖突的情況下在專家之間傳遞信息(特征轉(zhuǎn)移),從而進(jìn)一步提高了多任務(wù)訓(xùn)練的模型(專家)性能,即“通才”能力。

在結(jié)構(gòu)上,通才模型是所有專家的一個(gè)相互關(guān)聯(lián)的版本,因此可以把每個(gè)“專家主干”稱為“通才分支”。此外,我們還可以根據(jù)訓(xùn)練相應(yīng)專家的任務(wù)將通才中的每個(gè)分支分為圖像、補(bǔ)丁和像素。但無論是軟共享還是硬共享,都意味著從專家模型到通才模型的一次躍升。

在經(jīng)歷了前三個(gè)訓(xùn)練階段模塊后,終于來到最后的任務(wù)遷移階段 (Adaptation)。

這個(gè)階段屬于技術(shù)鏈條的下游,用來解決各式各樣不同類型的任務(wù),而這也是最考驗(yàn)“書生”舉一反三能力的時(shí)刻。它需要在這個(gè)階段把之前學(xué)到的通用知識(shí),融會(huì)貫通地應(yīng)用到不同特定任務(wù)中。

在此之前,很多遷移學(xué)習(xí)方法確實(shí)取得了很多進(jìn)步,但問題是,這些方法既沒有利用上游預(yù)訓(xùn)練中的隱含信息,也沒有考慮到下游數(shù)據(jù)在少鏡頭場(chǎng)景中的不足。

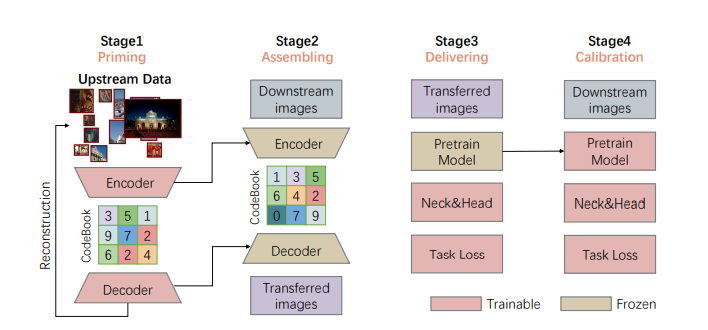

因此,“書生”提出了一種Multi-stage Fine-tuning (MF)方法,緩解在數(shù)據(jù)較少的情況下傳輸?shù)睦щy,再通過將上游數(shù)據(jù)編碼成生成模型,即VQ-GAN,可以將預(yù)訓(xùn)練的模型轉(zhuǎn)移到多個(gè)任務(wù)和領(lǐng)域,而無需每次都使用上游數(shù)據(jù),而這也使得“書生”更具通用性和可擴(kuò)展性。

多級(jí)微調(diào)(MF)概述:VQ-GAN模型首先在第一階段使用上游數(shù)據(jù)進(jìn)行訓(xùn)練,然后在第二階段由它重構(gòu)下游數(shù)據(jù)。在此之后,第三階段只對(duì)新增任務(wù)的特定參數(shù)進(jìn)行重新表示的圖像訓(xùn)練,第四階段則通過下游數(shù)據(jù)對(duì)整個(gè)模型進(jìn)行微調(diào)。

至此,一個(gè)具有持續(xù)學(xué)習(xí)能力的通用視覺模型終于出世。

而具體有哪些提升,不如看一下更直觀的實(shí)驗(yàn)數(shù)據(jù)對(duì)比!

3 一網(wǎng)打盡視覺領(lǐng)域四大任務(wù)

視覺領(lǐng)域,任務(wù)繁多,主流任務(wù)包含分類、目標(biāo)檢測(cè)、語義分割、深度估計(jì)四大類型。

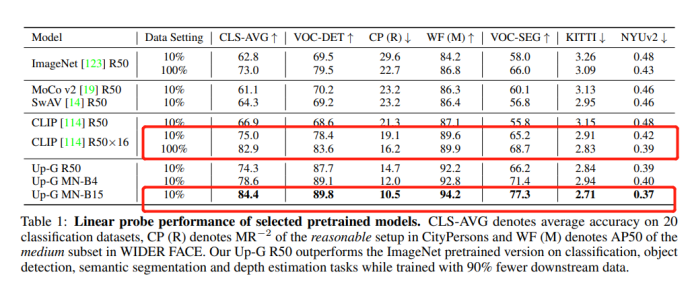

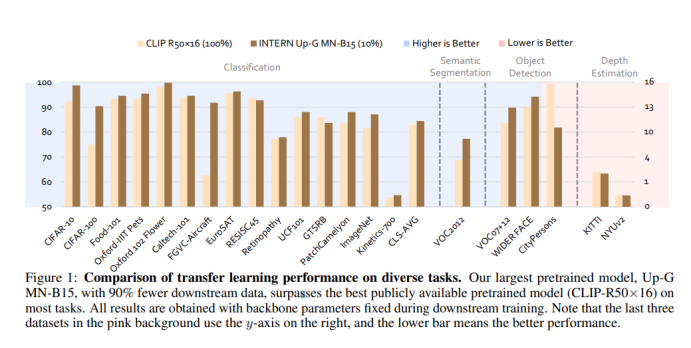

在這四大任務(wù)中,最強(qiáng)大的視覺模型還是去年OpenAI發(fā)布的CLIP模型。但相比較而言,“書生”則在準(zhǔn)確率和數(shù)據(jù)使用效率上都有所提升。

(1)精度表現(xiàn)

通過對(duì)“書生”訓(xùn)練出的模型在GV-B上的評(píng)測(cè)對(duì)比,發(fā)現(xiàn)經(jīng)過多階段預(yù)訓(xùn)練的MetaNet精度表現(xiàn)優(yōu)異。

在ImageNet等26個(gè)最具代表性的下游場(chǎng)景中, “書生”在分類、目標(biāo)檢測(cè)、語義分割及深度估計(jì)等四大任務(wù)上,平均錯(cuò)誤率分別降低了40.2%、47.3%、34.8%和9.4%。

書生(INTERN)與CLIP-R50x16在不同樣本量上的性能對(duì)比,正確率展示

(2)數(shù)據(jù)使用效率

“書生”在數(shù)據(jù)效率方面的提升尤為矚目:只需要1/10的下游數(shù)據(jù),就能超過CLIP基于完整下游數(shù)據(jù)訓(xùn)練的準(zhǔn)確度。

以CLIP-R50x16和Up-G MN-B15在GV-B的評(píng)測(cè)對(duì)比為例,分別在分類、目標(biāo)檢測(cè)、語義分割、深度估計(jì)四大類型的26個(gè)下游任務(wù)數(shù)據(jù)集上進(jìn)行了評(píng)測(cè),僅使用了10%數(shù)據(jù)進(jìn)行訓(xùn)練的Up-G MN-B15模型,在絕大部分?jǐn)?shù)據(jù)集上都能比使用了全部訓(xùn)練數(shù)據(jù)的CLIP-R50有更好的精度表現(xiàn)。這表明,經(jīng)過多階段預(yù)訓(xùn)練的MetaNet具有極強(qiáng)的泛化能力,能夠在僅有少量的訓(xùn)練樣本情況下,達(dá)到SOTA的精度表現(xiàn)。

在下游視覺場(chǎng)景中,小樣本訓(xùn)練帶來的是極高的訓(xùn)練速度,以及極低的訓(xùn)練成本。

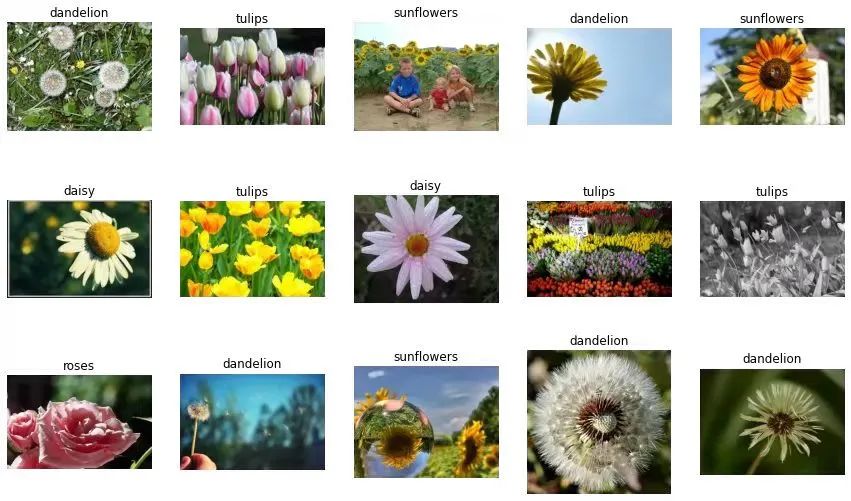

例如在花卉種類識(shí)別任務(wù)上,“書生“只需要每一類型的花卉提供兩個(gè)訓(xùn)練樣本,就能實(shí)現(xiàn)99.7%的準(zhǔn)確率。

這個(gè)花卉數(shù)據(jù)集由102種英國(guó)常見的花組成,每個(gè)類別有40至258張圖片。其中包含有很大的比例、姿勢(shì)和光線變化。

102個(gè)類別的花卉數(shù)據(jù)集:https://www.robots.ox.ac.uk/~vgg/data/flowers/102/index.html

4 通用視覺平臺(tái),已正式開源

如此強(qiáng)大的通用視覺訓(xùn)練模型已經(jīng)正式開源!

更關(guān)鍵的是,連同上述講到的標(biāo)簽數(shù)據(jù)集、網(wǎng)絡(luò)結(jié)構(gòu)以及評(píng)測(cè)基準(zhǔn),均在OpenGVLab被統(tǒng)一打包開源。

其中的網(wǎng)絡(luò)結(jié)構(gòu)除了MetaNet,還包含大家普遍使用的ResNet, MobileNet, ViT, EfficientNet等,以滿足不同場(chǎng)景的應(yīng)用,賦能計(jì)算機(jī)視覺。

然而,「書生」的布局不止于此。

OpenGVLab將與上海人工智能實(shí)驗(yàn)室此前發(fā)布的OpenMMLab、OpenDILab一道,共同構(gòu)筑開源體系OpenXLab,持續(xù)推進(jìn)通用人工智能的技術(shù)突破和生態(tài)構(gòu)建。

一位已經(jīng)使用過此次開源平臺(tái)的自動(dòng)駕駛算法研究員表示:“書生系列模型充分覆蓋了從移動(dòng)可部署的小模型,到超大規(guī)模自研結(jié)構(gòu),為行業(yè)帶來了希望,尤其是它的收斂速度,大幅節(jié)省了訓(xùn)練開銷,是技術(shù)落地的一大助推器。“

不僅是自動(dòng)駕駛領(lǐng)域,智慧城市、智慧醫(yī)療、智慧交通,以及千千萬萬其他的智能化領(lǐng)域,都將獲得通用視覺模型帶來的技術(shù)紅利。

一位騰訊研究員大贊OpenGVLab:“能把這么大的工作開源出來真的是業(yè)界良心。簡(jiǎn)單用了一下,確實(shí)比CLIP要更fine-grained(細(xì)粒度更高)。”

而來自學(xué)界的師生也對(duì)此感慨有加:“OpenGVLab集成了大量各種量級(jí)的state-of-the-art(先進(jìn))模型,使用起來更得心應(yīng)手,省去了對(duì)不同codebase、不同模型繁瑣調(diào)研的煩惱。”

換句話說,當(dāng)那些代碼和公式脫去了枯燥乏味的外衣,人們才發(fā)現(xiàn)了真正的創(chuàng)造力。而這,也是技術(shù)創(chuàng)新與平臺(tái)開源的魅力所在。

往近了說,用這款通用視覺模型打比賽,怕不是獎(jiǎng)金多到飛起!在技術(shù)生產(chǎn)力的道路上,又誕生了一個(gè)致富小妙招!

目前,“書生”技術(shù)報(bào)告《INTERN: A New Learning Paradigm Towards General Vision》已在arXiv平臺(tái)發(fā)布。

論文地址:arxiv.org/abs/2111.08687?