ChatGPT發(fā)布一周年了,開源大模型都迎頭趕上了嗎?

一年前的今天,ChatGPT 橫空出世,人工智能的新時(shí)代似乎已經(jīng)到來。短短兩個(gè)月,ChatGPT 積累了一億用戶,速度遠(yuǎn)超 TikTok 和 YouTube 等熱門應(yīng)用;似乎每隔幾天就會(huì)有新的基于生成式人工智能的創(chuàng)業(yè)公司出現(xiàn);以 ChatGPT 和 GPT-4 為核心的智能助手也開始走進(jìn)各個(gè)行業(yè)中,幫助普通用戶簡化工作流程和提高效率。

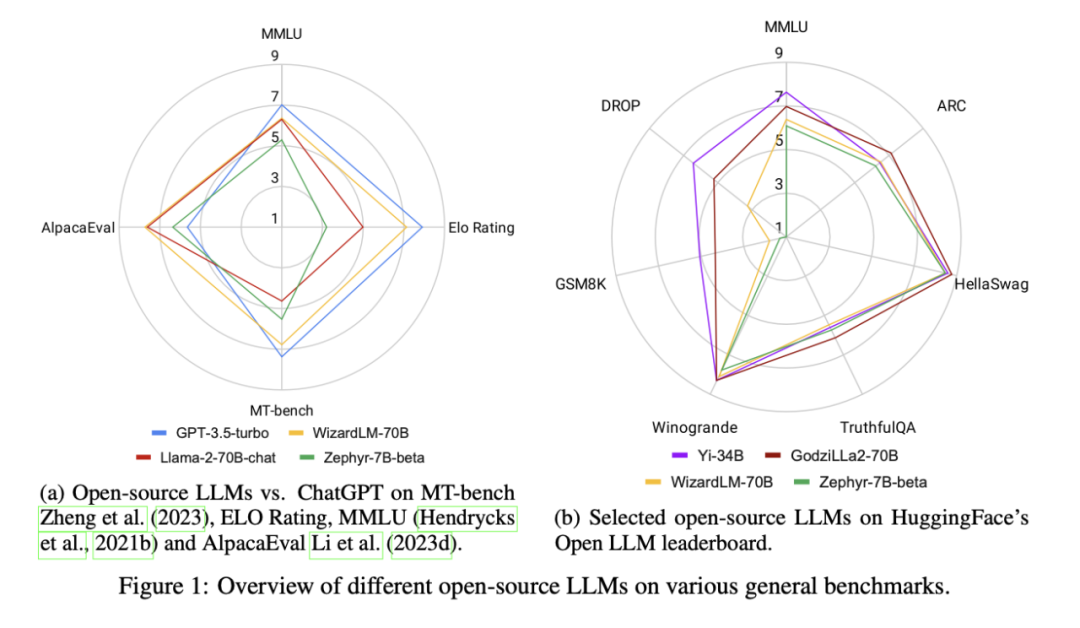

但眾所周知,ChatGPT 并未開源,不僅技術(shù)細(xì)節(jié)未知,部分國家和地區(qū)也不在 OpenAI 的服務(wù)范圍之內(nèi)。這種封閉性帶來了一系列問題:如服務(wù)的穩(wěn)定度,高昂的 API 成本,數(shù)據(jù)所有權(quán)和隱私問題等。因此,與閉源模型相比,開源社區(qū)的力量備受期待。雖然,許多基礎(chǔ)模型在發(fā)布之初仍然無法接近 ChatGPT 的性能,但隨著大量技術(shù)上的研究和探索,已經(jīng)有部分開源大模型或小型專有模型迎頭趕上。如圖一中所示,在部分任務(wù)上,最好的開源大模型已經(jīng)表現(xiàn)得比 ChatGPT 更好。

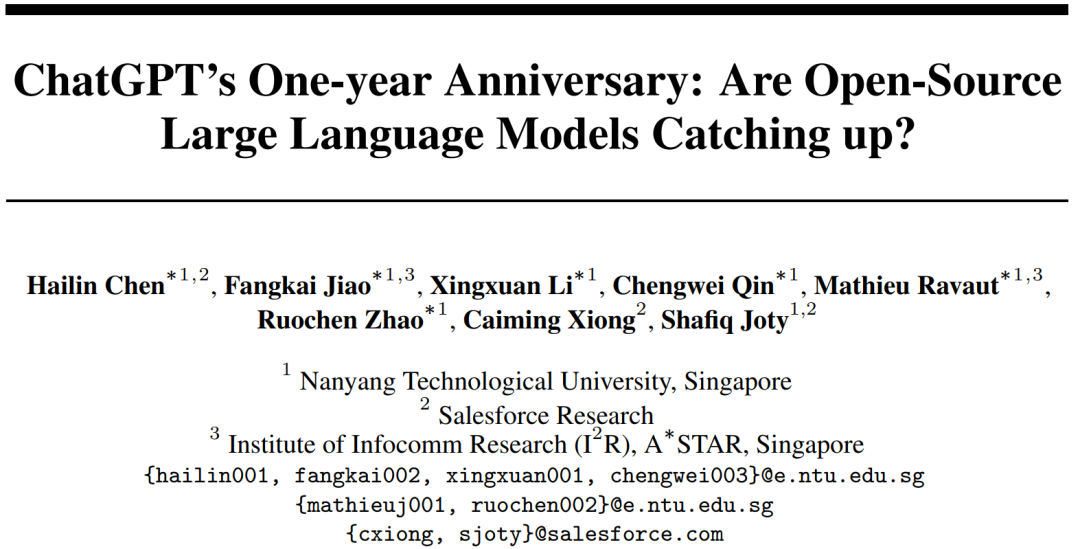

本周,來自南洋理工大學(xué),Salesforce Research,以及新加坡科技研究局等機(jī)構(gòu)的研究者們推出了一篇總結(jié)性的論文,調(diào)研了在各個(gè)領(lǐng)域與任務(wù)中與 ChatGPT 表現(xiàn)相當(dāng)甚至優(yōu)于其的開源大模型。論文旨在成為研究界和商業(yè)領(lǐng)域的重要資源,幫助他們了解開源大模型的當(dāng)前格局和未來潛力。

- 論文鏈接:https://arxiv.org/pdf/2311.16989.pdf

- 陳海林 *,焦方鍇 *,李星漩 *,秦成偉 *, Mathieu Ravaut *, 趙若辰 *,Caiming Xiong, Shafiq Joty (* 為共同一作)

- 數(shù)據(jù)代碼:https://github.com/ntunlp/OpenSource-LLMs-better-than-OpenAI/tree/main

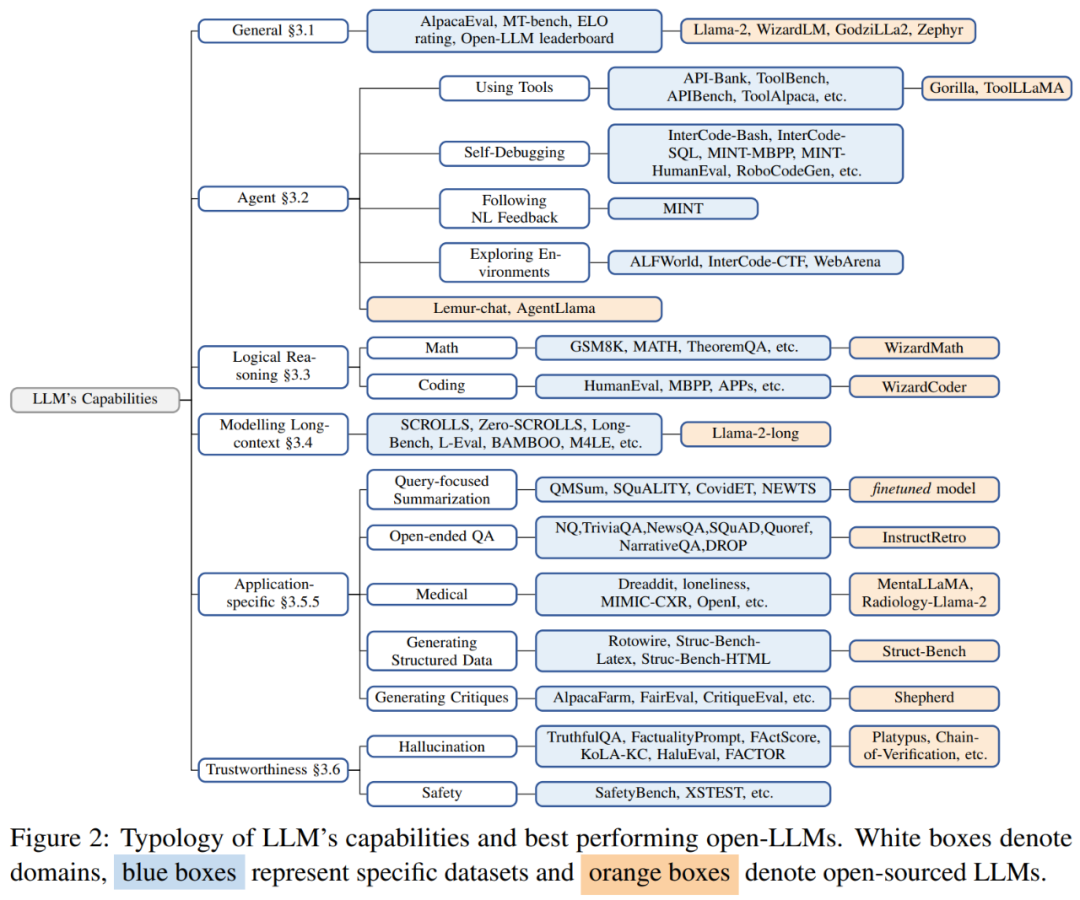

I. 綜合能力

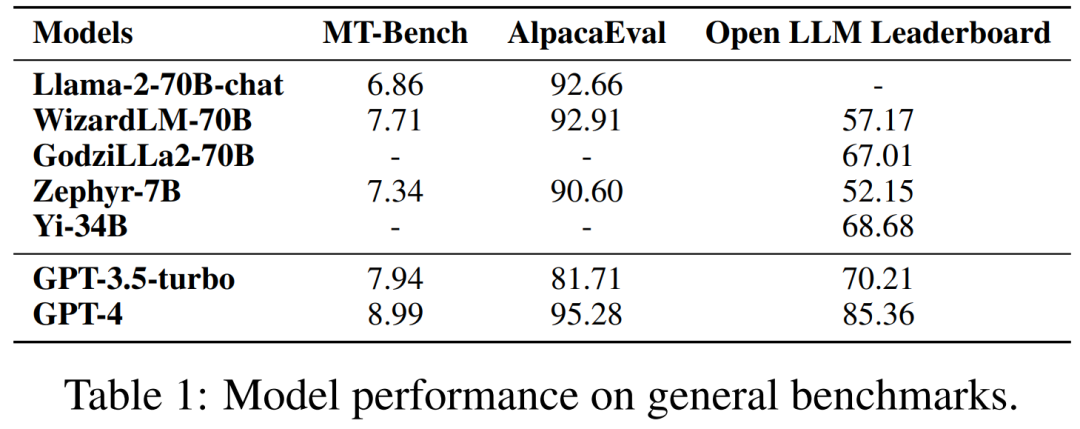

Llama-2-70B 是開源社區(qū)最核心及衍生模型最多的 LLM,其預(yù)訓(xùn)練過程使用了包含兩萬億 Token 的大規(guī)模語料。Llama-2-70B 作為基礎(chǔ)模型已經(jīng)在綜合性基準(zhǔn)測試上展示出了極為優(yōu)秀的性能。而經(jīng)過了指令微調(diào)和對(duì)齊的 Llama-70b-chat-70B 則在通用對(duì)話任務(wù)中表現(xiàn)出進(jìn)一步的性能提升,并能在 AlpacaEval(測試指令跟隨能力的數(shù)據(jù)集)上取得 92.66% 的勝率,領(lǐng)先 ChatGPT 10.95% 的絕對(duì)性能。此外,GPT-4 仍是所有 LLM 中的佼佼者,勝率答到了 95.28%。

Zephyr-7B 是由 Huggingface 團(tuán)隊(duì)訓(xùn)練的小型語言模型。與 ChatGPT 或者 Llama-2 不同,它使用 Direct Preference Optiomization(DPO,直接偏好優(yōu)化)完成對(duì)齊。在 AlpacaEval 上,Zephyr-7B 取得了 90.6% 的勝率,與 70B 級(jí)別的 LLM 表現(xiàn)相當(dāng),同樣也勝過了 ChatGPT。在 MT-Bench(測試多輪對(duì)話和指令跟隨能力的數(shù)據(jù)集)上,Zephyr-7B 的性能甚至超過了 Llama-2-chat-70B。

WizardLM-70B 利用自動(dòng)化構(gòu)造的大量復(fù)雜程度不同的指令數(shù)據(jù)進(jìn)行微調(diào),成為 MT-Bench 上得分最高的開源 LLM,得分為 7.71。它同樣在 AlpacaEval 上超過了 ChatGPT。

GodziLLa2-70B 把多種專有 LoRA 和 Guanaco Llama 2 1K 數(shù)據(jù)集與 Llama-2-70B 相結(jié)合,在 Open LLM Leaderboard(結(jié)合了多個(gè)推理和問答任務(wù)的數(shù)據(jù)集)的表現(xiàn)與 ChatGPT 相當(dāng)。然而,WizardLM-70B 和 GodziLLa-70B 仍然明顯落后于 GPT-4。

UltraLlama 使用了更多樣和質(zhì)量更高的數(shù)據(jù)進(jìn)行微調(diào)訓(xùn)練,在其提出的基準(zhǔn)測試上(未在上圖表中展示)與 ChatGPT 的表現(xiàn)持平,并在回答需要結(jié)合專業(yè)知識(shí)的問題上超過了 ChatGPT 的表現(xiàn)。

II. 具體任務(wù)上超越 ChatGPT 的開源大模型

1.AI 智能體(Agent)

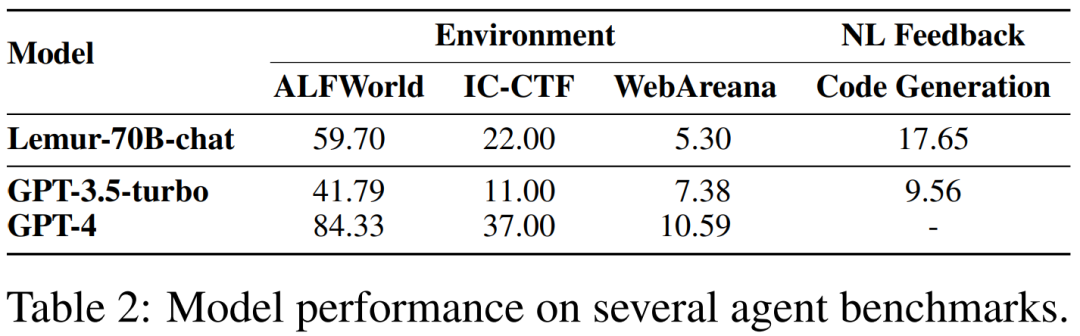

Lemur-70B-chat 團(tuán)隊(duì)探索了訓(xùn)練數(shù)據(jù)中代碼和文本更優(yōu)的配比。通過在包含 90B Token 和 300K 示例的代碼 - 文本混合語料上進(jìn)行訓(xùn)練和指令微調(diào),Lemur-70B-chat 在能夠接收來自環(huán)境以及編碼任務(wù)的自然語言反饋以完成目標(biāo)的設(shè)置下,超越了 ChatGPT 的表現(xiàn)。AgentTuning 結(jié)合自行構(gòu)建的 AgentInstruct 數(shù)據(jù)集和通用領(lǐng)域指令數(shù)據(jù)在 Llama-2 上進(jìn)行指令微調(diào)。值得注意的是,AgentLlama-70B 在未見過的智能體任務(wù)上達(dá)到了與 ChatGPT 持平的表現(xiàn)。

通過在 ToolBench 上對(duì) Llama-2-7B 進(jìn)行微調(diào),ToolLLaMA 在工具使用評(píng)估中展現(xiàn)出與 ChatGPT 相當(dāng)?shù)谋憩F(xiàn)。

FireAct 通過對(duì) Llama-2-13B 進(jìn)行微調(diào),在 HotpotQA 上勝過基于 ReAct 模式的提示式 ChatGPT。

此外,從 Llama-7B 微調(diào)而來的 Gorilla 在編寫 API 調(diào)用方面優(yōu)于 GPT-4。

2. 邏輯推理

WizardCoder 和 WizardMatch 基于 WizardLM,在知識(shí)的寬度和廣度上對(duì)微調(diào)使用的指令數(shù)據(jù)集進(jìn)行了拓展。實(shí)驗(yàn)表明,WizardCoder 在 HumanEval 上比 ChatGPT 表現(xiàn)更好,提升了 19.1%。而 WizardMath 在 GSM8K 上與 ChatGPT 相比也取得了了 42.9% 的提升。

除了在智能體相關(guān)的任務(wù)上表現(xiàn)出色,Lemur 在編程與求解數(shù)學(xué)題等考察邏輯的任務(wù)上性能也得到了顯著提升。同時(shí),Lemur-70B 在不經(jīng)過特定任務(wù)微調(diào)的情況下,在 HumanEval 和 GSM8K 上的表現(xiàn)顯著優(yōu)于 ChatGPT。此外,Phi 使用高質(zhì)量教科書語料作為主要數(shù)據(jù)進(jìn)行預(yù)訓(xùn)練,使得較小的語言模型也可以擁有強(qiáng)大的能力。從結(jié)果上看,參數(shù)量僅為 1.3B 的 Phi-1 相比 ChatGPT 在 HumanEval 上取得了約 3% 的性能提升。

3. 長文本能力建模

Llama-2-long 使用 16k 上下文窗口對(duì) Llama-2 進(jìn)行持續(xù)訓(xùn)練。其中 Llama-2-long-chat-70B 在 ZeroSCROLLS 上的表現(xiàn)為 37.7,優(yōu)于 ChatGPT-16k 的 36.7。處理長文本任務(wù)的方法通常為兩種:(1)采用位置插值擴(kuò)展上下文窗口,這涉及對(duì)更長上下文窗口進(jìn)行另一輪微調(diào);(2)檢索增強(qiáng),需要訪問檢索器以查找相關(guān)信息。通過結(jié)合這兩種看似相反的技術(shù),Llama2-70B-32k-ret [1] 在 7 個(gè)長文本任務(wù)(包括來自 ZeroSCROLLS 的 4 個(gè)數(shù)據(jù)集)上的平均表現(xiàn)超過了 ChatGPT-16k。

4. 其他特定領(lǐng)域的應(yīng)用能力

(1) 以查詢?yōu)榻裹c(diǎn)的摘要:[2] 發(fā)現(xiàn),與 ChatGPT 相比,微調(diào)訓(xùn)練在性能上仍然更好。在 CovidET、NEWTS、QMSum 和 SQuALITY 等數(shù)據(jù)集上,該類方法對(duì)比 ChatGPT 平均提升 2 個(gè)點(diǎn)的 ROUGE-1。

(2) 開放域問答:InstructRetro 在 NQ、TriviaQA、SQuAD 2.0 和 DROP 數(shù)據(jù)集上展現(xiàn)出比 GPT-3 更好的表現(xiàn)。與相似參數(shù)量的專有 GPT-instruct 模型相比,InstructRetro 在一系列短文和長文開放域問答數(shù)據(jù)集上有 7-10% 的領(lǐng)先。

(3) 醫(yī)療:在心理健康方面,MentalLlama-chat-13B 基于 IMHI 訓(xùn)練集微調(diào)了一個(gè) Llama-chat-13B 模型。在零樣本提示下,MentalLlama-chat-13B 模型在 IMHI 的 10 項(xiàng)任務(wù)中,9 項(xiàng)任務(wù)的表現(xiàn)優(yōu)于 ChatGPT。Radiology-Llama-2 模型基于放射學(xué)報(bào)告對(duì) Llama 進(jìn)行微調(diào),在 MIMIC-CXR 和 OpenI 數(shù)據(jù)集上的表現(xiàn)遠(yuǎn)遠(yuǎn)優(yōu)于 ChatGPT 和 GPT-4。

(4) 基于結(jié)構(gòu)化數(shù)據(jù)的生成:Struc-Bench 在結(jié)構(gòu)化生成數(shù)據(jù)上對(duì) Llama-7B 模型進(jìn)行微調(diào)。微調(diào)后的 7B 模型在基準(zhǔn)測試中優(yōu)于 ChatGPT。

(5) 評(píng)論生成:Shepherd 基于社區(qū)收集的評(píng)論數(shù)據(jù)和 1317 條高質(zhì)量人工標(biāo)注數(shù)據(jù)在 Llama-7B 上進(jìn)行微調(diào)。在以 GPT-4 作為評(píng)估器的情況下,Shepherd 在 60% 以上的情況下勝過或與 ChatGPT 持平。在以人類作為評(píng)估者的情況下,Shepherd 幾乎與 ChatGPT 持平。

5. 朝著值得信賴的人工智能邁進(jìn)

可靠性是確保 LLM 在實(shí)際應(yīng)用中至關(guān)重要。對(duì) LLM 生成幻覺和不安全內(nèi)容的擔(dān)憂會(huì)降低用戶對(duì) LLM 的信任,并帶來巨大的潛在風(fēng)險(xiǎn)。

(1) 幻覺:在微調(diào)期間,提高數(shù)據(jù)的正確性和相關(guān)性可以較少模型幻覺的生成。Platypus 收集了一個(gè)經(jīng)過內(nèi)容過濾、以 STEM 領(lǐng)域高質(zhì)量數(shù)據(jù)為主的數(shù)據(jù)集,并基于該數(shù)據(jù)集在一系列 LLM 上進(jìn)行微調(diào),最終在 TruthfulQA 上對(duì)于 ChatGPT 表現(xiàn)出了實(shí)質(zhì)性改進(jìn)(約 20%)。現(xiàn)有的在推理階段減少模型幻覺的技術(shù)主要有三類:(1)特定的解碼策略(Chain-of-Verification)、(2)外部知識(shí)增強(qiáng)(Chain-of-Knowledge(CoK),LLM-AUGMENTER,Knowledge Solver,CRITIC,Parametric Knowledge Guiding(PKG)等等)(3)多智能體對(duì)話([3],[4])。這些推理技術(shù)與僅使用 ChatGPT 的普通提示策略相比,可以提高答案準(zhǔn)確性。目前,ChatGPT 也推出了檢索插件(OpenAI,2023a 年),用于訪問外部知識(shí)以減少幻覺。

(2) 安全性:根據(jù)現(xiàn)有的評(píng)估結(jié)果,ChatGPT 和 GPT-4 模型在安全性評(píng)估方面仍然處于領(lǐng)先地位。這主要?dú)w功于人類反饋強(qiáng)化學(xué)習(xí)(RLHF)。RLHF 需要收集大量昂貴的人類標(biāo)注,這阻礙了其在開源大模型的使用。目前,通過 AI 反饋來代替人類反饋(RLAIF)和直接偏好優(yōu)化(DPO)等方法的提出可以大大降低 RLHF 的成本。結(jié)合并改進(jìn)這些方法可以給開源 LLM 的安全性帶來潛在的改進(jìn)。

III. 總結(jié)

1. 大模型的發(fā)展趨勢

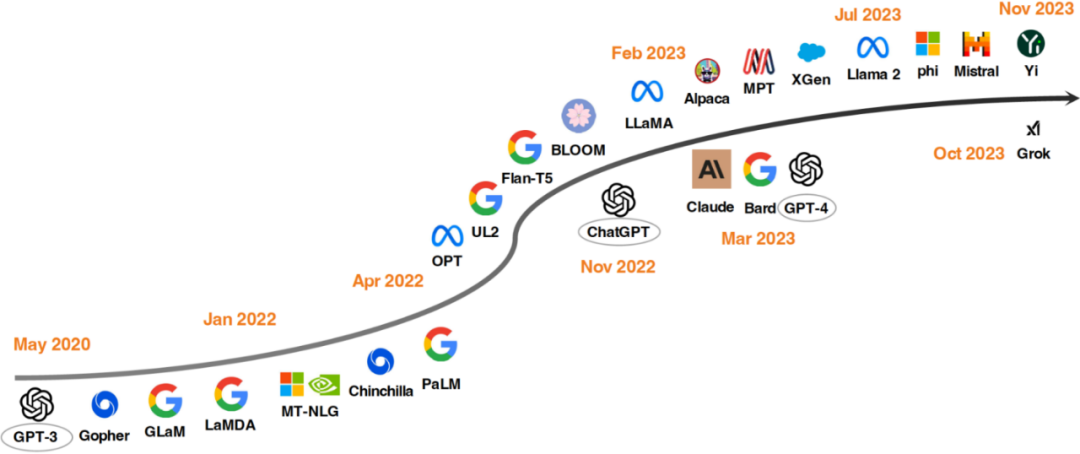

自從 GPT-3 問世以來,研究人員已經(jīng)做了大量的工作來推動(dòng) LLM 的發(fā)展,其中一個(gè)重要的研究方向就是擴(kuò)大模型的參數(shù)量 (比如 Gopher,MT-NLG 和 PaLM 等)。雖然這些大模型擁有強(qiáng)大的能力,但閉源的特性也限制了它們的廣泛應(yīng)用,因此也有一些工作開始關(guān)注開發(fā)開源的大語言模型,比如 OPT 和 BLOOM。與此同時(shí),探索如何預(yù)訓(xùn)練更小的模型(如 Chinchilla 和 UL2)和指令調(diào)整(如 Flan-T5)也是很重要的研究方向。

一年之前 ChatGPT 的出現(xiàn)極大地改變了 NLP 社區(qū)的研究重點(diǎn)。為了趕上 OpenAI,Google 和 Anthropic 分別開發(fā)了 Bard 和 Claude。雖然它們在許多任務(wù)上能夠有和 ChatGPT 相似的性能,但它們與 OpenAI 最新的模型 GPT-4 之間仍然存在一些差距。并且由于這些模型的成功主要來源于人類反饋的強(qiáng)化學(xué)習(xí)(RLHF),研究人員也探索了各種方法來改進(jìn) RLHF。

為了促進(jìn)開源 LLM 的研究,Meta 發(fā)布了 Llama 系列模型。此后,基于 Llama 的開源模型開始井噴式出現(xiàn)。一個(gè)有代表性的研究方向是使用指令數(shù)據(jù)對(duì) Llama 進(jìn)行微調(diào),包括 Alpaca、Vicuna、Lima 和 WizardLM 等。研究者們還探索了基于 Llama 的智能體、邏輯推理和長上下文建模能力。此外,與基于 Llama 開發(fā) LLM 不同,還有許多工作致力于從零開始訓(xùn)練 LLM,例如 MPT、Falcon、XGen、Phi、Baichuan、Mistral、Grok 和 Yi 等。我們相信,開發(fā)更強(qiáng)大、更高效的開源 LLM 將是一個(gè)非常有前途的未來方向。

2. 怎么才能制作出更好的開源大模型?

雖然頭部模型的詳細(xì)做法往往是保密的,但以下也有一些社區(qū)普遍認(rèn)可的最佳實(shí)踐:

(1) 數(shù)據(jù):預(yù)訓(xùn)練涉及使用來自公開可訪問來源的數(shù)萬億 token。相比之下,微調(diào)數(shù)據(jù)數(shù)量較少,但質(zhì)量更高。使用優(yōu)質(zhì)數(shù)據(jù)進(jìn)行微調(diào)的 LLM 可以獲得一定的性能改進(jìn),特別是在專業(yè)領(lǐng)域。

(2) 模型架構(gòu):盡管大多數(shù) LLM 使用了僅解碼器的 Transformer 架構(gòu),但很多模型也使用了不同的技術(shù)來優(yōu)化效果。比如 Llama-2 采用了 Ghost attention 以提高多輪對(duì)話控制能力,Mistral 采用滑動(dòng)窗口注意力來處理更長的上下文長度。

(3) 訓(xùn)練:使用指令調(diào)整數(shù)據(jù)進(jìn)行監(jiān)督微調(diào)(SFT)的過程至關(guān)重要。對(duì)于生成高質(zhì)量的結(jié)果,數(shù)萬個(gè) SFT 標(biāo)注就足夠了,正如 Llama-2 使用了 27,540 條標(biāo)注。這些數(shù)據(jù)的多樣性和質(zhì)量至關(guān)重要。在 RLHF 階段,近端策略優(yōu)化(PPO)通常是優(yōu)選的算法,以更好地使模型行為與人類偏好和指令遵循保持一致,這在增強(qiáng) LLM 的安全性方面起著關(guān)鍵作用。直接偏好優(yōu)化(DPO)可以作為 PPO 的替代方法。例如,Zephyr-7B 采用了 DPO,在各種常規(guī)基準(zhǔn)測試中顯示出與 70B-LLM 相當(dāng)?shù)慕Y(jié)果,甚至在 AlpacaEval 上超過了 ChatGPT。

3. 漏洞和潛在問題

(1)預(yù)訓(xùn)練期間的數(shù)據(jù)污染:數(shù)據(jù)污染問題的根源在于基準(zhǔn)數(shù)據(jù)的收集來源已經(jīng)包含在預(yù)訓(xùn)練語料中。因此,解決 LLM 的預(yù)訓(xùn)練語料檢測問題,探索現(xiàn)有基準(zhǔn)測試和廣泛使用的預(yù)訓(xùn)練語料之間的重疊,以及評(píng)估對(duì)基準(zhǔn)測試的過度擬合等挑戰(zhàn)是至關(guān)重要的。這些工作對(duì)于提高 LLM 的忠實(shí)度和可靠性至關(guān)重要。未來需要建立披露預(yù)訓(xùn)練語料細(xì)節(jié)的標(biāo)準(zhǔn)化實(shí)踐,并開發(fā)方法來減輕模型開發(fā)生命周期中的數(shù)據(jù)污染問題。

(2) 封閉式對(duì)齊開發(fā):在廣義偏好數(shù)據(jù)上應(yīng)用人類反饋的強(qiáng)化學(xué)習(xí)(RLHF)已經(jīng)引起了社區(qū)越來越多的關(guān)注。然而,只有少數(shù)幾個(gè)開源 LLM 使用 RLHF 進(jìn)行對(duì)齊。主要原因?yàn)槿狈Ω哔|(zhì)量、公開可用的偏好數(shù)據(jù)集和預(yù)先訓(xùn)練的獎(jiǎng)勵(lì)模型。我們?nèi)匀幻媾R著在復(fù)雜推理、編程和安全場景中缺乏多樣化、高質(zhì)量和可擴(kuò)展偏好數(shù)據(jù)的挑戰(zhàn)。

(3)在基本能力上的持續(xù)改進(jìn)難度:回顧本文提到的基本能力的突破揭示了一些具有挑戰(zhàn)性的情況:1. 人們已經(jīng)投入了大量精力來探索改進(jìn)預(yù)訓(xùn)練期間數(shù)據(jù)混合的方法,以提高構(gòu)建更強(qiáng)大基礎(chǔ)模型的平衡性和魯棒性。然而,相關(guān)的探索成本往往使得這種方法變得不切實(shí)際。2. 超越 ChatGPT 或 GPT-4 的模型主要基于來自閉源模型的知識(shí)蒸餾和額外的專家注釋。雖然高效,但過度依賴知識(shí)蒸餾可能會(huì)掩蓋關(guān)于將所提出的方法擴(kuò)展到教師模型時(shí)效果的潛在問題。此外,LLM 預(yù)計(jì)將充當(dāng)智能體并提供合理的解釋以支持決策,而為了使 LLM 適用于現(xiàn)實(shí)場景,注釋智能體任務(wù)形式的數(shù)據(jù)也是昂貴且耗時(shí)的。從本質(zhì)上講,僅通過知識(shí)蒸餾或?qū)<易⑨尩膬?yōu)化不能實(shí)現(xiàn)模型的持續(xù)改進(jìn),并且可能有上限。未來的研究方向可能涉及探索新的方法論,如無監(jiān)督或自監(jiān)督學(xué)習(xí)范式,以實(shí)現(xiàn)對(duì) LLM 基礎(chǔ)能力的持續(xù)改進(jìn),同時(shí)減輕相關(guān)的成本。

IV. 結(jié)論

在 ChatGPT 發(fā)布一周年之際,本文對(duì)高性能的開源 LLM 進(jìn)行了系統(tǒng)調(diào)研。結(jié)果表明,有很多開源大模型在特定領(lǐng)域上的表現(xiàn)已經(jīng)趕上甚至超越了 ChatGPT。此外,我們提供了對(duì)開源 LLM 的見解、分析和潛在問題的討論。我們相信,這份調(diào)查為開源 LLM 的有前景的方向提供了啟發(fā),并將激勵(lì)該領(lǐng)域的進(jìn)一步研究和發(fā)展,有助于彌合其與付費(fèi)閉源模型的差距。