國(guó)內(nèi)多所高校共建開源社區(qū)LAMM,加入多模態(tài)語(yǔ)言模型大家庭的時(shí)候到了

ChatGPT問(wèn)世以來(lái),大語(yǔ)言模型(LLM)實(shí)現(xiàn)了跳躍式發(fā)展,基于自然語(yǔ)言進(jìn)行人機(jī)交互的AI范式得到廣泛運(yùn)用。然而,人類與世界的交互中不僅有文本,其他諸如圖片、深度等模態(tài)也同樣重要。然而,目前的多模態(tài)大語(yǔ)言模型(MLLM)研究大多數(shù)閉源,對(duì)高校和大多數(shù)研究機(jī)構(gòu)的同學(xué)們并不友好。而且,大語(yǔ)言模型受限于訓(xùn)練知識(shí),往往缺乏時(shí)事認(rèn)知、復(fù)雜推理能力,這就如同只能快速問(wèn)答,沒(méi)有“深度思考”能力。AI Agent(人工智能代理)則是解決這一問(wèn)題的關(guān)鍵,它賦予LLM深度思考、復(fù)雜決策的能力,使LLM向自主性、反應(yīng)性、積極性和社交能力特征的智能實(shí)體發(fā)展。我們相信,AI Agent領(lǐng)域?qū)?huì)誕生更多改變生活工作方式的成果,是大語(yǔ)言模型及多模態(tài)大模型的重要進(jìn)化方向。

來(lái)自北航、復(fù)旦大學(xué)、悉尼大學(xué)、香港中文大學(xué)(深圳)等高校與上海人工智能實(shí)驗(yàn)室的學(xué)者共同推出多模態(tài)語(yǔ)言模型最早的開源社區(qū)之一 ——LAMM(Language-Assisted Multi-modal Model)。我們旨在將 LAMM 建設(shè)成一個(gè)不斷發(fā)展的社區(qū)生態(tài),支持 MLLM 訓(xùn)練和評(píng)測(cè)、MLLM 驅(qū)動(dòng)的 Agent 等方向的研究。作為多模態(tài)大語(yǔ)言模型領(lǐng)域最早的開源項(xiàng)目之一,LAMM 的目標(biāo)是建立一個(gè)開放的研究社區(qū)生態(tài),讓每個(gè)研究和開發(fā)人員都可以基于此開展研究,共同建設(shè)開源社區(qū)。

- 項(xiàng)目主頁(yè):https://openlamm.github.io

- 代碼地址:https://www.github.com/OpenGVLab/LAMM

在這里,你可以 :

- 以最小的計(jì)算資源成本訓(xùn)練和評(píng)估 MLLM,僅需 3090 或 V100,輕松開始 MLLM 的訓(xùn)練和評(píng)測(cè)。

- 構(gòu)建基于 MLLM 的具身智能 Agent,能夠使用機(jī)器人或游戲模擬器定義任務(wù)并生成數(shù)據(jù)。

- 在幾乎任何專業(yè)領(lǐng)域擴(kuò)展 MLLM 應(yīng)用。

開源框架

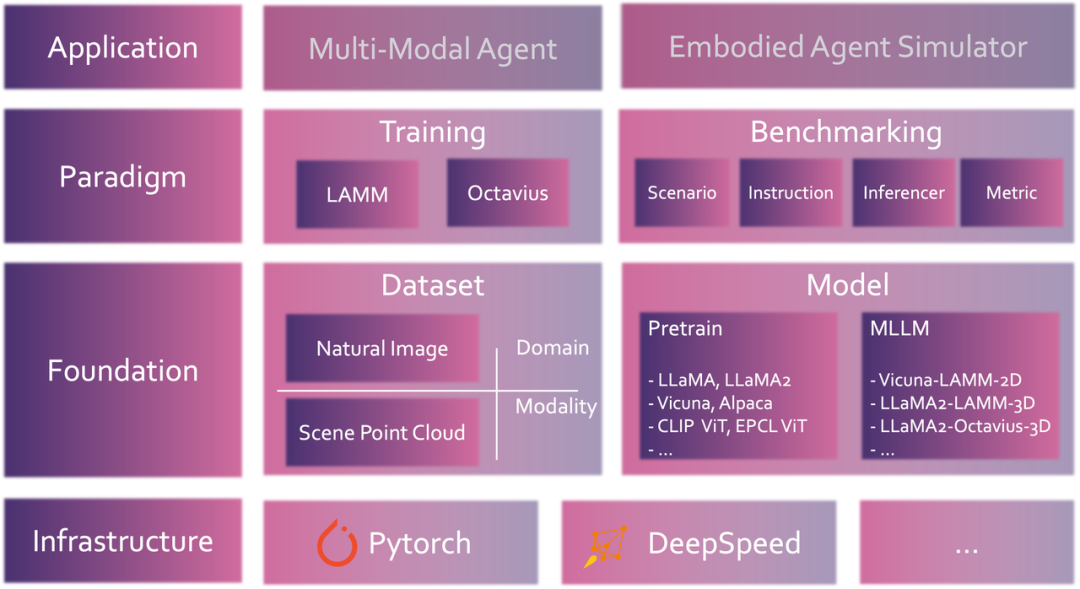

LAMM 代碼庫(kù)實(shí)現(xiàn)了統(tǒng)一的數(shù)據(jù)集格式、組件式模型設(shè)計(jì)、一鍵式分布式訓(xùn)練,方便用戶啟動(dòng)和實(shí)現(xiàn)自己專屬的多模態(tài)語(yǔ)言模型。

- 使用標(biāo)準(zhǔn)數(shù)據(jù)集格式兼容不同指令微調(diào)數(shù)據(jù)集。LAMM 定義了標(biāo)準(zhǔn)化多模態(tài)指令微調(diào)數(shù)據(jù)格式,可以多模態(tài)指令微調(diào)常用的 LLaVA、LAMM、ShareGPT4V 等數(shù)據(jù)集可以直接無(wú)縫適配,一鍵啟動(dòng)。

- 組件式搭建模型流程,方便地更新和修改模型架構(gòu)。LAMM 中模型以視覺(jué)編碼器(Vision Encoder)、特征映射器(Feature Projector)、語(yǔ)言模型(LLM)為主要組件。目前 LAMM 已經(jīng)支持 Image、Point Cloud 等模態(tài)編碼器和 LLaMA/LLaMA2 等預(yù)訓(xùn)練語(yǔ)言模型,用戶可以自由選擇適合需求的模塊搭建 pipeline,實(shí)現(xiàn)自己專屬的 MLLM。

- 以最小計(jì)算資源訓(xùn)練和評(píng)測(cè) MLLM。LAMM Repo 集成了 Deepspeed、LightLLM、flash attention 等加速框架,將訓(xùn)練成本大幅優(yōu)化。目前已經(jīng)支持在 4 張 RTX3090 或更新設(shè)備上微調(diào) 7B 的語(yǔ)言模型。同時(shí) LAMM 也在不斷跟進(jìn)新的大語(yǔ)言模型和優(yōu)化框架,以推動(dòng)多模態(tài)領(lǐng)域的發(fā)展。

- 基于 MLLM 構(gòu)建具身智能 AI Agent。使用機(jī)器人或模擬器定義目標(biāo)任務(wù)并生成相應(yīng)指令數(shù)據(jù)后,LAMM 支持的 MLLM 可以作為強(qiáng)大的 AI Agent 進(jìn)行決策和分析。

更多詳情請(qǐng)參考項(xiàng)目主頁(yè)。

多模態(tài)大語(yǔ)言模型訓(xùn)練與評(píng)測(cè)

近期大量工作展現(xiàn)了多模態(tài)大模型 (MLLM) 在視覺(jué)內(nèi)容理解和交互上的能力,并且體現(xiàn)出了解決更為復(fù)雜的下游任務(wù)應(yīng)用的能力。除了常見(jiàn)的圖片輸入,LAMM 目前還支持點(diǎn)云等視覺(jué)模態(tài)輸入,用戶也可以根據(jù)自己的需求加入新的編碼器。同時(shí),LAMM 支持 PEFT 包進(jìn)行高效微調(diào),也引入了 flash attention、xformer 等工具進(jìn)一步優(yōu)化模型計(jì)算成本,使得用戶能夠用盡可能低的成本訓(xùn)練 MLLM。面對(duì)復(fù)雜的多任務(wù)學(xué)習(xí),LAMM 也支持 MoE 等策略統(tǒng)一多組微調(diào)參數(shù),進(jìn)一步提高模型多任務(wù)能力,實(shí)現(xiàn)更全能的 MLLM。

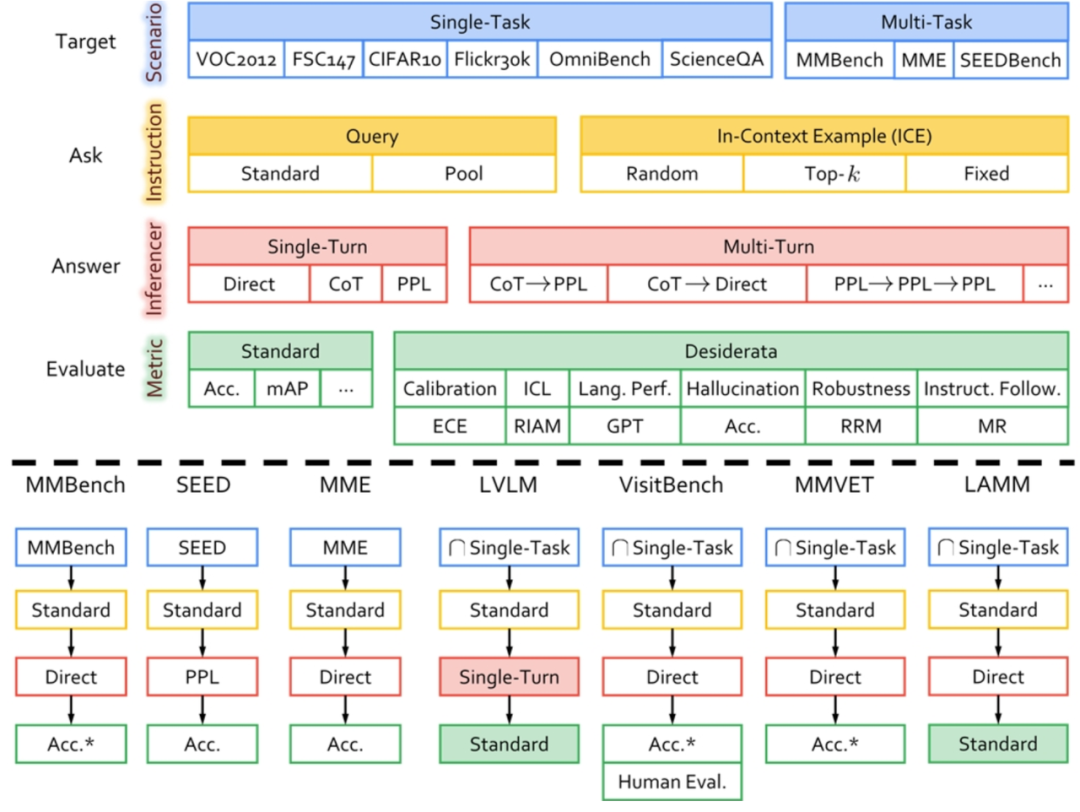

然而,由于缺乏一個(gè)標(biāo)準(zhǔn)化的全面評(píng)估框架,這些模型的能力和局限性尚未被全面探索,我們?nèi)匀粺o(wú)法確認(rèn)這些模型的能力究竟如何,他們究竟能做什么事情。現(xiàn)有的基準(zhǔn)測(cè)試工作主要集中于為多模態(tài)大模型構(gòu)建多模態(tài)評(píng)估數(shù)據(jù)集,或僅評(píng)估了一部分的視覺(jué)能力維度,或嘗試建立了一個(gè)評(píng)測(cè)框架但缺乏可擴(kuò)展性和全面性,對(duì)各個(gè)模型的全面評(píng)估和不同模型間進(jìn)行公平可靠的對(duì)比仍然具有挑戰(zhàn)性。LAMM 實(shí)現(xiàn)了一種具有高度可擴(kuò)展性和靈活性的評(píng)測(cè)框架,旨在為多模態(tài)大模型提供一種可靠的、全面的評(píng)估。

詳情可參考 https://openlamm.github.io/paper_list/ChEF

一鍵式組合式多模態(tài)語(yǔ)言模型評(píng)測(cè)框架

一鍵式組合式多模態(tài)語(yǔ)言模型評(píng)測(cè)框架

基于 LAMM 框架的多模態(tài)模型能力部分展示如下:

基于 2D 圖像內(nèi)容的問(wèn)答:

基于 3D 點(diǎn)云的視覺(jué)問(wèn)答:

多模態(tài)大語(yǔ)言模型驅(qū)動(dòng)的具身 Agent

近期大量工作借助大語(yǔ)言模型 (LLM) 的強(qiáng)大推理規(guī)劃能力來(lái)構(gòu)建 Agent,例如 Minecraft 中的 Voyager 和 GITM 都借助 LLM 和文本記憶來(lái)規(guī)劃智能體的行動(dòng),但是這些工作都假定智能體可以在規(guī)劃決策的時(shí)候獲取所有正確的環(huán)境感知信息,直接跳過(guò)感知階段,忽視了實(shí)時(shí)的第一人稱視角圖片對(duì)具身智能體規(guī)劃自身行動(dòng)的影響,這在現(xiàn)實(shí)生活中也是不可能存在的。

為了讓具身智能體在開放世界復(fù)雜環(huán)境中更好地感知環(huán)境,我們提出了以MLLM驅(qū)動(dòng)的具身智能體MP5,其特點(diǎn)在于具備視覺(jué)感知和主動(dòng)感知能力。視覺(jué)感知模塊(模型主要架構(gòu)為L(zhǎng)AMM)允許MP5解決以前從未見(jiàn)過(guò)的任務(wù),主動(dòng)感知可以主動(dòng)獲取環(huán)境信息,以執(zhí)行合適動(dòng)作。最終 MP5 具有開放感知能力,并能根據(jù)不同的目的提供量身定制的感知結(jié)果,可以完成長(zhǎng)時(shí)序及復(fù)雜環(huán)境信息任務(wù)。

下面是 MP5 在 Minecraft 這一開放世界中完成「在晴天且光線充足的情況下,找到一頭在平原且靠近水附近有草的豬」這一需要復(fù)雜環(huán)境信息的任務(wù)的演示過(guò)程。

總結(jié)

基于 MLLM 的強(qiáng)大能力和廣闊應(yīng)用前景,多模態(tài)學(xué)習(xí)來(lái)到了一個(gè)全新的階段。LAMM 旨在建設(shè)一個(gè)助力多模態(tài)大模型研究的開源社區(qū),并向社區(qū)開源了包括數(shù)據(jù)準(zhǔn)備、模型訓(xùn)練、性能評(píng)測(cè)所有相關(guān)數(shù)據(jù)。

作為最早一批投入多模態(tài)語(yǔ)言模型研究的團(tuán)隊(duì),我們希望不斷發(fā)展 LAMM 工具箱,為 LAMM 開源生態(tài)提供輕量易用的多模態(tài)研究框架,和開源力量合作,助力更多有意義的研究。

以上內(nèi)容均會(huì)在 LAMM 主頁(yè)持續(xù)開源,請(qǐng)大家關(guān)注我們的主頁(yè)和項(xiàng)目,也歡迎為 LAMM 代碼庫(kù)多多提交反饋和 PR。