英偉達吞噬世界!新架構(gòu)超級GPU問世,AI算力一步提升30倍

「這不是演唱會。你們是來參加開發(fā)者大會的!」老黃出場時,現(xiàn)場爆發(fā)出了巨大的歡呼聲。

今天凌晨四點,加州圣何塞,全球市值第三大公司英偉達一年一度的 GTC 大會開始了。

今年的 GTC 大會伴隨著生成式 AI 技術(shù)爆發(fā),以及英偉達市值的暴漲。相對的是,算力市場也在升溫,硬件和軟件方面的競爭都在加劇。

而英偉達帶來的產(chǎn)品,再次將 AI 芯片的標桿推向了難以想象的高度。

「通用計算已經(jīng)失去動力,現(xiàn)在我們需要更大的模型,我們需要更大的 GPU,更需要將 GPU 堆疊在一起。」黃仁勛說道。「這不是為了降低成本,而是為了擴大規(guī)模。」

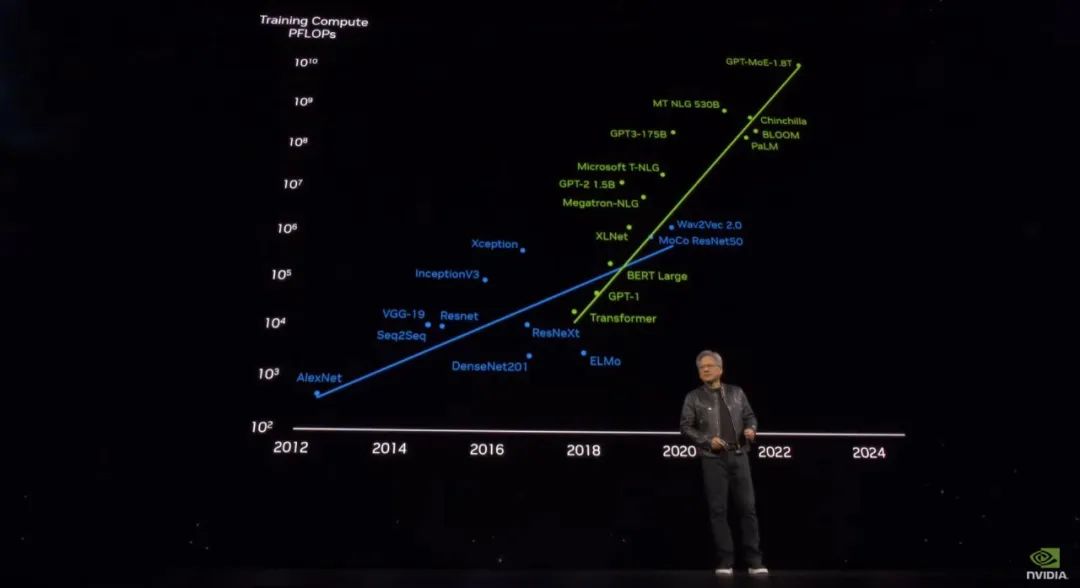

黃仁勛提到,大模型參數(shù)量正在呈指數(shù)級增長,此前 OpenAI 最大的模型已經(jīng)有 1.8T 參數(shù),需要吞吐數(shù)十億 token。即使是一塊 PetaFLOP 級的 GPU,訓練這樣大的模型也需要 1000 年才能完成。這句話還透露了一個關(guān)鍵信息:GPT-4 的實際參數(shù)量應該就是 1.8 萬億。

為了幫助世界構(gòu)建更大的 AI,英偉達必須首先拿出新的 GPU,這就是 Backwell。此處老黃已有點詞窮了:「這是塊非常非常大的 GPU!」

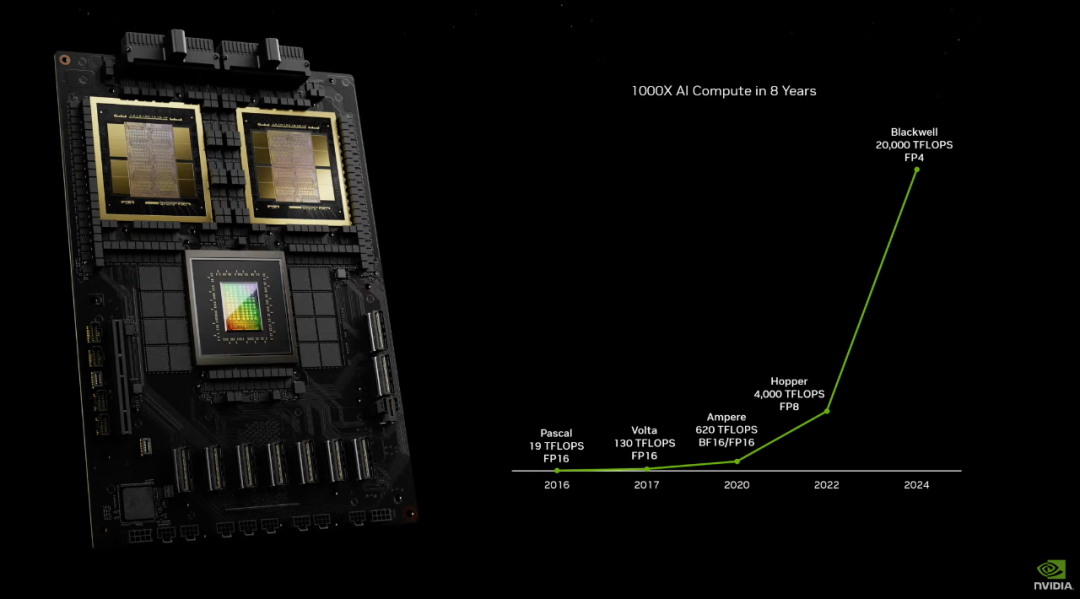

Blackwell 的發(fā)布意味著,近八年來,AI 算力增長了一千倍。一些網(wǎng)友看完發(fā)布會驚嘆:Nvidia eats world!

2080 億個晶體管的 Blackwell

同行不知應該怎么追

雖然全球的科技公司都還在爭搶 H100 芯片,但新一代產(chǎn)品已來。

在今天的大會上,英偉達正式推出了 Blackwell 平臺。從此以后,在數(shù)萬億參數(shù)上構(gòu)建和運行實時生成式 AI 大型語言模型的成本和能耗降低到此前的 25 分之一。

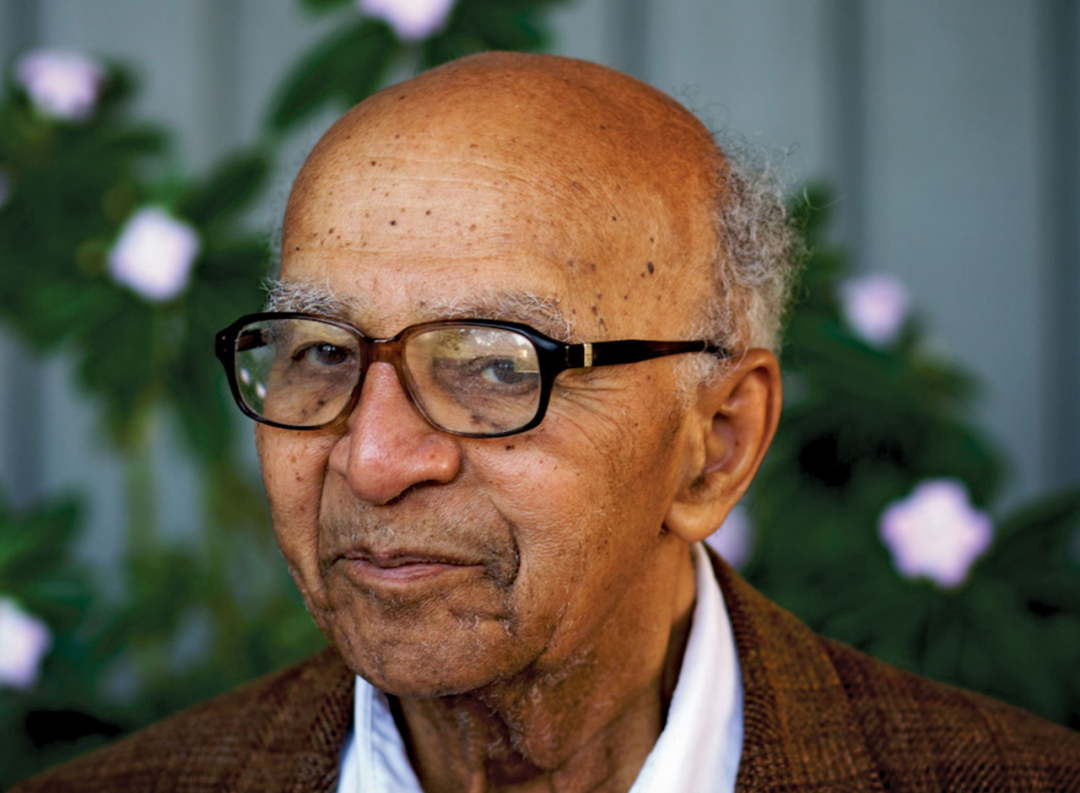

Blackwell 的名字旨在紀念第一位入選美國國家科學院的黑人學者、數(shù)學家和博弈論學家 David Harold Blackwell,它繼承了 Hopper GPU 架構(gòu),為加速計算樹立了新的標準。英偉達表示,Blackwell 架構(gòu)的 GPU 預計將于今年晚些時候發(fā)貨。

David Harold Blackwell。圖源 britannica

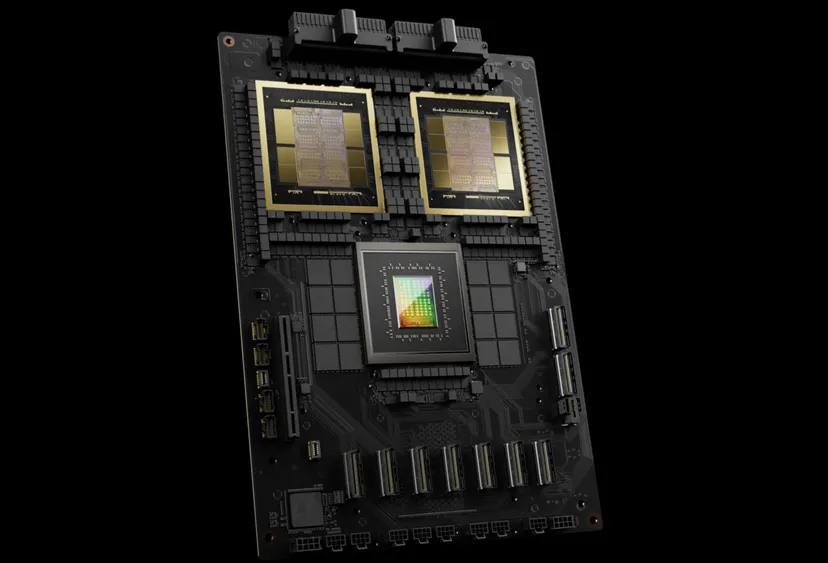

正如預期的一樣,Blackwell 是英偉達首個采用 MCM(多芯片封裝)設(shè)計的 GPU,在同一個芯片上集成了兩個 GPU。

在活動現(xiàn)場,黃仁勛對比了 Blackwell(右手)與 Hopper GH100 GPU(左手)的尺寸大小。

It’s OK, Hopper.

黃仁勛表示,Blackwell 將成為世界上最強大的芯片。Blackwell 架構(gòu)的 GPU 擁有 2080 億個晶體管,采用定制的、雙 reticle 的臺積電 4NP(4N 工藝的改進版本)制程工藝,兩塊小芯片之間的互聯(lián)速度高達 10TBps,可以大幅度提高處理能力。

此處需要強調(diào)的是,沒有內(nèi)存局部性問題或緩存問題,CUDA 將其視為單塊 GPU。

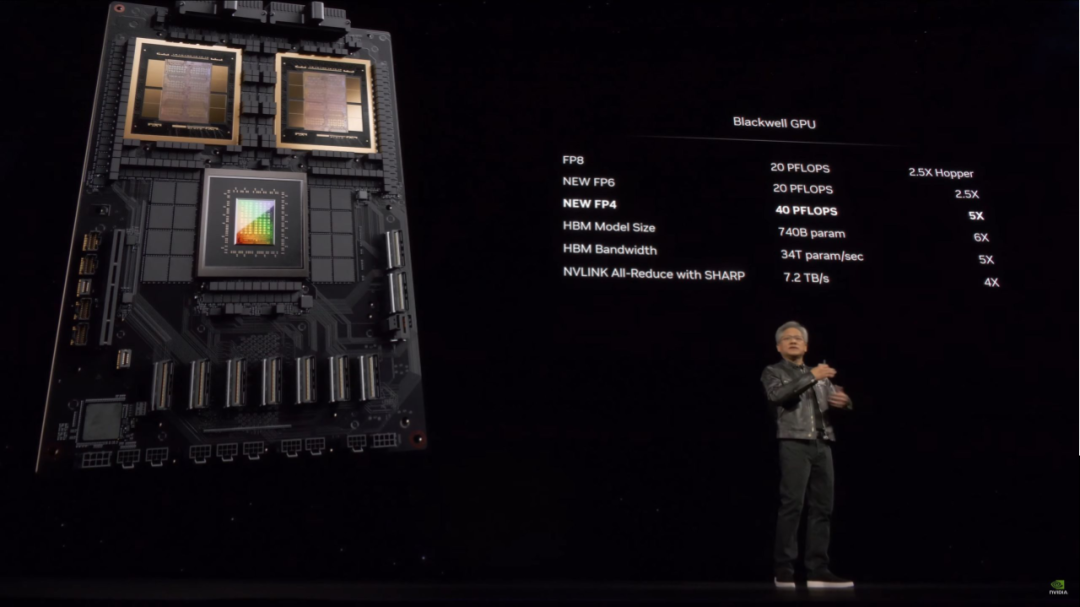

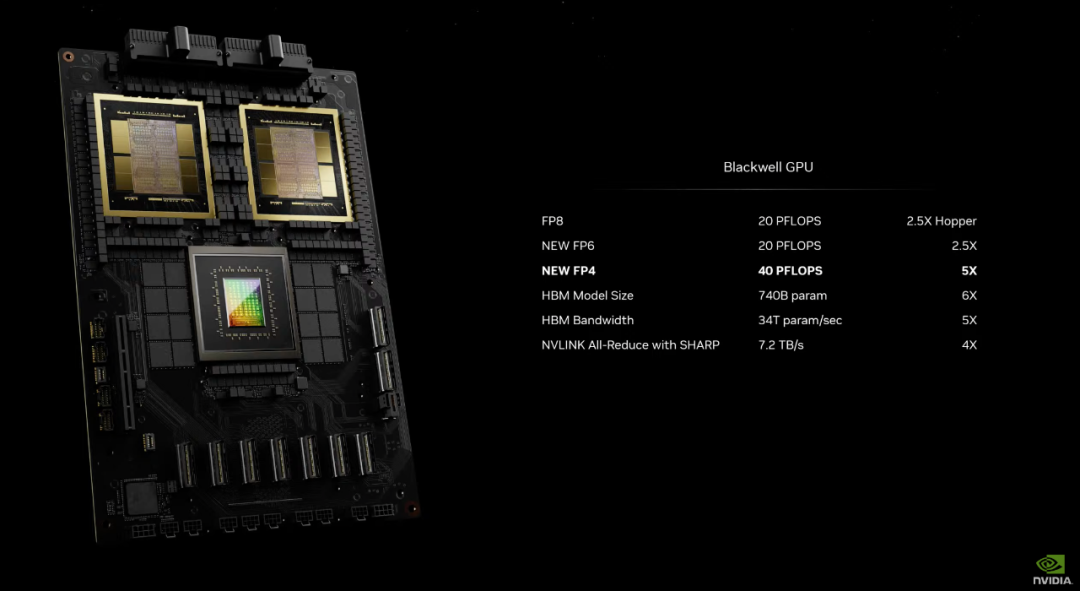

它還帶有 192GB 速度為 8Gbps 的 HBM3E 內(nèi)存,AI 算力能達到 20 petaflops(FP4 精度),相比之下,上代的 H100「僅為」4 petaflops。

這是世界上第一次有如此高效整合在一起的多 die 芯片,或許也是在制程升級速度減慢之后,升級算力的唯一方法。

黃仁勛提到,Blackwell 不是芯片名,而是整個平臺的名字。具體來講,采用 Blackwell 架構(gòu)的 GPU 分為了 B200 和 GB200 產(chǎn)品系列,后者集成了 1 個 Grace CPU 和 2 個 B200 GPU。

其中 B200 GPU 通過 2080 億個晶體管提供高達 20 petaflops 的 FP4 吞吐量。而 GB200 GPU 通過 900GB / 秒的超低功耗芯片到芯片連接,將兩個 B200 GPU 連接到 1 個 Grace CPU 上。

GB200 架構(gòu),包含兩個 GPU 和一個 CPU

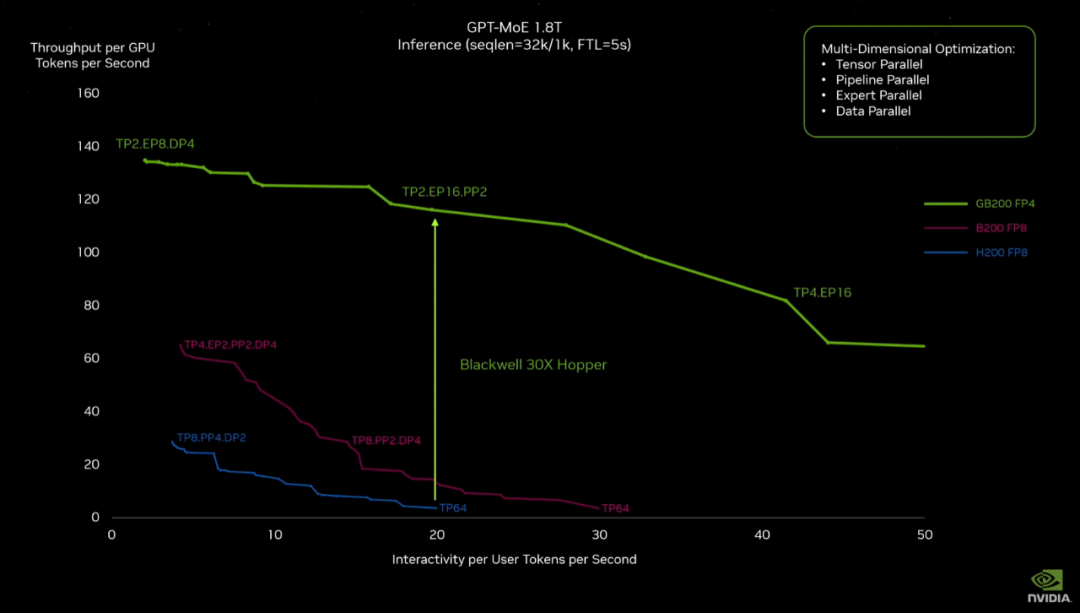

相較于 H100 Tensor Core GPU,GB200 超級芯片可以為大語言模型(LLM)推理負載提供 30 倍的性能提升,并將成本和能耗降低高達 25 倍。

「人們認為我們制造 GPU,但 GPU 看起來并不像以前那樣了,」黃仁勛表示。「我現(xiàn)在一手拿著 100 億,一手拿著 50 億。」

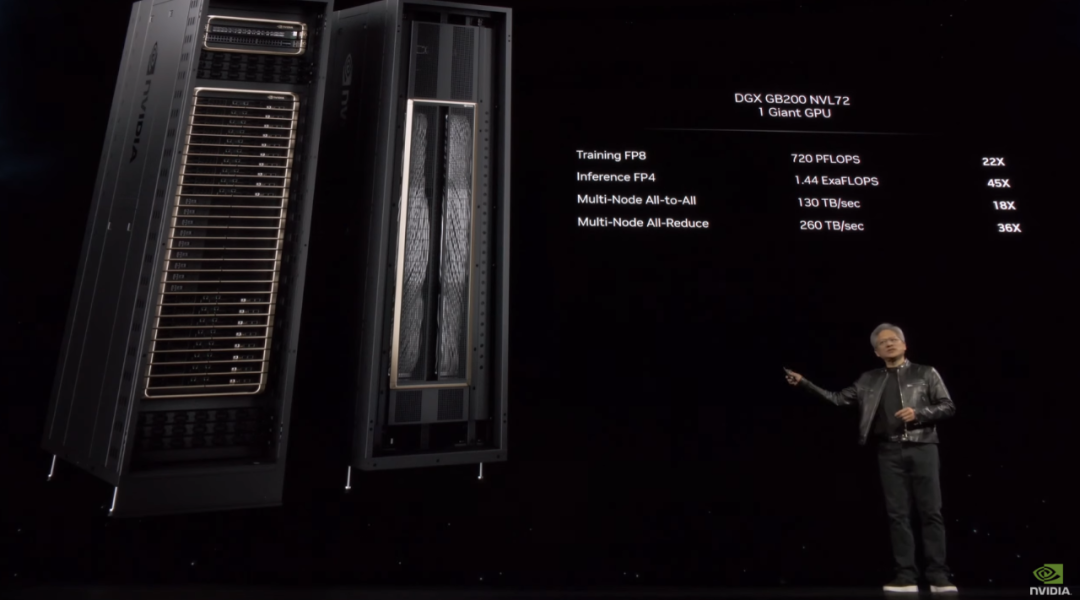

現(xiàn)在,顯卡不再是顯卡,而是作為系統(tǒng)整體售賣,畢竟只有通過英偉達自家的組件才能達到最佳效率。「現(xiàn)在我們賣的 GPU 是 7000 個組件,3000 磅重。」

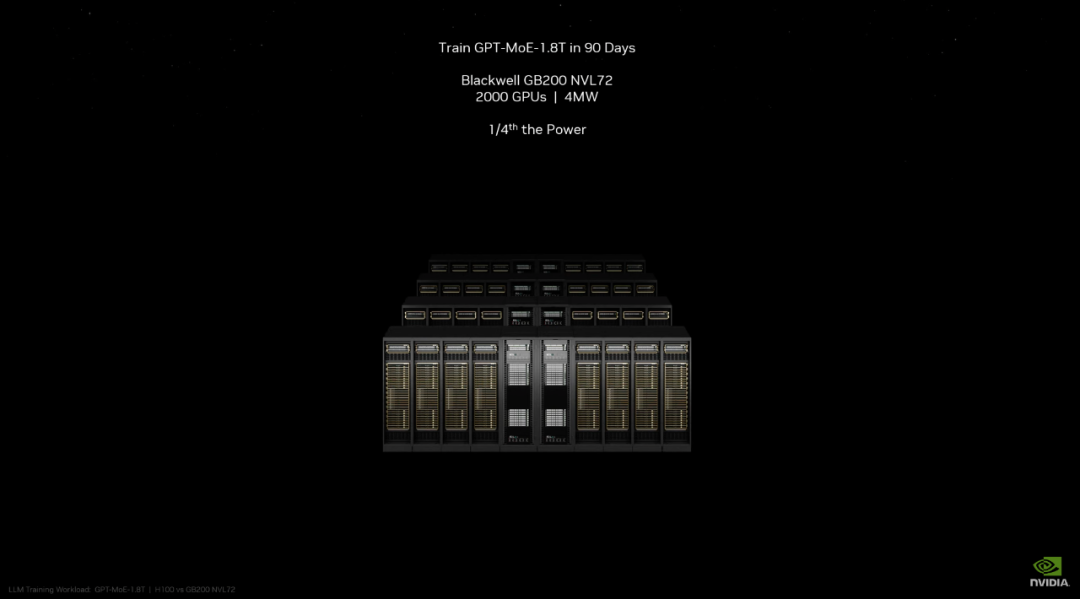

基于 Blackwell 的 AI 算力將以名為 DGX GB200 的完整服務器形態(tài)提供給用戶,結(jié)合了 36 顆 NVIDIA Grace CPU 和 72 塊 Blackwell GPU。這些超級芯片通過第五代 NVLink 連接成一臺超級計算機。

再往上擴展,Grace Blackwell 架構(gòu)的 DGX SuperPOD 由 8 個或以上的 DGX GB200 系統(tǒng)構(gòu)建而成,這些系統(tǒng)通過 NVIDIA Quantum InfiniBand 網(wǎng)絡連接,可擴展到數(shù)萬個 GB200 超級芯片。用戶可通過 NVLink 連接 8 個 DGX GB200 系統(tǒng)中的 576 塊 Blackwell GPU,從而獲得海量共享顯存空間,來訓練下一代 AI 模型。

再詳細對比一下性能的升級,以前使用 Hopper 訓練 GPT-MoE-1.8T,8000 塊 GPU 要花費 90 天,同樣的事只需要 2000 塊 GB2000,能耗也只需要四分之一。

生成式 AI 的下一步是多模態(tài)和視頻,也就意味著更大規(guī)模的訓練,Blackwell 帶來了更多可能性。

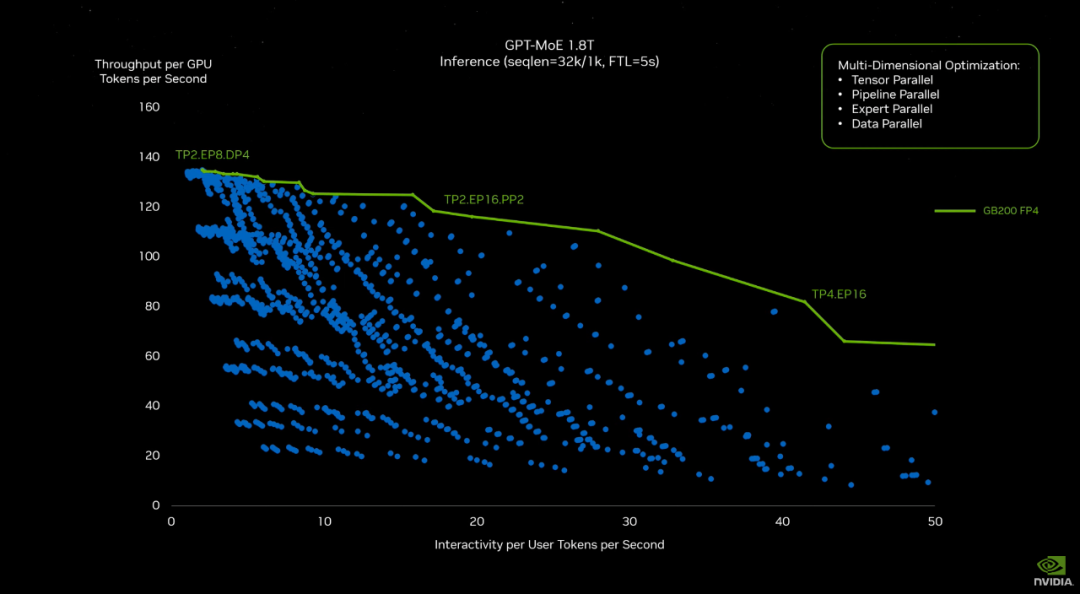

此外,大模型(LLM)的大規(guī)模推理始終是一個挑戰(zhàn),并非適合單個 GPU 的任務。在具有 1750 億個參數(shù)的 GPT-3 LLM 基準測試中,GB200 的性能是 H100 的 7 倍,并且訓練速度是 H100 的 4 倍。

現(xiàn)在,用于大模型推理的速度是上代的 30 倍,黃仁勛展示了一張對比圖,藍線是 Hopper。

「DGX 超級計算機是推進 AI 產(chǎn)業(yè)變革的工廠。新一代 DGX SuperPOD 集加速計算、網(wǎng)絡和軟件方面的最新進展于一身,能幫助每一個公司、行業(yè)和國家完善并生成自己的 AI,」黃仁勛說道。

有了 Blackwell,我們距離生成式 AI 的實用化也更近了一步。

兩大技術(shù)革新

第二代 Transformer 引擎、第五代 NVLink

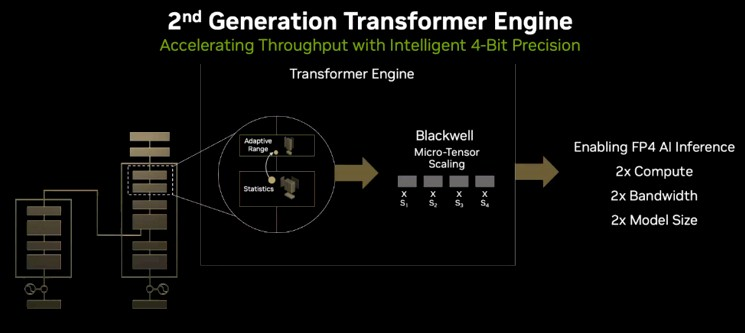

30 倍 AI 算力是如何做到的?除了使用新制程,并聯(lián)兩塊芯片以外,Blackwell 的關(guān)鍵改進在于引入第二代 Transformer 引擎,它支持了 FP4 和 FP6,使得計算、帶寬和模型大小翻了一番。

得益于新的微張量(micro-tensor)擴展支持和集成到英偉達 TensorRT-LLM 和 NeMo Megatron 框架中的先進動態(tài)范圍管理算法,Blackwell 通過 4-bit 浮點 AI 推理能力支持了雙倍的算力和模型大小。

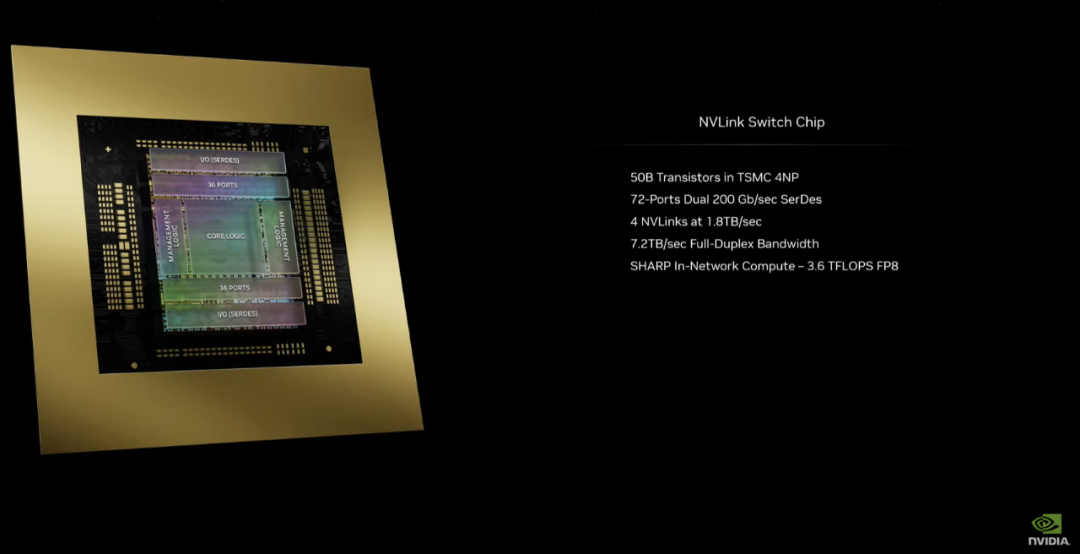

當互聯(lián)大量此類 GPU 時,第二個關(guān)鍵區(qū)別開始顯現(xiàn):下一代 NVLink 交換機可讓 576 個 GPU 相互通信,具有每秒 1.8 TB 的雙向帶寬。

英偉達表示,此前,僅由 16 個 GPU 組成的集群會在相互通信上花費 60% 的時間,而只有 40% 的時間用于實際計算。

現(xiàn)在,英偉達的 NVLink Switch Chip 可以讓所有這些芯片互聯(lián)起來,全速運轉(zhuǎn)沒有瓶頸(1.8TB/s,幾乎比上代快 10 倍),并幫助構(gòu)建了 DGX GB200 NVL72。

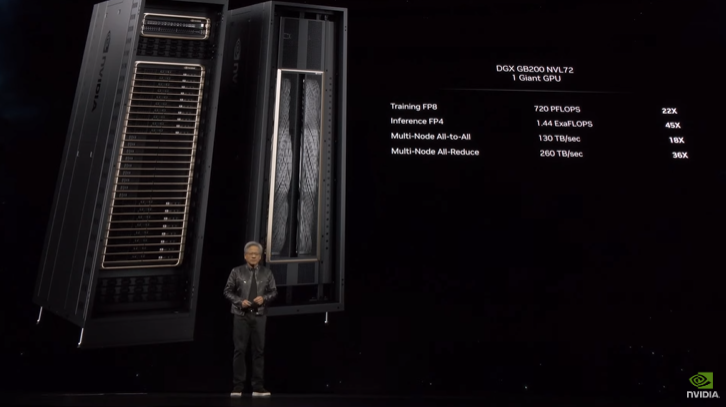

通過高速互聯(lián)的機制,DGX GB200 NVL72 可以被認為是一個超級 GPU,F(xiàn)P8 訓練吞吐量高達 720 PFLOPS、FP4 推理吞吐量為 1.44 ExaFLOPS,多節(jié)點 All-to-All 通信速度為 130TB / 秒,多節(jié)點 All-Reduce 通信速度為 260TB / 秒。

在具體架構(gòu)方面,DGX GB200 NVL72 擁有 18 個 GB200 節(jié)點機架,每個節(jié)點搭配 2 個 GB200 GPU。此外還有 9 個 NVSwitch 機架,從而為 GB200 NVL 提供了 720 PFLOPS 的 FP8 吞吐量,以及 FP4 精度的 ExaFLOPS。

所以今年畫風變了現(xiàn)在 DGX 長這樣:擁有 5000 條 NVLink 電纜,長達 2 英里,都是銅電纜,不需要光收發(fā)器,節(jié)省了 20kW 的計算成本。

它的功耗過大,以至于需要用液冷,同時重量高達 3000 磅(約 1361 公斤)。

2016 年,老黃扛著第一個 DGX 系統(tǒng)給 OpenAI,這才有了如今的 ChatGPT。那個時候 DGX 的算力是 0.17Petaflops,現(xiàn)在這個 GB200,算力是以 Exaflop 計算的。

在英偉達新的摩爾定律下,算力的提升速度居然還加快了。

構(gòu)建生態(tài),入場具身智能

除了硬件系統(tǒng),英偉達也利用生成式 AI 構(gòu)建了一系列元宇宙、工業(yè)數(shù)字孿生、機器人訓練軟件體系。

英偉達表示,它正在將 Omniverse 企業(yè)技術(shù)引入蘋果。這個想法是讓開發(fā)人員通過 Vision Pro 在 AR/VR 設(shè)置中使用 Omniverse 工具。在 GTC 上,英偉達展示了設(shè)計師是如何通過 Vision Pro 使用汽車配置工具來操縱車輛,然后虛擬地進入其中的。人們可以通過 Omniverse Cloud API 以及通過云端直接流式傳輸?shù)?Vision Pro 的圖形傳輸網(wǎng)絡來做到這一點。

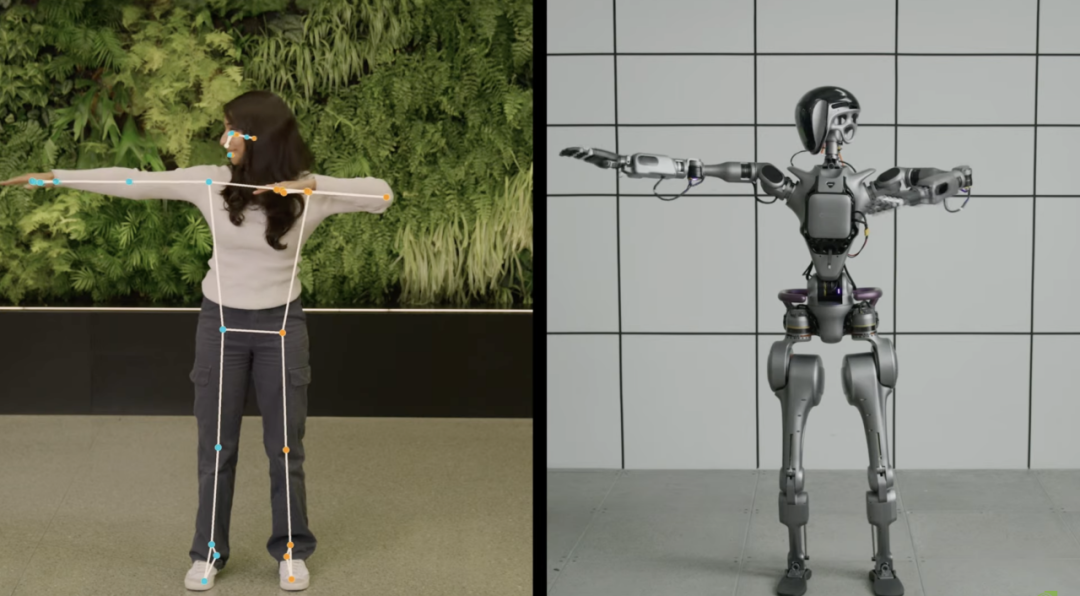

最后,還有前沿方向機器人的工作,英偉達公布了人形機器人項目 GR00T。

在今天的主題演講中,黃仁勛展示了多個由 GR00T 驅(qū)動的人形機器人如何完成各種任務,包括來自 Agility Robotics、Apptronik、傅利葉智能(Fourier Intelligence) 和宇樹科技(Unitree Robotics) 的機器人產(chǎn)品。

GR00T 脫胎于英偉達的 Isaac 機器人平臺工具,基于新的通用基礎(chǔ)模型,GR00T 驅(qū)動的人形機器人能夠接受文本、語音、視頻甚至現(xiàn)場演示的輸入,并對其進行處理以采取特定的操作,包括理解自然語言、模擬人類行為、在現(xiàn)實世界中導航和交互。

英偉達還開發(fā)了一種新型「機器人大腦」計算芯片 Jetson Thor,能夠執(zhí)行復雜的任務并使用 Transformer 引擎處理多個傳感器。

人形機器人賽道近期達到了一個新的火熱程度。就比如英偉達的「大客戶」OpenAI,一直在使用自己的 AI 模型來為一家名為 Figure 的初創(chuàng)公司的人形機器人提供支持。

現(xiàn)在英偉達也把它擺在了重要位置,正如黃仁勛所說:「機器人的 ChatGPT 時刻可能即將到來。」

你準備好了嗎?