小紅書多模態團隊建立新「擴散模型」:解碼腦電波,高清還原人眼所見

近些年,研究人員們對探索大腦如何解讀視覺信息,并試圖還原出原始圖像一直孜孜不倦。去年一篇被 CVPR 錄用的論文,通過擴散模型重建視覺影像,給出了非常炸裂的效果—— AI 不光通過腦電波知道你看到了什么,并且幫你畫了出來。

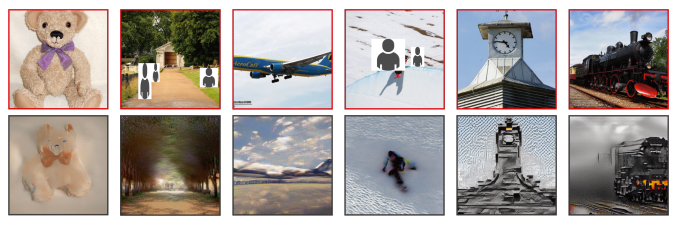

第一行:人眼所見畫面,第二行:AI 重現的畫面

簡而言之,AI 利用 fMRI 信號(全稱為功能性核磁共振成像)+ Diffusion Model,就能一定程度上實現「讀腦術」。

不過,如何有效提取并利用 fMRI 信號中隱含的語義和輪廓信息,仍然是業界的一個關鍵挑戰。

在上月揭曉的 AAAI 2024 上,小紅書多模態團隊提出了一種新方法——可控腦視覺擴散模型(Controllable Mind Visual Diffusion Model,CMVDM)。該模型能很好地將 fMRI 信號還原為與原始視覺刺激語義屬性一致,空間結構對齊的高質量圖片,可以使得生成的圖像清晰度更高、也更接近人眼所見的原始圖像。

具體來說,CMVDM 首先使用屬性對齊和輔助網絡,從 fMRI 數據中提取語義和輪廓信息。其次,引入一個控制模型并結合殘差塊,充分利用提取的信息進行圖像合成,生成與原始視覺刺激在語義內容和輪廓特征上高度相似的高質量圖像。

通過大量實驗,小紅書多模態團隊證明了 CMVDM 在可視化質量和技術指標上都優于現有的最先進的方法(SOTA)。此外,團隊還發現大腦的高級視覺皮層(HVC) 主要關注視覺刺激的語義信息,而低級視覺皮層(LVC)則主要關注視覺刺激的結構信息。

一、背景

理解人類大腦在觀察視覺刺激(例如自然圖像)時發生的認知過程,一直是神經科學家的主要關注點。客觀的視覺刺激和主觀的認知活動,都能在大腦的視覺皮層中引發復雜的神經信號傳遞,從而為更高層次的認知認知和決策過程奠定基礎。隨著功能性磁共振成像(fMRI)等技術的進步,人們已經能夠以更高的精度和更細的粒度捕獲實時的大腦活動信號,從而加速了神經科學研究的進程。然而,對于認知神經科學和下游應用(如腦機接口 BCI)來說,解讀和重構這些復雜的信號仍然是一個巨大的挑戰。

早期嘗試在分析視覺任務的大腦活動時,主要關注將在人類受試者的大腦活動與觀察到的自然圖像相匹配,或者重構簡單幾何形狀的視覺模式。這些探索證明了從大腦信號中獲取感知圖像的語義信息的可行性,然而它們對未見過的語義類別或復雜的重構任務的泛化能力較差。

近期研究在從大腦信號重構視覺刺激方面取得了重要進展。Roman Beliy、Guy Gaziv 等工作能夠生成與原始視覺刺激形狀相似的圖像,但這些圖像存在嚴重的扭曲和模糊問題。文獻 IC-GAN, Mind-Vis 等研究采用了常用的生成模型,如生成對抗網絡(GAN)或擴散模型,生成的高質量 RGB 圖像在語義上與原始視覺刺激保持一致,條件是對應的 fMRI 信號。然而,如圖所示,這些方法在位置一致性上存在問題。 總的來說,現有方法未能有效地利用 fMRI 信號中固有的語義和空間特征。

為了解決上述問題,我們提出了一種可控腦視覺擴散模型(CMVDM),該模型通過控制網絡使擴散模型能夠利用提取出可信的語義和輪廓信息,從而完成高度逼真的人類視覺重構。我們在兩個數據集上進行了全面的實驗來評估 CMVDM 的性能。與現有的方法相比,它在定性和定量結果上都達到了最先進的水平(SOTA),證明了 CMVDM 從 fMRI 信號中解碼高質量和可控圖像的有效性。

二、方法

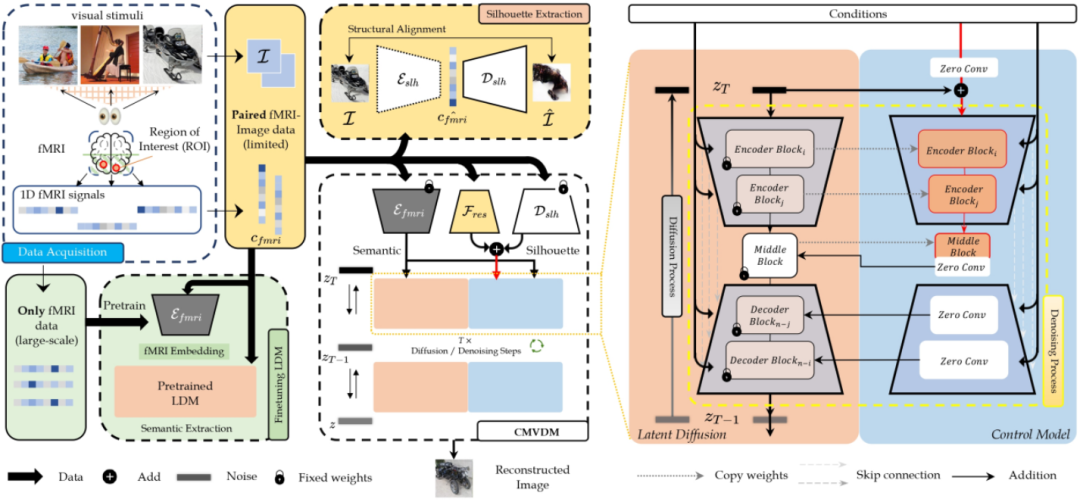

CMVDM 框架示意圖

具體來說,我們的方法可以被拆解為:

● 我們首先對一個預訓練的潛在擴散模型(Latent Diffusion Model,LDM)進行微調,使用語義對齊損失來提高性能,并預訓練一個輪廓提取器來估計 fMRI 數據的準確語義和輪廓信息。

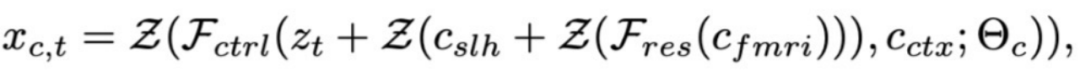

● 受 ControlNet 的啟發,我們引入一個控制網絡,該網絡將輪廓信息作為條件輸入到預訓練的 LDM 中,以指導擴散過程生成所需的圖像,這些圖像在語義和輪廓信息方面都與原始視覺刺激相匹配。

● 此外,我們構建了一個殘差模塊來提供超出語義和輪廓的信息。

2.1 預訓練 LDM 調整以及語義信息提取

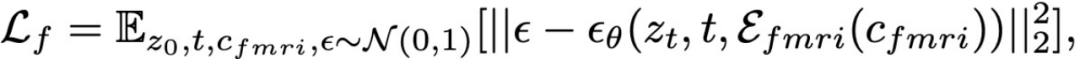

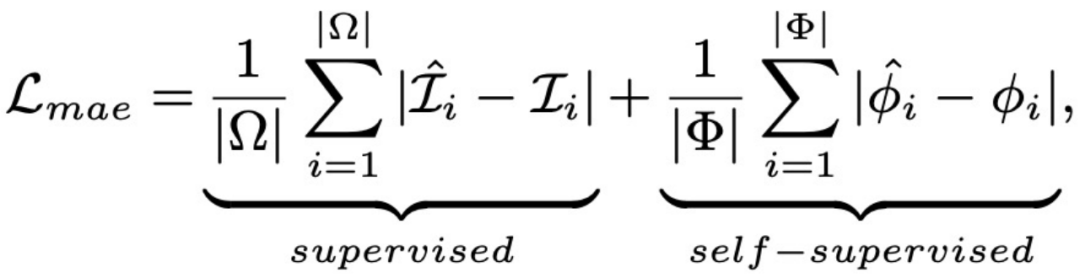

我們引入在 HCP 數據集上預訓練的 fMRI 信號特征提取器以及預訓練的 LDM 網絡,通過下述監督損失優化 fMRI 信號特征提取器以及 LDM 網絡中的 cross attention 層,從而基本實現將腦電信號還原為視覺刺激。

我們將上文從 fMRI 信號提取器中得到的特征定義為從 fMRI 信號中提取的語義信息。由于缺乏直接的語義監督,只憑上文提到的監督函數可能無法提供足夠的語義信息。因此,我們設計了一個語義對齊損失來進一步增強語義信息和余弦相似度,如下所示。

核心思路是將從 fMRI 信號中提取出的語義信息與 CLIP 處理圖片得到的特征進行對齊。可以參考「CMVDM 框架示意圖」中的“Finetuning LDM”部分。

2.2 輪廓信息提取

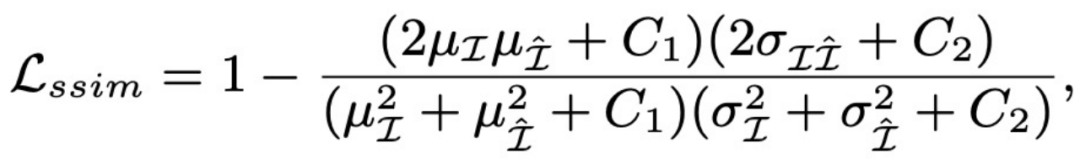

由于缺乏明確的位置條件指導,Latent Diffusion Model 生成與輪廓匹配的結果仍然是一個挑戰。因此,我們提出了輪廓估計網絡來提取輪廓信息。我們的輪廓估計網絡由兩個對稱的部分組成:一個編碼器 ε 和一個解碼器 。編碼器將輸入圖像投影到 fMRI 信號空間,而解碼器則正相反。我們采用結構相似性(SSIM)損失和平均絕對誤差(MAE)損失來優化圖像和 Ground Truth 圖像之間的空間距離,具體公示如下。我們采用解碼器從 fMRI 信號中提取輪廓信息。

可以參考「CMVDM 框架示意圖」中的 “Silhouette Extraction” 部分。

2.3 控制網絡訓練

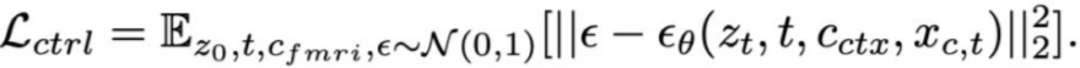

在從 fMRI 信號中獲取增強的語義信息和可靠的輪廓信息后,我們使用它們來控制生成的結果。受 ControlNet 的啟發,我們設計了一個控制模型來控制生成圖像的整體構成。具體來說,我們固定了 LDM 中去噪網絡中的所有參數,并將去噪網絡的 U-Net 編碼器克隆到可訓練的控制模塊中。控制模塊的輸入包括噪聲潛在代碼、語義信息和輪廓信息。此外,為了彌補在屬性提取中丟失的 fMRI 信息,我們采用了一個可訓練的殘差塊來添加超出語義和輪廓的信息。推理過程和監督控制模型的訓練損失表示為:

可以參考「CMVDM 框架示意圖」中的 “Control Model” 以及 部分。

三、實驗

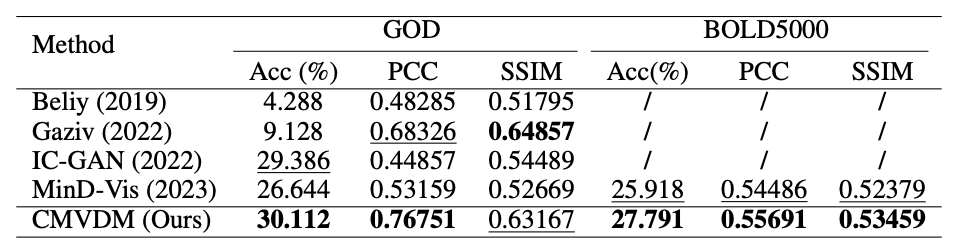

我們考慮在不同復雜度數據集上進行視覺信號重建測試,考慮的數據集有兩個:Generic Objects Dataset (GOD)、BOLD5000 (Brain, Object, Landscape Dataset)。前者多為受試者對簡單圖片物體的腦電信號-圖片對,后者則增加了場景復雜度和數據量。我們將 CMVDM 與四種 SOTA 方法進行比較:Beliy、Gaziv、IC-GAN、MinD-Vis。為評估模型的性能,在評價指標上我們考慮 N-way 分類準確度(Acc),皮爾森相關系數(PCC),結構相似性度量(SSIM)來評價生成圖像的語義準確度和結構相似性。

3.1 指標對比結果

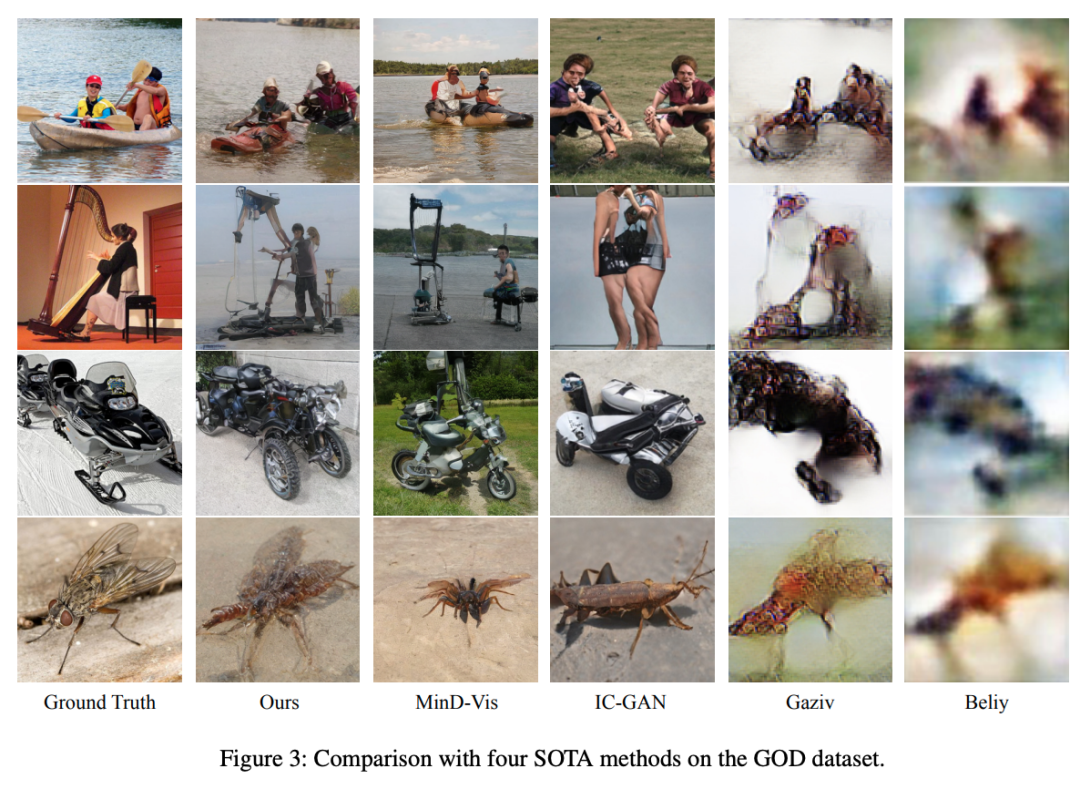

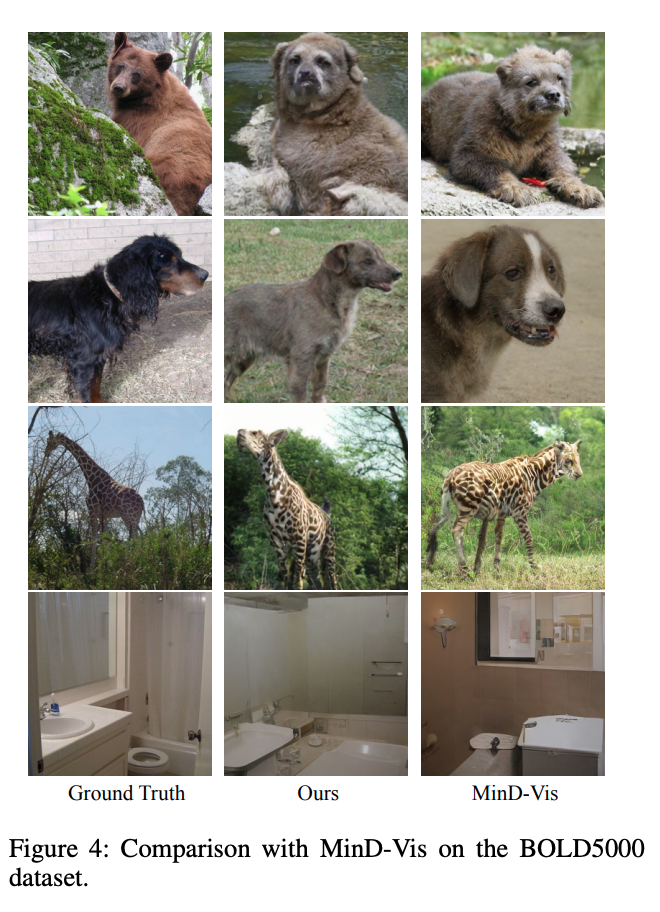

如圖所示,實驗結果揭示了 CMVDM 總體上顯著優于其他方法。與 IC-GAN、MinD-Vis 相比,盡管兩者都產生了良好的結果,但 CMVDM 在 SSIM 方面顯著優于它們。這表明 CMVDM 生成的圖像在物體輪廓和圖像結構方面與視覺刺激的相似度更高。Gaziv 在 SSIM 方面取得了顯著的結果,但視覺結果表明,Gaziv 方法無法生成高保真度的圖像。

3.2 可視化對比結果

● GOD 上的可視化對比

● BOLD5000 對比結果

3.3 實驗分析

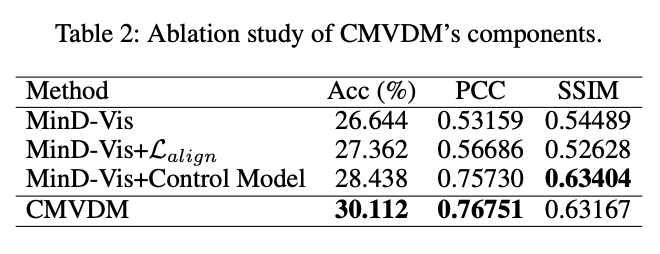

本工作對提出的損失函數與引入的模塊進行了消融實驗,并結合不同視覺皮層的腦電信號進行實驗對比與可視化驗證,證明了所提出方法的有效性。

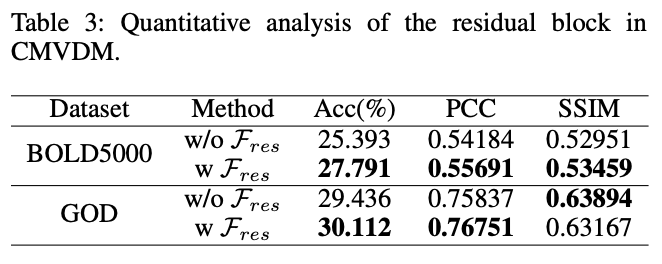

● 消融實驗指標分析

消融實驗表明,CMVDM 在引入了新的對齊損失與結構控制模塊后實現了對原始刺激更高的語義準確度和結構相似性。

引入的殘差模塊 有效提高了模型的表現:

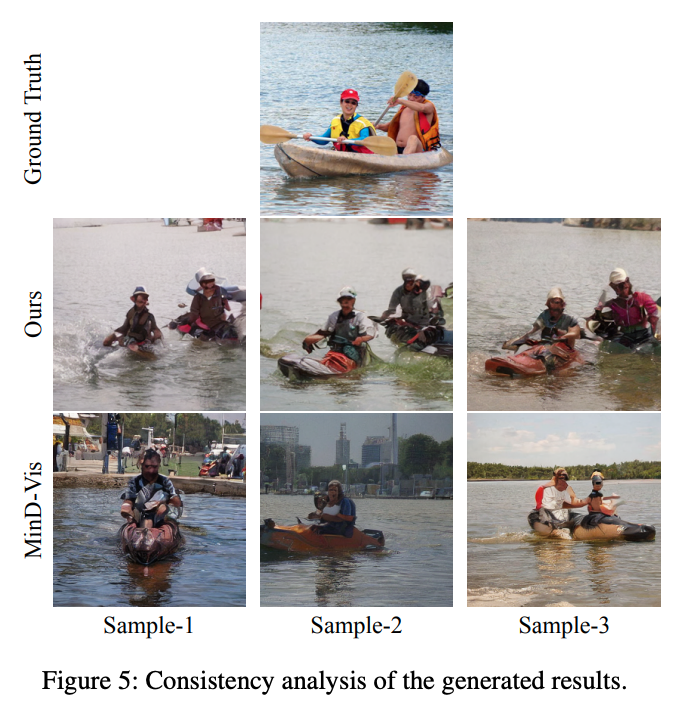

● 重建結果一致性可視化分析

我們的方法相比于 MinD-Vis 在生成一致性上更佳,表現出了對生成圖片結構的有效控制。

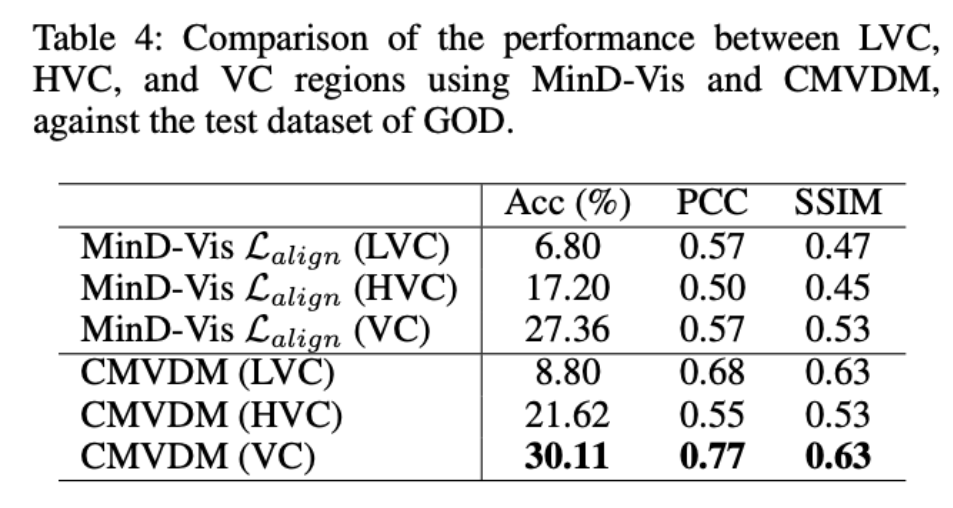

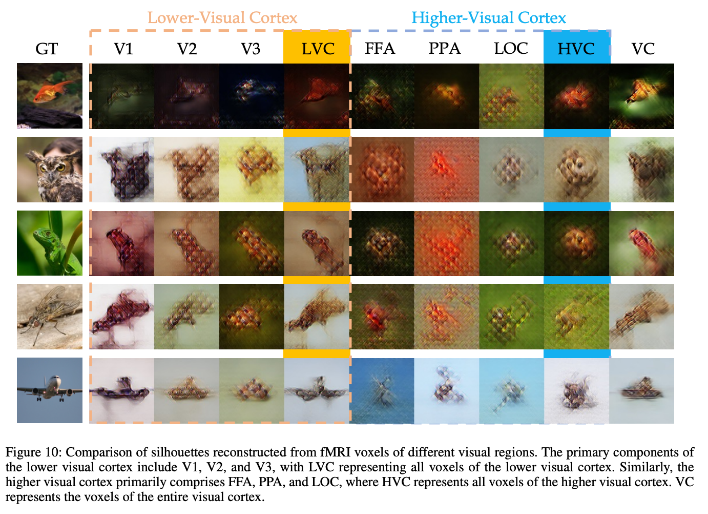

● 不同視覺皮層區域信號的重建分析

V1,V2, V3 均屬于低級視覺皮層 LVC 的主要組成區域,FFA,PPA,LOC則屬于高級視覺皮層 HVC 的主要組成區域,VC 代表全視覺皮層

實驗結果與可視化表明:LVC 在結構指標上(如 SSIM )表現優于 HVC,表明低級視覺皮層捕獲視覺信息的結構等低級特征;HVC 在語義指標上(如 Acc )表現明顯優于 LVC,表明高級視覺皮層用于處理更抽象的語義特征;借助全視覺皮層 VC 的信號,我們的方法可以有效重建出語義、結構與原始視覺刺激相近的高質量圖像。

四、結束

我們提出了可控腦視覺擴散模型(CMVDM)。這項工作將腦電信號重建問題分解為特征提取和圖像重建兩個子任務。通過采取自監督與半監督方法,我們分別提取信號的語義和結構特征,并利用預訓練擴散模型的豐富知識進行多條件視覺信號重建,實現了與原始視覺刺激語義匹配且結構相似的高質量圖像生成。

更進一步,CMVDM 在腦電信號重建相關的數據集上取得了最先進成果(SOTA),展現了其在復雜場景視覺信號可控重建方面的良好泛化性,突出其在神經科學和計算機視覺交叉領域的創新性和實用性。本文提出的 Diffusion-based 生成方案可拓展至泛化的條件可控生成領域,為小紅書發布端文生圖新玩法提供更多方案。

論文地址:https://arxiv.org/pdf/2305.10135.pdf

五、作者簡介

- 曾博涵

現為北京航空航天大學碩士研究生,小紅書創作發布團隊實習生,曾在 ECCV、CVPR、NeurIPS 等發表論文。主要研究方向為計算機視覺生成。 - 李尚霖

現為北京航空航天大學碩士研究生,小紅書創作發布團隊實習生,曾在 AAAI 發表多篇論文。主要研究方向為計算機視覺生成、聯邦學習等。 - 萊戈(賈一亮)

小紅書生態算法團隊負責人。曾在 CVPR、ICCV、ECCV、TNNLS、TGRS 等會刊發表 10 余篇論文,曾獲 YouTube-VOS 視頻分割競賽 Top-3 排名,曾獲天池視覺分割大獎賽復賽第 1 名。主要研究方向:目標跟蹤、視頻分割、多模態分類/檢索等。 - 湯神(田不易)

小紅書創作發布團隊負責人。曾在 CVPR、ECCV、ICCV、TIFS、ACMMM 等會議與期刊發表近 20 篇論文。多次刷新 WiderFace 和 FDDB 國際榜單世界記錄,ICCV Wider Challenge 人臉檢測國際競賽冠軍,ICCV VOT 單目標跟蹤冠軍,CVPR UG2+ 亞軍。