非Transformer架構新模型爆火,從第一性原理出發(fā),MIT CSAIL衍生團隊打造

挑戰(zhàn)Transformer,MIT初創(chuàng)團隊推出LFM(Liquid Foundation Model)新架構模型爆火。

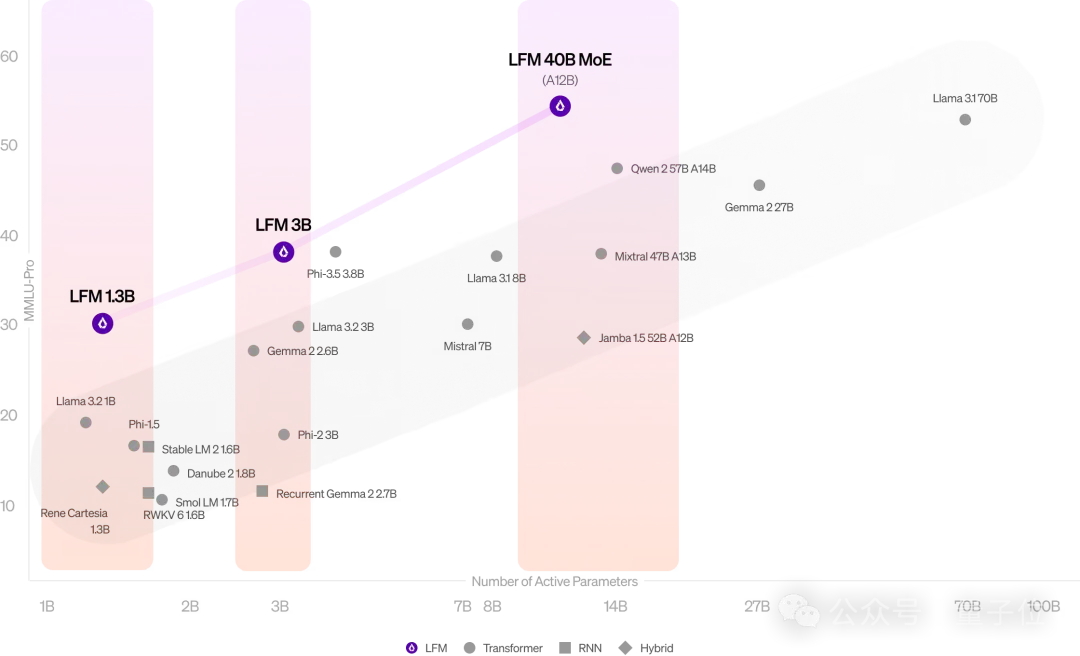

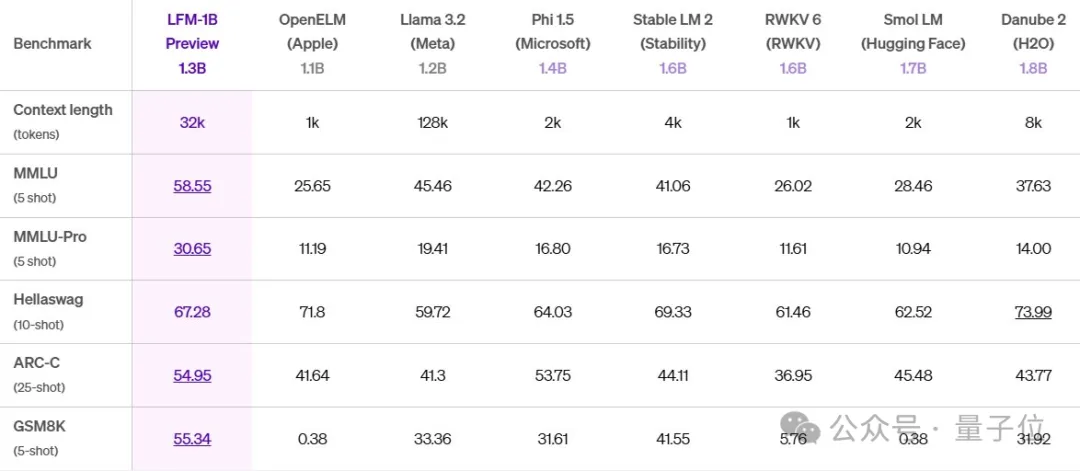

LFM 1.3B、LFM 3B兩個不同大小的模型,性能超越同等規(guī)模Llama3.2等Transformer模型。

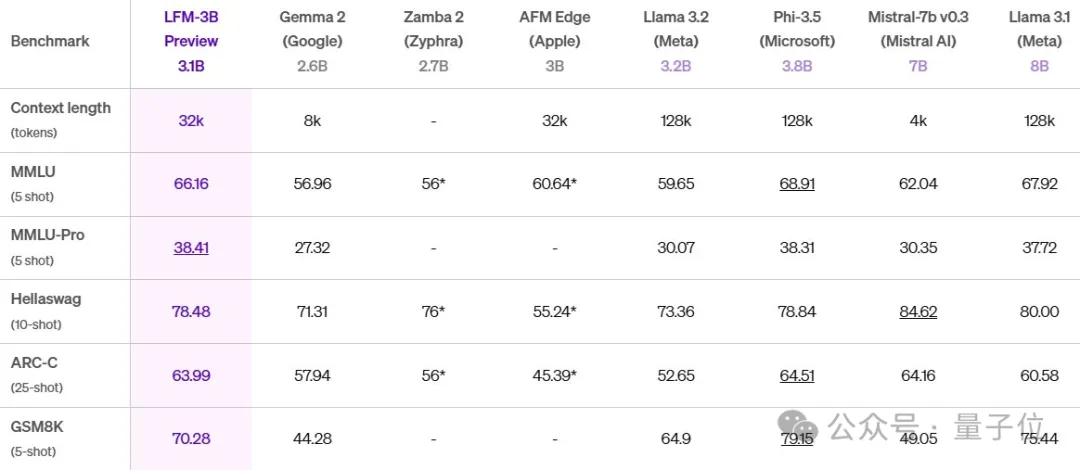

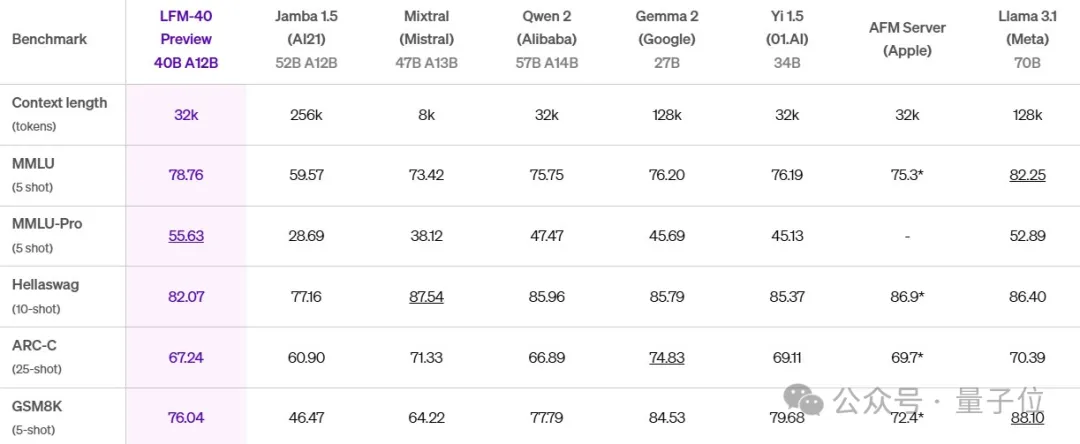

LFM架構還有很好的可擴展性,團隊還推出了基于MoE的LFM 40B(激活12B參數(shù)),能與更大規(guī)模的密集模型或MoE模型相媲美。

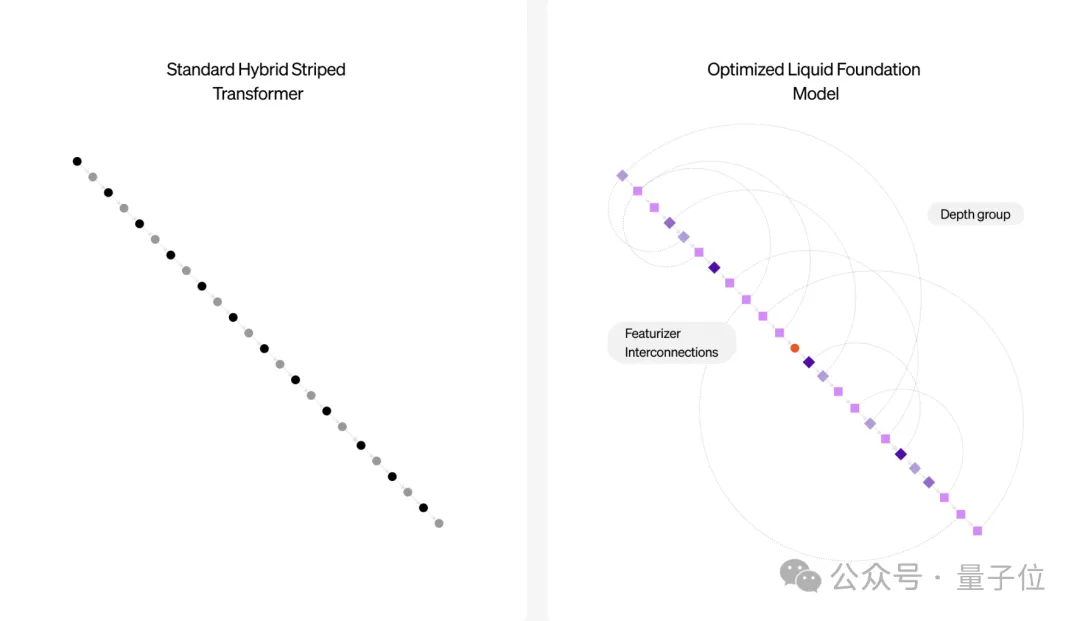

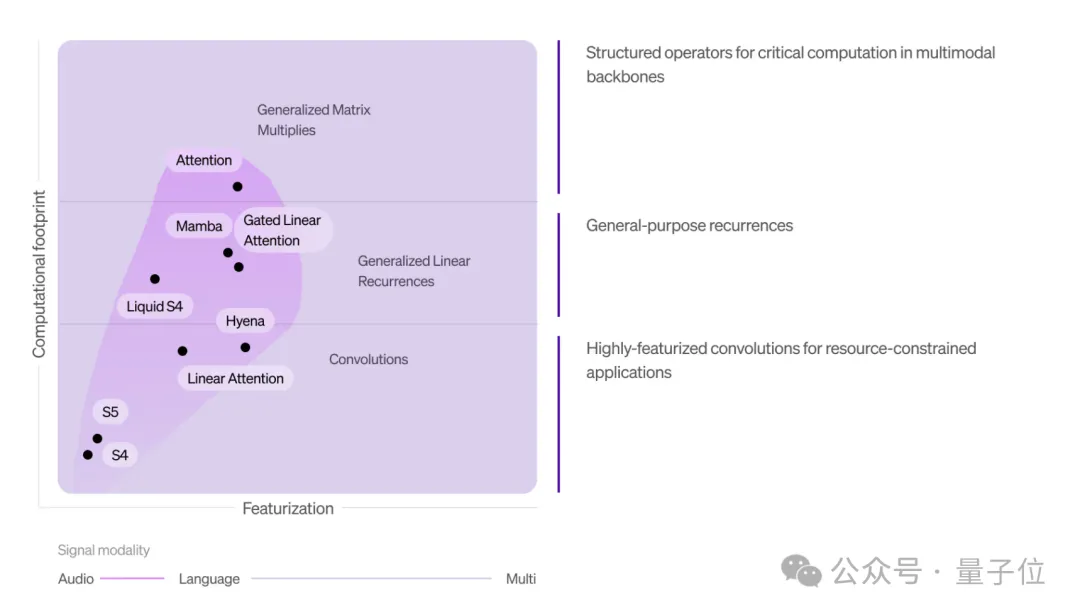

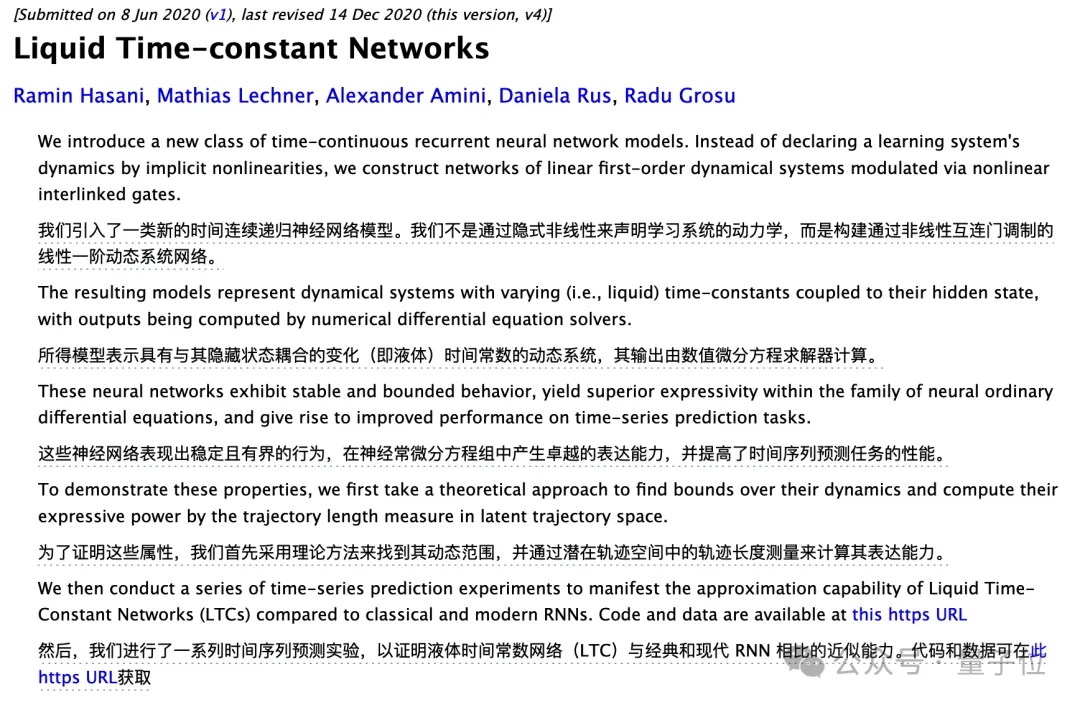

LFM用的是一種液態(tài)神經(jīng)網(wǎng)絡(LNN),從第一性原理出發(fā)而構建,其計算單元植根于動態(tài)系統(tǒng)理論、信號處理和數(shù)值線性代數(shù)。

這種架構還有一個特點:在內(nèi)存效率方面特別強。

基于Transformer的LLM中的KV緩存在長上下文中會急劇增長,而LFM即使在處理100萬個token時也能保持內(nèi)存最小。

小巧便攜,使得它能夠直接部署在手機上進行文檔和書籍等分析。

LFM模型背后是一支MIT計算科學與人工智能實驗室衍生出來的小團隊,名叫Liquid AI。

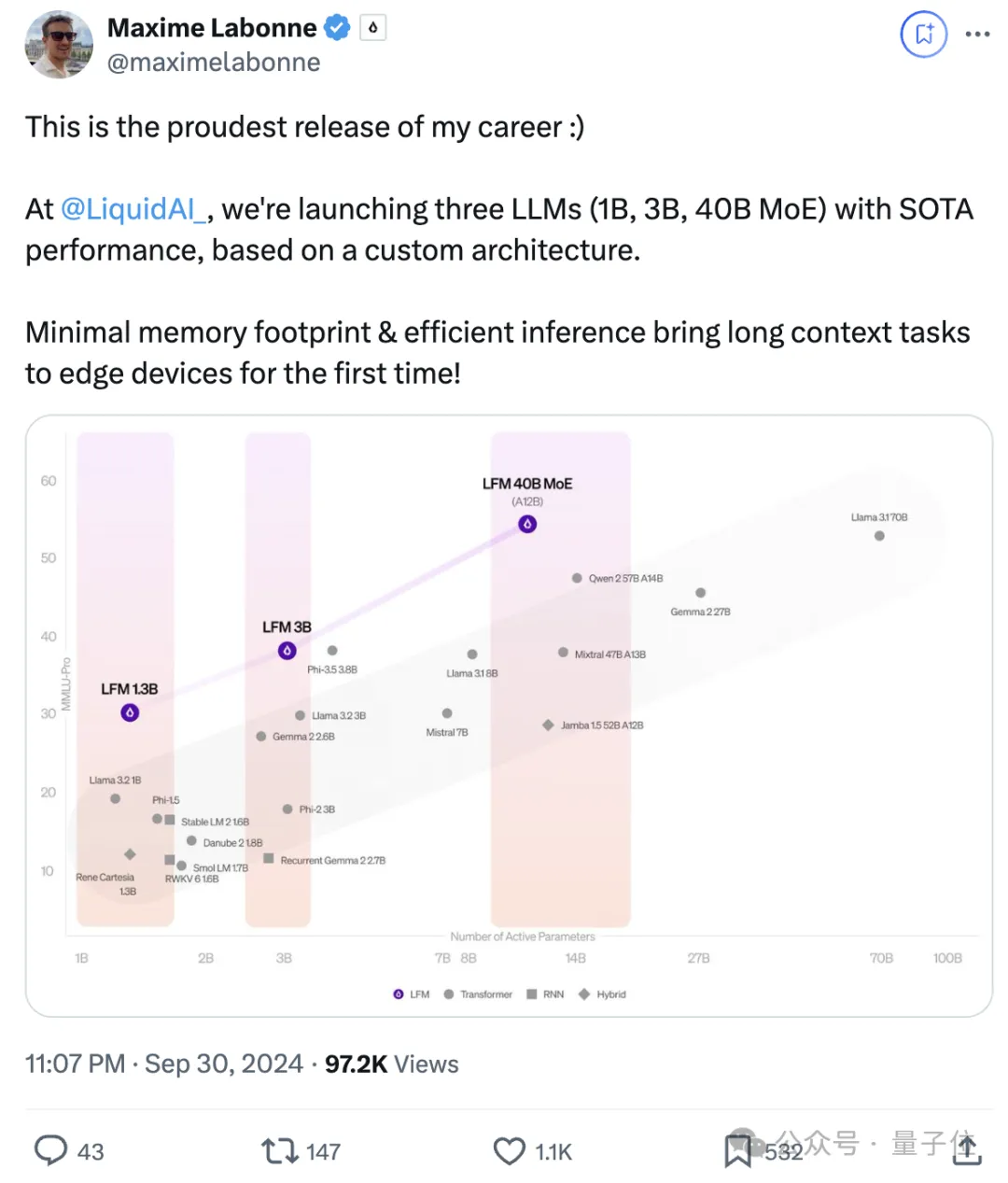

其后訓練負責人Maxime Labonne在X上為自家模型瘋狂打Call:

這三個具有SOTA性能的模型,是我職業(yè)生涯中最值得驕傲的版本。

AI暢銷書《人工直覺》作者也表示看好。

一直等的就是這樣的模型,基于物理學或神經(jīng)元的“第一性原理”

目前LFM系列模型還在預覽測試中,大伙兒可通過Liquid官方平臺、Lambda Chat、Perplexity AI來訪問。

基于液態(tài)神經(jīng)網(wǎng)絡打造

具體來看看這三個模型的性能和特點。

LFM 1.3B在MMLU、MMLU-Pro、ARC-C、GSM8K基準上相較于下表其它模型,取得SOTA性能。

LFM 3B,還能和Mistral 7B、Llama3.1 8B兩倍大模型打得有來有回。

LFM 40B性能也可與比其自身更大的模型相媲美,MoE架構可實現(xiàn)更高吞吐可部署在更具成本效益的硬件上。

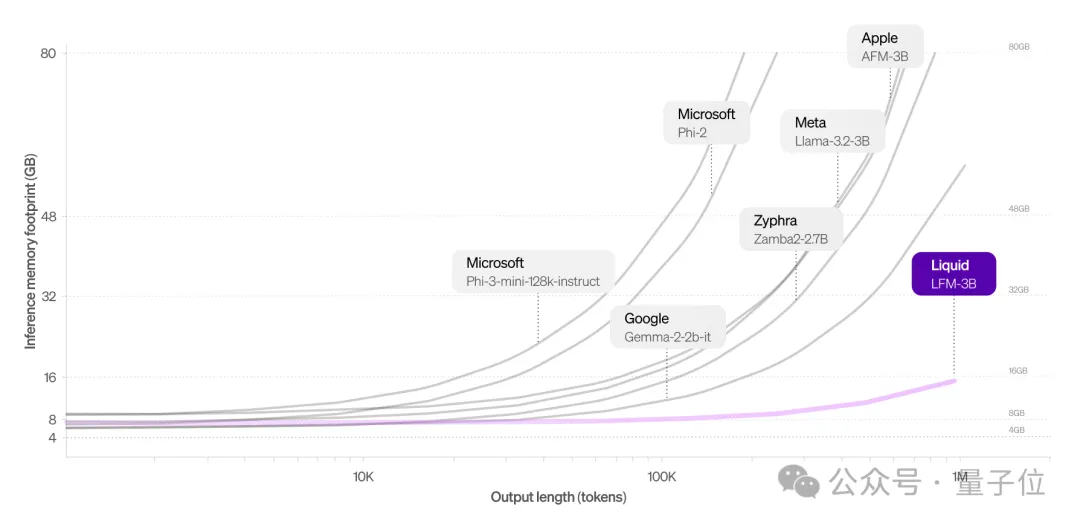

與Transformer架構相比,LFM的一個突出優(yōu)勢就是內(nèi)存占用更少。

對于長輸入效果更明顯,基于Transformer的LLM中的KV緩存隨著序列長度線性增長。通過有效壓縮輸入,LFM可以在同一硬件上處理更長的序列。

以下是LFM 3B與其它3B級模型的對比,LFM 3B能始終保持較小的內(nèi)存占用。

處理100萬個token,LFM 3B只需16 GB內(nèi)存,而Llama-3.2-3B模型則需48 GB+。

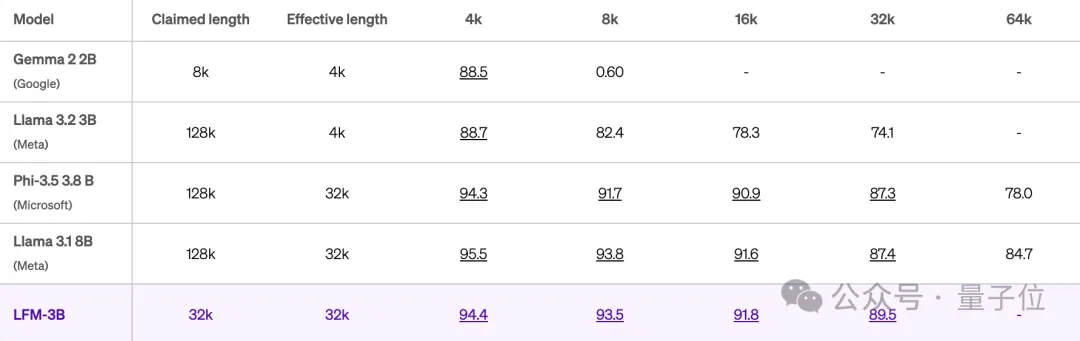

LFM上下文有效長度為32k。

當相應得分高于85.6時,長度被認為是“有效的”(Hsieh等人,2024 RULER)。

LFM 3B在32k的上下文長度上,仍能保持89.5的高分。

實驗結果中Llama 3.2生成128k上下文窗口,但實際只在4k上有效,也引起一波關注。

除此之外,LFM由結構化運算符組成,為基礎模型打開了一個新的設計空間。

不僅限于語言,還可以將其應用于音頻、時間序列、圖像等等其它模態(tài)。

還具有高適應性,可針對特定平臺(如蘋果、高通、Cerebras、AMD)優(yōu)化架構,或匹配給定的參數(shù)要求和推理緩存大小。

Liquid AI團隊直接把目前LFM模型的優(yōu)缺點都一一列了出來。

現(xiàn)在LFM語言模型擅長通用和專業(yè)知識、數(shù)學和邏輯推理、長上下文任務。

主要語言是英語,還支持西班牙語、法語、德語、中文、阿拉伯語、日語和韓語。

但LFM語言模型不擅長零樣本代碼任務、精確的數(shù)值計算、時效性信息,人類偏好優(yōu)化相關技術也尚未廣泛應用。

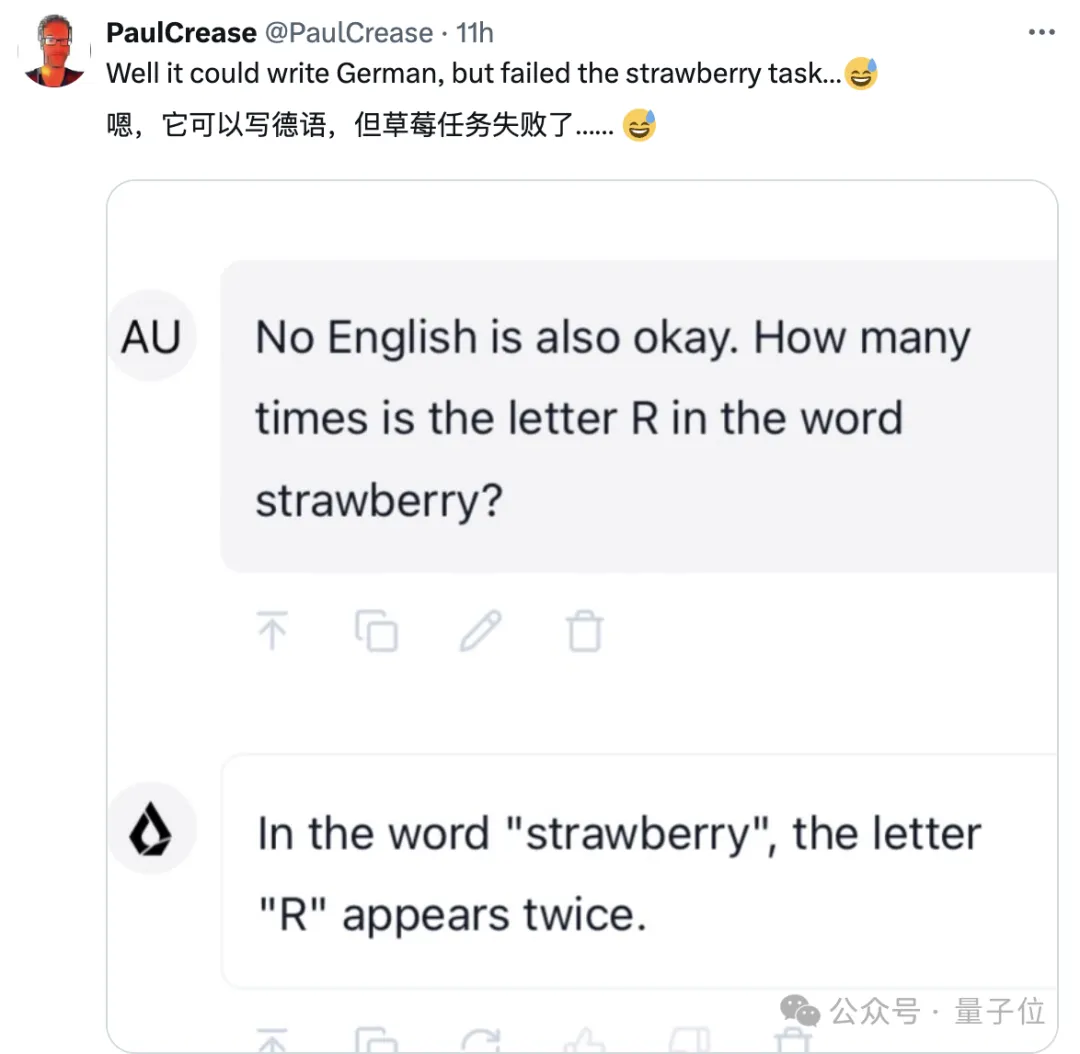

有意思的是,Liquid AI團隊還明確表示LFM現(xiàn)在不會數(shù)“Strawberry”中“r”的數(shù)量。

經(jīng)網(wǎng)友測試,它確實不會??。

關于LFM架構更多技術細節(jié),官方表示將持續(xù)發(fā)布技術Blog。

背后團隊來自MIT CSAIL

下面簡單介紹一下LFM模型背后團隊——Liquid AI。

Liquid AI是一家從MIT計算機科學與人工智能實驗室衍生出來的公司。

目標是在每一個規(guī)模上構建能力強大且高效的通用人工智能系統(tǒng)。

聯(lián)合創(chuàng)始人共有四位。

CEO Ramin Hasani,MIT CSAIL人工智能科學家、前Vanguard Group首席人工智能和機器學習科學家。

博士論文研究主題就是關于液態(tài)神經(jīng)網(wǎng)絡(Liquid Neural Networks),由維也納工業(yè)大學Radu Grosu教授和麻省理工學院Daniela Rus教授共同指導。

CTO Mathias Lechner,MIT CSAIL研究員。

維也納工業(yè)大學計算機科學的學士、碩士學位,奧地利科學與技術研究所(ISTA)博士學位。

專注于開發(fā)穩(wěn)健可信的機器學習模型。

首席科學官Alexander Amini,在MIT完成了計算機科學學士、碩士和博士學位,同時輔修數(shù)學。

研究的領域包括自主系統(tǒng)的端到端控制學習、神經(jīng)網(wǎng)絡的置信度公式化、人類移動性的數(shù)學建模以及復雜慣性精細化系統(tǒng)的構建。

另外一位聯(lián)合創(chuàng)始人是MIT CSAIL主任Daniela Rus,她還是MIT電氣工程與計算機科學系的Andrew&Erna Viterbi教授。

Liquid AI成立初就致力于從第一性原理出發(fā)構建新一代基礎模型,是一個基于深度信號處理和狀態(tài)空間層擴展語言模型的團隊。

之前研究有一籮筐:

感興趣的的家人們可以自行查閱:

https://www.liquid.ai/blog/liquid-neural-networks-research

對新模型感興趣的家人們可以測試起來了:

https://playground.liquid.ai/chat?model=cm1ooqdqo000208jx67z86ftk