ICLR 2025 | 讓大模型更懂時序的語境對齊來了!性能更優開銷更低

大語言模型在迅速發展的同時,也展現了其在下游任務中的卓越性能,這主要得益于豐富多樣的大型語料訓練庫,使大語言模型掌握了一定的跨領域、跨任務的知識。

近兩年,越來越多的研究工作利用預訓練的大語言模型來構建時間序列分析模型。通過微調大語言模型,使其能夠理解陌生的時序數據,進而激活其在時序分析任務中的能力。

近期,來自東方理工大學、香港理工大學和上海交通大學的研究團隊提出了一種新的模態對齊范式 —— 語境對齊(Context-Alignment)。該方法將時間序列數據對齊到大語言模型熟悉的語言環境中,幫助模型更好地理解時間序列,從而激活其在時序分析方面的能力。該論文已被 ICLR 2025 會議接收。

- 論文標題:Context-Alignment: Activating and Enhancing LLMs Capabilities in Time Series

- 論文鏈接:https://openreview.net/forum?id=syC2764fPc

- 代碼鏈接:https://github.com/tokaka22/ICLR25-FSCA

以往的微調方法往往依賴于一個詞庫,通過各種方式將時序數據的 token 嵌入與詞庫中的詞匯(例如 rise、fall、periodic、short 等)的 token 嵌入進行對齊,也就是說將大語言模型陌生的時序數據嵌入轉化為其熟悉的語言嵌入。此前研究希望通過這種「詞對齊」的方式幫助大語言模型理解時序數據,進而激活其在時序分析上的能力。

然而,這種依賴詞庫的對齊方式通常需要較大的計算開銷,且是否能有效地幫助大語言模型理解時序數據還有待商榷。

語境對齊(Context-Alignment)

本文指出,大語言模型在處理語言時的能力更多源于其對語言邏輯和結構的深刻理解,而不僅僅是對詞匯模式的表面對齊。因此,作者認為,即使使用精準的詞匯來表達冗長的時間序列數據,這種方式也只是大量詞匯嵌入的堆疊,缺乏語言的邏輯和結構,使得大語言模型難以真正理解其中的含義。

本文中,作者基于語言學中關于邏輯結構的層次關系,提出了語境對齊范式(Context-Alignment)。他們希望將時間序列數據融入自然語言的語境中,使大語言模型能夠將時序數據整體視為一個語言成分,并通過上下文自主地理解時間序列。

雙尺度語境對齊圖結構

考慮到圖結構往往可以很好地表達邏輯和結構的關系,作者在時序數據和自然語言 prompt 的多模態輸入上構建了雙尺度圖結構,以實現語境對齊。

具體來說,作者利用雙尺度的圖節點來描述語言結構的層次劃分,在保證信息不丟失的前提下,將冗長的時序數據表達為一個整體,這就好像英語中的賓語從句,從句整體充當了一個語言成分,冗長的時序數據也應該被視為輸入中的一個整體成分。利用有向邊表達時序和 prompt 輸入之間的邏輯關系。從而將時序數據對齊到大語言模型熟悉的語境中。

雙尺度圖結構包括細粒度圖結構和粗粒度圖結構,其中:

- 細粒度圖結構將每個 token 視為一個節點,強調 token 之間的相互獨立性,保留時序的具體信息。通過兩個線性層(如圖 1 中所示的

和

和 ),將連續且冗長的時序數據嵌入和 prompt 嵌入分別映射為兩種粗粒度節點。

),將連續且冗長的時序數據嵌入和 prompt 嵌入分別映射為兩種粗粒度節點。 - 粗粒度圖結構將連續的、模態一致的 tokens 映射為一個節點,表示了模態的整體性。

根據 prompt 的內容,在粗粒度和細粒度圖中構建表示邏輯關系的有向邊(有向邊表示信息的傳遞方向)。例如,當 prompt 為「predict future sequences using previous data」時,有向邊由表示「previous data」的時序節點指向 prompt 節點,因為時序數據是 prompt 的信息來源。粗粒度有向邊是細粒度有向邊的簡化。

雙尺度圖結構顯式地體現了時序數據和自然語言 prompt 之間的語言層級結構和邏輯傳遞關系。粗粒度圖結構和細粒度圖結構在經過圖卷積網絡(GCN)對節點嵌入進行更新后,通過一個可學習的交互機制(根據圖 1 中的 和分配矩陣計算,參考原文公式 4),使粗粒度節點能夠向細粒度節點傳遞更新后的信息,細粒度節點在完成自己的更新后整合來自粗粒度節點的信息。最后,粗粒度節點和細粒度節點嵌入將分別輸入預訓練的大語言模型。

和分配矩陣計算,參考原文公式 4),使粗粒度節點能夠向細粒度節點傳遞更新后的信息,細粒度節點在完成自己的更新后整合來自粗粒度節點的信息。最后,粗粒度節點和細粒度節點嵌入將分別輸入預訓練的大語言模型。

就其效果而言,該雙尺度圖結構可以嵌入至大語言模型的任意層,并可多次使用,以強化大語言模型對語境對齊的記憶能力。

圖 1 雙尺度語境對齊圖結構

圖 1 雙尺度語境對齊圖結構

VCA 和 FSCA

由于不同的 prompt 內容對應不同的邏輯結構關系,因此雙尺度語境對齊圖結構依賴于具體的 prompt 內容。作者提出了兩種使用雙尺度語境對齊圖結構的具體方法。

1. Vanilla Context-Alignment(VCA)

VCA 是最直接的實現方式,其輸入模式為時序數據 + prompt。例如,在預測任務中,prompt 為「predict future sequences using previous data」,其圖結構如圖 1 中的 VCA 所示。在分類任務中,輸入為「時序數據 + Predict category using previous data」,其圖結構與預測任務相同。VCA 利用最簡單直接的 prompt,通過雙尺度圖結構實現語境對齊。

2. Few-Shot Context-Alignment(FSCA)

FSCA 是 VCA 的進階版本,結合了 Few-Shot prompting 技術以進一步提升性能。該方法的輸入包括例子 + 時序數據 + prompt。在預測任務中,prompt 依然為「predict future sequences using previous data」,但需要將原始歷史時序數據分成兩部分構建一個例子:前半段數據作為后半段數據的歷史輸入,后半段數據作為利用前半段數據預測的 ground truth。這一示例有助于大語言模型更好地理解預測任務。其圖結構如圖 1 中的「FSCA in TS Forecasting」所示。

圖 2 展示了 FSCA 作為一個即插即用的模塊被引入到預訓練的大語言模型中進行微調。在分類任務中,FSCA 需要抽取一組時序數據和其對應的標簽構成一個固定的例子,再進行分類預測。其圖結構如圖 1 中的「FSCA in TS Classification」所示。

圖 2 利用 FSCA 進行時序預測

主要實驗結果

各種任務上的表現

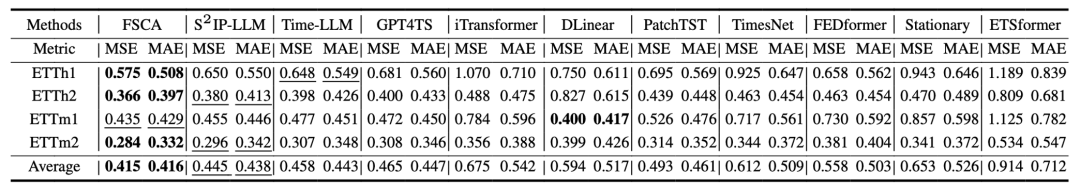

該研究展示了長期預測、短期預測、Few-Shot 預測、Zero-Shot 預測以及分類任務的實驗結果。

實驗表明,FSCA 在多個任務中均取得了更優的性能。尤其在 Few-Shot 預測和 Zero-Shot 預測中,FSCA 分別超越次優方法 6.7% 和 13.3%。FSCA 在 Few-Shot 和 Zero-Shot 預測任務中的出色表現表明,雙尺度圖結構成功引入了基于邏輯結構的先驗知識。這進一步驗證了正確的結構劃分和邏輯引導對于大語言模型(LLM)理解時序數據的重要性。

表 1 長期預測結果對比

表 2 短期預測結果對比

表 3 Few-shot 預測結果對比

表 4 Zero-shot 預測結果對比

圖 3 分類結果對比

計算效率對比

所提出的 FSCA 在計算效率方面僅次于 GPT4TS(該方法僅在 LLM 的輸入和輸出階段加入了線性層)。

相比之下,其他流行方法在實現詞 token 對齊時往往需要付出較大的計算代價。此外,這些方法通常包含額外的操作。例如,Time-LLM 在每次迭代中都會重復生成提示并檢索相應的嵌入,進一步增加了計算開銷。

相較而言,FSCA 中的雙尺度 GNN 僅引入了兩個可學習矩陣,以及兩個用于將細粒度節點嵌入轉化為粗粒度節點嵌入的可學習線性層。這些操作本質上是簡單的矩陣計算,極大地降低了計算復雜性。因此,FSCA 在計算效率上顯著優于以往基于詞 token 對齊的方法,在保證性能提升的同時有效減少了計算資源的消耗。

總結

綜上所述,本文首次提出了語境對齊(Context-Alignment)的概念,并基于雙尺度圖網絡結構和 Few-Shot prompting 技術設計了 FSCA 模型。與以往流行的基于詞 token 對齊的方法相比,FSCA 在實現更優性能的同時顯著降低了計算開銷。此外,原文還提供了更為詳盡的消融實驗、分析實驗和對比實驗結果,全面驗證了 FSCA 的有效性和優勢。