稚暉君的「好東西」揭曉!首個通用具身基座模型,機器人告別「看得懂做不來」

上周五,稚暉君在微博上預告,「下周有好東西發布」。

還沒進入「下周」多久,智元機器人的「好東西」揭曉了,還是雙重驚喜:Vision-Language-Latent-Action (ViLLA) 架構和通用具身基座大模型 GO-1。

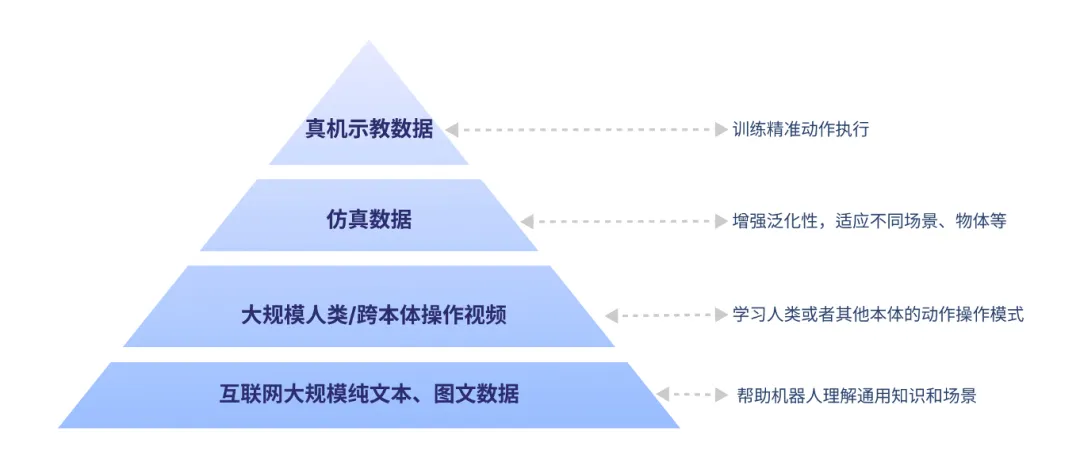

機器人訓練,苦數據難久矣。一方面是認知維度的數據:互聯網上海量的文本和圖片數據,幫助機器人建立基礎認知,理解世界是什么樣的。

另一方面是動作維度的數據,主要來源有人類的操作視頻、跨本體示范視頻、在虛擬場景中練習的仿真數據,還有機器人在實際環境中實操得來的真機示教數據。

智元機器人將機器人的訓練數據劃分為四個層次

然而現有的 VLA(Vision-Language-Action)架構,主要依賴真機和合成數據。

我們每天刷的短視頻有很多可供機器人學習的操作,但不能直接用,需要「翻譯」成機器人能理解的語言。

因此,機器人很難做到看完人類的視頻教程,腦子學會了,手學會了,直接上手做好了。

沒有充分激活人類 / 跨本體操作視頻數據這個寶貴的數據來源,機器人迭代的成本更高,進化的速度也更慢了。

那么,怎樣的架構才能充分利用好這些數據呢?

智元提出了全新的 Vision-Language-Latent-Action (ViLLA) 架構。

與 VLA 架構相比,ViLLA 通過預測 Latent Action Tokens(隱式動作標記),讓機器人能夠將人類動作視頻轉化為自己可執行的動作序列。這樣,機器人就能同時獲得認知和動作兩個維度的訓練,既知其然,也知其所以然。

這樣一來,機器人也能有效利用高質量的 AgiBot World 數據集以及互聯網上廣泛的視頻數據,增強策略的泛化能力。

基于 ViLLA 架構,智元打造了通用具身基座大模型 ——GO-1。它由 VLM (語言視覺模型) 和 MoE (專家混合模型) 組成。它整合了視覺、語言、動作、觸覺等多模態輸入,規劃具體動作,直接輸出機器人的動作執行序列。

舉個例子來說,你告訴機器人去掛衣服,GO-1 會指導機器人理解任務要求,分解動作步驟,適應具體環境,最終執行操作。

但在更深的技術面,這是因為 GO-1 大模型融會貫通了機器人訓練數據的四個層次:

在訓練階段,學習了互聯網的大規模純文本和圖文數據,所以能理解「掛衣服」在此情此景下的含義和要求。

學習過人類操作視頻和其他機器人的各種操作視頻,所以能知道掛衣服通常包括哪些環節。

學習過仿真的不同衣服、不同衣柜、不同房間,模擬過掛衣服的操作,所以能理解環節中對應的物體和環境并打通整個任務過程。

又因為學習過真機的示教數據,所以機器人能精準完成任務。

這樣一來,GO-1 大模型可以幫助機器人完成全面的「基礎教育」和「職業教育」,讓機器人具備強大的遷移學習能力。面對新場景時,機器人既有基本常識,又能根據多種多樣的環境和物體,快速上手新操作。

- 論文鏈接:https://agibot-world.com/blog/agibot_go1.pdf

GO-1:VLA 進化到 ViLLA

與 Vision-Language-Action (VLA) 架構相比,ViLLA 通過預測 Latent Action Tokens (隱式動作標記),彌合圖像 - 文本輸入與機器人執行動作之間的鴻溝。在真實世界的靈巧操作和長時任務方面表現卓越,遠遠超過了已有的開源 SOTA 模型。

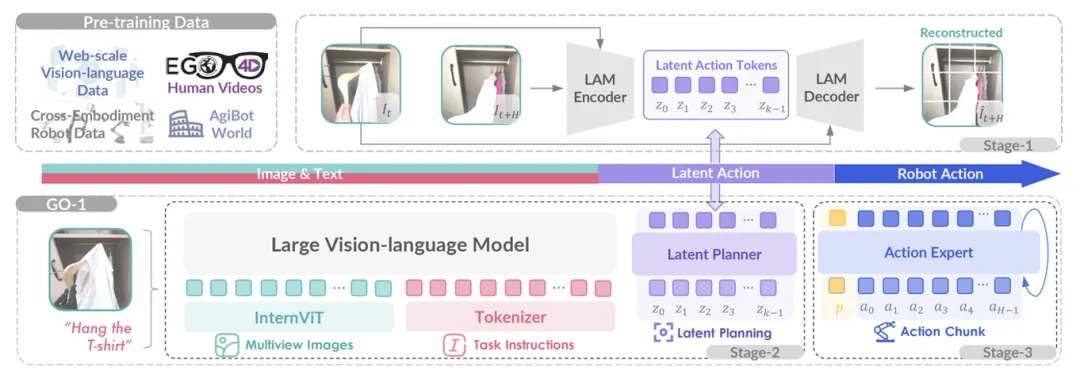

ViLLA 架構是由 VLM (多模態大模型) + MoE (混合專家) 組成,其中 VLM 借助海量互聯網圖文數據獲得通用場景感知和語言理解能力,MoE 中的 Latent Planner (隱式規劃器) 借助大量跨本體和人類操作數據獲得通用的動作理解能力,MoE 中的 Action Expert (動作專家) 借助百萬真機數據獲得精細的動作執行能力。

在推理時,VLM、Latent Planner 和 Action Expert 三者協同工作:

- VLM 采用 InternVL-2B,接收多視角視覺圖片、力覺信號、語言輸入等多模態信息,進行通用的場景感知和指令理解

- Latent Planner 是 MoE 中的一組專家,基于 VLM 的中間層輸出預測 Latent Action Tokens 作為 CoP (Chain of Planning,規劃鏈),進行通用的動作理解和規劃

- Action Expert 是 MoE 中的另外一組專家,基于 VLM 的中間層輸出以及 Latent Action Tokens,生成最終的精細動作序列

Latent Planner 和 Action Expert 是這個 MoE 框架里的 2 個關鍵構成:

Latent Planner(隱式規劃器)

盡管 AgiBot World 數據集已經是全球最大的機器人真機示教數據集,但這樣高質量帶動作標簽的真機數據量仍然有限,遠少于互聯網規模的數據集。

為此,智元采用 Latent Actions(隱式動作)來建模當前幀和歷史幀之間的隱式變化,然后通過 Latent Planner 預測這些 Latent Actions,從而將異構數據源中真實世界的動作知識轉移到通用操作任務中。

- Latent Action Model(LAM,隱式動作模型)主要用于獲取當前幀和歷史幀之間 Latent Actions 的 Groundtruth(真值),它由編碼器和解碼器組成。其中

- 編碼器采用 Spatial-temporal Transformer,并使用 Causal Temporal Masks(時序因果掩碼)。

- 解碼器采用 Spatial Transformer,以初始幀和離散化的 Latent Action Tokens 作為輸入。

- Latent Action Tokens 通過 VQ-VAE 的方式進行量化處理。

- Latent Planner 負責預測這些離散的 Latent Action Tokens,它與 VLM 主干網絡共享相同的 Transformer 結構,但使用了兩套獨立的 FFN (前饋神經網絡) 和 Q/K/V/O (查詢、鍵、值、輸出) 投影矩陣。Latent Planner 這組專家會逐層結合 VLM 輸出的中間信息,通過 Cross Entropy Loss(交叉熵損失)進行監督訓練。

Action Expert(動作專家)

為了實現 High-frequency(高頻率)且 Dexterous(靈活)的操控,智元引入了 Action Expert,其采用 Diffusion Model 作為目標函數來建模低層級動作的連續分布。

- Action Expert 結構設計上與 Latent Planner 類似,也是與 VLM 主干網絡共享相同的 Transformer 結構,但使用兩套獨立的 FFN 和 Q/K/V/O 投影矩陣,它通過 Denoising Process(去噪過程)逐步回歸動作序列。

- Action Expert 與 VLM、Latent Planner 分層結合,確保信息流的一致性與協同優化。

GO-1 首個通用具身基座模型

而 GO-1 基于 ViLLA架構。具體來說,VLM 作為通用具身基座大模型的主干網絡,繼承開源多模態大模型 InternVL2.5-2B 的權重,利用互聯網大規模純文本和圖文數據,讓 GO-1 大模型具備了通用的場景感知和理解能力。

隱動作專家模型作為第一個專家模型,是 GO-1 大模型中隱式的規劃器,它利用到了大規模人類操作和跨本體操作視頻,讓模型具備動作的理解能力。

GO-1 大模型的最后是作為動作預測器的動作專家模型,它利用高質量的仿真數據、真機數據,讓模型具備了動作的精細執行能力。

作為通用具身基座大模型,GO-1 實現了四項突破:

- 人類視頻學習:GO-1 大模型可以結合互聯網視頻和真實人類示范進行學習,增強模型對人類行為的理解,更好地為人類服務。

- 小樣本快速泛化:GO-1 大模型具有強大的泛化能力,能夠在極少數據甚至零樣本下泛化到新場景、新任務,降低了具身模型的使用門檻,使得后訓練成本非常低。

- 一腦多形:GO-1 大模型是通用機器人策略模型,能夠在不同機器人形態之間遷移,快速適配到不同本體,群體升智。

- 持續進化:GO-1 大模型搭配智元一整套數據回流系統,可以從實際執行遇到的問題數據中持續進化學習,越用越聰明。

實驗結果

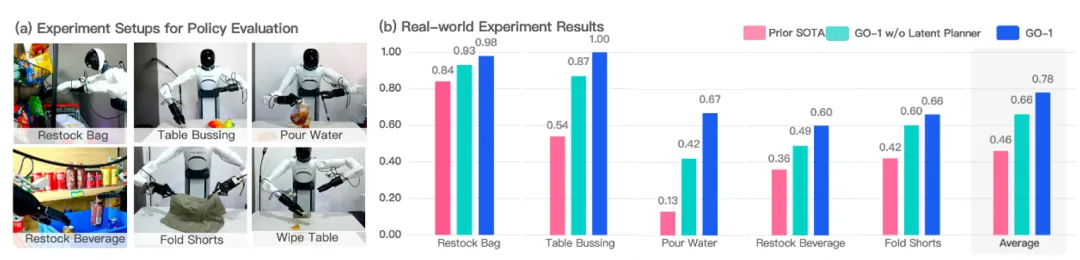

通過 Vision-Language-Latent-Action (ViLLA) 創新性架構,研究團隊在五種不同復雜度任務上測試 GO-1。

相比已有的最優模型,GO-1 成功率大幅領先,平均成功率提高了 32%(46%→78%)。其中 GO-1 在倒水(Pour Water)、清理桌面(Table Bussing) 和補充飲料( Restock Beverage) 任務表現尤為突出。

此外,他們還對 Latent Planner 進行了消融實驗,可以看到增加 Latent Planner 可以提升 12% 的成功率 (66%→78%)。

在破解機器人訓練的數據難題上,智元始終秉持開源精神,推動業界共享。

去年 12 月,智元面向全球開源了 AgiBot World 數據集大規模訓練數據集,這是首個基于真實場景和全棧硬件的平臺所采集的百萬級機器人數據集。今年 2 月,智元開源了 AgiBot Digital World 仿真數據集,還可以提供多元化的專家軌跡生成策略。

如今,隨著 ViLLA 架構與 GO-1 大模型的重磅發布,機器人不僅擁有了海量真實和仿真數據,更具備了快速學習的遷移能力,讓機器在拓展了運動能力之外,更加具備了 AI 的能力,作業能力,是讓機器具備了真正的價值。

相信機器人將能更好地適應千變萬化的現實環境,向著具備通用智能的自主體發展,在商業、工業、家居等多個領域大展身手。