告別Transformer,重塑機器學習范式:上海交大首個「類人腦」大模型誕生

本文一作趙海,上海交通大學計算機學院長聘教授、博士生導師,上海交通大學通用人工智能(AGI)研究所所長。研究興趣:自然語言處理、人工智能和大模型。據 MIT 主辦的世界大學計算機學科排行榜 csrankings 數據統計,上海交通大學計算機學科排名國內第三,趙海教授在其中的 AI 和 NLP 方向的論文貢獻度第一,占整個交大標準發表總量 1/4。Google Scholar 引用 11900 次。2022、2023、2024 年,連續入選愛思唯爾高被引學者。

本文二作伍鴻秋,趙海教授 2020 級博士生;本文三作楊東杰,趙海教授 2022 級博士生;本文四作鄒安妮,趙海教授 2022 級碩士生;本文五作洪家樂,趙海教授 2024 級碩士生。

當前 GPT 類大語言模型的表征和處理機制,僅在輸入和輸出接口層面對語言元素保持可解釋的語義映射。相比之下,人類大腦直接在分布式的皮層區域中編碼語義,如果將其視為一個語言處理系統,它本身就是一個在全局上可解釋的「超大模型」。

因此,為了解決現有基于 Transformer 大模型的三個主要缺陷:算力需求高、不可解釋性的黑箱、上下文規模受限,上海交通大學團隊剛剛發布首個宏觀模擬人類大腦全局機制的大語言模型 BriLLM,脫離了傳統 Transformer 架構的限制,以腦科學神經系統為靈感,用受大腦啟發的動態信號傳播替代了基于注意力的架構。

- Github 地址:https://github.com/brillm05/BriLLM0.5

- 論文地址:https://arxiv.org/pdf/2503.11299

- 模型權重:https://huggingface.co/BriLLM/BriLLM0.5

突破 Transformer:模擬人腦學習機制

以 Transformer 為主流的當代大模型架構存在一些明顯的局限性:

- 算力黑洞:Transformer 的自注意力機制本質上是平方級別(O (n2))的時間與空間復雜度,處理更長的上下文時,模型的計算開銷將隨輸入長度的平方增長。

- 黑箱困境: Transformer 在輸入和輸出層可視化方面有一定的可解釋性,但其中的中間層邏輯仍像黑盒子一樣缺乏機制透明度。

- 上下文枷鎖:模型參數量必須隨上下文擴展,隨著所支持的上下文長度的增長,模型的體量也會呈平方幅度增長,無法像人腦一樣隨時調動記憶。

「人類大腦無需擴容就能處理終身記憶,這才是 AGI 該有的樣子!」論文一作趙海教授指出。趙海團隊的設計靈感來源于腦科學的兩項關鍵發現:

靜態語義映射

大腦皮層區域分工明確,Nature 2016 論文的研究顯示,語言元素的語義特征分布在整個大腦皮層,不同的皮層區域會編碼特定的語義內容,而且這種組織方式在不同個體之間具有一致性。比如,當人們思考 「房子」 的時候,大腦中會激活與 「房子」 概念相關的特定區域。

動態電信號傳導

人的決策過程依賴于神經通路中不斷變化的電信號流動 —— 即便同樣的輸入,信號路徑和強度也會根據語境與任務需求而變化。

受此啟發,趙海團隊提出了一種全新的機器學習機制 ——SiFu(Signal Fully-connected Flowing)學習機制。他們在此基礎上構建了 BriLLM 模型,這是第一個在計算層面上模擬人腦全局工作機制的語言模型。

BriLLM 模型突破了傳統 Transformer 架構的限制,這是一種基于有向圖的神經網絡設計,使得模型中所有節點都具備可解釋性,而非像傳統模型那樣僅在輸入輸出端具有有限的解釋能力。模型內部的信號流傳導遵循 「最小阻力原則」,模擬大腦信息流動的方式,不僅提升了模型的效率,也增強了其解釋性。

在類腦計算領域,spike 脈沖神經網絡是神經網絡類腦化改造的重要方法之一,它是在神經元激活方式上做了局部微觀的類腦改進。為了和這樣脈沖改進的類腦 GPT 大模型區分開來。趙海教授團隊將 BriLLM 稱之為「原生類腦大模型」,以體現 BriLLM 在宏觀上對于人腦的計算模擬。

三大顛覆性創新,重新定義 LLM 底層邏輯

信號全連接流動(SiFu)機制

- 類人腦架構:全連接有向圖,節點之間具備雙向連接,每個詞元分配專屬節點。

- 動態決策:信號沿「最小阻力路徑」流動,可根據節點相關性調節信號強度,實時生成預測結果。

在 SiFu 中,信號傳遞取代了傳統機器學習中的核心預測操作,就像神經電信號在突觸間跳躍,最終激活目標神經元的過程。

SiFu 有向圖的示意圖(節點旁的數字表示能量分數)

無限上下文處理

預測過程通過節點間的信號傳播實現。由于信號可以自由流動于網絡各節點之間,因此序列預測理論上支持任意長的上下文輸入,且不依賴于模型的規模擴展。

也就是說,模型參數完全獨立于序列長度,并且長上下文無需增加參數量。

這和人腦的功能優勢相似,并不因為需要學習記憶大量知識而就必須擴充模型容量。

100% 可解釋

- 全模型可解釋:用戶可定義的實體(如概念、token 或其他可解釋單元)可直接映射到圖中的特定節點,實現端到端全面的可解釋性。

- 推理全流程可解釋:既然每一個節點可解釋、可理解,而決策預測過程在節點間通過信號傳播進行,因此決策過程同樣透明。

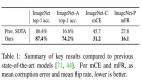

性能對標初代 GPT

盡管作為概念驗證的初代模型(2B/1B 參數)未追求規模,但實驗表現穩定,展現全新大語言模型的全流程鏈路已經打通。

團隊發布了 BriLLM-Chinese 和 BriLLM-English 兩個版本:

- 中文版 20 億參數(稀疏訓練后僅占原理論參數 13%)

- 英文版 10 億參數(稀疏率 94.3%)

受到大腦神經通路復用的啟發,BriLLM 利用「低頻詞元邊共享」的方法,讓參數規模降低 90%:

大多數二元組(bigram)很少出現甚至未出現,因此允許對不活躍邊共享參數。對于這些低頻二元組,采用一個固定且不更新的矩陣,從而將模型大小縮減至中文版本約 20 億參數、英文版約 10 億參數,分別僅占原模型規模的 13.0% 和 5.7%。這不僅減少了參數量近 90%,同時也顯著加速了訓練過程。

這為經濟實用的千億級腦啟發模型鋪平道路。按照這個稀疏比率,當 BriLLM 的 token 詞表擴展到目前 GPT-LLM 同等程度的 4 萬時候(當前為 4000),預期的模型參數量將在 100-200B(1000-2000億參數)。全詞表的 BriLLM 并不比目前 SOTA 的 GPT-LLM 更大。但是請注意,BriLLM 不會有 GPT-LLM 那種隨著輸入上下文增長而必須進行模型擴張的問題,因為前者天然支持無限長物理上下文,并和模型規模擴張解耦。即,模型規模不變情況下,物理支持任意長上下文。

BriLLM 的架構

展望:多模態 + 具身智能的終極形態

BriLLM 的「節點 - 信號」設計以及全模型可解釋性天生支持多模態融合:

模型中的節點不僅限于表示語言 token,還可以映射多種模態的單元。引入新模態時,只需為其定義對應的節點,無需從頭訓練模型 —— 這與依賴輸入 / 輸出界面對齊的傳統大語言模型截然不同,例如:

- 添加視覺節點:直接處理圖像語義

- 添加聽覺節點:整合聲音信號流

- 添加具身交互節點:環境輸入與實時驅動信號傳播

「這將是首個能真正模擬感知 - 運動整合的通用框架。」團隊透露,下一步將向實現多模態腦啟發 AGI 的方向努力。

簡而言之,BriLLM 提出了全新的語言模型架構、全新的動態信號驅動的生成式人工智能任務框架以及首個對人類大腦核心表達與功能機制的宏觀全局尺度計算模擬的模型。

本項目已進入選上海交通大學「交大 2030」計劃 2025 年度重點項目資助。該重點項目每年全校動用雙一流建設經費僅資助五項,額度 500 萬。按照「交大 2030」計劃的官方指南明確,它只資助顛覆性從 0 到 1 的創新、世界級的基礎研究。