三分鐘看懂ChatGPT技術原理

1. 引言與目標

本文旨在為普通觀眾提供大型語言模型(如ChatGPT)的全面介紹。

目標是建立理解LLM的"心智模型",解釋其工作原理、優勢與局限。

LLM既有神奇之處,也有明顯缺陷和"尖銳邊緣"(潛在風險)需警惕。

核心問題:輸入框背后的機制是什么?用戶應如何有效提問?模型如何生成回復?

將逐步拆解LLM構建流程,同時探討其認知心理學意義。

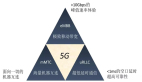

2. 預訓練階段(Pre-training)

預訓練是構建LLM的第一步,核心是"下載并處理互聯網"。

數據集代表(如Hugging Face的FineWeb)約44TB,經多階段過濾(URL過濾、文本提取、語言分類、去重、PII移除)。

高質量文檔需滿足:海量、高質、多樣性。

原始文本需轉化為 一維符號序列 ,通過 分詞(Tokenization) 壓縮序列長度(例如GPT-4使用100,277個符號)。

BPE算法(Byte Pair Encoding) 通過合并高頻字節對優化序列效率。

神經網絡訓練目標: 預測序列中下一個符號的概率 (輸入為token窗口,輸出為概率分布)。

訓練本質:調整網絡參數,使預測匹配訓練數據的統計規律。

計算成本極高(例如GPT-2訓練曾耗資,現可降至100)。

3. 基礎模型(Base Model)與推理(Inference)

預訓練產出 "基礎模型"——本質是"互聯網文檔的符號模擬器" 。

推理過程: 基于前綴符號序列,按概率分布采樣生成后續符號 (類似"加權擲骰子")。

基礎模型非對話助手,僅能生成類互聯網文本的"混音"(remix) 。

模型知識存儲于參數中,是"模糊記憶"而非精確數據庫 ,易產生 幻覺(Hallucination) 。

示例:基礎模型(如Llama 3.1 405B)可硬編碼提示模擬助手,但本質仍是符號補全。

4. 監督微調階段(Supervised Fine-Tuning, SFT)

目標:將基礎模型轉化為"助手"(如ChatGPT)。

方法:替換預訓練數據集為人工標注的"對話數據集" (例如InstructGPT、UltraChat)。

對話需編碼為 一維符號序列 (例如OpenAI使用<|im_start|>等特殊符號區分角色)。

標注員(Labeler)依據公司編寫的"標注指南"生成理想回復 (例如"有益、真實、無害"原則)。

SFT模型本質是"標注員的統計模擬" ,其知識、風格、能力邊界均由訓練數據定義。

計算成本遠低于預訓練 (例如SFT僅需數小時)。

5. LLM心理學與認知缺陷

幻覺根源:SFT訓練數據中"提問-答案"模式鼓勵模型自信回復,即使其內部不確定。

緩解方法:

? 知識邊界探測: 添加"我不知道"示例至訓練集(如Meta Llama 3方案)。

? 工具使用(Tool Use): 引入搜索、代碼解釋器等工具, 將外部信息注入上下文窗口(工作記憶) 。

上下文窗口(Context Window)是模型的"工作記憶" ,參數知識則是"長期模糊記憶"。

模型不具"自我":自我描述(如"我是ChatGPT")由SFT數據或系統消息硬編碼實現。

計算瓶頸:每符號生成僅固定計算量, 復雜任務需跨多符號分配計算 (如數學分步推理)。

分詞限制:模型處理字符級任務(如拼寫、計數)能力弱,因世界基于符號而非字符。

能力不均衡:模型呈"瑞士奶酪"能力分布——精通專業領域,但可能在簡單問題(如9.11 > 9.9?)出錯。

6. 強化學習階段(Reinforcement Learning, RL)

目標:超越模仿人類(SFT),讓模型自主發現高效解決方案。

可驗證領域(如數學、代碼):

? 方法:生成多個解決方案,獎勵正確結果對應的符號序列 (如DeepSeek-R1)。

? 涌現特性:模型自發產生"思維鏈"(Chain-of-Thought) ,通過回溯、多視角驗證提升準確率。

? RL模型能超越人類策略 (類比AlphaGo的"第37步")。

不可驗證領域(如創意寫作):

? 人類反饋強化學習(RLHF): 訓練獎勵模型(Reward Model)模擬人類偏好排序,替代人工評分。

? 局限:獎勵模型可被"對抗樣本"欺騙,RLHF非真正RL,僅是有限微調。

RL與SFT關系: SFT提供初始策略,RL通過實踐優化。

RL模型代表(如GPT-4o "Advanced Reasoning"): 需訂閱或使用開源模型(DeepSeek-R1)。

7. 未來方向與資源

多模態(Multimodality): 文本、音頻、圖像統一符號化處理是趨勢。

智能體(Agents): 模型將能執行長期任務(需人類監督)。

測試時訓練(Test-Time Training): 突破固定參數限制是關鍵挑戰。

資源推薦:

? 排行榜:lmsys.org(動態評估模型性能)。

? 新聞:ainewsletter.com(全面AI動態摘要)。

模型獲取:

? 商業助手:OpenAI Chat, Google Gemini, Anthropic Claude。

? 開源模型:Together AI(推理平臺), Hyperbolic(基礎模型), LM Studio(本地運行)。

8. 總結與本質

LLM三大訓練階段類比人類學習:

? 預訓練 = 閱讀教材(知識積累)

? SFT = 學習例題(模仿專家)

? RL = 練習習題(自主解題)

ChatGPT本質: 用戶輸入被編碼為符號序列,模型續寫符號生成回復。

回復來源: SFT模型是"OpenAI標注員的統計模擬",RL模型則包含"自主發現的推理策略"。

核心提示:

? 始終將LLM視為工具(非可信賴代理),驗證其輸出。

? 參數知識是"模糊記憶",工具提供"精確工作記憶"。

? 能力呈"瑞士奶酪"分布——強大但不均衡。

關鍵觀點總結:

- LLM既有神奇之處,也有明顯缺陷和"尖銳邊緣"(潛在風險)需警惕。

- 預訓練是構建LLM的第一步,核心是"下載并處理互聯網"。

- 高質量文檔需滿足:海量、高質、多樣性。

- BPE算法(Byte Pair Encoding)通過合并高頻字節對優化序列效率。

- 訓練本質:調整網絡參數,使預測匹配訓練數據的統計規律。

- 基礎模型非對話助手,僅能生成類互聯網文本的"混音"(remix)。

- SFT模型本質是"標注員的統計模擬"。

- 幻覺根源:SFT訓練數據中"提問-答案"模式鼓勵模型自信回復,即使其內部不確定。

- 上下文窗口(Context Window)是模型的"工作記憶"。

- RL模型能超越人類策略(類比AlphaGo的"第37步")。

- 獎勵模型可被"對抗樣本"欺騙,RLHF非真正RL,僅是有限微調。