2024年AI代理的突破:CoAgents如何引領人機協同新潮流? 原創

01 概述

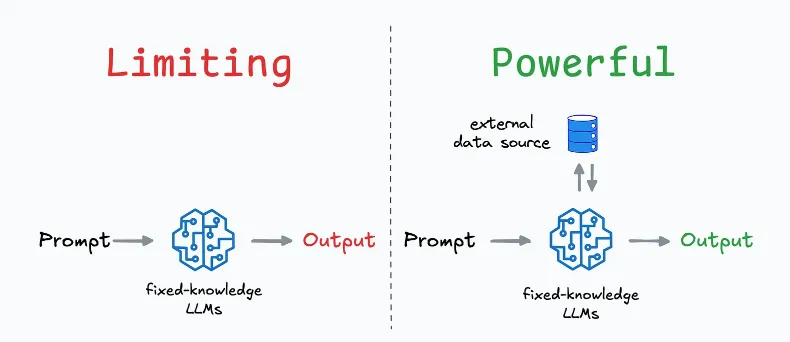

現代大型語言模型(LLMs)的規模和能力,讓我們僅僅將它們用于文本摘要、文本補全、代碼補全等普通任務,似乎有些局限。它們的真正潛力在于圍繞這些模型構建系統,讓它們能夠:

- 訪問、檢索和過濾相關來源的數據,

- 分析和處理這些數據以做出實時決策等。

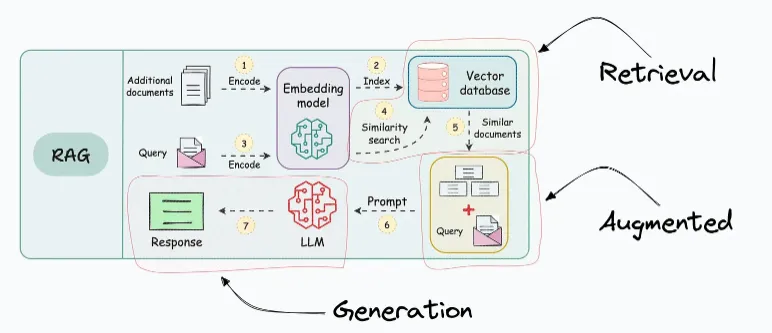

RAG(Retrieval-Augmented Generation)是構建此類復合AI系統的一個重要步驟:

但RAG遵循程序化流程(作為程序員,您定義步驟、要搜索的數據庫、要檢索的上下文等),它并未完全釋放出這些復合AI系統所期望的自主性。

因此,2024年的主要焦點是構建AI代理——能夠推理、思考、規劃、確定相關來源并在需要時從中提取信息、采取行動,甚至在出現問題時自我修正的自主系統。

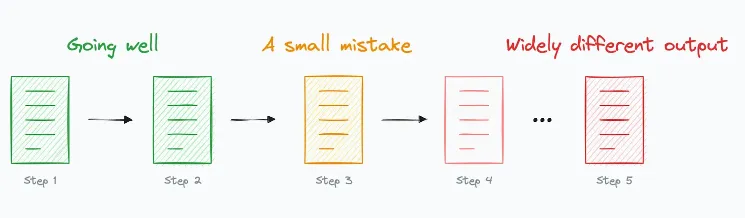

雖然這聽起來很有前景,但目前的問題是:

- 我們離構建完全自主的AI代理還有很長的路要走。

- 更具體地說,當代理需要執行一個包含多個步驟的復雜任務時,過程中的一個小錯誤就會使整個操作脫軌。

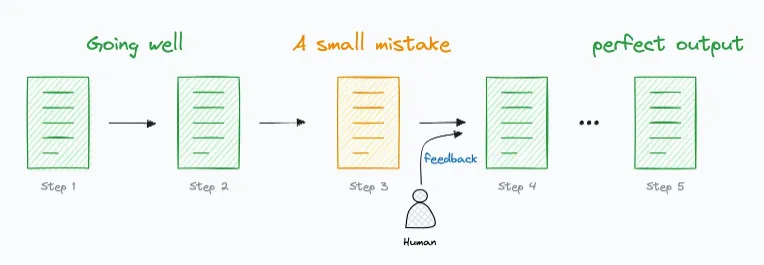

為了避免這種情況,它們需要反饋機制,例如人機協同(HITL),以指導它們完成步驟(IBM在這篇博客中對此進行了廣泛討論)。

顧名思義,人機協同工作流程結合了AI代理和人類的力量。

CoAgents是由CopilotKit開發的全開源解決方案,提供了構建此類工作流程所需的所有基礎設施。

02 CoAgents

CoAgents的核心驅動力是LangGraph,這是一個使用圖結構定義、協調和執行LLM代理的框架。

CoAgents更進一步,提供了將LangGraph與HITL工作流程連接起來構建更可靠AI代理的所有功能。

以下是一些關鍵特性:

1) 流式中間代理狀態

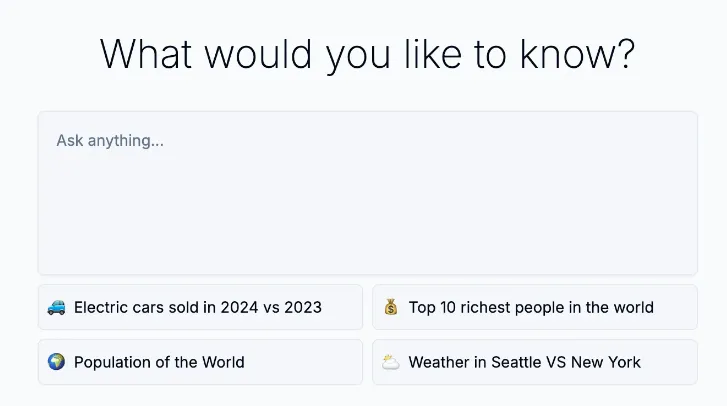

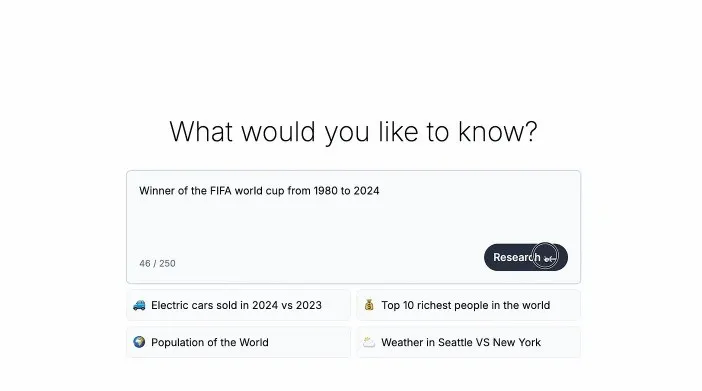

使用CoAgents,可以在代理執行提示時,將其中間狀態流式傳輸到應用程序UI。

這樣,用戶就可以看到代理在后端正在做什么,并驗證它是否正在采取正確的步驟,而不僅僅是盯著一個加載旋轉器。

2) 代理與應用程序之間的共享狀態

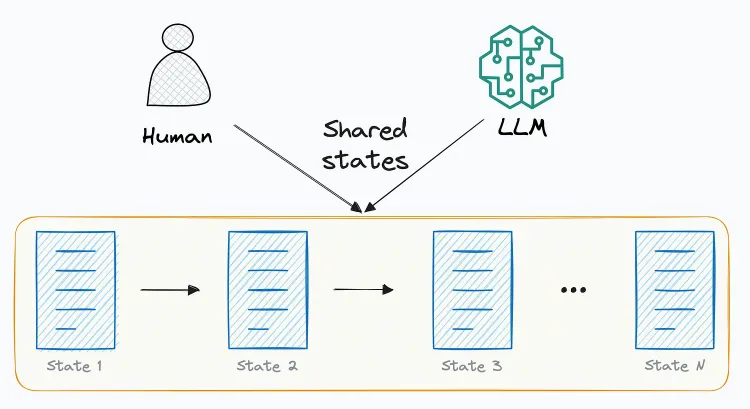

流式傳輸AI代理的中間狀態并不完全有幫助,對吧?我的意思是,溝通正在發生的事情當然是有益的,但如果需要,人類應該被允許與這些狀態互動。

因此,狀態必須在應用程序狀態(對人類可見)和代理狀態(代理的內部狀態)之間雙向同步,以允許代理和人類協作完成任務。

3) 代理問答

任何由人機協同驅動的代理的一個明顯期望是,如果它對某事不確定或需要用戶提供一些額外的細節以達成最終狀態,它應該能夠向用戶提出問題。

使用此功能,任何AI代理都可以輕松地以兩種方式提出這樣的問題:

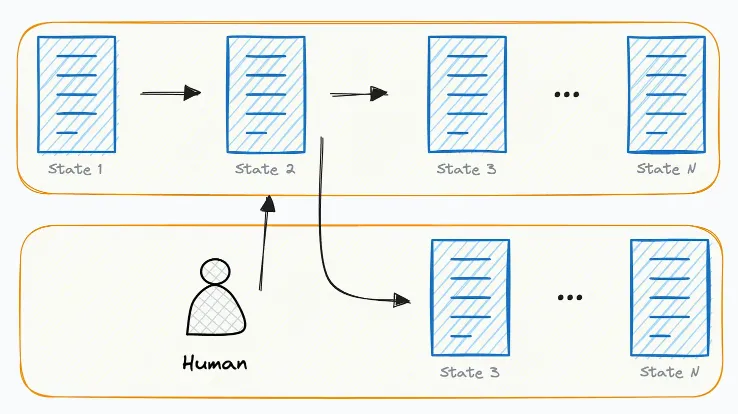

4)代理引導(即將推出)

一旦代理產生了其狀態,可能需要我們回到中間狀態,糾正一些事情,并從那個特定的檢查點重新運行。

這個功能即將發布(加入搶先體驗以保持更新),將讓我們能夠做到這一點:

03 結語

憑借今天的技術和技巧,任何現有的GPT或LLaMAs或Mistrals都可以(幾乎)可靠地:

- 使用LoRA/QLoRA等進行微調以適應額外信息。

- 使用基于RAG的技術增加額外信息。

此外,通過Tree-of-thoughts、Reflexion等技術,我們能夠向模型引入“規劃/推理技巧”,以利用更多的代理行為。

參考:

- ??https://blog.dailydoseofds.com/p/copilotkit-coagents-build-human-in??

- ??https://github.com/login?return_to=%2FCopilotKit%2FCopilotKit??

?

本文轉載自公眾號Halo咯咯 作者:基咯咯

原文鏈接:??https://mp.weixin.qq.com/s/CuWqU3AYdYsDlXBvAlGeHg??????