使用Kubernetes最常見的10個錯誤

使用 Kubernetes,大家都會遇到哪些錯誤?本文分享了作者多年來使用 Kubernetes 最常見的 10 個錯誤。

使用 kubernetes 這么多年以來,我們見過的集群不計其數(包括托管的和非托管的,GCP、AWS 和 Azure 上的都有),還見識了很多經常重復出現的錯誤。其中大部分錯誤我們自己也犯過,這沒什么丟人的!

本文會給大家展示一些我們經常遇到的問題,并談談修復它們的方法。

1. 資源:請求和限制

這無疑是最值得關注的,也是這個榜單上的第一名。

人們經常不設置 CPU 請求或將 CPU 請求設置得過低(這樣我們就可以在每個節點上容納很多 Pod),結果節點就會過量使用(overcommited)。在需求較高時,節點的 CPU 全負荷運行,而我們的負載只能得到“它所請求的”數據,使 CPU 節流(throttled),從而導致應用程序延遲和超時等指標增加。

BestEffort(不要這樣做):

- resources: {}

very low cpu(不要這樣做):

- resources:

- requests:

- cpu: "1m"

另一方面,啟用 CPU 限制可能會在節點的 CPU 沒有充分利用的情況下,對 Pod 進行不必要地節流,這也會導致延遲增加。人們也討論過關于 Linux 內核中的 CPU CFS 配額,和因為設置了 CPU 限制并關閉 CFS 配額而導致的 CPU 節流問題。CPU 限制造成的問題可能會比它能解決的問題還多。想了解更多信息,請查看下面的鏈接。

內存過量使用會給我們帶來更多麻煩。達到 CPU 限制將導致節流,達到內存限制會導致 Pod 被殺。見過 OOMkill(因內存不足而被殺死)嗎?我們要說的就是這個意思。想要盡量減少這類狀況?那就不要過量使用內存,并使用 Guaranteed QoS(Quality of Service)將內存請求設置為與限制相等,就像下面的例子那樣。了解更多信息,請參考 Henning Jacobs(Zalando)的演講。

https://www.slideshare.net/try_except_/optimizing-kubernetes-resource-requestslimits-for-costefficiency-and-latency-highload

Burstable(容易帶來更多 OOMkilled):

- resources:

- requests:

- memory: "128Mi"

- cpu: "500m"

- limits:

- memory: "256Mi"

- cpu: 2

Guaranteed:

- resources:

- requests:

- memory: "128Mi"

- cpu: 2

- limits:

- memory: "128Mi"

- cpu: 2

那么我們設置資源時有什么訣竅呢?

我們可以使用 metrics-server 查看 Pod(以及其中的容器)的當前 CPU 和內存使用情況。你可能已經啟用它了。只需運行以下命令即可:

- kubectl top pods

- kubectl top pods --containers

- kubectl top nodes

不過,這些只會顯示當前的使用情況。要大致了解這些數據的話這就夠用了,但我們到頭來是希望能及時看到這些使用量指標(以回答諸如:昨天上午 CPU 使用量的峰值等問題)。為此我們可以使用 Prometheus 和 DataDog 等工具。它們只是從 metrics-server 接收度量數據并存儲下來,然后我們就能查詢和繪制這些數據了。

VerticalPodAutoscaler 可以幫助我們自動化這一手動過程——及時查看 cpu/ 內存的使用情況,并基于這些數據再設置新的請求和限制。

https://cloud.google.com/kubernetes-engine/docs/concepts/verticalpodautoscaler

有效利用計算資源不是一件容易的事情,就像不停地玩俄羅斯方塊。如果我們發現自己花了大筆錢購買計算資源,可是平均利用率卻很低(比如大約 10%),那么我們可能就需要 AWS Fargate 或基于 Virtual Kubelet 的產品。它們主要使用無服務器 / 按使用量付費的的計費模式,這對我們來說可能會更省錢。

2. liveness 和 readiness 探針

默認情況下,Kubernetes 不會指定任何 liveness 和 readiness 探針。有時它會一直保持這種狀態……

但如果出現不可恢復的錯誤,我們的服務將如何重新啟動呢?負載均衡器如何知道特定的 Pod 可以開始處理流量,或能處理更多流量呢?

人們通常不知道這兩者間的區別。

- 如果探針失敗,liveness 探針將重新啟動 Pod

- Readiness 探針失敗時,會斷開故障 Pod 與 Kubernetes 服務的連接(我們可以用kubectl get endpoints檢查這一點),并且直到該探針恢復正常之前,不會向該 Pod 發送任何流量。

它們兩個都運行在整個 Pod 生命周期中。這一點是很重要的。

人們通常認為,readiness 探針只在開始時運行,以判斷 Pod 何時 Ready 并可以開始處理流量。但這只是它的一個用例而已。

它的另一個用例是在一個 Pod 的生命周期中判斷它是否因過熱而無法處理太多流量(或一項昂貴的計算),這樣我們就不會讓它做更多工作,而是讓它冷卻下來;等到 readiness 探針成功,我們會再給它發送更多流量。在這種情況下(當 readiness 探針失敗時),如果 liveness 探針也失敗就會非常影響效率了。我們為什么要重新啟動一個健康的、正在做大量工作的 Pod 呢?

有時候,不指定任何探針都比指定一個錯誤的探針要好。如上所述,如果 liveness 探針等于 readiness 探針,我們將遇到很大的麻煩。我們一開始可能只會指定 readiness 探針,因為 liveness 探針太危險了。

https://twitter.com/sszuecs/status/1175803113204269059

https://srcco.de/posts/kubernetes-liveness-probes-are-dangerous.html

如果你的任何共享依賴項出現故障,就不要讓任何一個探針失敗,否則它將導致所有 Pod 的級聯故障。我們這是搬起石頭砸自己的腳。

https://blog.colinbreck.com/kubernetes-liveness-and-readiness-probes-how-to-avoid-shooting-yourself-in-the-foot/

3. 在所有 HTTP 服務上啟用負載均衡器

我們的集群中可能有很多 HTTP 服務,并且我們希望將這些服務對外界公開。

如果我們將 Kubernetes 服務以type: LoadBalancer的形式公開,那么它的控制器(取決于供應商)將提供并協調一個外部負載均衡器(不一定是 L7 的,更可能是 L4 lb);當我們創建很多這種資源時,它們可能會變得很昂貴(外部靜態 ipv4 地址、計算、按秒計費……)。

在這種情況下,共享同一個外部負載均衡器可能會更好些,這時我們將服務以type: NodePort的形式公開。或者更好的方法是,部署 nginx-ingress-controller(或 traefik)之類的東西,作為公開給這個外部負載均衡器的單個 NodePort 端點,并基于 Kubernetes ingress 資源在集群中路由流量。

其他相互通信的集群內(微)服務可以通過 ClusterIP 服務和開箱即用的 DNS 服務發現來通信。注意不要使用它們的公共 DNS/IP,因為這可能會影響它們的延遲和云成本。

4. 無 Kubernetes 感知的集群自動縮放

在集群中添加節點或刪除節點時,不應該考慮一些簡單的度量指標,比如這些節點的 CPU 利用率。在調度 Pod 時,我們需要根據許多調度約束來進行決策,比如 Pod 和節點的親密關系(affinities)、污點(taints)和容忍(tolerations)、資源請求(resource requests)、QoS 等。讓一個不了解這些約束的外部自動縮放器(autoscaler)來處理縮放可能會招來麻煩。

假設有一個新的 Pod 要被調度,但是所有可用的 CPU 都被請求了,并且 Pod 卡在了 Pending 狀態。可是外部自動縮放器會查看當前的平均 CPU 使用率(不是請求數量),然后決定不擴容(不添加新的節點)。結果 Pod 也不會被調度。

縮容(從集群中刪除節點)總是更難一些。假設我們有一個有狀態的 Pod(連接了持久卷),由于持久卷(persistent volumes)通常是屬于特定可用區域的資源,并且沒有在該區域中復制,我們自定義的自動縮放器會刪除一個帶有此 Pod 的節點,而調度器無法將其調度到另一個節點上,因為這個 Pod 只能待在持久磁盤所在的那個可用區域里。Pod 將再次陷入 Pending 狀態。

社區正在廣泛使用 cluster-autoscaler,它運行在集群中,能與大多數主要的公共云供應商 API 集成;它可以理解所有這些約束,并能在上述情況下擴容。它還能搞清楚是否可以在不影響我們設置的任何約束的前提下優雅地縮容,從而節省我們的計算成本。

https://github.com/kubernetes/autoscaler/tree/master/cluster-autoscaler

5. 不要使用 IAM/RBAC 的能力

不要使用 IAM Users 永久存儲機器和應用程序的秘鑰,而要使用角色和服務帳戶生成的臨時秘鑰。

我們經常看到這種情況,那就是在應用程序配置中硬編碼訪問(access )和密鑰(secret),并在使用 Cloud IAM 時從來不輪換密鑰。我們應該盡量使用 IAM 角色和服務帳戶來代替 Users。

請跳過 kube2iam,直接按照Štěpán Vraný在這篇博文中介紹的那樣,使用服務賬戶的 IAM 角色。

https://blog.pipetail.io/posts/2020-04-13-more-eks-tips/

- apiVersion: v1

- kind: ServiceAccount

- metadata:

- annotations:

- eks.amazonaws.com/role-arn: arn:aws:iam::123456789012:role/my-app-role

- name: my-serviceaccount

- namespace: default

只有一個 annotation。沒那么難做吧。

另外,當服務帳戶或實例配置文件不需要admin和cluster-admin權限時,也不要給它們這些權限。這有點困難,尤其是在 k8s RBAC 中,但仍然值得一試。

6. Pod 的 self anti-affinities

某個部署有 3 個 Pod 副本正在運行,然后節點關閉了,所有的副本也都隨之關閉。豈有此理?所有副本都在一個節點上運行?Kubernetes 難道不應該很厲害,并提供高可用性的嗎?!

我們不能指望 Kubernetes 調度程序為我們的 Pod 強制使用 anti-affinites。我們必須顯式地定義它們。

- // omitted for brevity

- labels:

- app: zk

- // omitted for brevity

- affinity:

- podAntiAffinity:

- requiredDuringSchedulingIgnoredDuringExecution:

- - labelSelector:

- matchExpressions:

- - key: "app"

- operator: In

- values:

- - zk

- topologyKey: "kubernetes.io/hostname"

就是這樣。這樣就能保證 Pod 被調度到不同的節點上(這僅在調度時檢查,而不是在執行時檢查,因此需要requiredDuringSchedulingIgnoredDuringExecution )。

我們討論的是不同節點名稱上( topologyKey: "kubernetes.io/hostname" )的 podAntiAffinity,而不是不同可用區域的 podAntiAffinity。如果你確實需要很好的可用性水平,可以在這個主題上再深入做些研究。

7. 無 PodDisruptionBudget

我們在 Kubernetes 上運行生產負載。我們的節點和集群必須不時升級或停用。PodDisruptionBudget(pdb)是一種用于在集群管理員和集群用戶之間提供服務保證的 API。

請確保創建了pdb ,以避免由于節點耗盡而造成不必要的服務中斷。

- apiVersion: policy/v1beta1

- kind: PodDisruptionBudget

- metadata:

- name: zk-pdb

- spec:

- minAvailable: 2

- selector:

- matchLabels:

- app: zookeeper

作為一個集群用戶,我們可以告訴集群管理員:“嘿,我這里有個 zookeeper 服務,無論如何我都希望至少有 2 個副本是始終可用的”。

我在這篇博客文章中更深入地討論了這個話題。

https://blog.marekbartik.com/posts/2018-06-29_kubernetes-in-production-poddisruptionbudget/

8. 共享集群中有不止一個租戶或環境

Kubernetes 命名空間不提供任何強隔離。

人們似乎期望,如果將非生產負載放到一個命名空間,然后將生產負載放到生產命名空間,那么這些負載之間就永遠不會相互影響了。我們可以在某種程度上公平分配(比如資源的請求和限制、配額、優先級)并實現隔離(比如 affinities、tolerations、taints 或 nodeselectors),進而“物理地”分離數據平面上的負載,但這種分離是相當復雜的。

如果我們需要在同一個集群中同時擁有這兩種類型的負載,那么就必須要承擔這種復雜性。如果我們用不著局限在一個集群里,而且再加一個集群的成本更低時(比如在公共云上),那么應該將它們放在不同的集群中以獲得更強的隔離級別。

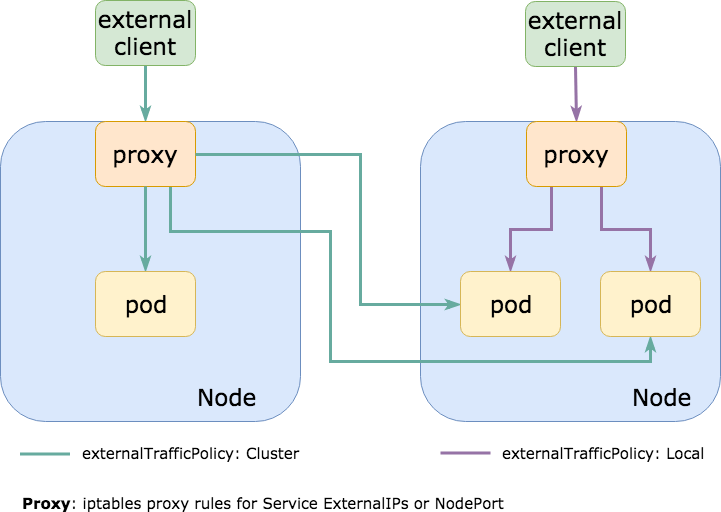

9. externalTrafficPolicy: Cluster

經常看到這種情況,所有流量都在集群內路由到一個 NodePort 服務上,該服務默認使用 externalTrafficPolicy: Cluster 。這意味著在集群中的每個節點上都打開了 NodePort,這樣我們可以任選一個來與所需的服務(一組 Pod)通信。

通常情況下,NodePort 服務所針對的那些 Pod 實際上只運行在這些節點的一個子集上。這意味著,如果我與一個沒有運行 Pod 的節點通信,它將會把流量轉發給另一個節點,從而導致額外的網絡跳轉并增加延遲(如果節點位于不同的 AZs 或數據中心,那么延遲可能會很高,并且會帶來額外的出口成本)。

在 Kubernetes 服務上設置externalTrafficPolicy: Local,就不會在每個節點上都打開 NodePort,只會在實際運行 Pod 的節點上開啟它。如果我們使用一個外部負載均衡器來檢查它端點的運行狀況(就像 AWS ELB 所做的那樣),它就會只將流量發送到應該接收流量的節點上,這樣就能改善延遲、減少計算開銷、降低出口成本并提升健全性。

我們可能會有像 traefik 或 nginx-ingress-controller 之類的東西,被公開成 NodePort(或使用 NodePort 的負載均衡器)來處理入口 HTTP 流量路由,而這種設置可以極大地減少此類請求的延遲。

這里有一篇很棒的博客文章,更深入地討論了 externalTrafficPolicy 和它們的權衡取舍。

https://www.asykim.com/blog/deep-dive-into-kubernetes-external-traffic-policies

10. 把集群當寵物 + 控制平面壓力過大

你有沒有過這樣的經歷:給服務器取 Anton、HAL9000 或 Colossus 之類的名字(都是帶梗的名稱,譯注),或者給節點隨機生成 id,卻給集群取個有含義的名稱?

還可能是這樣的經歷:一開始用 Kubernetes 做概念驗證,給集群取名"testing",結果到了生產環境還沒給它改名,結果誰都不敢碰它?(真實的故事)

把集群當寵物可不是開玩笑的,我們可能需要不時刪除集群,演練災難恢復并管理我們的控制平面。害怕觸碰控制平面不是個好兆頭。Etcd 掛掉了?好嘞,我們遇到大麻煩。

反過來說,控制平面也不要用過頭了。也許隨著時間的流逝,控制平面變慢了。這很可能是因為我們創建了很多對象而沒有輪換它們(使用 helm 時常見的情況,它的默認設置不會輪換 configmaps/secrets 的狀態,結果我們在控制平面中會有數千個對象),或者是因為我們不斷從 kube-api(用于自動伸縮、CI/CD、監視、事件日志、控制器等)中刪除和編輯了大量內容。

另外,請檢查托管 Kubernetes 提供的“SLAs”/SLOs 和保證。供應商可能會保證控制平面(或其子組件)的可用性,但不能保證發送給它的請求的 p99 延遲水平。換句話說,就算我們kubectl get nodes后用了 10 分鐘才得到正確結果,也沒有違反服務保證。

11. 附贈一條:使用 latest 標簽

這一條是很經典的。我覺得最近它沒那么常見了,因為大家被坑的次數太多,所以再也不用 :latest ,開始加上版本號了。這下清靜了!

ECR 有一個標簽不變性的強大功能,絕對值得一試。

https://aws.amazon.com/about-aws/whats-new/2019/07/amazon-ecr-now-supports-immutable-image-tags/

12.總結

別指望所有問題都能自動解決——Kubernetes 不是銀彈。即使是在 Kubernetes 上,一個糟糕的應用程序還會是一個糟糕的應用程序(實際上,甚至還可能更糟糕)。如果我們不夠小心,最后就會遇到一系列問題:太過復雜、壓力過大、控制平面變慢、沒有災難恢復策略。不要指望多租戶和高可用性是開箱即用的。請花點時間讓我們的應用程序云原生化。