華人團(tuán)隊(duì)獲最佳論文、最佳系統(tǒng)論文,CoRL獲獎(jiǎng)?wù)撐某鰻t

自 2017 年首次舉辦以來(lái),CoRL 已經(jīng)成為了機(jī)器人學(xué)與機(jī)器學(xué)習(xí)交叉領(lǐng)域的全球頂級(jí)學(xué)術(shù)會(huì)議之一。CoRL 是面向機(jī)器人學(xué)習(xí)研究的 single-track 會(huì)議,涵蓋機(jī)器人學(xué)、機(jī)器學(xué)習(xí)和控制等多個(gè)主題,包括理論與應(yīng)用。

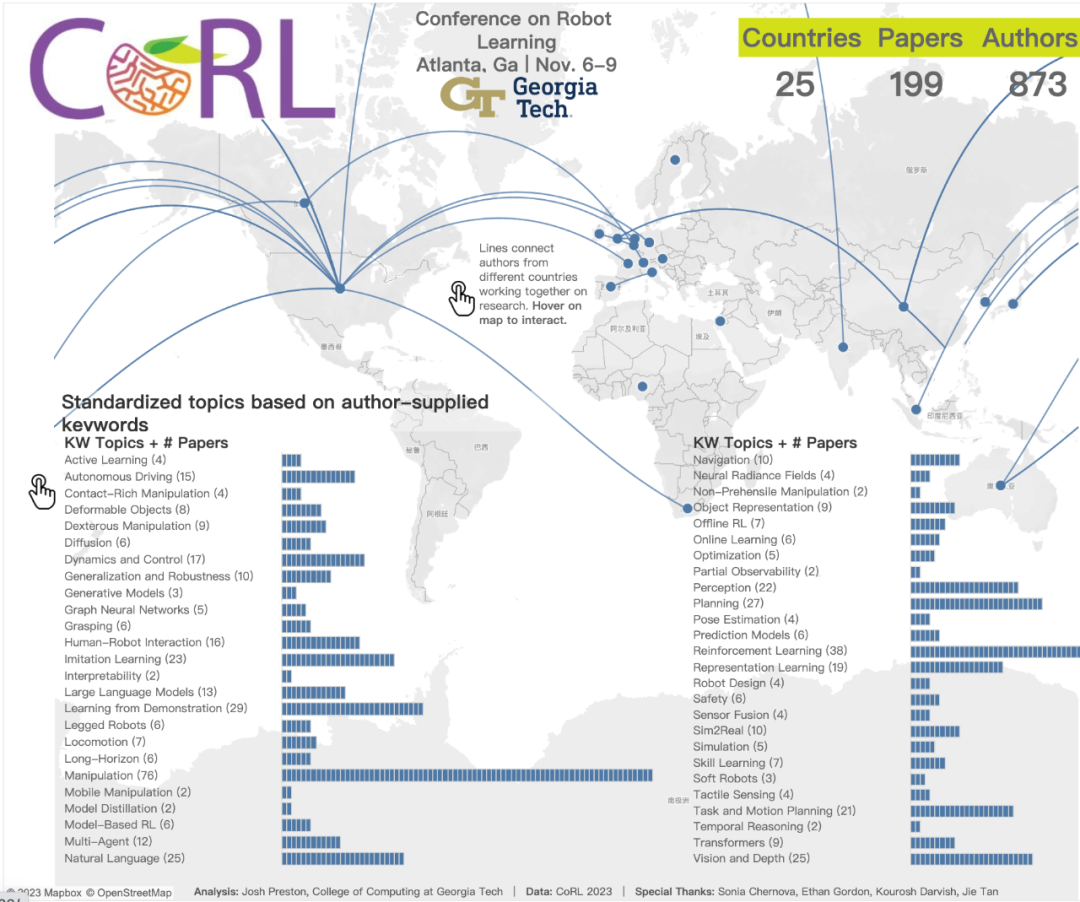

2023 年的 CoRL 大會(huì)于 11 月 6 日至 9 日在美國(guó)亞特蘭大舉行。據(jù)官方數(shù)據(jù)透露,今年來(lái)自 25 個(gè)國(guó)家的 199 篇論文入選 CoRL,熱門主題包括 manipulation、強(qiáng)化學(xué)習(xí)等。雖然相比于 AAAI、CVPR 等大型 AI 學(xué)術(shù)會(huì)議,CoRL 的會(huì)議規(guī)模還相對(duì)小很多,但隨著今年大模型、具身智能、人形機(jī)器人等概念的火熱,CoRL 會(huì)議上的相關(guān)研究也非常值得關(guān)注。

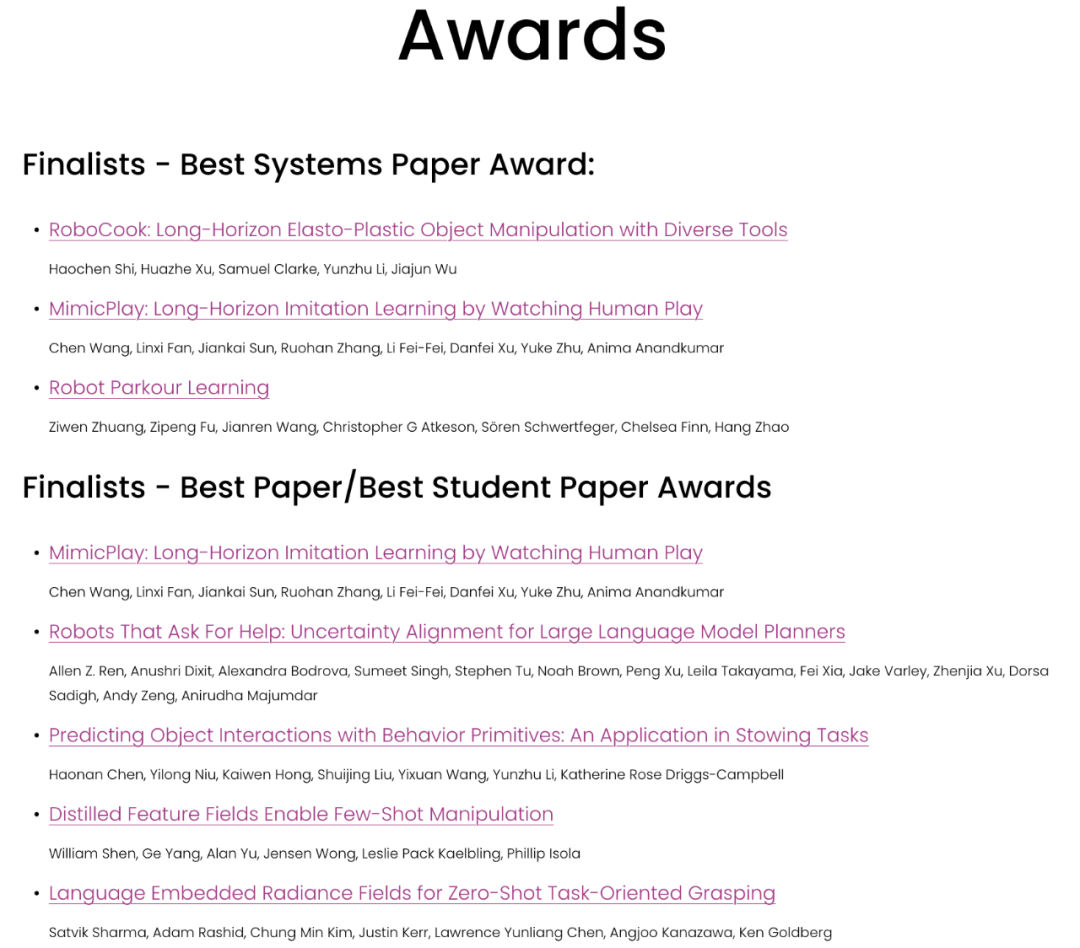

目前,CoRL 2023 官方已公布最佳論文獎(jiǎng)、最佳學(xué)生論文獎(jiǎng)、最佳系統(tǒng)論文獎(jiǎng)等獎(jiǎng)項(xiàng)。接下來(lái),我們將為大家介紹一下這些獲獎(jiǎng)?wù)撐摹?/span>

最佳論文

- 論文:Distilled Feature Fields Enable Few-Shot Language-Guided Manipulation

- 作者:William Shen, Ge Yang, Alan Yu, Jensen Wong, Leslie Pack Kaelbling, Phillip Isola

- 機(jī)構(gòu):MIT CSAIL、IAIFI

- 論文地址:https://openreview.net/forum?id=Rb0nGIt_kh5

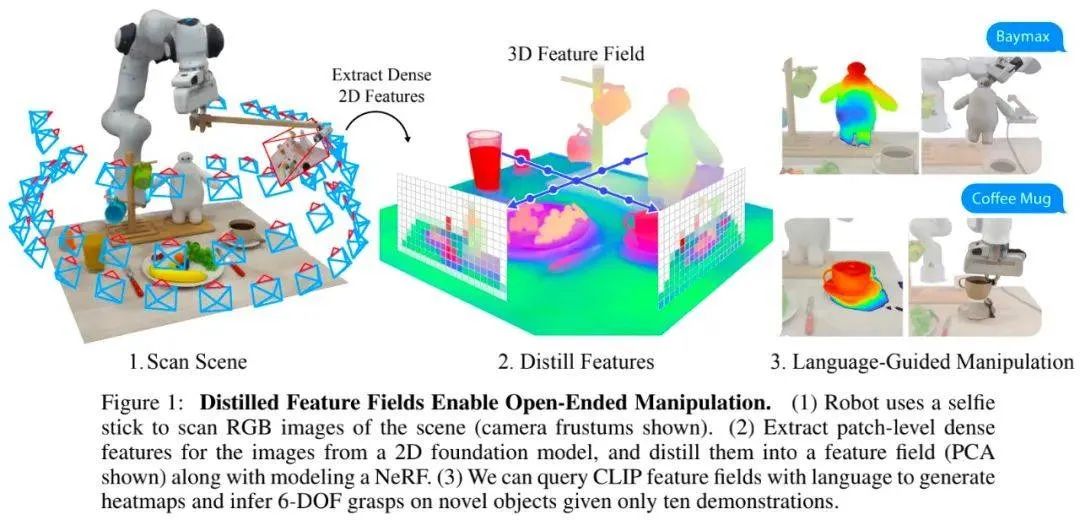

論文簡(jiǎn)介:當(dāng)前,自監(jiān)督和語(yǔ)言監(jiān)督的圖像模型已經(jīng)包含豐富的世界知識(shí),這對(duì)于泛化來(lái)說(shuō)非常重要,但圖像特征是二維的。我們知道,機(jī)器人任務(wù)通常需要對(duì)現(xiàn)實(shí)世界中三維物體的幾何形狀有所了解。

該研究利用蒸餾特征場(chǎng)(Distilled Feature Field,DFF),將準(zhǔn)確的 3D 幾何圖形與來(lái)自 2D 基礎(chǔ)模型的豐富語(yǔ)義結(jié)合起來(lái),讓機(jī)器人能夠利用 2D 基礎(chǔ)模型中豐富的視覺(jué)和語(yǔ)言先驗(yàn),完成語(yǔ)言指導(dǎo)的操作。

具體來(lái)說(shuō),該研究提出了一種用于 6-DOF 抓取和放置的小樣本學(xué)習(xí)方法,并利用強(qiáng)大的空間和語(yǔ)義先驗(yàn)泛化到未見(jiàn)過(guò)物體上。使用從視覺(jué) - 語(yǔ)言模型 CLIP 中提取的特征,該研究提出了一種通過(guò)開放性的自然語(yǔ)言指令對(duì)新物體進(jìn)行操作,并展示了這種方法泛化到未見(jiàn)過(guò)的表達(dá)和新型物體的能力。

這篇論文的兩位共同一作是 CSAIL 「具身智能」團(tuán)隊(duì)的成員 William Shen 和楊歌,其中楊歌是 2023 年 CSAIL 具身智能研討會(huì)的共同籌辦人。

機(jī)器之心曾詳細(xì)介紹過(guò)這篇研究,請(qǐng)參考《大模型加持的機(jī)器人有多強(qiáng),MIT CSAIL&IAIFI 用自然語(yǔ)言指導(dǎo)機(jī)器人抓取物體》。

最佳學(xué)生論文

- 論文:Robots That Ask For Help: Uncertainty Alignment for Large Language Model Planners

- 作者:Allen Z. Ren, Anushri Dixit, Alexandra Bodrova, Sumeet Singh, Stephen Tu, Noah Brown, Peng Xu, Leila Takayama, Fei Xia, Jake Varley, Zhenjia Xu, Dorsa Sadigh, Andy Zeng, Anirudha Majumdar

- 機(jī)構(gòu):普林斯頓大學(xué)、Google DeepMind

- 論文地址:https://openreview.net/forum?id=4ZK8ODNyFXx

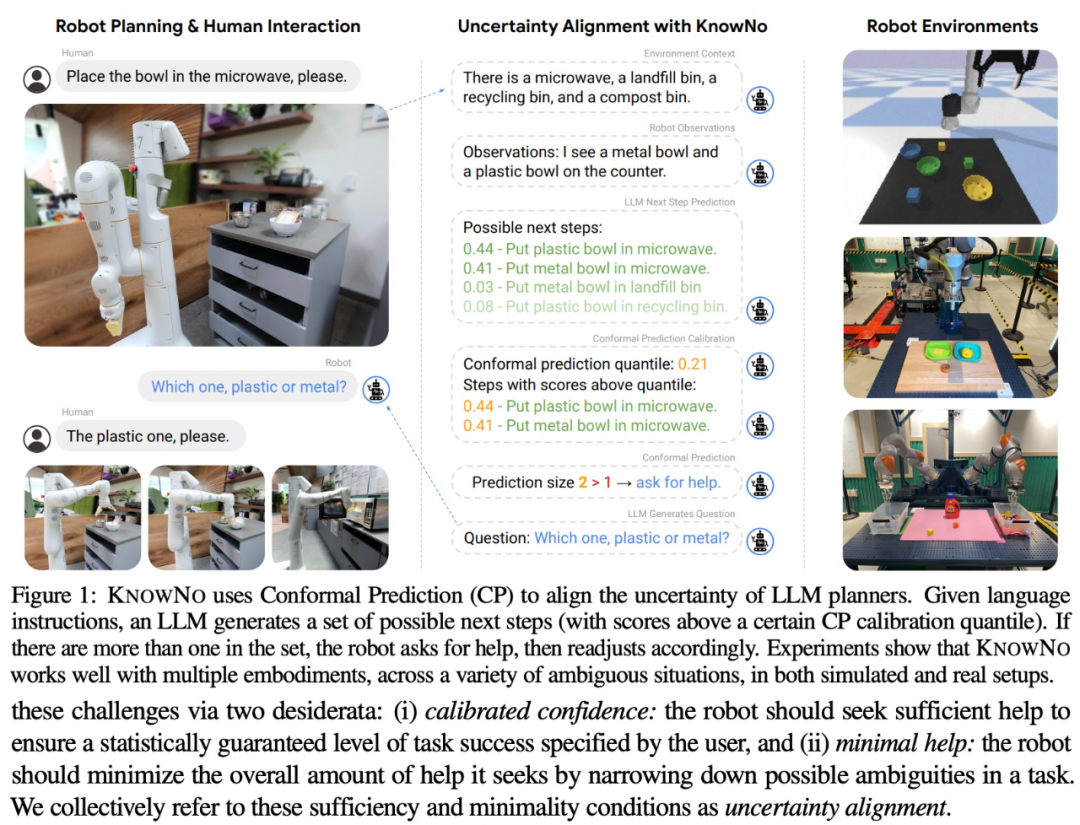

論文簡(jiǎn)介:從逐步規(guī)劃到常識(shí)推理,大型語(yǔ)言模型(LLM)展現(xiàn)出大量在機(jī)器人領(lǐng)域未來(lái)可期的能力,但 LLM 存在幻覺(jué)問(wèn)題。

基于此,該研究提出了一種新框架 ——KnowNo,用于度量和對(duì)齊基于 LLM 的規(guī)劃器的不確定性。它能夠使 LLM 意識(shí)到哪些信息是未知的,并在有需要時(shí)求助。

KnowNo 建立在共形預(yù)測(cè)(conformal prediction)理論的基礎(chǔ)上,為任務(wù)完成提供統(tǒng)計(jì)保證,同時(shí)能夠最大限度地減少多步驟規(guī)劃任務(wù)中的人工干預(yù)。

該研究在各種模擬和真實(shí)機(jī)器人實(shí)驗(yàn)中,用各種模式的不確定任務(wù)(包括空間不確定性、數(shù)字不確定性等等)對(duì) KnowNo 進(jìn)行了測(cè)試。實(shí)驗(yàn)結(jié)果表明, KnowNo 在提高效率和自主性方面表現(xiàn)出色,優(yōu)于基線,并且安全可信。KnowNo 能夠在不進(jìn)行模型微調(diào)的情況下直接用于 LLM,為模型的不確定性提供了一種有效的輕量級(jí)解決方法,并能夠與基礎(chǔ)模型不斷增強(qiáng)的能力相輔相成。

最佳系統(tǒng)論文

- 論文:RoboCook: Long-Horizon Elasto-Plastic Object Manipulation with Diverse Tools

- 作者:Haochen Shi, Huazhe Xu, Samuel Clarke, Yunzhu Li, Jiajun Wu

- 機(jī)構(gòu):斯坦福大學(xué)、UIUC

- 論文地址:https://openreview.net/forum?id=69y5fzvaAT

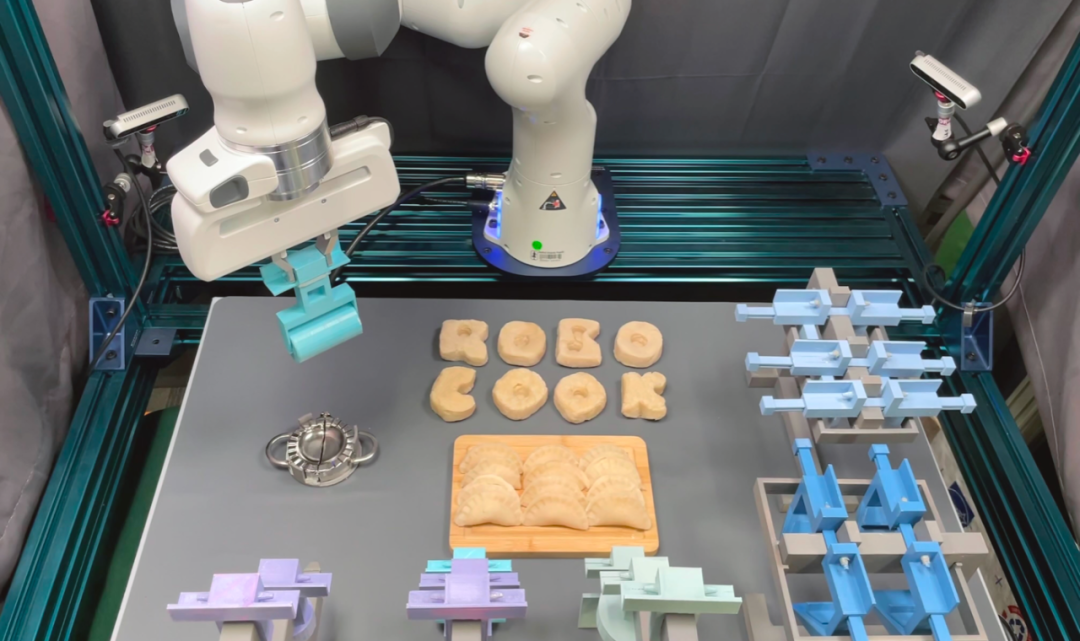

論文簡(jiǎn)介:人類擅長(zhǎng)制造和使用各種工具,但對(duì)于機(jī)器人而言,理解如何有效使用工具,并在相應(yīng)的物體上完成操作仍然是一個(gè)很大的挑戰(zhàn)。該研究構(gòu)建了一個(gè)名為 RoboCook 的智能機(jī)器人系統(tǒng),該系統(tǒng)能夠通過(guò)各種工具感知、建模并操縱彈塑性物體(elasto-plastic object)。

RoboCook 使用點(diǎn)云場(chǎng)景表征,利用圖神經(jīng)網(wǎng)絡(luò)(GNN)對(duì)工具與物體的相互作用進(jìn)行建模,并將工具分類與自監(jiān)督策略學(xué)習(xí)相結(jié)合,以制定操作計(jì)劃。

該研究表明,對(duì)于每個(gè)工具,僅需 20 分鐘的現(xiàn)實(shí)世界交互數(shù)據(jù),RoboCook 就能學(xué)會(huì)并操縱機(jī)械臂完成一些復(fù)雜的、長(zhǎng)時(shí)程的彈塑性物體操作任務(wù),例如制作餃子、字母餅干等。

實(shí)驗(yàn)表明,RoboCook 的性能大大優(yōu)于現(xiàn)有 SOTA 方法,對(duì)嚴(yán)重的外部干擾也能表現(xiàn)出穩(wěn)健性,對(duì)不同材料的適應(yīng)性也較強(qiáng)。

值得一提的是,這篇論文的共同一作分別是來(lái)自斯坦福大學(xué)的博士生 Haochen Shi、原斯坦福大學(xué)博士后研究員、現(xiàn)清華大學(xué)交叉信息科學(xué)研究所助理教授 Huazhe Xu,論文作者之一是姚班校友、斯坦福大學(xué)助理教授吳佳俊。

獲獎(jiǎng)?wù)撐耐暾雵麊?/span>