綜述!深度模型融合(LLM/基礎(chǔ)模型/聯(lián)邦學習/微調(diào)等)

23年9月國防科大、京東和北理工的論文“Deep Model Fusion: A Survey”。

深度模型融合/合并是一種新興技術(shù),它將多個深度學習模型的參數(shù)或預(yù)測合并為一個模型。它結(jié)合了不同模型的能力來彌補單個模型的偏差和錯誤,以獲得更好的性能。然而,大規(guī)模深度學習模型(例如LLM和基礎(chǔ)模型)上的深度模型融合面臨著一些挑戰(zhàn),包括高計算成本、高維參數(shù)空間、不同異構(gòu)模型之間的干擾等。本文將現(xiàn)有的深度模型融合方法分為四類:(1)“模式連接”,通過一條損失減少的路徑將權(quán)重空間中的解連接起來,以獲得更好的模型融合初始化;(2)“對齊”,匹配神經(jīng)網(wǎng)絡(luò)之間的單元,為融合創(chuàng)造更好的條件;(3)“權(quán)重平均”是一種經(jīng)典的模型融合方法,將多個模型的權(quán)重進行平均,以獲得更接近最優(yōu)解、更準確的結(jié)果。(4)“集成學習”結(jié)合了不同模型的輸出,這是提高最終模型準確性和魯棒性的基礎(chǔ)技術(shù)。此外,分析深度模型融合面臨的挑戰(zhàn),并提出了未來模型融合可能的研究方向。

由于數(shù)據(jù)隱私和實際資源節(jié)省問題,深度模型融合引起了越來越多的興趣。盡管深度模型融合的發(fā)展帶來了許多技術(shù)突破,但也產(chǎn)生了一系列挑戰(zhàn),例如計算負載高、模型異構(gòu)性以及組合優(yōu)化對齊速度慢等[133, 204],讓一些方法在具體的場景受到限制[227, 254],這激發(fā)了科學家研究不同情況下模型融合的原理。

不過,有些工作只關(guān)注單一視角(例如特征融合等)[45, 195]和特定場景[213]的模型融合,或者不同方式的信息融合(多模態(tài)融合[1, 103] ])而不是參數(shù)的融合。加上最近的進展和代表性應(yīng)用,例如聯(lián)邦學習(FL)[160]和微調(diào)[29]等,本文根據(jù)內(nèi)部機制和目的分為四類,如圖所示整個模型融合流程示意圖,以及各種方法的分類和連接。

對于獨立訓(xùn)練且彼此不相鄰的模型,“模式連接”和“對齊”使解決方案更加接近,從而 以獲得更好的平均原始條件。對于權(quán)值空間存在一定差異的相似模型,“權(quán)重平均(WA)”傾向于直接對模型進行平均,在損失函數(shù)值較低的參數(shù)空間區(qū)域中獲得更接近最優(yōu)點的解 [118]。此外,對于現(xiàn)有模型的預(yù)測,“集成學習”整合了模型的不同形式的預(yù)測,以獲得更好的結(jié)果。

模型融合作為一種提高深度模型精度和魯棒性的技術(shù),促進了許多應(yīng)用領(lǐng)域的改進。“聯(lián)邦學習[160]”是一種在中央服務(wù)器上聚合客戶端模型的應(yīng)用程序,使各方能夠為函數(shù)的計算(例如各種統(tǒng)計數(shù)據(jù)、分類器[177])貢獻數(shù)據(jù),而不會帶來隱私暴露的風險。“微調(diào)”對預(yù)訓(xùn)練的模型進行小幅調(diào)整,與模型融合相結(jié)合,以降低訓(xùn)練成本并適應(yīng)特定任務(wù)或領(lǐng)域的需求。模型融合還涉及到“蒸餾”。即結(jié)合多個復(fù)雜模型(教師)的軟目標知識,訓(xùn)練一個針對特定需求的小模型。“基礎(chǔ)/LLM上的模型融合”包括大型基礎(chǔ)模型或大型語言模型(LLM)的工作,例如視覺Transformer(ViT)[79]和GPT[17]等。模型融合的應(yīng)用幫助開發(fā)人員適應(yīng)各種任務(wù)和領(lǐng)域的需求,促進深度學習的發(fā)展。

為了確定訓(xùn)練網(wǎng)絡(luò)的結(jié)果對于 SGD 噪聲是否穩(wěn)定,損失屏障(誤差屏障)被定義為兩點損失線性插值與兩點線性連接損失之間的最大差[50]。損失屏障說明,沿著 W1 和 W2 之間的路徑優(yōu)化圖 [56, 61] ,誤差是恒定的還是增加的。如果兩個網(wǎng)絡(luò)之間存在一條隧道,其屏障約等于0,則相當于模式連接[46,59,60]。也就是說,SGD得到的局部極小值可以通過一條最大損失最小化的路徑 φ 連接起來。

基于梯度的優(yōu)化得到的解可以在權(quán)重空間中通過沒有屏障的路徑(連接器)連接起來,這被稱為模式連接[46, 50]。可以沿著低損失路徑獲得更適合模型融合的其他模型。根據(jù)路徑的數(shù)學形式和連接器所在的空間,分為三個部分“線性模式連接(LMC)[66]”、“非線性模式連接”和“子空間的模式連接” ”。

模式連接可以解決訓(xùn)練過程中的局部優(yōu)化問題。模式連接路徑的幾何關(guān)系 [61, 162] 也可用于加速隨機梯度下降 (SGD) 等優(yōu)化過程的收斂性、穩(wěn)定性和準確性。總之,模式連接為解釋和理解模型融合的行為提供了新的視角[66]。但計算復(fù)雜度和參數(shù)調(diào)整的困難應(yīng)該得到解決,特別是在大型數(shù)據(jù)集上訓(xùn)練模型時。下表是線性模式連接(LMC) 和非線性模式連接的標準訓(xùn)練流程總結(jié)。

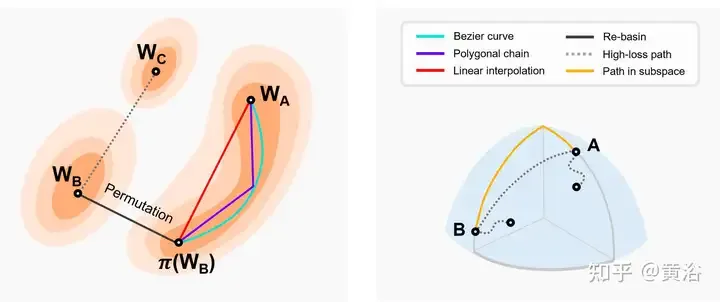

如圖是二維損失圖和其他維度子空間中的模式連接示意圖。左:兩個盆地最小值的線性插值導(dǎo)致高損失屏障[46]。較低的兩個最佳值遵循接近恒定的低損失路徑(例如貝塞爾曲線、多邊框鏈等)[66]。π(W2)是W2的排列對稱性的等價模型,與W1位于同一盆地。Re-Basin 通過為各個流域提供解決方案來合并模型 [3]。右圖:低損失路徑連接子空間中的多個最小值(例如,由 d-維 楔形組成的低損失流形 [56])等)。

下表是在不同局部最小值之間尋找隧道的方法。

總之,模式連接為深度模型融合提供了更新、更靈活的視角。神經(jīng)網(wǎng)絡(luò)的訓(xùn)練容易陷入局部最優(yōu),從而導(dǎo)致性能下降。在模型連接的基礎(chǔ)上,可以找到性能更好的其他模型,并將其作為進一步優(yōu)化和融合的起點。可以利用已經(jīng)訓(xùn)練的模型在參數(shù)空間中移動來達到新的目標模型,這樣可以節(jié)省時間和計算開銷,適合數(shù)據(jù)有限的情況。然而,在連接不同模型時,可能會引入額外的復(fù)雜性和靈活性,從而增加過度擬合的風險。因此,應(yīng)仔細控制相關(guān)的超參數(shù)和變化程度。此外,模式連接需要微調(diào)或參數(shù)更改,這可能會增加訓(xùn)練時間和資源消耗。綜上所述,模型連通性在模型融合方面具有諸多優(yōu)勢,包括幫助克服局部最優(yōu)問題、提供解釋網(wǎng)絡(luò)行為的新視角等。未來,模式連接有望幫助理解神經(jīng)網(wǎng)絡(luò)的內(nèi)部機制并提供指導(dǎo) 以便將來進行更高效的深度模型融合設(shè)計。

由于來自不同網(wǎng)絡(luò)的通道和組件的隨機性,網(wǎng)絡(luò)的活動組件相互干擾[204]。因此,未對齊的加權(quán)平均值可能會忽略不同模型中單位之間的對應(yīng)關(guān)系并損壞有用信息。例如,不同模型中的兩個神經(jīng)元之間存在一種關(guān)系,它們可能完全不同但功能相似。對齊是將不同模型的單元進行匹配,從而為深度模型融合獲得更好的初始條件。其目的是使多個模型的差異更小,從而增強深度模型融合效果。此外,對齊本質(zhì)上可以被視為組合優(yōu)化問題。一種代表性機制“Re-basin”,它為各個流域提供解決方案,合并具有更好原始條件的模型。根據(jù)對齊目標是否是數(shù)據(jù)驅(qū)動的,對齊分為“激活匹配”和“權(quán)重匹配”兩種類型,如表所示。

一般來說,即使對于淺層神經(jīng)網(wǎng)絡(luò),鞍點和局部最優(yōu)的數(shù)量也會隨著參數(shù)數(shù)量呈指數(shù)增長[10, 66]。研究發(fā)現(xiàn),訓(xùn)練中存在不變性,導(dǎo)致這些局部最優(yōu)中的某些點具有相同的表示形式 [22,81,140]。具體來說,如果通過排列交換隱藏層的單元,則網(wǎng)絡(luò)的功能不會改變,這稱為排列對稱性[43, 50]。

這些不變性帶來的排列對稱性有助于更好地理解損失圖的結(jié)構(gòu) [22, 66]。不變性也可以被視為損失圖中鞍點的來源[14]。[68]研究神經(jīng)網(wǎng)絡(luò)中對稱性的代數(shù)結(jié)構(gòu)以及這種結(jié)構(gòu)如何在損失圖幾何中表現(xiàn)出來。[14]在高維平臺引入排列點,在該點可以交換神經(jīng)元,而不會增加損失或參數(shù)跳躍。對損失進行梯度下降,調(diào)整神經(jīng)元m和n的參數(shù)向量θm和θn,直到向量到達排列點。

基于排列對稱性,權(quán)空間中不同區(qū)域的解可以生成等價解。等效解位于與原始解相同的區(qū)域,具有低損失屏障(盆地),稱為“Re-basin”[3]。與模式連接相比,Re-basin傾向于通過排列而不是低損失隧道的方式將點傳輸?shù)脚璧刂小D壳埃瑢R是Re-basin的代表性方法[3, 178]。然而,如何高效地搜索排列對稱性的所有可能性,使得所有解都指向同一個盆地是當前的挑戰(zhàn)。

如圖是【14】引入排列點交換神經(jīng)元的示意圖。左:一般對齊過程,模型A參考模型B轉(zhuǎn)化為模型Ap,然后Ap和B的線性組合產(chǎn)生C。右:調(diào)整不同隱藏層兩個神經(jīng)元的參數(shù)向量θm和θn接近排列點,在排列點[14]θ′m = θ′n,兩個神經(jīng)元計算相同的函數(shù),這意味著兩個神經(jīng)元可以交換。

對齊通過調(diào)整模型的參數(shù)使模型更加相似,可以提高模型之間的信息共享,從而提高融合模型的泛化能力。此外,對齊有助于提高模型在復(fù)雜任務(wù)上的性能和魯棒性。然而,對齊方法面臨著組合優(yōu)化速度慢的問題。對齊需要額外的計算開銷來調(diào)整模型的參數(shù),這可能導(dǎo)致更復(fù)雜且耗時的訓(xùn)練過程,特別是在大深度模型中[142, 204]。

綜上所述,對齊可以提高不同模型之間的一致性和整體效果。隨著DL應(yīng)用場景的多樣化,對齊將成為優(yōu)化深度模型融合、提高泛化能力的關(guān)鍵方法之一。未來,對齊可以在遷移學習、域自適應(yīng)[63]、知識蒸餾等領(lǐng)域發(fā)揮作用。例如,對齊可以減少遷移學習中源域和目標域之間的差異,提高對新域的學習 。

由于神經(jīng)網(wǎng)絡(luò)參數(shù)的高度冗余,不同神經(jīng)網(wǎng)絡(luò)的權(quán)值之間通常不存在一一對應(yīng)的關(guān)系。因此,通常不能保證權(quán)重平均(WA) 在默認情況下表現(xiàn)良好。對于權(quán)重差異較大的訓(xùn)練網(wǎng)絡(luò),普通平均值表現(xiàn)不佳[204]。從統(tǒng)計的角度來看,WA允許控制模型中的各個模型參數(shù),從而減少最終模型的方差,從而對正則化屬性和輸出結(jié)果產(chǎn)生可靠的影響[77, 166]。

下表是WA的代表性方法:

受快速幾何集成 (FGE) [66] 和檢查點平均 [149] 的啟發(fā),[99]利用恒定或周期性學習率對SGD軌跡的多個點進行平均,這被視為隨機權(quán)重平均(SWA)。SWA 改進了一系列重要基線的訓(xùn)練,提供了更好的時間可擴展性。SWA 不是訓(xùn)練一組收集的模型(如普通融合),而是訓(xùn)練單個模型來找到比 SGD 更平滑的解決方案。在下表中列出了與 SWA 相關(guān)的方法。此外,SWA 可以應(yīng)用于任何架構(gòu)或數(shù)據(jù)集,并展示出比快照集成 (SSE) [91] 和 FGE 更好的性能。在每個周期結(jié)束時,對新獲得的權(quán)重與現(xiàn)有權(quán)重進行平均來更新 SWA 模型。

然而SWA只能對局部最優(yōu)點附近的點進行平均,最終得到一個相對最小值,而不能準確逼近最優(yōu)值。另外,由于某些因素(如前期收斂性差、學習率大、權(quán)重變化率快等),最終的輸入樣本偏差可能較大或不充分,導(dǎo)致整體效果不佳。大量工作往往會改變 SWA 的采樣方法。

如圖不同SWA相關(guān)方法的采樣和學習率安排比較。(a) SWA:恒定學習率。(b)SWA:周期性學習率。(c)SWAD:密集采樣。(d)HWA:利用在線和離線WA,以不同的同步周期采樣,滑動窗口長度為h。

模型湯[239]是指對用不同超參微調(diào)的模型進行平均的方法。它簡單但有效,在 ImageNet-1K 上實現(xiàn)了 90.94% 的準確率,超過了之前在 CoAtNet-7 (90.88%) [38] 和 ViT-G (90.45%) [255] 上的工作。如表總結(jié)了不同的模型湯方法。

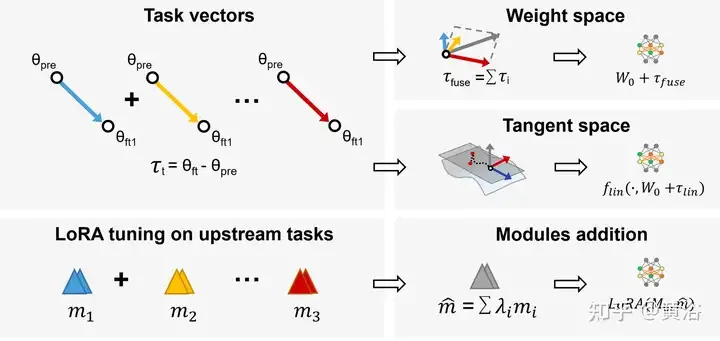

在 多任務(wù)學習(MTL )中,預(yù)訓(xùn)練模型和任務(wù)向量(即 τi = Wft ? Wpre,預(yù)訓(xùn)練模型和微調(diào)模型之間的差異)相結(jié)合,在所有任務(wù)上獲得更好的性能。基于這一觀察,任務(wù)算術(shù)[94]通過加法和線性組合微調(diào)任務(wù)向量來提高模型在任務(wù)上的性能,這已成為直接編輯預(yù)訓(xùn)練模型的靈活高效的方法,如圖所示:采用任務(wù)算術(shù)和LoraHub(Low-rank adaptations Hub)。

另外,子空間中的模型融合將訓(xùn)練軌跡限制在低維子空間中,可減少負載和難度。

WA 通過平均不同深度模型的權(quán)重來獲得最終模型,無需額外的計算復(fù)雜性或訓(xùn)練過程[109, 159]。一般來說,如果隨機模型在表示能力、結(jié)構(gòu)或訓(xùn)練數(shù)據(jù)方面存在顯著差異,則融合的結(jié)果可能無法達到預(yù)期的性能。使用相同的超參配置但具有不同的數(shù)據(jù)順序從頭開始對模型進行線性插值甚至不如隨機模型有效[59]。因此,大量提出的方法旨在以其他數(shù)學方式優(yōu)化 WA 過程。

此外,當模型共享其優(yōu)化軌跡的一部分(例如,檢查點平均、尾部平均、SWA [99, 149] 等)或在相同的預(yù)訓(xùn)練模型上進行微調(diào)時(例如,模型湯 [239] 等),插值模型的準確性表現(xiàn)更好[167]。此外,模型湯[239]對具有不同超參配置的模型進行平均以獲得最終結(jié)果。此外,在模型平均值中選擇適當?shù)臋?quán)重也可能是一個挑戰(zhàn),這通常充滿主觀性。更復(fù)雜的權(quán)重選擇機制可能需要大量復(fù)雜的試驗和交叉驗證。

WA是深度學習中一種很有前景的技術(shù),未來可以作為模型優(yōu)化技術(shù),減少不同迭代之間的權(quán)值波動,提高穩(wěn)定性和收斂速度。WA可以改進聯(lián)邦學習(FL)的聚合階段,以更好地保護隱私并降低未來的通信成本。此外,通過在終端設(shè)備上實施網(wǎng)絡(luò)壓縮,有望減少模型在資源受限設(shè)備上的存儲空間和計算開銷[250]。簡而言之,WA是一種有前途且具有成本效益的DL技術(shù),可以應(yīng)用于FL等領(lǐng)域,以提高性能并減少存儲開銷。

集成學習,或多分類器系統(tǒng),是一種集成多個單一模型來生成最終預(yù)測的技術(shù),包括投票、平均[195]等。它提高了整體性能并減少了模型的方差,解決了諸如過擬合、 不穩(wěn)定,數(shù)據(jù)量有限。

基于現(xiàn)有的預(yù)訓(xùn)練源模型,模型重用[266]提供了應(yīng)用于新任務(wù)所需的模型,而無需從頭開始重新訓(xùn)練新模型。它可以節(jié)省時間和計算資源,并在資源有限的情況下提供更好的性能[249]。另外,由于遷移學習的重點是解決目標域上的預(yù)測任務(wù),因此模型重用可以視為遷移學習的一種。但遷移學習需要源域和目標域的標記數(shù)據(jù),而在模型重用中,只能收集未標記的數(shù)據(jù),而不能使用源域的數(shù)據(jù)[153]。

與多分類器集成學習不同,大多數(shù)當前方法重用現(xiàn)有的特征、標簽或模態(tài)來獲得最終預(yù)測[176, 266],而不存儲大量訓(xùn)練數(shù)據(jù)[245]。模型重用的另一個關(guān)鍵挑戰(zhàn)是從一組針對給定學習任務(wù)的預(yù)訓(xùn)練模型中識別有用的模型。

使用單一模型進行模型重用會產(chǎn)生過多的同質(zhì)信息(例如,在一個域訓(xùn)練的模型可能不適合另一域的數(shù)據(jù)),并且很難找到完全適合目標域的單一預(yù)訓(xùn)練模型 。一般來說,用一組相似的模型來產(chǎn)生比單個模型更好的性能,這被表示為多模型重用(MMR)[153]。

下表比較不同復(fù)用方法的特點,簡而言之,模型復(fù)用可以顯著減少使用預(yù)訓(xùn)練模型所需的數(shù)據(jù)量,解決不同端之間傳輸數(shù)據(jù)時消耗大量帶寬的問題。多模型復(fù)用也有廣泛的應(yīng)用,例如語音識別、安全隱私交互系統(tǒng)、數(shù)字視網(wǎng)膜[64]等。

與聯(lián)邦學習[88,89,160]等對模型參數(shù)和規(guī)模有一定要求的相關(guān)模型融合算法相比,集成學習方法利用預(yù)測來組合多個異構(gòu)弱分類器,沒有這樣的限制。另外,集成方法中不同架構(gòu)的網(wǎng)絡(luò)會比WA有更明顯的比較效果。然而,集成方法需要維護和運行多個經(jīng)過訓(xùn)練的模型,并在測試時將它們一起運行。考慮到深度學習模型的規(guī)模和復(fù)雜性,這種方法不適合計算資源和成本有限的應(yīng)用程序[204]。

由于集成學習框架的多樣性,可以實現(xiàn)模型多樣性并增強泛化能力。將來,這對于處理數(shù)據(jù)變化和對抗性攻擊非常重要。深度學習中的集成學習有望為模型預(yù)測提供置信度估計和不確定性測量,這對于決策支持系統(tǒng)、自動駕駛[74]、醫(yī)療診斷等的安全性和可靠性至關(guān)重要。

近年來,深度模型融合領(lǐng)域出現(xiàn)了大量的新研究,也推動了相關(guān)應(yīng)用領(lǐng)域的發(fā)展。

聯(lián)邦學習

為了解決數(shù)據(jù)存儲的安全性和集中化挑戰(zhàn),聯(lián)邦學習(FL) [160, 170]允許許多參與模型協(xié)作訓(xùn)練共享的全局模型,同時保護數(shù)據(jù)隱私,而無需將數(shù)據(jù)集集中在中央服務(wù)器上。它也可以被視為多-方學習問題[177]。特別是,聚合是 FL 的一個重要過程,它包含了由各方(例如設(shè)備、組織或個人)訓(xùn)練的模型或參數(shù)更新。如圖演示了集中式和分散式 FL 中的兩種不同聚合方法。,左:中央服務(wù)器和客戶端終端之間的集中式聯(lián)邦學習,遷移模型或梯度,最終聚合在服務(wù)器上。右:分散式聯(lián)合學習在客戶端終端之間傳輸和聚合模型,無需中央服務(wù)器。

下表是聯(lián)邦學習的不同聚合方法:

簡而言之,F(xiàn)L 中聚合步驟的本質(zhì)是一種模型融合技術(shù)。選擇合理的模型融合方法可以減少特定參與者或個體數(shù)據(jù)對最終模型的影響,從而提高模型在全局范圍內(nèi)的泛化能力和適應(yīng)性。今后良好的聚合方法有望有助于應(yīng)對聯(lián)邦學習中的一系列挑戰(zhàn)。高質(zhì)量且可擴展的聚合方法預(yù)計將面臨FL的一系列挑戰(zhàn),例如客戶端異構(gòu)性、非獨立同分布異構(gòu)數(shù)據(jù)、有限的計算資源[141]等。FL有望展現(xiàn)其潛力在更多領(lǐng)域中,例如自然語言處理、推薦系統(tǒng)[146]、醫(yī)學圖像分析[144]等。

微調(diào)

微調(diào)是一個基本模式(例如預(yù)訓(xùn)練模型),是調(diào)整模型以執(zhí)行下游任務(wù)的有效方法 [23, 41],這可以使用更少的標記數(shù)據(jù)獲得更好的泛化和更準確的輸出。與隨機初始化相比,預(yù)訓(xùn)練模型是通過相對一組特定于任務(wù)的數(shù)據(jù)來訓(xùn)練的,這始終是更好的訓(xùn)練標準起點。盡管如此。現(xiàn)有微調(diào)模型 [28, 29] 的平均值甚至是比普通預(yù)訓(xùn)練模型更好的基礎(chǔ)模型,用于對下游任務(wù)進行微調(diào)。

此外,最近有大量將 WA 與微調(diào)相結(jié)合的工作,如圖所示,例如 model soup [239]、DiWA [190] 等。微調(diào)提高了目標分布的準確性,但往往導(dǎo)致分布變化的穩(wěn)健性下降。對微調(diào)模型進行平均的策略可能很簡單,但它們沒有充分利用每個微調(diào)模型之間的連接。因此,在目標任務(wù)訓(xùn)練之前先進行中間任務(wù)訓(xùn)練可以探索基礎(chǔ)模型的能力[180,185,224]。受相互訓(xùn)練策略 [185] 的啟發(fā),[188]微調(diào)輔助任務(wù)的模型,利用不同的輔助任務(wù)并提高分布外(OOD)泛化能力。

微調(diào)模型的平均值減少了實現(xiàn)目標所需的訓(xùn)練時間[28],并生成更準確和更好的泛化模型。本質(zhì)上,不同的微調(diào)方式(例如,凍結(jié)層微調(diào)、頂層微調(diào)等)也會對最終的精度和分布偏移產(chǎn)生一定的影響[240]。然而,WA和微調(diào)的結(jié)合是昂貴的開銷,對具體應(yīng)用有一定的限制。此外,它可能面臨保存檢查點爆炸或災(zāi)難性遺忘的問題[121],特別是應(yīng)用于遷移學習。

知識蒸餾

知識蒸餾(KD)[83]是集成多個模型的重要方法,涉及以下兩類模型。教師模型是指在大規(guī)模數(shù)據(jù)上訓(xùn)練的大型且強大的模型,具有較高的預(yù)測能力和表達能力。學生模型是一個相對較小的模型,具有較少的參數(shù)和計算資源 [18, 199]。利用教師的知識(例如輸出概率分布、隱藏層表示等)指導(dǎo)訓(xùn)練,學生可以用更少的資源和更快的速度達到接近大型模型的預(yù)測能力[2, 119, 124 ,221]。考慮到多個教師或?qū)W生的表現(xiàn)預(yù)計比單個模型[6]更好,根據(jù)聚合目標將 KD 分為兩類,如圖所示。

第一類方法是合并多個教師模型并直接提取學生模型,如表所示。目前,最近的工作主要集成教師的輸出(例如,logits [6,49,252]或特征) 基礎(chǔ)知識 [143, 241] 等)。

另一種方法是使用教師模型提取多個學生,然后合并這些學生模型。然而,合并多學生也存在一些問題,例如計算資源需求大、解釋性差以及過度依賴原始模型等。

基礎(chǔ)模型/LLMs的模型融合

基礎(chǔ)模型在處理復(fù)雜任務(wù)時表現(xiàn)出強大的性能和突現(xiàn)能力,大型基礎(chǔ)模型的特點是其龐大的規(guī)模,包含數(shù)十億個參數(shù),幫助學習數(shù)據(jù)中的復(fù)雜模式。特別是,隨著最近新的LLM [200, 264]的出現(xiàn),如GPT-3 [17, 172],T5 [187],BERT [41],Megatron-LM,WA的應(yīng)用[154, 212, 256] ] LLM引起了更多關(guān)注。

此外,最近的工作 [120, 256] 傾向于設(shè)計更好的框架和模塊來適應(yīng)應(yīng)用LLM。由于高性能和低計算資源,對大型基礎(chǔ)模型進行微調(diào)可以提高分布變化的魯棒性[240]。