Ilya認(rèn)錯(cuò),Scaling Law崩了?自曝SSI秘密技術(shù)路線取代OpenAI

昨天,The Information爆料,傳統(tǒng)的大模型Scaling Law已經(jīng)撞墻,OpenAI下一代旗艦Orion遭遇瓶頸。

就在剛剛,路透社也發(fā)文表示,由于當(dāng)前方法受到限制,OpenAI和其他公司正在尋求通向更智能AI的新途徑。

有趣的是,昨天拱火的The Information,今天又急忙發(fā)出一篇文章來(lái)滅火。

他們強(qiáng)調(diào),昨天的文章只是在說(shuō)改進(jìn)大模型必須找到新方法,并不是說(shuō)Scaling Law已經(jīng)終結(jié)。

但一個(gè)不爭(zhēng)的事實(shí)就是:硅谷幾大主要AI實(shí)驗(yàn)室正在陷入困境。訓(xùn)練這些大規(guī)模的LLM動(dòng)輒需要花費(fèi)數(shù)千美元,但復(fù)雜系統(tǒng)還經(jīng)常崩潰。往往需要數(shù)月時(shí)間,才知道模型能否按預(yù)期工作。

比起GPT-4o,Orion幾乎沒(méi)有任何改進(jìn);谷歌的Gemini 2.0,被曝也存在同樣問(wèn)題;Anthropic據(jù)傳也已暫停Opus 3.5模型的工作。

據(jù)悉,谷歌正準(zhǔn)備在12月推測(cè)出最新的Gemini 2.0,它可能無(wú)法實(shí)現(xiàn)DeepMind創(chuàng)始人Demis Hassabis團(tuán)隊(duì)預(yù)期的顯著性能改進(jìn),但會(huì)有引入一些有趣的新功能

Anthropic首席執(zhí)行官Dario Amodei 表示,「我們的目標(biāo)是改變曲線,然后在某個(gè)時(shí)候成為Opus 3.5」

而離職創(chuàng)業(yè)的OpenAI元老則Ilya Sutskever則表示,現(xiàn)在重要的是「擴(kuò)大正確的規(guī)模」。

「2010年代是scaling的時(shí)代,現(xiàn)在,我們?cè)俅位氐搅似孥E和發(fā)現(xiàn)的時(shí)代。每個(gè)人都在尋找下一個(gè)奇跡。」

對(duì)經(jīng)營(yíng)著自己的AI實(shí)驗(yàn)室SSI的Ilya來(lái)說(shuō),這是一個(gè)很大的改變。

曾經(jīng)在推動(dòng)OpenAI的GPT模型時(shí),他的準(zhǔn)則是「越大越好」。但在SSI的最近一輪融資中,Ilya開(kāi)始希望嘗試一種與OpenAI不同的Scaling方法。

Scaling Law大家都說(shuō)得夠多了。但有一個(gè)問(wèn)題,卻被每個(gè)人都忽略了——我們說(shuō)scaling的時(shí)候,究竟在scaling什么?

如今,Ilya拋出了這個(gè)振聾發(fā)聵的疑問(wèn)。

Scaling正確的東西,比以往任何時(shí)候都更重要

畢竟,超大規(guī)模語(yǔ)言模型的ROI實(shí)在太低了。

雖然在GPT-4發(fā)布后,各大AI實(shí)驗(yàn)室的研究人員都競(jìng)相追趕,發(fā)布了超過(guò)GPT-4的大模型,但他們更多的感覺(jué)是失望。

因?yàn)橐瑫r(shí)運(yùn)行數(shù)百個(gè)芯片,這種超大參數(shù)模型的訓(xùn)練可能要花費(fèi)數(shù)千萬(wàn)美元,系統(tǒng)太復(fù)雜還可能會(huì)出現(xiàn)硬件故障。但只有經(jīng)過(guò)數(shù)月,等到運(yùn)行結(jié)束后,研究人員才能知道模型的最終性能。

另一個(gè)問(wèn)題,就是LLM吞噬了大量數(shù)據(jù),而世界上易于獲取的數(shù)據(jù),幾乎已經(jīng)被耗盡了!

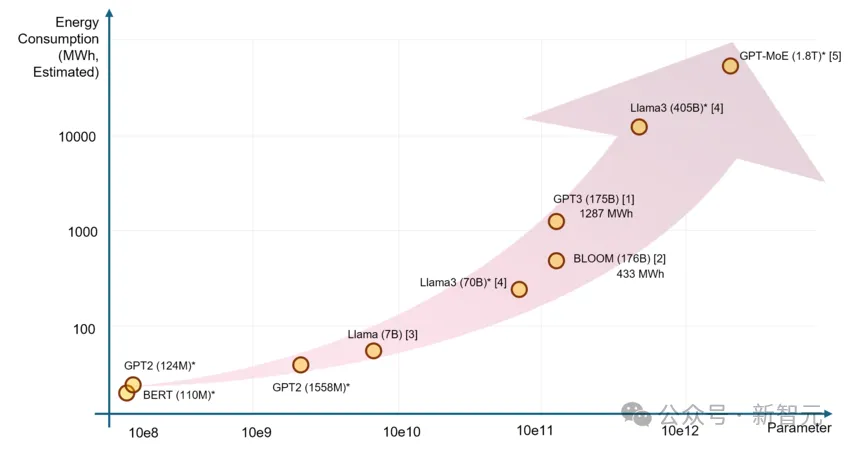

同時(shí),由于過(guò)程中需要大量能源,電力短缺也成為訓(xùn)練AI的嚴(yán)重阻礙。

論文題目:「The Unseen AI Disruptions for Power Grids: LLM-Induced Transients」

替代Scaling的新方法,Ilya已經(jīng)有了?

面對(duì)這種種現(xiàn)狀,Ilya最近在路透社的采訪中表示,擴(kuò)展訓(xùn)練的結(jié)果,已經(jīng)趨于平穩(wěn)。

也就是說(shuō),用大量未標(biāo)記數(shù)據(jù)來(lái)理解語(yǔ)言模式和結(jié)構(gòu)的訓(xùn)練階段到頭了。

以前,Ilya是暴力scaling的早期倡導(dǎo)者之一,那時(shí)有一種想法廣泛認(rèn)為,通過(guò)預(yù)訓(xùn)練中使用更多的數(shù)據(jù)和算力,能讓AI模型的性能暴漲。

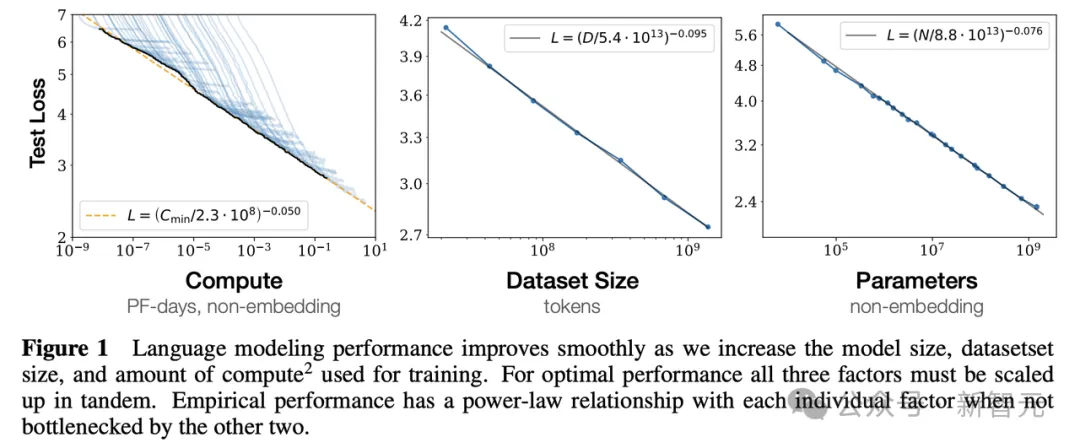

OpenAI團(tuán)隊(duì)2020年提交的arXiv論文中最先提出這一概念:LLM性能與計(jì)算量、參數(shù)量、數(shù)據(jù)量三者呈現(xiàn)冪律關(guān)系

的確,沿著這條路線,最終ChatGPT誕生了。

ChatGPT發(fā)布后,從AI熱潮中受益頗多的科技公司都公開(kāi)聲稱,這種通過(guò)增加數(shù)據(jù)和算力來(lái)「scale up」的方法,能顯著改善模型性能。

可是現(xiàn)在,Scaling Law已經(jīng)碰壁了!越來(lái)越多的AI科學(xué)家,對(duì)于這種「越大越好」(bigger is better)的哲學(xué)產(chǎn)生了質(zhì)疑。

2010年代屬于Scaling,但大模型要繼續(xù)發(fā)展下去,需要一個(gè)新的奇跡。

Ilya的SSI團(tuán)隊(duì)是否找到了呢?

對(duì)此,Ilya拒絕透露,只是表示,SSI正在研究一種全新的替代方法,來(lái)擴(kuò)展預(yù)訓(xùn)練。

再領(lǐng)先三步?OpenAI破局新方法:測(cè)試時(shí)計(jì)算

同時(shí),OpenAI仿佛也找到了新方法——通過(guò)開(kāi)發(fā)使用更類人思維的算法訓(xùn)練技術(shù),或許就能克服在追求更大規(guī)模LLM過(guò)程中遇到的意外延遲和挑戰(zhàn)。

已經(jīng)有十幾位AI科學(xué)家、研究人員和投資者告訴路透社,他們認(rèn)為正是這些技術(shù),推動(dòng)了OpenAI最近發(fā)布的o1模型。

而它們,可能會(huì)重塑AI競(jìng)賽的格局,讓AI公司們不再對(duì)能源和芯片資源產(chǎn)生無(wú)限制的需求。

有沒(méi)有這么一種新方法,讓AI模型既能擺脫對(duì)數(shù)據(jù)的依賴,又不再需要?jiǎng)虞m吞噬整個(gè)國(guó)家乃至全球的電力?

為了克服這些挑戰(zhàn),研究人員正在探索一項(xiàng)「測(cè)試時(shí)計(jì)算」的技術(shù)。

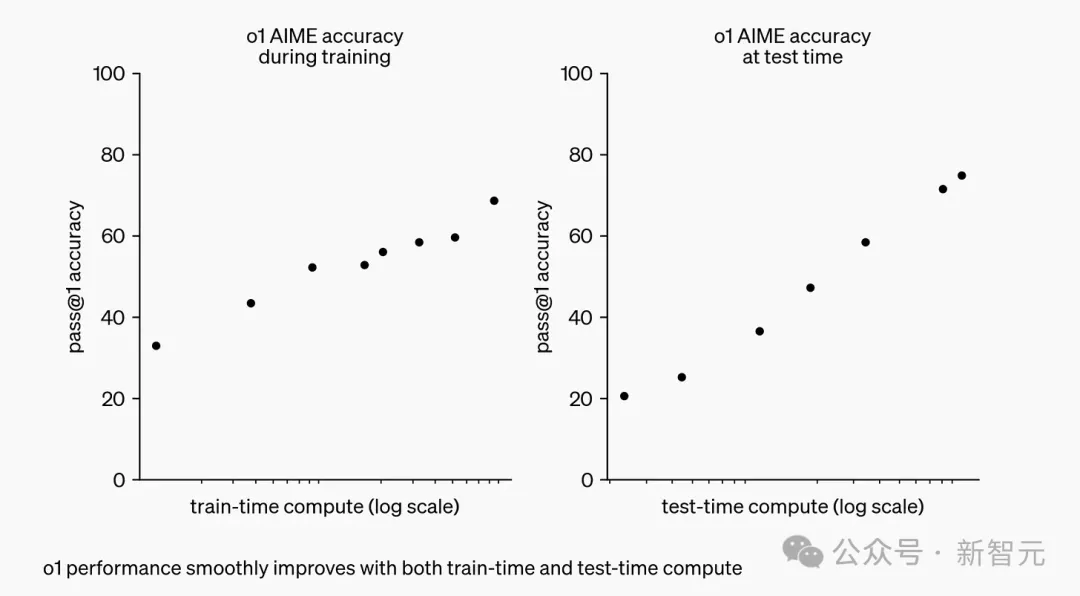

上圖即是OpenAI解釋o1的博文,x軸標(biāo)記為「訓(xùn)練時(shí)計(jì)算」和「測(cè)試時(shí)計(jì)算」。

左圖是OpenAI發(fā)現(xiàn)的Scaling Law,意味著在模型上投入更多訓(xùn)練時(shí)間(GPU周期)時(shí),我們可以獲得更好的結(jié)果。

右圖則暗示了我們尚未觸及的一套全新的Scaling Law。「測(cè)試時(shí)計(jì)算」意味著,給模型更多的「思考時(shí)間」(GPU周期)時(shí),它會(huì)思考出更好的結(jié)果。

測(cè)試時(shí)計(jì)算技術(shù),能在推理階段(模型被使用時(shí))就將模型增強(qiáng),比如,模型可以實(shí)時(shí)生成和評(píng)估多種可能性,而不是理解選擇單一答案。最終,模型就可以選擇出最佳路徑。

這種方法可以允許模型將更多的處理能力,用于數(shù)學(xué)、編碼問(wèn)題等具有挑戰(zhàn)性的任務(wù),或者需要類人推理和決策的復(fù)雜操作。

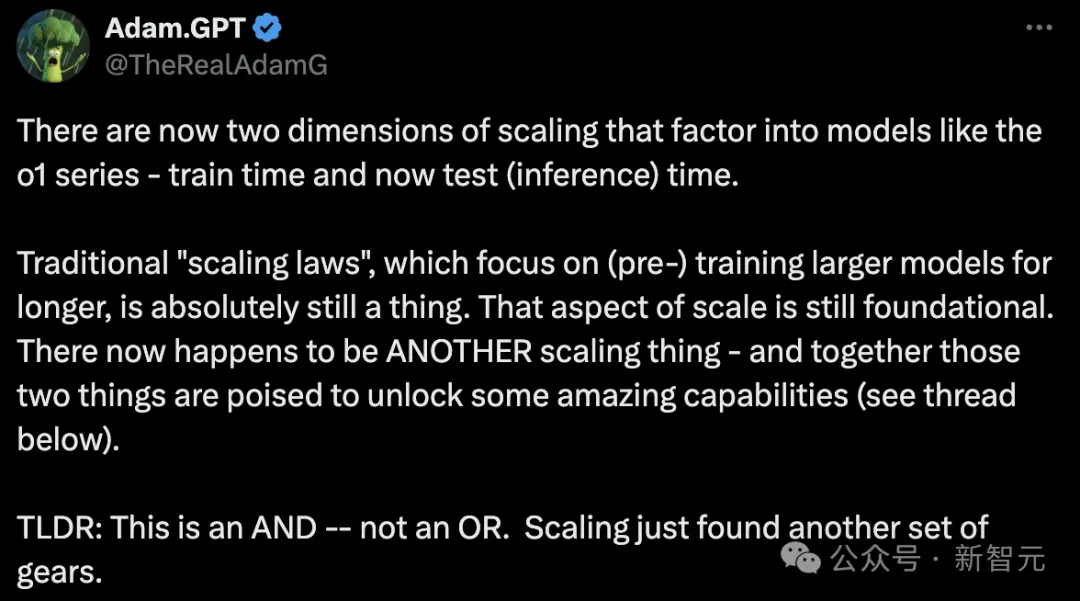

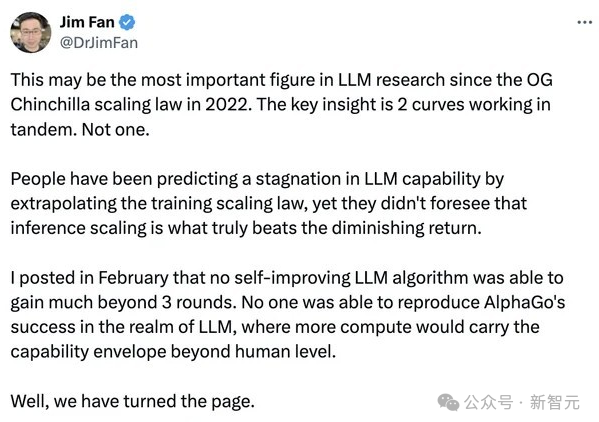

傳統(tǒng)的Scaling Law,專注于用更長(zhǎng)時(shí)間訓(xùn)練大模型,但如今o1系列模型scaling有了兩個(gè)維度——訓(xùn)練時(shí)間和測(cè)試(推理)時(shí)間

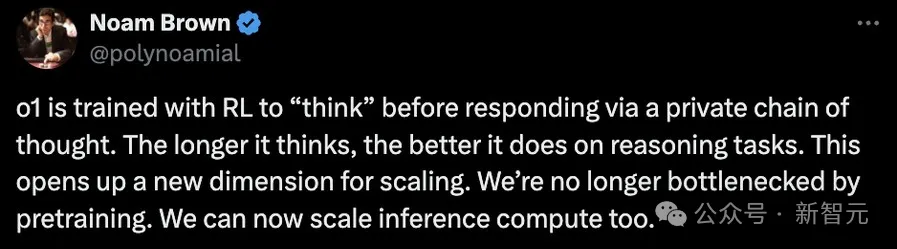

早在上個(gè)月的舊金山TED AI會(huì)議上,曾參與o1開(kāi)發(fā)的OpenAI研究員Noam Brown就提出——

事實(shí)證明,讓一個(gè)機(jī)器人在一局撲克中思考僅20秒,其性能提升與將模型規(guī)模擴(kuò)大10萬(wàn)倍并訓(xùn)練10萬(wàn)倍時(shí)間相同。

o1模型以前曾被稱為「Q*」和「Strawberry」。現(xiàn)在,它能夠以多步驟方法思考問(wèn)題,類似于人類推理。

現(xiàn)在,模型不再受限于預(yù)訓(xùn)練階段,還可以通過(guò)增加推理計(jì)算資源,來(lái)提升表現(xiàn)

而且,它還涉及了來(lái)自博士和行業(yè)專家策劃的數(shù)據(jù)和反饋。

o1系列的秘密武器,是在GPT-4等基礎(chǔ)模型上進(jìn)行的另一套訓(xùn)練,OpenAI還計(jì)劃,將這種技術(shù)應(yīng)用于更多更大的基礎(chǔ)模型。

OpenAI的首席產(chǎn)品官Kevin Well在十月的一次科技會(huì)議表示——

我們看到很多可以快速改進(jìn)這些模型的機(jī)會(huì),而且非常簡(jiǎn)單。到人們趕上來(lái)的時(shí)候,我們會(huì)嘗試再領(lǐng)先三步。

通過(guò)思維鏈提示,o1模型可以經(jīng)過(guò)訓(xùn)練生成長(zhǎng)長(zhǎng)的輸出,并通過(guò)答案進(jìn)行推理

全球頂尖AI實(shí)驗(yàn)室開(kāi)卷,英偉達(dá)壟斷地位有望打破?

OpenAI說(shuō)要領(lǐng)先三步,其他頂尖AI實(shí)驗(yàn)室豈甘落后?

據(jù)知情人士透露,來(lái)自Anthropic、xAI和谷歌DeepMind的研究人員,也已經(jīng)奮力開(kāi)卷了!

比如Meta最近提出了「思維偏好優(yōu)化」TPO,這種方法旨在教會(huì)LLM在回答一般任務(wù)(而不僅僅是數(shù)學(xué)或邏輯問(wèn)題)之前「思考」,而不需要特殊的訓(xùn)練數(shù)據(jù)。

論文地址:https://arxiv.org/pdf/2410.10630

而谷歌也在開(kāi)發(fā)一種新模型,同樣使用CoT方法解決多步驟問(wèn)題、生成多個(gè)答案,評(píng)估后選擇最佳答案。

這個(gè)過(guò)程同樣可以通過(guò)在推理中使用更多算力來(lái)增強(qiáng),而非僅僅增加訓(xùn)練數(shù)據(jù)和算力,這就為擴(kuò)展AI模型開(kāi)辟了一條新道路。

論文地址:https://arxiv.org/pdf/2408.03314

這會(huì)導(dǎo)致什么后果?

很有可能,對(duì)英偉達(dá)GPU巨大需求主導(dǎo)的AI硬件競(jìng)爭(zhēng)格局,將從此改變。

這是因?yàn)椋ㄟ^(guò)增加訓(xùn)練時(shí)間和測(cè)試(推理)時(shí)間,可能會(huì)獲得更好的結(jié)果,模型就不再需要那么大的參數(shù)。

而訓(xùn)練和運(yùn)行較小模型會(huì)更便宜,因此,在給定固定計(jì)算量的情況下,我們可能會(huì)突然從小模型中獲得更多收益。

突然之間,模型參數(shù)、訓(xùn)練時(shí)間和測(cè)試時(shí)間計(jì)算之間的關(guān)系變得復(fù)雜了,也就讓我們看到了下一代GPU的可能。

比如Groq這樣的公司,恰巧就在為這類任務(wù)制造專門(mén)的芯片。

今年2月登場(chǎng)的世界最快大模型Groq,每秒500 token直接破了紀(jì)錄,自研的LPU在LLM任務(wù)上比英偉達(dá)GPU性能快了10倍。

紅杉資本和A16z在內(nèi)的著名風(fēng)投機(jī)構(gòu),如今已經(jīng)投入了數(shù)十億美元,資助OpenAI、xAI等多家AI實(shí)驗(yàn)室的開(kāi)發(fā)。

他們不可能不注意到最近圈內(nèi)盛傳的Scaling Law碰壁事件,而重新考慮自己的昂貴投資是否會(huì)打水漂。

紅杉資本合伙人Sonya Huang表示,這種轉(zhuǎn)變,將使我們從大規(guī)模預(yù)訓(xùn)練集群轉(zhuǎn)向推理云,即分布式的、基于云的推理服務(wù)器。

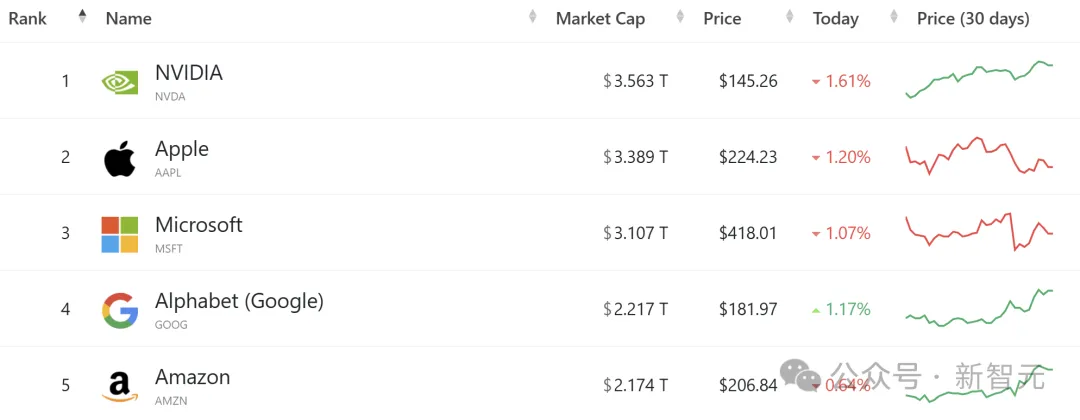

大模型熱以來(lái),對(duì)英偉達(dá)尖端AI芯片的需求,已經(jīng)讓它崛起為全球最有價(jià)值的公司,并且市值超越了蘋(píng)果。

今年以來(lái),英偉達(dá)股價(jià)了約186%,而蘋(píng)果僅上漲了17%

雖然在訓(xùn)練芯片的市場(chǎng),英偉達(dá)已經(jīng)占據(jù)主導(dǎo)地位,但它在推理市場(chǎng),可能還會(huì)面臨更多競(jìng)爭(zhēng)。

而o1模型背后技術(shù),意味著對(duì)推理芯片的需求也會(huì)隨著增加。

「我們現(xiàn)在發(fā)現(xiàn)了第二個(gè)Scaling Law,這是在推理階段的Scaling Law……所有這些因素導(dǎo)致對(duì)Blackwell的需求非常高。」

在英偉達(dá)GTC大會(huì)上,黃仁勛也講到,如果要訓(xùn)練一個(gè)1.8萬(wàn)億參數(shù)量的GPT模型,需要8000張H100 GPU,消耗15兆瓦的電力,連續(xù)跑上90天

隨著Scaling Law碰壁,各大公司紛紛開(kāi)啟新路線,英偉達(dá)是否還會(huì)繼續(xù)坐火箭般的輝煌呢?

再見(jiàn),GPT。你好,推理「o」

The Information今天的解釋文章,標(biāo)題意味深長(zhǎng):《再見(jiàn),GPT。你好,推理「o」》。

文章內(nèi)容是這樣的。

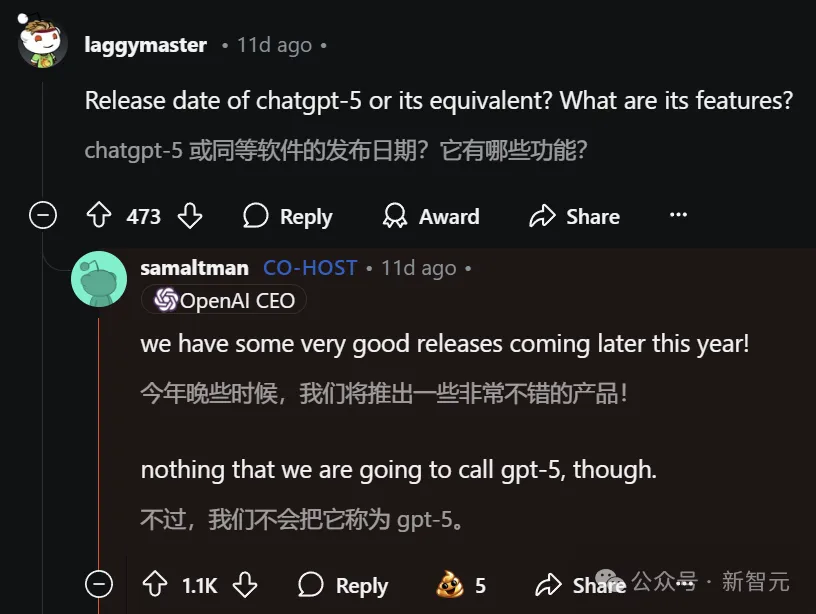

月初,一位Reddit用戶曾在QA種問(wèn)道,OpenAI的下一代旗艦大語(yǔ)言模型何時(shí)發(fā)布。

對(duì)此,Altman回答說(shuō):「今年晚些時(shí)候,我們會(huì)發(fā)布一些非常不錯(cuò)的產(chǎn)品,但并不會(huì)叫做GPT-5。」隨后他又補(bǔ)充道,有限的計(jì)算資源意味著很難同時(shí)推出過(guò)多的項(xiàng)目。

當(dāng)時(shí)我們并未多想。

但如今,我們更能理解Altman的評(píng)論了——以及他為何專注于推出o系列推理模型而非另一版本的GPT 。

所謂GPT,即生成式預(yù)訓(xùn)練Transformer模型,是ChatGPT和大多數(shù)其他生成式人工智能產(chǎn)品的基石。

原因正如之前報(bào)道的那樣,GPT的改進(jìn)速度正在放緩。

2023年初登場(chǎng)的上一代旗艦級(jí)模型GPT-4,憑借著巨大的性能提升在科技行業(yè)引發(fā)了轟動(dòng)。

Orion比GPT-4更好,但其質(zhì)量提升與GPT-3和GPT-4之間的差距相比略顯遜色。甚至,可能會(huì)讓OpenAI放棄自2018年推出GPT-1起使用的「GPT」命名慣例。

因此,當(dāng)Altman寫(xiě)道「o1及其后續(xù)版本」時(shí),可能意味著Orion將與推理融合并被命名為「o2」。

隨著一種Scaling Law的消退,另一種定律取而代之

讓我們回到GPT發(fā)展放緩這個(gè)問(wèn)題上。

傳統(tǒng)的Scaling Law不僅僅意味著在大語(yǔ)言模型訓(xùn)練過(guò)程中需要更多的數(shù)據(jù)和計(jì)算能力才能獲得更好的結(jié)果。OpenAI的研究人員還做了各種其他有趣的事情,才使得GPT-4比GPT-3有了大幅提升。比如,引入被稱為模型稀疏性的概念。

隨著推理范式的出現(xiàn),預(yù)訓(xùn)練改進(jìn)的放緩變可以得到彌補(bǔ)——從本質(zhì)上講,它可能代表了一種新的Scaling Law。

OpenAI一再表示,推理模型的性能在回答問(wèn)題前有更多時(shí)間思考時(shí)會(huì)變得更好,這被稱為對(duì)數(shù)線性計(jì)算擴(kuò)展。

那么,這些變化是否意味著OpenAI的1000億美元超級(jí)計(jì)算集群的夢(mèng)想正在消退呢?對(duì)于這個(gè)問(wèn)題,可以肯定的是,所有主流的AI開(kāi)發(fā)者都在全速推進(jìn)極其昂貴的集群建設(shè)。

一方面是,大型集群上可以更好地在預(yù)訓(xùn)練后改進(jìn)這些模型、在后訓(xùn)練階段處理強(qiáng)化學(xué)習(xí)以及更新或微調(diào)模型。

另一方面是,即便預(yù)訓(xùn)練模型的改進(jìn)速度放緩,但只要自己能訓(xùn)出比競(jìng)爭(zhēng)對(duì)手略好的模型,就值得增加的數(shù)據(jù)中心投入。畢竟,LLM越好,將推理模型融入模型后獲得的結(jié)果就越好。

最后,如果GPT的發(fā)展沒(méi)有加速,是不是就意味著末日論者錯(cuò)了——AI不會(huì)進(jìn)入所謂的遞歸自我改進(jìn)循環(huán),在這個(gè)循環(huán)中,AI會(huì)一次又一次地找出如何制造下一個(gè)更好版本的自己(然后也許會(huì)征服我們所有人)?

對(duì)此,Marc Andreessen認(rèn)為,這種明顯的平臺(tái)期意味著這樣的恐懼目前看來(lái)是沒(méi)有根據(jù)的。