英偉達「世界基礎模型」誕生,引爆物理AI革命!75頁報告出爐,GitHub狂飆2k星

CES大會上,老黃稱,「AI下一個前沿就是物理AI」。

為此,英偉達重磅官宣了世界基礎模型開發平臺——Cosmos,其模型基于在200萬小時視頻上完成訓練。

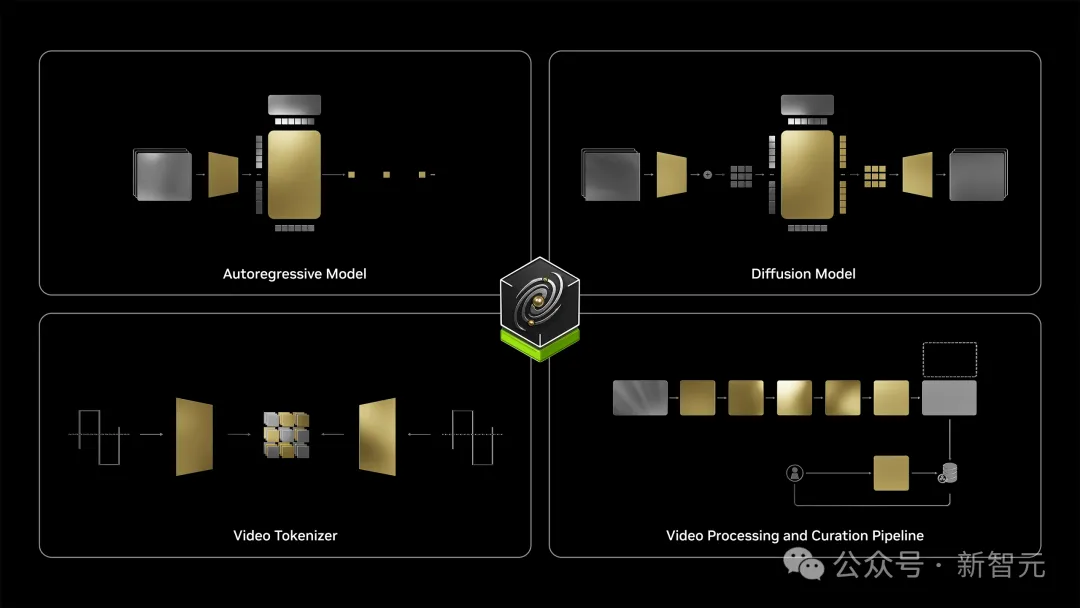

它一共包含了四大功能模塊:擴散模型、自回歸模型、視頻分詞器,以及視頻處理與編輯流程。

圖片

圖片

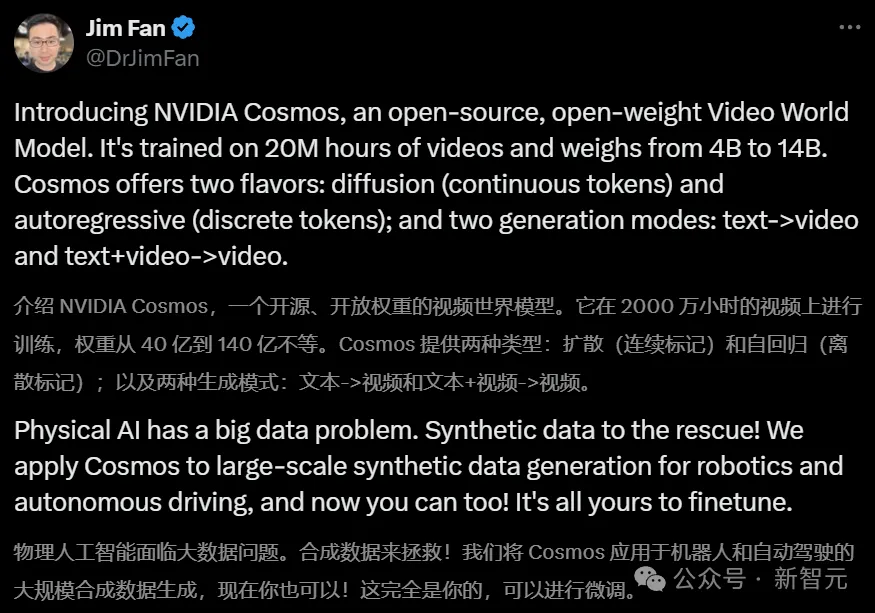

用英偉達高級科學家Jim Fan的話來總結:

- 兩種形式:擴散模型(生成連續的token);自回歸模型(生成離散的token)

- 兩種生成模式:文本->視頻;文本+視頻->視頻

圖片

圖片

Cosmos誕生就是為了拯救物理AI數據不夠的問題!現如今,開發者們可以直接生成合成數據,將其用于自動駕駛和機器人研究中。

它一共包含了三種規格的模型:Nano、Super、Ultra。

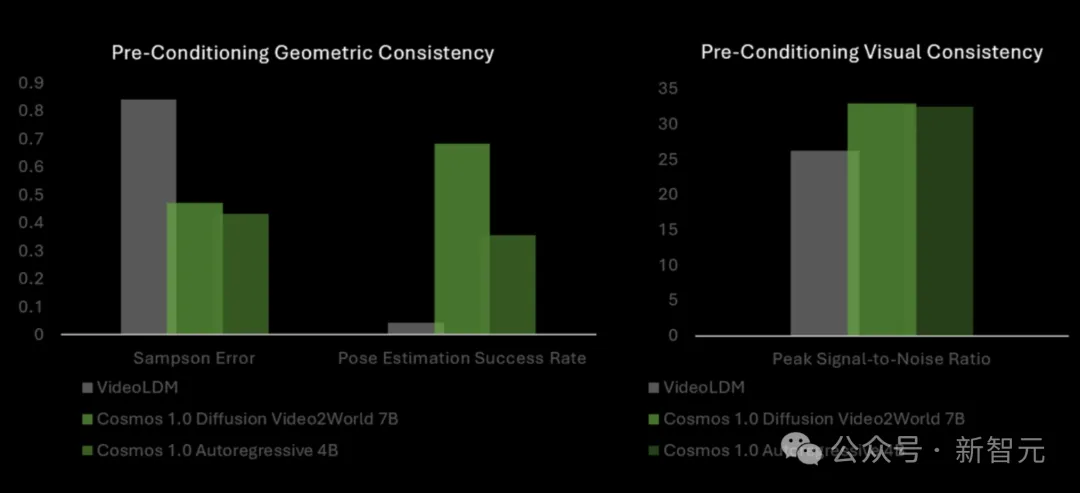

與VideoLDM基準相比,Cosmos世界模型在幾何準確性方面表現更優,而且在視覺一致性方面持續超越VLDM,姿態估計成功率最高飆升14倍。

圖片

圖片

圖片

圖片

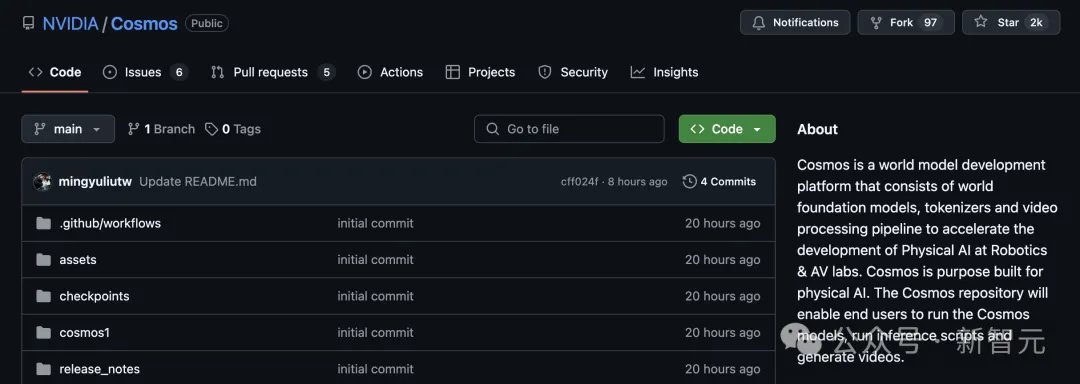

GitHub項目僅開源不到一天的時間,星標飆升至2k。

與此同時,關于Cosmos 75頁最詳細的技術報告也發布了。

圖片

圖片

開源項目:https://github.com/NVIDIA/Cosmos

圖片

圖片

論文地址:https://research.nvidia.com/publication/2025-01_cosmos-world-foundation-model-platform-physical-ai

Cosmos,定制世界模型

本文介紹了Cosmos世界基礎模型平臺,旨在幫助開發者構建定制化的世界模型。

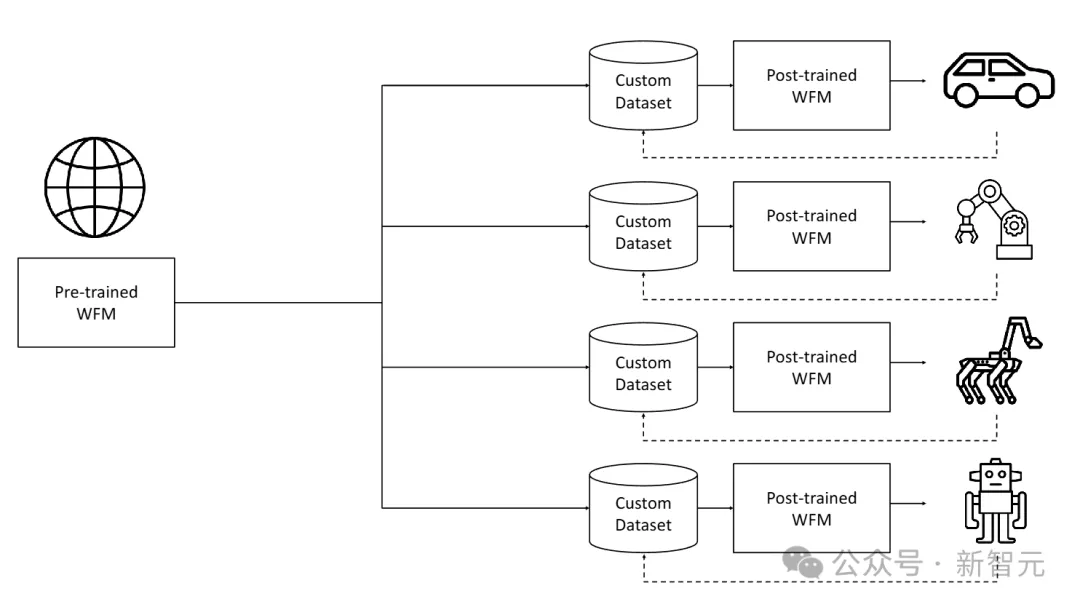

在預訓練中,研究者利用大規模的視頻數據集,讓模型接觸到多樣化的視覺數據,訓練一個通用型模型。預訓練的Cosmos世界基礎模型(WFM)能夠生成高質量、具有一致性的3D視頻。

在后訓練中,研究者從特定環境收集數據集,對預訓練模型進行微調,從而得到適用于特定目標的專用WFM。

圖片

圖片

預訓練的世界基礎模型(WFM)是通用的世界模型,通過大規模、多樣化的視頻數據集進行訓練。后訓練的數據集是從目標環境中收集的提示-視頻對。提示可以是動作指令、軌跡、說明等形式。

預訓練和后訓練相結合策略為構建物理AI系統提供了一種高效的方法。由于預訓練WFM提供了良好的基礎,后訓練的數據集可以相對較小。

圖片

圖片

世界基礎模型平臺

設??_0:??為從時間0到??的真實世界視覺觀測序列。

設??為對世界的擾動。如圖3所示,WFM是一種模型??,它根據過去的觀測??_0:??和當前擾動????,預測時間??+1的未來觀測值 。

。

在本案例中,??_0:??是一個RGB視頻(即彩色圖像視頻),而????是可以采取多種形式的擾動。例如,物理AI的動作、隨機擾動或描述擾動的文本等。

世界基礎模型(WFM)??是一種模型,它根據過去的觀測??_0:??和當前擾動????生成世界的未來狀態??_??+1

視頻編輯

研究者開發了一條可擴展的視頻數據編輯流程。

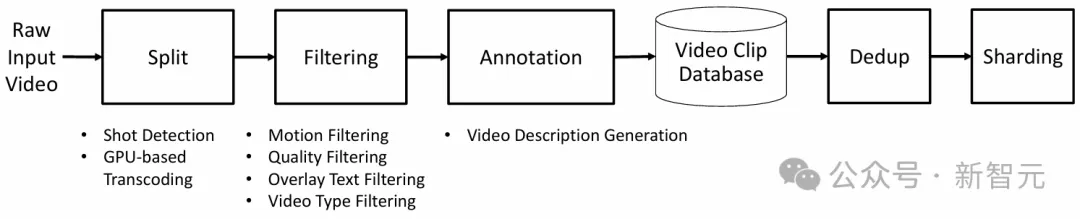

其中,每段視頻被分割為無場景變化的獨立鏡頭。通過過濾步驟定位高質量、動態且信息豐富的片段用于訓練。

這些高質量鏡頭隨后通過VLM(視覺語言模型)進行標注。接著執行語義去重,以構建一個多樣但緊湊的數據集。

視頻分詞

研究者開發了一系列具有不同壓縮比的視頻分詞器。這些分詞器是因果性的(即當前幀的token計算不依賴未來幀)。

這種因果性設計帶來了多個好處。在訓練方面,它使得聯合圖像和視頻訓練成為可能,因為當輸入為單張圖像時,因果性視頻分詞器也可以作為圖像分詞器。

這對于視頻模型利用圖像數據集進行訓練非常重要,因為圖像數據集包含豐富的世界外觀信息,且通常更加多樣化。

在應用方面,因果性視頻分詞器更適合生活在因果世界中的物理AI系統。

WFM預訓練

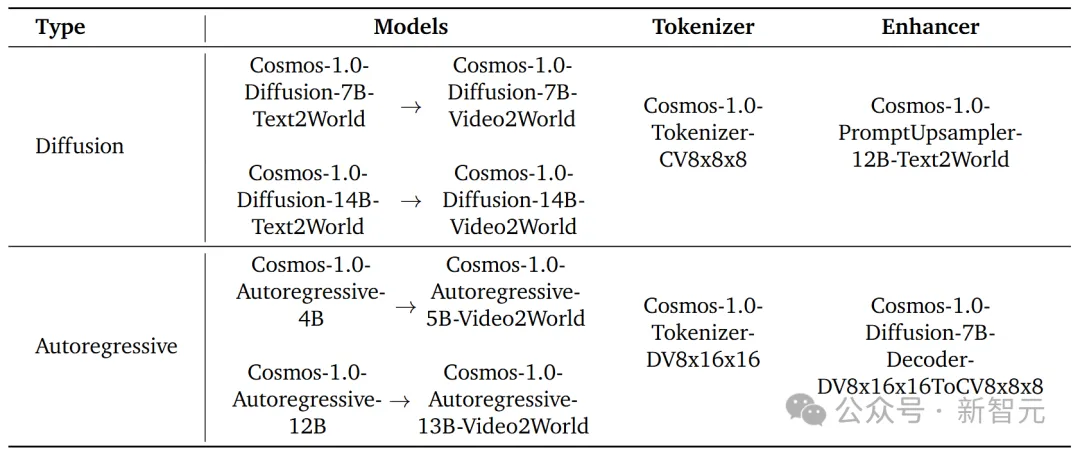

研究者探索了兩種可擴展的預訓練世界基礎模型的方法——擴散模型和自回歸模型。他們使用了Transformer架構,以實現可擴展性。

對于基于擴散的WFM,預訓練包括兩個步驟:

1. 文本到世界生成預訓練(Text2World generation pre-training)

2. 視頻到世界生成預訓練(Video2World generation pre-training)

具體來說,他們訓練了模型根據輸入的文本提示詞生成一個視頻世界。然后對其進行微調,使其能夠根據過去的視頻和輸入的文本提示詞生成未來的視頻世界,這被稱為視頻到世界生成任務(Video2World generation task)。

對于基于自回歸的 WFM,預訓練包括兩個步驟:

1. 基本的下一個token生成(vanilla next token generation)

2. 文本條件的視頻到世界生成(text-conditioned Video2World generation)

他們首先訓練模型根據過去的視頻輸入生成未來的視頻世界(前瞻生成)。然后對其進行微調,使其能夠根據過去的視頻和文本提示詞生成未來的視頻世界。

視頻到世界生成模型是一種基于當前觀測和提示詞預測未來的預訓練世界模型。

對于擴散模型和自回歸模型的WFM,研究者構建了一系列具有不同容量的模型,并研究了其在各種下游應用中的有效性。

他們進一步微調了預訓練的擴散WFM,以開發一個擴散解碼器來增強自回歸模型的生成結果。

為了更好地控制WFM,他們還基于LLM構建了一個提示詞上采樣器。

WFM后訓練

團隊展示了預訓練WFM在多個下游物理AI應用中的應用。

他們將預訓練的WFM微調為以相機姿態作為輸入提示詞,這讓他們能夠在創建的世界中自由導航。此外他們還展示了如何微調預訓練的WFM,以用于人形機器人和自動駕駛任務。

安全機制

為了安全使用開發的世界基礎模型,研究者開發了一個安全機制,用于阻止有害的輸入和輸出。

圖片

圖片

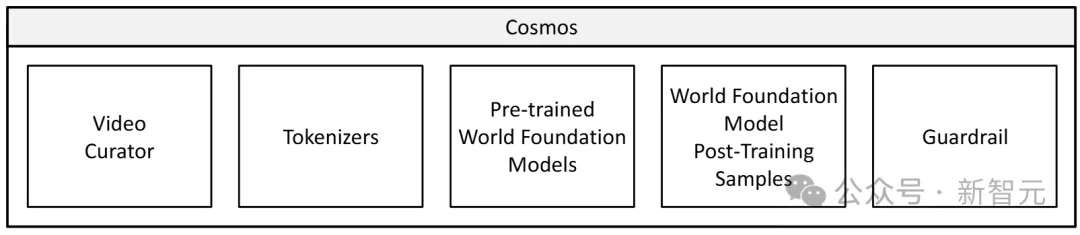

Cosmos世界基礎模型平臺由幾個主要組件組成:視頻編輯器、視頻分詞器、預訓練的世界基礎模型、世界基礎模型后訓練樣本,以及安全機制

他們相信,WFM對物理AI構建者有多種用途,包括(但不限于):

策略評估

與其通過在真實世界中運行物理AI系統來評估訓練后的策略,不如讓物理AI系統的數字副本與世界基礎模型交互。基于WFM的評估更加經濟高效且節省時間。

通過WFM,構建者可以在未見過的環境中部署策略模型,這些環境在現實中可能無法獲得。WFM幫助開發者快速排除不合格的策略,聚焦于潛力更大的策略。

策略初始化

策略模型根據當前觀測和給定任務,生成物理AI系統需要執行的動作。建模世界動態模式的高質量WFM,可以作為策略模型的良好初始化。

這有助于解決物理AI中的數據稀缺問題。

策略訓練

在強化學習設置中,WFM與獎勵模型配對,可以作為物理世界的代理,為策略模型提供反饋。智能體通過與WFM的交互,逐步掌握解決任務的能力。

規劃或模型預測控制

WFM可用于模擬物理AI系統在執行不同動作序列后,可能出現的未來狀態,然后通過成本/獎勵模塊量化這些不同動作序列的表現。

物理AI可以根據整體模擬結果執行最佳動作序列(如在規劃算法中),或以遞歸視界的方式執行(如在模型預測控制中)。

世界模型的準確性決定了這些決策策略的性能上限。

合成數據生成

WFM不僅可用于生成用于訓練的合成數據,還可以微調為基于渲染元數據(如深度圖或語義圖)進行條件生成。條件 WFM可用于Sim2Rea 場景。

數據編輯

研究者提出了一種視頻處理流程,用于為分詞器和WFM生成高質量訓練數據集。

如下圖所示,流程包括5個主要步驟:1)分割,2)過濾,3)標注,4)去重,以及5)分片。

這些步驟均經過專門的優化,從而提高數據質量并滿足模型訓練的需求。

圖片

圖片

預訓練數據集

研究者積累了大約2000萬小時的原始視頻,分辨率從720p到4k不等,并為預訓練生成了大約10^8個視頻片段,為微調生成了大約10^7個視頻片段。

其中,涵蓋了各種物理AI應用,并將訓練視頻數據集劃分為以下類別:

- 駕駛(11%)

- 手部動作和物體操作(16%)

- 人體動作和活動(10%)

- 空間意識和導航(16%)

- 第一人稱視角(8%)

- 自然動態(20%)

- 動態相機運動(8%)

- 合成渲染(4%)

- 其他(7%)

Tokenizer(分詞器)

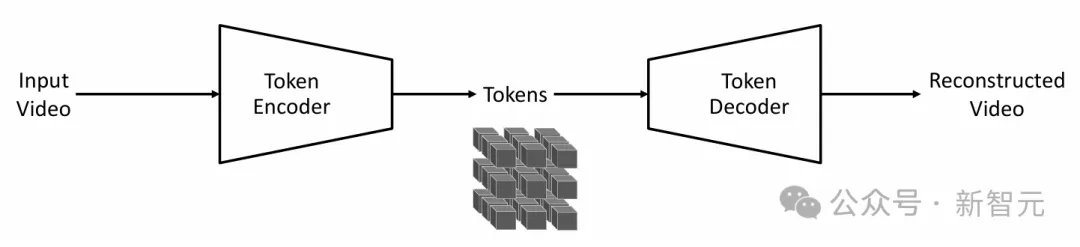

分詞器是大模型的基礎構建模塊,它通過學習瓶頸式的潛空間,以無監督方式將原始數據轉換為更高效的表示形式。

下圖以示意圖形式展示了分詞訓練流程,其目標是訓練編碼器和解碼器,使瓶頸式token表示能夠最大程度保留輸入的視覺信息。

圖片

圖片

視頻分詞流程:輸入視頻被編碼為token,解碼器隨后從這些token中重建輸入視頻。分詞器的訓練目標是學習編碼器和解碼器,盡可能保留token中的視覺信息

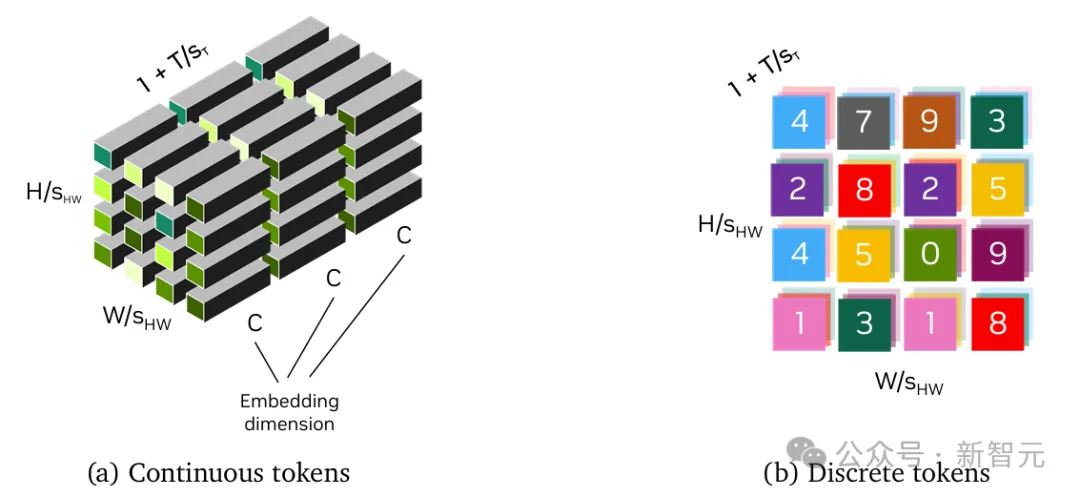

連續分詞器將視覺數據編碼為連續的潛嵌入,并用于通過從連續分布中采樣生成數據的模型。

離散分詞器將視覺數據編碼為離散的潛代碼,并將其映射為量化索引。這種離散表示對于使用交叉熵損失訓練的模型(如GPT)是必要的。

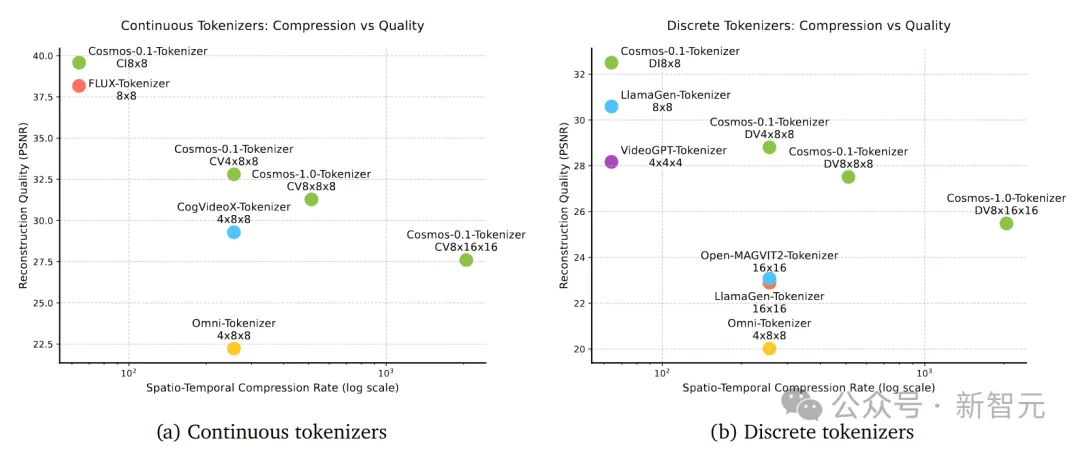

分詞器的成功很大程度上取決于其在不損害后續視覺重建質量的情況下提供高壓縮率的能力。

在此,研究者提出了一套視覺分詞器——包括用于圖像和視頻的連續和離散分詞器。它們可以提供卓越的視覺重建質量和推理效率,并支持多種壓縮率,以適應不同的計算限制和應用需求。

圖片

圖片

連續和離散分詞器的可視化:(左)連續潛嵌入,嵌入大小為C;(右)量化索引,每種顏色代表一個離散的潛編碼

具體來說,Cosmos分詞器采用輕量化且計算高效的架構,并結合時間因果機制。

通過使用因果時間卷積層和因果時間注意力層,可以保留視頻幀的自然時間順序,從而通過單一統一的網絡架構實現圖像和視頻的無縫分詞。

通過在高分辨率圖像和長時視頻上直接訓練分詞器,可以不受類別或寬高比的限制,包括1:1、3:4、4:3、9:16和16:9等。

在推理階段,它對時間長度不敏感,能夠處理超出訓練時時間長度的視頻分詞。

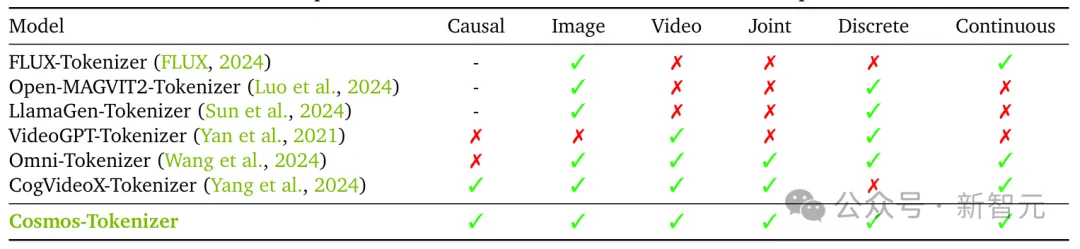

不同視覺分詞器及其功能的比較

不同視覺分詞器及其功能的比較

評估結果表明,Cosmos分詞器在性能上顯著超越了現有分詞器——不僅質量更高,而且運行速度最高可快12 倍。

此外,它還可以在單塊NVIDIA A100 GPU(80GB顯存)上一次性編碼長達8秒的1080p視頻和10秒的720p視頻,且不會耗盡內存。

圖片

圖片

連續分詞器(左)和離散分詞器(右)在時空壓縮率(對數刻度)與重建質量(PSNR)上的比較。每個實心點表示一種分詞器配置,展示了壓縮率與質量之間的權衡關系

世界基礎模型預訓練

研究者利用兩種不同的深度學習范式——擴散模型和自回歸模型——來構建兩類WFM。

本文中所有WFM模型都是在一個包含10,000個NVIDIA H100 GPU的集群上訓練的,訓練周期為三個月。

基于擴散模型和自回歸模型的世界基礎模型(WFM)

基于擴散模型和自回歸模型的世界基礎模型(WFM)

自回歸世界基礎模型生成的視頻

自回歸世界基礎模型生成的視頻

研究者展示了如何將Cosmos WFM進行微調,以支持多種場景,包括3D視覺導航,讓不同的機器人執行任務,以及自動駕駛。

世界基礎模型后訓練

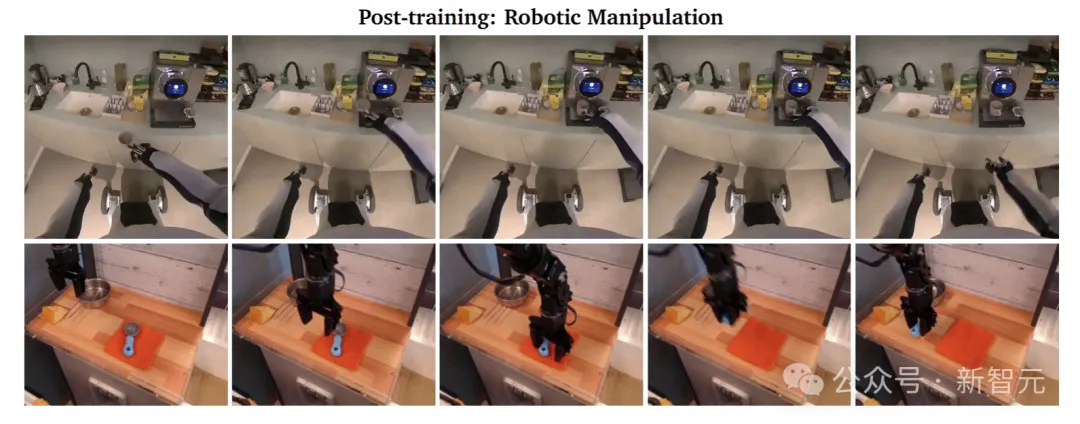

用于機器人的WFM后訓練

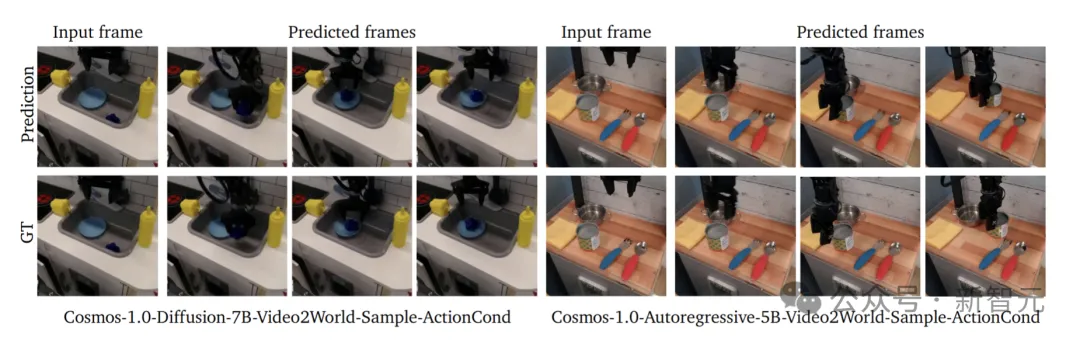

世界模型具有支持機器人操作的強大潛力,這里展示了兩個任務:(1)基于指令的視頻預測,(2)基于動作的下一幀預測。

對于基于指令的視頻預測,輸入是機器人當前視頻幀以及文本指令,輸出是預測的視頻。基于動作的下一幀預測,輸入是機器人的當前視頻幀以及當前幀與下一幀之間的動作向量,輸出是預測的下一幀,展示機器人執行指定動作的結果。

對于基于指令的視頻預測,研究者創建了一個名為Cosmos-1X的數據集。該數據集包含大約200小時的由EVE(1x.Tech公司的一款人形機器人)捕捉的第一視角視頻,包括導航、折疊衣物、清潔桌面、拾取物體等。

對于基于動作的下一幀生成,團隊使用了一個名為Bridge的公開數據集。Bridge數據集包括大約20,000個第三人稱視角的視頻,展示了機器人手臂在廚房環境中執行不同任務的過程。

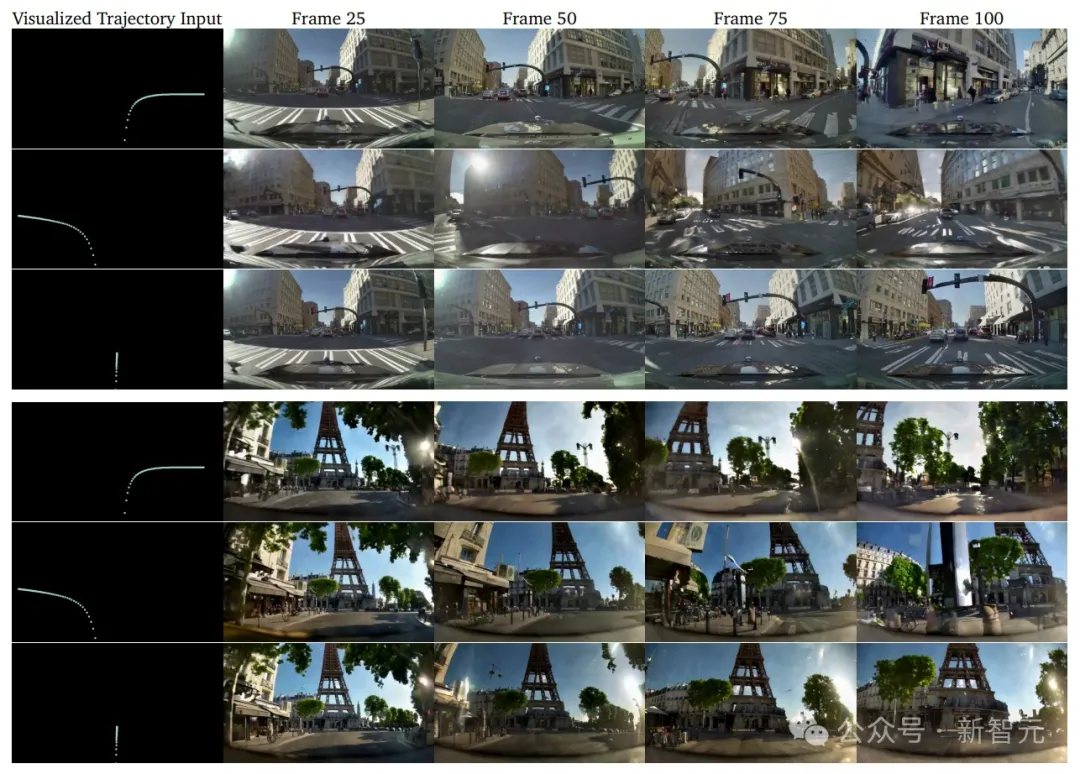

用于自動駕駛的后訓練

研究者展示了如何對預訓練的WFM進行微調,從而創建一個適用于自動駕駛任務的多視角世界模型。

研究者策劃了一個內部數據集,稱為真實駕駛場景(RDS)數據集。該數據集包含大約360萬個20秒的環視視頻片段,這些視頻是通過英偉達的內部駕駛平臺錄制的。

研究者使用RDS數據集對Cosmos-1.0-Diffusion-7B-Text2World進行微調,打造出一個多視角的世界模型。

Cosmos-1.0-Diffusion-7B-Text2World-Sample-MultiVie

Cosmos-1.0-Diffusion-7B-Text2World-Sample-MultiVie

一些演示

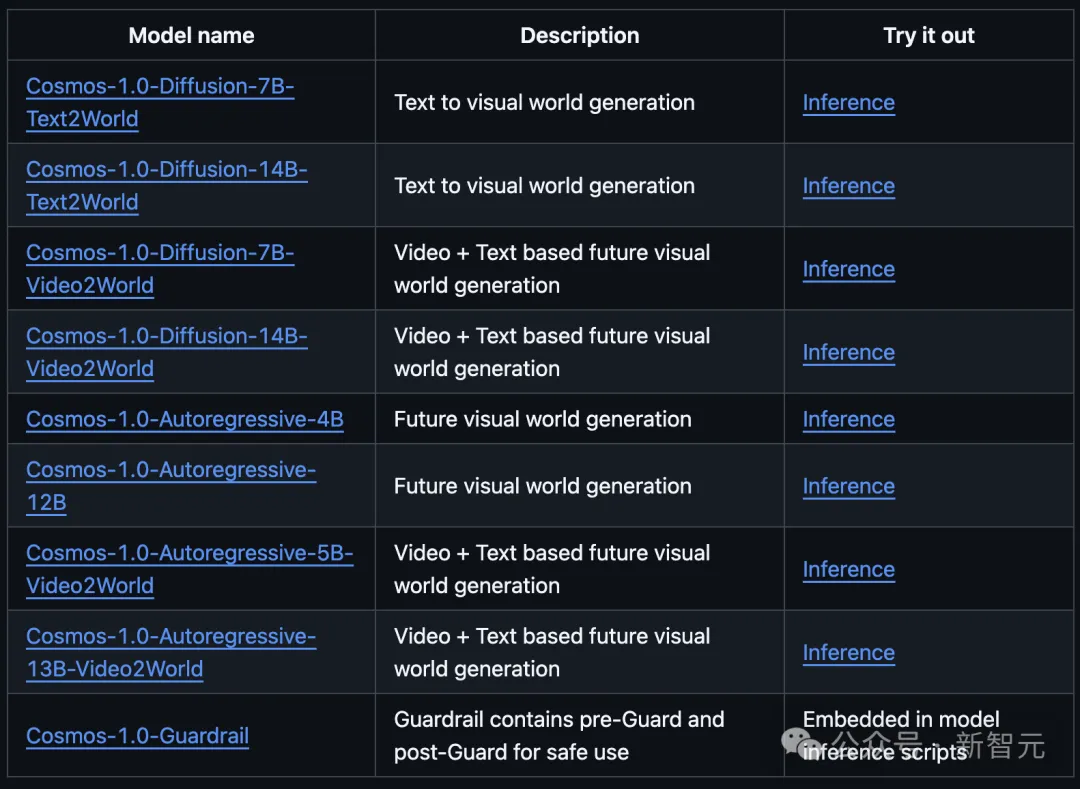

從GitHub主頁中,我們能夠看到Cosmos家族的所有模型系列:擴散模型和自回歸模型各4個。

圖片

圖片

擴散模型7B和14B(Text2World)根據同一提示,生成效果如下:

圖片

圖片

擴散模型7B和14B(Video2World)根據同一提示,生成效果如下:

圖片

圖片

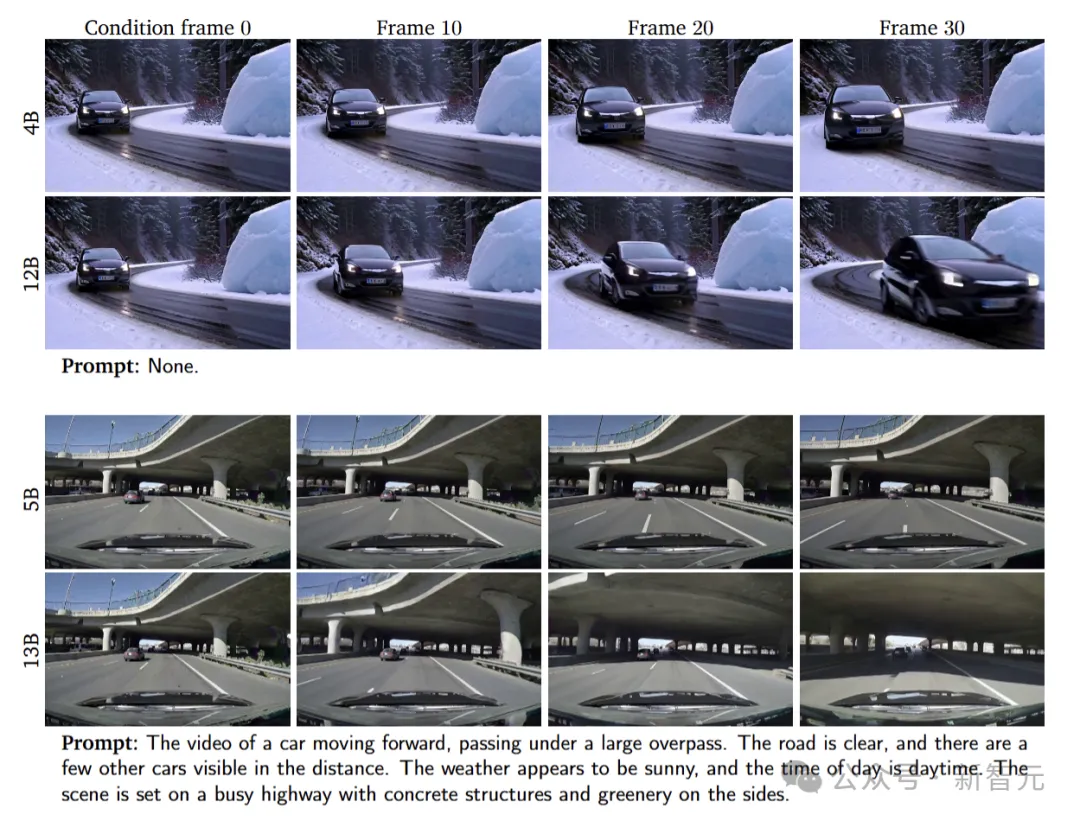

自回歸模型4B和12B生成效果如下:

圖片

圖片

自回歸模型5B和13B根據同一提示,生成效果如下:

圖片

圖片

此外,后訓練世界基礎模型還能實現「相機控制」,如下機器人在車廠的生成視頻中,通過移動能夠看到四周環境全貌。

圖片

圖片

提示:這段視頻展示了一座先進的制造設施,其中多臺機器人手臂協同工作。這些機器人配備了特殊的抓取裝置,正在中央平臺上處理和組裝組件。環境干凈且井然有序,背景中可以看到各種機械和設備。整個機器人系統高度自動化,體現了高科技的生產流程。

更驚喜的是,Cosmos還能根據提示,生成出各種機器人在不同環境中的預測場景。比如,把書放在書架上,煮咖啡、分揀物品......

也就是說,以后機器人的模擬訓練,直接在物理世界就能實操了!

圖片

圖片

還有針對自動駕駛場景,Cosmos進行的多視圖視頻生成。

要知道,以下這些場景是完全不存在的。

圖片

圖片

有網友調侃道,我們一定生活在模擬世界中,99%情況下是由英偉達撐著這個系統。

圖片

圖片

物理AI,不能沒有WFM

為什么說世界模型,對于物理AI的實現非常關鍵?

圖片

圖片

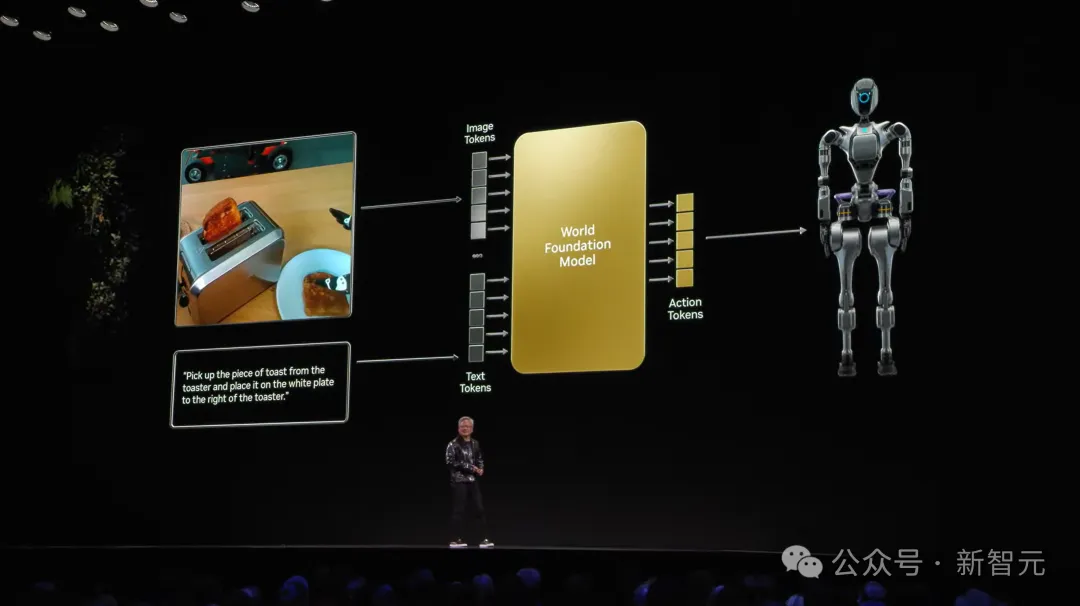

老黃在大會上,從大模型工作原理生動地闡釋了世界模型的重要性——

大模型通常是根據提示一次生成一個token,但也僅限內容token的輸出。若要實現從「內容token」轉向「動作token」的輸出,語言模型早已無法滿足。

圖片

圖片

我們需要的是,一個能夠理解物理世界的模型,簡之WFM。

昨天,英偉達研究副總Ming-Yu Liu在最新播客中同樣表示,WFM是一種能夠模擬物理世界的強大神級網絡。

它可以從文本/圖像輸入數據,生成詳細的視頻,并通過將其的當前狀態(圖像/視頻)與動作(提示/控制信號)相結合來預測場景的演變。

WFM能夠想象許多不同的環境,并可以模擬未來,幫助物理AI開發者做出更好的決策。

圖片

圖片

另一方面,構建世界模型通常需要大量的數據集。

數據收集不僅耗時,成本也高,WFM便可以生成合成數據,從而增強訓練的過程。

此外,物理測試風險巨大,比如一臺價值數十萬美元的機器人原型的任何失誤都可能帶來重大損失。

有了WFM模擬的3D環境,研究者就可以在受控環境中訓練和測試物理AI系統。

圖片

圖片

物理模擬世界的一切,英偉達Cosmos都能幫你生成出來。

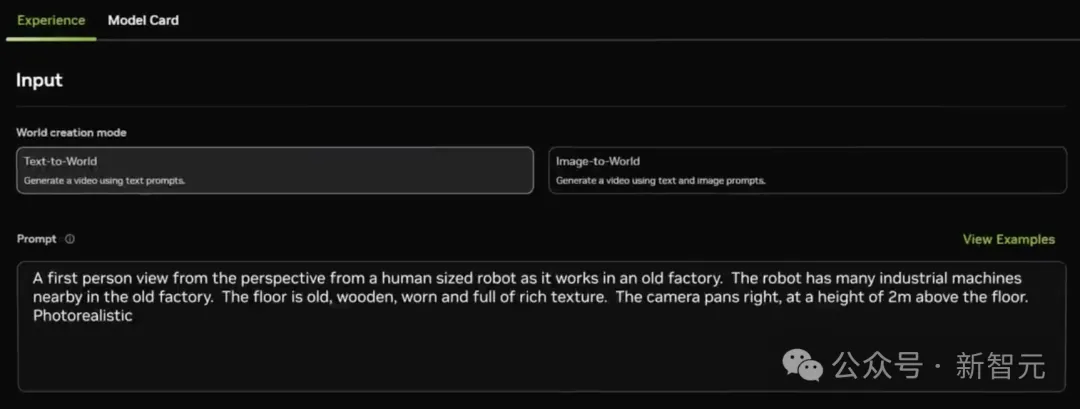

假設你要測試一臺機器人,長傳一個原視頻,然后輸入:

「以人形機器人的第一人稱視角拍攝在一個老舊工廠中工作的場景。機器人周圍有許多工業機械設備。地板是老舊的木質地板,破舊且具有豐富的紋理。攝像機在距離地面2米的高度向右平移。照片風格要求逼真」。

圖片

圖片

然后,一個機器人在工廠工作的虛擬畫面就出現了。

圖片

圖片

包括如下自動駕駛場,都是由Cosmos完全生成。

圖片

圖片

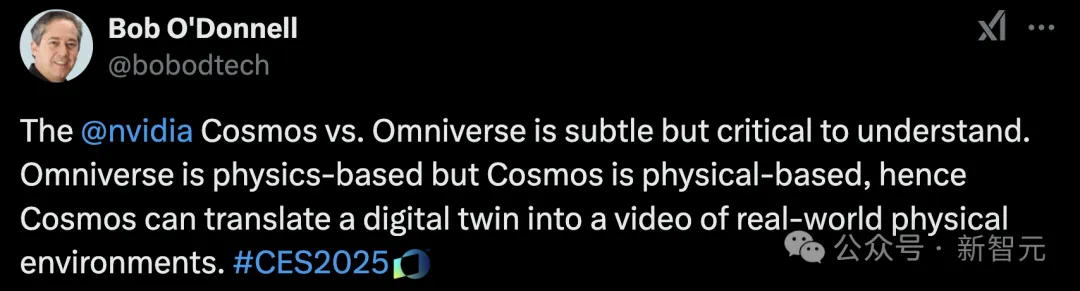

不僅如此,英偉達還將Cosoms與Omniverse搭配使用,虛實結合,讓虛擬世界的設計搬到現實世界訓練。

圖片

圖片

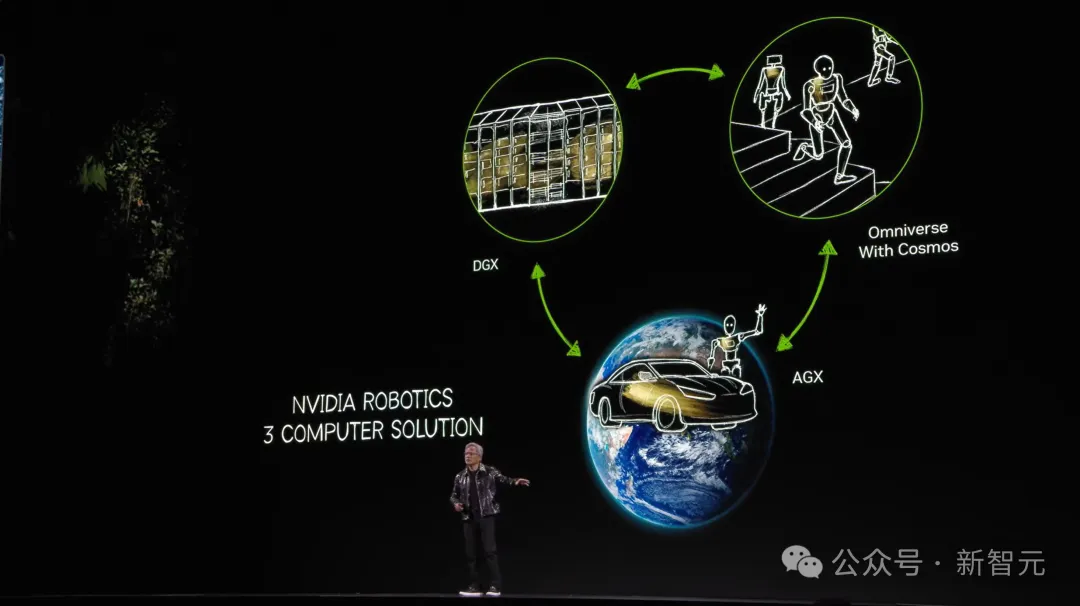

一直以來,老黃都在強調一個新概念「三臺計算機」:一臺是DGX用來訓練AI,另一臺AGX用來部署AI,最后一臺便是Omniverse+Cosmos。

若是連接前兩者,我們就需要一個數字孿生。

老黃認為,「未來,每一個工廠都有數字孿生,你可以將Omniverse和Cosoms結合,生成一大批未來場景」。

圖片

圖片

參考資料:

https://github.com/NVIDIA/Cosmos

https://x.com/DrJimFan/status/1876516972512559170

https://research.nvidia.com/publication/2025-01_cosmos-world-foundation-model-platform-physical-ai