2024屬于小模型,99%的用例可用SLM解決,大模型遇瓶頸?

在人工智能“戰(zhàn)爭(zhēng)”中,科技巨頭們一直在競(jìng)相構(gòu)建更大的語(yǔ)言模型,一個(gè)令人驚訝的新趨勢(shì)正在出現(xiàn):小就是新的大。

隨著大語(yǔ)言模型 (LLM) 的進(jìn)展出現(xiàn)一些停滯跡象,研究人員和開(kāi)發(fā)人員越來(lái)越多地將注意力轉(zhuǎn)向小語(yǔ)言模型 (SLM)。這些緊湊、高效且適應(yīng)性強(qiáng)的人工智能模型正在挑戰(zhàn)“越大越好”的觀念,有望改變我們進(jìn)行人工智能開(kāi)發(fā)的方式。

LLM 是否開(kāi)始趨于穩(wěn)定?

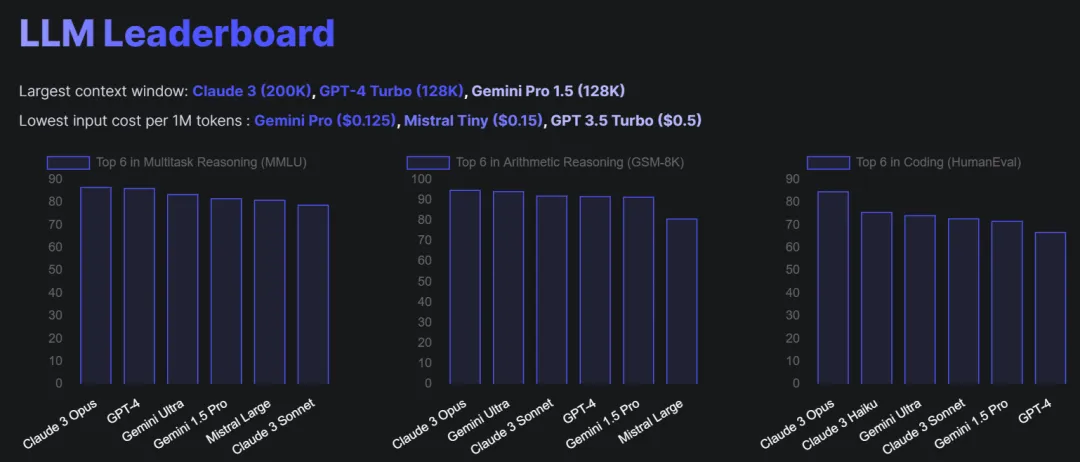

Vellum 和 HuggingFace 最近發(fā)布的績(jī)效比較表明,LLM 之間的績(jī)效差距正在迅速縮小。這種趨勢(shì)在多項(xiàng)選擇題、推理和數(shù)學(xué)問(wèn)題等特定任務(wù)中尤其明顯,其中頂級(jí)模型之間的性能差異很小。

LLM 排行榜。(來(lái)源:vellum)

LLM 排行榜。(來(lái)源:vellum)

例如,在選擇題中,Claude 3 Opus、GPT-4 和 Gemini Ultra 的得分都在 83% 以上,而在推理任務(wù)中,Claude 3 Opus、GPT-4 和 Gemini 1.5 Pro 的準(zhǔn)確率都超過(guò) 92%。

有趣的是,甚至像 Mixtral 8x7B 和 Llama 2 – 70B 這樣的較小模型在某些領(lǐng)域(例如推理和多項(xiàng)選擇題)也顯示出了有希望的結(jié)果,它們?cè)谶@些領(lǐng)域的表現(xiàn)優(yōu)于一些較大的模型。這表明模型的大小可能不是性能的唯一決定因素,架構(gòu)、訓(xùn)練數(shù)據(jù)和微調(diào)技術(shù)等其他方面可能發(fā)揮重要作用。

Uber 人工智能前負(fù)責(zé)人、《重啟人工智能》(Rebooting AI)一書的作者加里?馬庫(kù)斯(Gary Marcus)表示:“如果你從經(jīng)驗(yàn)上看,最近發(fā)表的十幾篇文章都與 GPT-4處于同一領(lǐng)域。”這本書講述了如何構(gòu)建值得信賴的人工智能。

“其中一些比 GPT-4 好一點(diǎn),但沒(méi)有質(zhì)的飛躍。我想每個(gè)人都會(huì)說(shuō) GPT-4 比 GPT-3.5 領(lǐng)先了一大步。一年多來(lái)沒(méi)有發(fā)生任何[量子躍遷]。”馬庫(kù)斯說(shuō)。

隨著性能差距不斷縮小,越來(lái)越多的模型展現(xiàn)出有競(jìng)爭(zhēng)力的結(jié)果,這就提出了 LLM 是否確實(shí)開(kāi)始趨于穩(wěn)定的問(wèn)題。如果這種趨勢(shì)持續(xù)下去,它可能會(huì)對(duì)語(yǔ)言模型的未來(lái)開(kāi)發(fā)和部署產(chǎn)生重大影響,可能會(huì)將重點(diǎn)從簡(jiǎn)單地增加模型大小轉(zhuǎn)移到探索更高效和專業(yè)的架構(gòu)。

LLM方法的缺點(diǎn)

LLM 雖然無(wú)可否認(rèn)地強(qiáng)大,但也有明顯的缺點(diǎn)。首先,訓(xùn)練LLM需要大量的數(shù)據(jù),需要數(shù)十億甚至數(shù)萬(wàn)億的參數(shù)。這使得訓(xùn)練過(guò)程極其耗費(fèi)資源,訓(xùn)練和運(yùn)行 LLM 所需的計(jì)算能力和能源消耗是驚人的。這導(dǎo)致成本高昂,使得較小的組織或個(gè)人很難參與核心的LLM開(kāi)發(fā)。在去年 MIT 的一次活動(dòng)上,OpenAI 首席執(zhí)行官 Sam Altman 表示,訓(xùn)練 GPT-4 的成本至少為 1 億美元。

與 LLM 合作所需的工具和技術(shù)的復(fù)雜性也為開(kāi)發(fā)人員帶來(lái)了陡峭的學(xué)習(xí)曲線,進(jìn)一步限制了可訪問(wèn)性。對(duì)于開(kāi)發(fā)人員來(lái)說(shuō),從培訓(xùn)到構(gòu)建和部署模型的周期時(shí)間很長(zhǎng),這會(huì)減慢開(kāi)發(fā)和實(shí)驗(yàn)的速度。

劍橋大學(xué)最近發(fā)表的一篇論文顯示,公司可以花費(fèi) 90 天或更長(zhǎng)時(shí)間來(lái)部署單個(gè)機(jī)器學(xué)習(xí) (ML) 模型。

論文鏈接:https://doi.org/10.1145/3533378

LLM 的另一個(gè)重要問(wèn)題是他們?nèi)菀桩a(chǎn)生幻覺(jué)——產(chǎn)生看似合理但實(shí)際上并不真實(shí)的輸出。這源于 LLM 的訓(xùn)練方式是根據(jù)訓(xùn)練數(shù)據(jù)中的模式預(yù)測(cè)下一個(gè)最可能的單詞,而不是真正理解信息。因此,LLM 可以自信地提出虛假陳述、編造事實(shí)或以無(wú)意義的方式組合不相關(guān)的概念。檢測(cè)和減輕這些幻覺(jué)是開(kāi)發(fā)可靠且值得信賴的語(yǔ)言模型的持續(xù)挑戰(zhàn)。

“如果你用它來(lái)解決高風(fēng)險(xiǎn)問(wèn)題,你不想侮辱你的客戶,或者得到不良的醫(yī)療信息,或者用它來(lái)駕駛汽車并在那里冒險(xiǎn)。這仍然是一個(gè)問(wèn)題,”馬庫(kù)斯警告說(shuō)。

LLM 的規(guī)模和黑盒性質(zhì)也使它們難以解釋和調(diào)試,這對(duì)于建立對(duì)模型輸出的信任至關(guān)重要。訓(xùn)練數(shù)據(jù)和算法中的偏差可能會(huì)導(dǎo)致不公平、不準(zhǔn)確甚至有害的輸出。

正如谷歌 Gemini 所見(jiàn),使 LLM “安全”和可靠的技術(shù)也會(huì)降低其有效性。此外,LLM 的集中性質(zhì)引起了人們對(duì)權(quán)力和控制權(quán)集中在少數(shù)大型科技公司手中的擔(dān)憂。

輸入小語(yǔ)言模型 (SLM)

SLM 是 LLM 的更精簡(jiǎn)版本,參數(shù)更少,設(shè)計(jì)更簡(jiǎn)單。他們需要更少的數(shù)據(jù)和訓(xùn)練時(shí)間——幾分鐘或幾個(gè)小時(shí),而 LLM 需要幾天的時(shí)間。這使得 SLM 在現(xiàn)場(chǎng)或較小的設(shè)備上實(shí)施起來(lái)更加高效和直接。

SLM 的主要優(yōu)勢(shì)之一是它們適合特定應(yīng)用。由于它們的范圍更集中并且需要的數(shù)據(jù)更少,因此與大型通用模型相比,它們可以更輕松地針對(duì)特定領(lǐng)域或任務(wù)進(jìn)行微調(diào)。這種定制使公司能夠創(chuàng)建能夠非常有效地滿足其特定需求的 SLM,例如情緒分析、命名實(shí)體識(shí)別或特定領(lǐng)域的問(wèn)答。與使用更通用的模型相比,SLM 的專業(yè)性質(zhì)可以提高這些目標(biāo)應(yīng)用程序的性能和效率。

與 LLM 相比,SLM 也不太容易在其特定領(lǐng)域內(nèi)出現(xiàn)未被發(fā)現(xiàn)的幻覺(jué)。SLM 通常在特定于其預(yù)期領(lǐng)域或應(yīng)用程序的更窄且更有針對(duì)性的數(shù)據(jù)集上進(jìn)行訓(xùn)練,這有助于模型學(xué)習(xí)與其任務(wù)最相關(guān)的模式、詞匯和信息。這種關(guān)注減少了產(chǎn)生不相關(guān)、意外或不一致輸出的可能性。憑借更少的參數(shù)和更精簡(jiǎn)的架構(gòu),SLM 不太容易捕獲和放大訓(xùn)練數(shù)據(jù)中的噪聲或錯(cuò)誤。

人工智能初創(chuàng)公司 HuggingFace 的首席執(zhí)行官 Clem Delangue 表示,高達(dá) 99% 的用例可以使用 SLM 來(lái)解決,并預(yù)測(cè) 2024 年將是 SLM 年。

HuggingFace 的平臺(tái)使開(kāi)發(fā)人員能夠構(gòu)建、訓(xùn)練和部署機(jī)器學(xué)習(xí)模型,今年早些時(shí)候宣布與谷歌建立戰(zhàn)略合作伙伴關(guān)系。兩家公司隨后將 HuggingFace 集成到 Google 的 Vertex AI 中,使開(kāi)發(fā)人員能夠通過(guò) Google Vertex Model Garden 快速部署數(shù)千個(gè)模型。

谷歌 Gemma 有些愛(ài)

在最初將 LLM 方面的優(yōu)勢(shì)讓給 OpenAI 后,谷歌正在積極尋求 SLM 機(jī)會(huì)。早在二月份,谷歌就推出了 Gemma,這是一系列新的小語(yǔ)言模型,旨在提高效率和用戶友好性。與其他 SLM 一樣,Gemma 模型可以在各種日常設(shè)備上運(yùn)行,例如智能手機(jī)、平板電腦或筆記本電腦,無(wú)需特殊硬件或廣泛優(yōu)化。

自 Gemma 發(fā)布以來(lái),經(jīng)過(guò)訓(xùn)練的模型上個(gè)月在 HuggingFace 上的下載量已超過(guò) 400,000 次,并且已經(jīng)出現(xiàn)了一些令人興奮的項(xiàng)目。

例如,Cerule 是一個(gè)強(qiáng)大的圖像和語(yǔ)言模型,它將 Gemma 2B 與 Google 的 SigLIP 相結(jié)合,并在海量圖像和文本數(shù)據(jù)集上進(jìn)行了訓(xùn)練。Cerule 利用高效的數(shù)據(jù)選擇技術(shù),這表明它無(wú)需大量數(shù)據(jù)或計(jì)算即可實(shí)現(xiàn)高性能。這意味著 Cerule 可能非常適合新興的邊緣計(jì)算用例。

另一個(gè)例子是 CodeGemma,它是 Gemma 的專門版本,專注于編碼和數(shù)學(xué)推理。CodeGemma 提供了針對(duì)各種編碼相關(guān)活動(dòng)量身定制的三種不同模型,使開(kāi)發(fā)人員更容易使用和高效地使用高級(jí)編碼工具。

小語(yǔ)言模型的變革潛力

隨著人工智能社區(qū)不斷探索小語(yǔ)言模型的潛力,更快的開(kāi)發(fā)周期、更高的效率以及根據(jù)特定需求定制模型的能力的優(yōu)勢(shì)變得越來(lái)越明顯。SLM 準(zhǔn)備通過(guò)提供經(jīng)濟(jì)高效且有針對(duì)性的解決方案,實(shí)現(xiàn)人工智能訪問(wèn)的民主化并推動(dòng)跨行業(yè)創(chuàng)新。

SLM 在邊緣的部署為金融、娛樂(lè)、汽車系統(tǒng)、教育、電子商務(wù)和醫(yī)療保健等各個(gè)領(lǐng)域的實(shí)時(shí)、個(gè)性化和安全應(yīng)用開(kāi)辟了新的可能性。

通過(guò)在本地處理數(shù)據(jù)并減少對(duì)云基礎(chǔ)設(shè)施的依賴,使用 SLM 的邊緣計(jì)算可實(shí)現(xiàn)更快的響應(yīng)時(shí)間、改善數(shù)據(jù)隱私并增強(qiáng)用戶體驗(yàn)。這種去中心化的人工智能方法有可能改變企業(yè)和消費(fèi)者與技術(shù)互動(dòng)的方式,在現(xiàn)實(shí)世界中創(chuàng)造更加個(gè)性化和直觀的體驗(yàn)。

由于 LLM 面臨與計(jì)算資源相關(guān)的挑戰(zhàn)并可能達(dá)到性能瓶頸,SLM 的興起有望使人工智能生態(tài)系統(tǒng)以驚人的速度發(fā)展。